RAG(Retrieval Augmented Generation)技术是一种结合检索和生成的方法,用于提升大型语言模型(LLMs)在知识密集型任务中的性能。RAG通过检索与用户输入相关的信息片段,并结合外部知识库来生成更准确、更丰富的回答。这项技术解决了LLMs在处理这类任务时可能遇到的挑战,如幻觉、知识过时和缺乏透明、可追溯的推理过程等问题。RAG技术能够提供更准确的回答、降低推理成本、实现外部记忆。

为了使用RAG技术,需要先配置环境,包括基础环境的搭建、基础文件的下载和茴香豆(huixiangdou)的安装。茴香豆是一个基于RAG技术的应用,可以快速、高效地搭建个人的知识领域助手。在Intern Studio服务器上部署茴香豆时,需要创建开发机并配置系统环境,下载必要的模型文件,并安装茴香豆运行所需的依赖。

接下来,通过修改配置文件,指定所需的模型路径和创建知识库,可以使用茴香豆搭建RAG助手。知识库的创建涉及提取知识库特征并创建向量数据库,这些数据库用于在检索过程中判断问题的接受与否,并生成准确的回答。向量数据库的创建需要一定的显存资源,并且在创建过程中需要等待。

最后,运行茴香豆知识助手,可以测试其效果。RAG技术的优势在于它允许使用基础模型进行调优,无需额外的数据训练。通过这种方式,即使是面对新的问题,茴香豆也能根据提供的数据库生成准确的答案。

总的来说,RAG技术结合了检索和生成的优势,通过外部知识库的支持,使得基础模型能够处理更复杂的知识密集型任务。茴香豆作为一个应用实例,展示了如何快速部署和使用RAG技术,为用户提供了一个强大的知识助手。通过这种方式,用户可以轻松地构建自己的知识库,并在各种场景中应用,从而提高工作效率和决策质量。

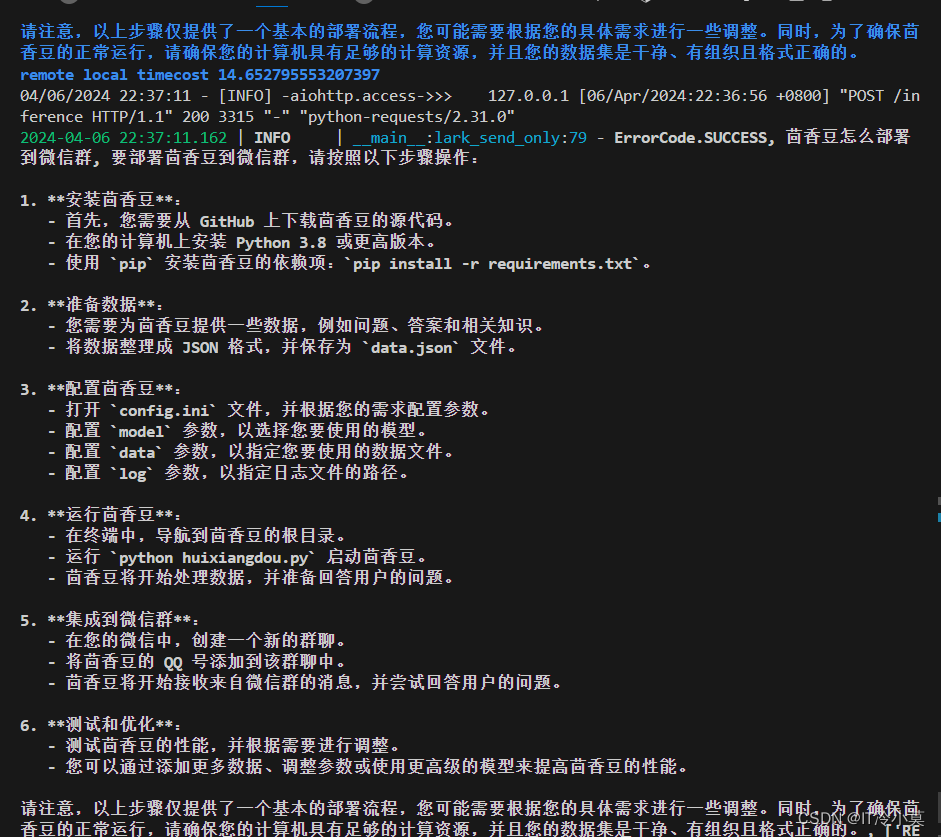

茴香豆(HuixiangDou)是一款专为群聊场景设计的知识助手,它基于大型语言模型(LLM)构建,通过两阶段的拒绝和响应流程,有效应对群聊中的信息泛滥问题。用户可以通过简单的配置,将茴香豆部署到不同的即时通讯平台,如微信和飞书,实现技术问题的即时解答和闲聊的智能过滤。

在部署过程中,用户首先需要下载并配置茴香豆的相关代码和模型。通过创建知识库和向量数据库,茴香豆能够对用户的问题进行精准的语义理解和相关性判断。此外,茴香豆支持网络搜索功能,可以结合本地知识库和互联网资源,为用户提供更全面的答案。

茴香豆的另一个亮点是其对远程模型的支持。用户可以根据需要,选择使用本地大模型或调用云端模型API,如Kimi、GPT-4等,这使得茴香豆在资源受限的环境中也能保持高效的运行。通过混合模型的使用,茴香豆能够进一步提升回答的准确性和响应速度。

总的来说,茴香豆以其灵活的部署方式、高效的检索能力和强大的模型支持,为用户提供了一个可靠、智能的群聊技术助手解决方案。无论是在即时通讯平台上的应用,还是在个人或企业的知识管理中,茴香豆都能发挥其独特的价值。

RAG技术通过结合检索和生成,利用外部知识库增强大型语言模型性能。茴香豆应用展示了如何部署和使用RAG,特别是在群聊场景中提供精准答案和智能过滤。

RAG技术通过结合检索和生成,利用外部知识库增强大型语言模型性能。茴香豆应用展示了如何部署和使用RAG,特别是在群聊场景中提供精准答案和智能过滤。

1864

1864

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?