1.request的介绍

通俗理解:爬虫是一个模拟人类请求网站行为的程序。可以自动请求网页、并数据抓取下来,然后使用一定

的规则提取有价值的数据。

专业介绍:百度百科。

2.通用爬虫和聚焦爬虫

通用爬虫:通用爬虫是搜索引擎抓取系统(百度、谷歌、搜狗等)的重要组成部分。主要是将互联网上的网页下载到本地,形成一个互联网内容的镜像备份。

聚焦爬虫:是面向特定需求的一种网络爬虫程序,他与通用爬虫的区别在于:聚焦爬虫在实施网页抓取的时候会对内容进行筛选和处理,尽量保证只抓取与需求相关的网页信息。

3.为什么用python写爬虫程序:

PHP:PHP是世界是最好的语言,但他天生不是做这个的,而且对多线程、异步支持不是很好,并发处理能力弱。爬虫是工具性程序,对速度和效率要求比较高。

Java:生态圈很完善,是Python爬虫最大的竞争对手。但是Java语言本身很笨重,代码量很大。重构成本比较高,任何修改会导致代码大量改动。爬虫经常要修改采集代码。

C/C++:运行效率是无敌的。但是学习和开发成本高。写个小爬虫程序可能要大半天时间。

Python:语法优美、代码简洁、开发效率高、支持的模块多。相关的HTTP请求模块和HTML解析模块非常丰富。还有Scrapy和Scrapy-redis框架让我们开发爬虫变得异常简单。

4.http协议 什么是http和https协议:

HTTP协议:全称是HyperText Transfer Protocol,中文意思是超文本传输协议,是一种发布和接收HTML页面的方法。服务器端口号是80端口。

HTTPS协议:是HTTP协议的加密版本,在HTTP下加入了SSL层。服务器端口号是443端口。

5.url详解:

URL是Uniform Resource Locator的简写,统一资源定位符。 一个URL由以下几部分组成:

scheme://host:port/path/?query-string=xxx#anchor

scheme:代表的是访问的协议,一般为http或者https以及ftp等。

host:主机名,域名,比如www.baidu.com。

port:端口号。

path:查找路径。

query-string:查询字符串。

anchor:锚点,前端用来做页面定位的。

在浏览器中请求一个url,浏览器会对这个url进行一个编码。除英文字母,数字和部分符号外,其他的全部使用百分号+十六进制码值进行编码

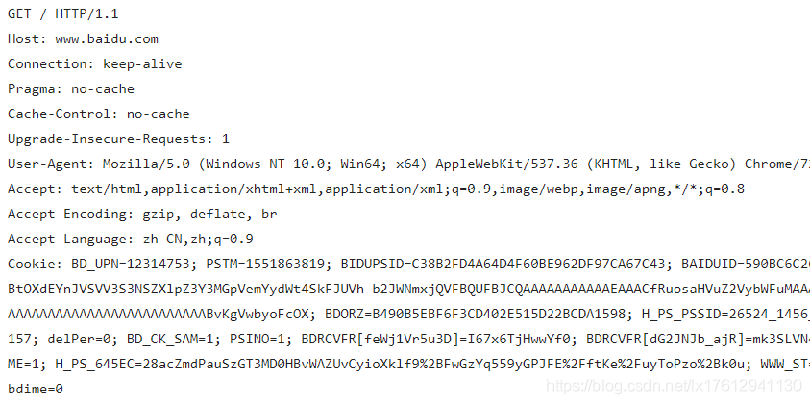

请求头

6.常用的请求方法

在Http协议中,定义了八种请求方法。这里介绍两种常用的请求方法,分别是get请求和post请求。

get请求:一般情况下,只从服务器获取数据下来,并不会对服务器资源产生任何影响的时候会使用get请求。

post请求:向服务器发送数据(登录)、上传文件等,会对服务器资源产生影响的时候会使用post请求。

7.常见响应状态码:

200:请求正常,服务器正常的返回数据。

301:永久重定向。比如在访问www.jingdong.com的时候会重定向到www.jd.com。

302:临时重定向。比如在访问一个需要登录的页面的时候,而此时没有登录,那么就会重定向到登录页面。

400:请求的url在服务器上找不到。换句话说就是请求url错误。

403:服务器拒绝访问,权限不够。

500:服务器内部错误。可能是服务器出现bug了

8.安装使用requests

pip install requests

中文文档

http://docs.python-requests.org/zh_CN/latest/user/quickstart.html

response = requests.get(url)

print(response.text)

9.response对象

print(type(response))

print(response.status_code)

print(type(response.text))

print(response.text)

print(response.cookies)

print(type(response.content))

print(response.content)

10.请求方式:

requests.post(‘http://httpbin.org/post’)

requests.put(‘http://httpbin.org/put’)

requests.delete(‘http://httpbin.org/delete’)

requests.head(‘http://httpbin.org/get’)

requests.options(‘http://httpbin.org/get’)

11.带参数GET请求:

import requests

response = requests.get(“http://httpbin.org/get?name=germey&age=22”)

print(response.text)

import requests

data = {

‘name’: ‘germey’,

‘age’: 22

}

response = requests.get(“http://httpbin.org/get”, params=data)

print(response.text)

12.添加headers

import requests

headers = {

‘User-Agent’: ‘Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_4) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36’

}

response = requests.get(“http://httpbin.org/get”, headers=headers)

print(response.text)

13.基本POST请求

import requests

data = {‘name’: ‘germey’, ‘age’: ‘22’}

response = requests.post(“http://httpbin.org/post”, data=data)

print(response.text)

import requests

data = {‘name’: ‘germey’, ‘age’: ‘22’}

headers = {

‘User-Agent’: ‘Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_4) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36’

}

response = requests.post(“http://httpbin.org/post”, data=data, headers=headers)

print(response.json())

eg:

基本用法

import requests

response=requests.get(url=‘https://www.baidu.com’) 也可不写url 如:response=requests.get(‘https://www.baidu.com’)

response.encoding=‘utf-8’ 编写编码格式

print(response.text) 输出爬取的网页信息

爬取图片

import request

response=requests.get(‘https://ss1.bdstatic.com/70cFvXSh_Q1YnxGkpoWK1HF6hhy/it/u=2748788776,2791291039&fm=26&gp=0.jpg’) 图片地址

with open(‘tupian.png’,‘wb’) as f:

f.write(response.content)

就是打开这个tupian.png文件 没有则创建 以二进制写入把爬取的图片二进制编码写入文件中 不写路径默认在本页面

63万+

63万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?