大模型学习笔记(一):部署ChatGLM模型以及stable-diffusion模型

注册算力平台(驱动云平台)

1.平台注册

平台注册链接:

https://growthdata.virtaicloud.com/t/SA

2.查看算力

注册完成后,点击右上角:费用中心,可查看领取的算力。

3.进入平台中心

https://platform.virtaicloud.com/

部署ChatGLM3-6B模型

ChatGLM3 是智谱AI和清华大学 KEG 实验室联合发布的新一代对话预训练模型。

推理速度比上一代提高了很多,虽然本教程有两种启动方式,但教程作者强烈推荐使用streamlit体验,效果极佳。

1.创建项目

- 创建好账号之后,进入自己的空间,点击右上角的创建项目。

- 给项目起一个你喜欢的名称,选择添加镜像

- 镜像选择pytorch2.0.1,Conda3.9

- 选择预训练模型,点击公开,选择不要葱姜蒜上传的这个ChtaGLM3-6B模型。

- 都选完之后,点击右下角的创建,代码选择暂不上传。待会直接clone代码。

- 点击运行代码

- 资源配置选择:B1.large, 24G的显存足够加载模型了。其他的不需要设置,然后点击右下角的开始运行。

2.配置环境

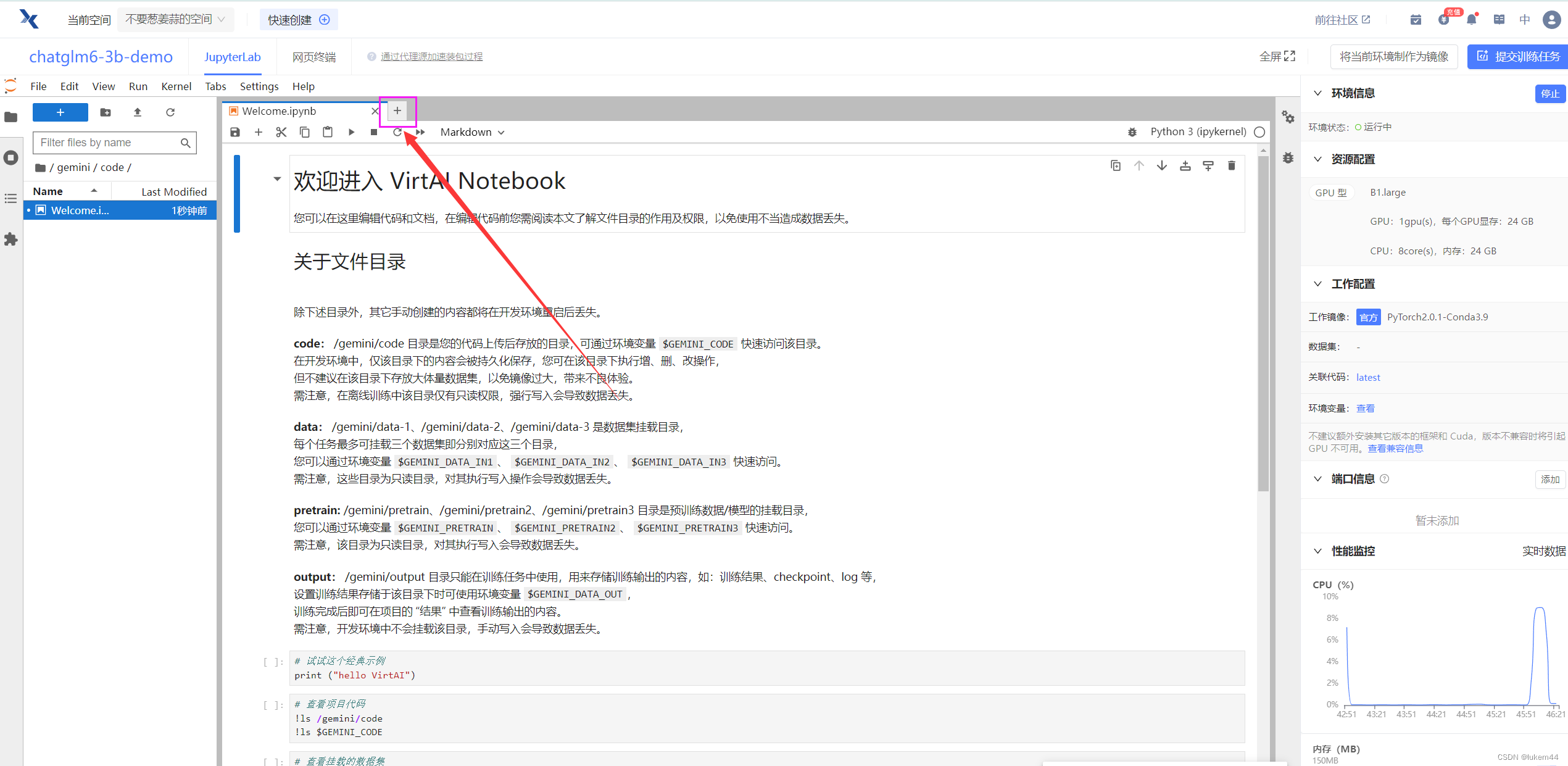

- 等右边两个工具全部加载完毕之后,再点击JupyterLab进入开发环境~

- 进入界面之后是这样的,然后点击这个小加号。

- 点击t

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9891

9891

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?