1.DeepSeek R1简介

DeepSeek R1 是一款开源 AI 模型,其性能可与 OpenAI 的 GPT-4 和 Claude 3.5 Sonnet 等顶级模型媲美,尤其在数学、编程和推理等任务上表现出色。最重要的是,它是免费、私密的,可以在本地硬件上离线运行。

DeepSeek R1 提供多个参数规模的版本,从轻量级的 1.5B 参数模型到高性能的 70B 版本。它基于 Qwen 7B 架构的精简优化版本,既保持强大性能,又具备更高的计算效率。

其主要亮点包括:- 完全开源,可自由使用。- 支持本地运行,无需依赖云服务器。- 数据完全可控,确保隐私安全。

2.为什么选择本地部署?

本地运行 AI 模型有以下优势:

- 隐私保障:所有数据均存储在本地,避免敏感信息泄露。

- 零额外成本:DeepSeek R1 免费运行,无需订阅或额外费用。

- 完全控制:可以进行微调和本地优化,无需外部依赖。

3.DeepSeek模型显卡和 macOs运行内存需求表

这是DeepSeek R1对应参数的性能需求,根据自身硬件来部署对应模型。

| 模型大小 | 显存需求(FP16推理) | 显存需求(INT8推理) | 推荐显卡 | macOS 需要的 RAM |

|---|---|---|---|---|

| 1.5B | ~3GB | ~2GB | RTX 2060/Mac M系列 | 8GB |

| 7B | ~14GB | ~10GB | RTX 3060 12GB/4070 Ti/Mac M系列 | 16GB |

| 8B | ~16GB | ~12GB | RTX 4070 /Mac M系列 | 16GB |

| 14B | ~28GB | ~20GB | RTX 4090 /A100 40G | 32GB |

| 32B | ~64GB | ~48GB | 2xRTX 4090 /A100 80G | 64GB |

4.安装Ollama

Ollama 是一款本地 AI 运行工具,可帮助用户轻松运行 DeepSeek R1。

下载Ollama,根据当前系统选择对应的版本进行下载。

Windows

等待下载完毕,双击OllamaSetup.exe,点击install

如下界面说明成功

macos

等待下载完毕,解压Ollama-darwin.zip

运行Ollama,移动到应用

如下界面说明成功

验证安装

安装完成后,在终端输入以下命令,检查Ollama版本:

ollama --version

5.安装DeepSeek R1

打开命令行

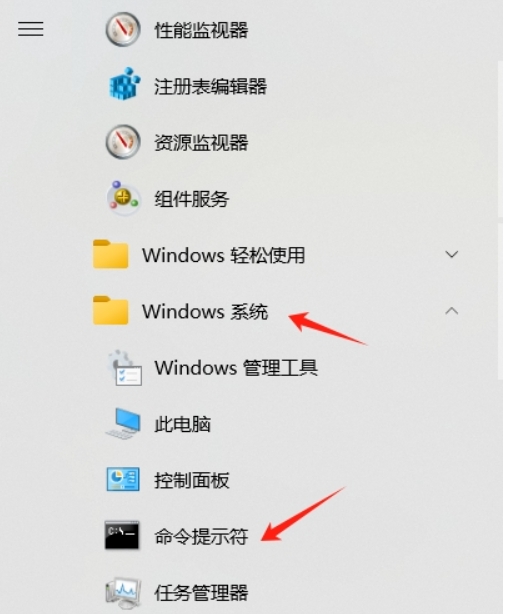

5.1Windows

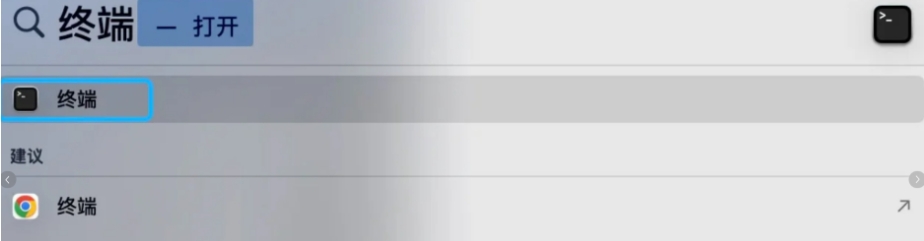

5.2macOS

在命令行运行安装输入命令

大家可以看到不同的版本对应的大小,根据电脑的配置选择合适的版本。其中,1.5b占用存储空间最小。

ollama run deepseek-r1:1.5b

5.3启动Ollama服务

ollama serve服务启动后,可以通过访问 http://localhost:11434 来与模型进行交互。

5.4提问测试

在命令行输入如下的命令,即能得到相应的回答:

ollama run deepseek-r1:1.5b 为什么天是蓝色的常见错误

1.找不到主机

"Error: error reading llm response: read tcp 127.0.0.1:49245->127.0.0.1:49210: wsarecv: An existing connection was forcibly closed by the remote host."

出现这种情况一般是dns问题,把系统dns改为8.8.4.4即可

2.端口冲突

Error: listen tcp 127.0.0.1:11434: bind: Only one usage of each socket address (protocol/network address/port) is normally permitted.

解决方法:

(1)退出Ollama:

(2)快捷键win+x打开任务管理器:启动应用中禁用掉ollama,并在进程中结束ollama的任务。

(3)再次尝试ollama serve

解决过程:

快捷键按下win+r键,输入cmd,打开命令行终端。

输入netstat -aon|findstr 11434查看11434这个端口是否被占用。

netstat -aon|findstr 11434

参考:Error: listen tcp 127.0.0.1:11434: bind: Only one usage of each socket address-优快云博客

18万+

18万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?