题目、作者:

Abstract

1. 写作目的:以往在ASTE任务中使用图神经网络的研究没有充分挖掘出ASTE任务中语法和语义信息

2. 本文方法大体介绍:我们的模型利用带有BERT通道的双通道编码器来捕获语义信息,并使用增强的LSTM通道来捕获全面的语法信息。随后,我们引入异构特征交互模块,捕捉依赖语法和关注语义之间复杂的交互,动态选择重要节点。我们利用这些模块的协同作用来利用自动化任务中语法和语义信息的巨大潜力。(大概读一下,后面会详细解读)

3. 摘要关键词:

- Aspect Sentiment Triplet Extraction:方面情感三元组提取(ASTE)。本文的任务

- Dual Encoder:双通道编码器。本文提出的一种编码方法

- Syntactic and Semantic:句法和语义。本文重点关注的点,也是本文的motivation

- Heterogeneous Feature Interaction:异构特征交互。本文提出的方法

1. Introduction

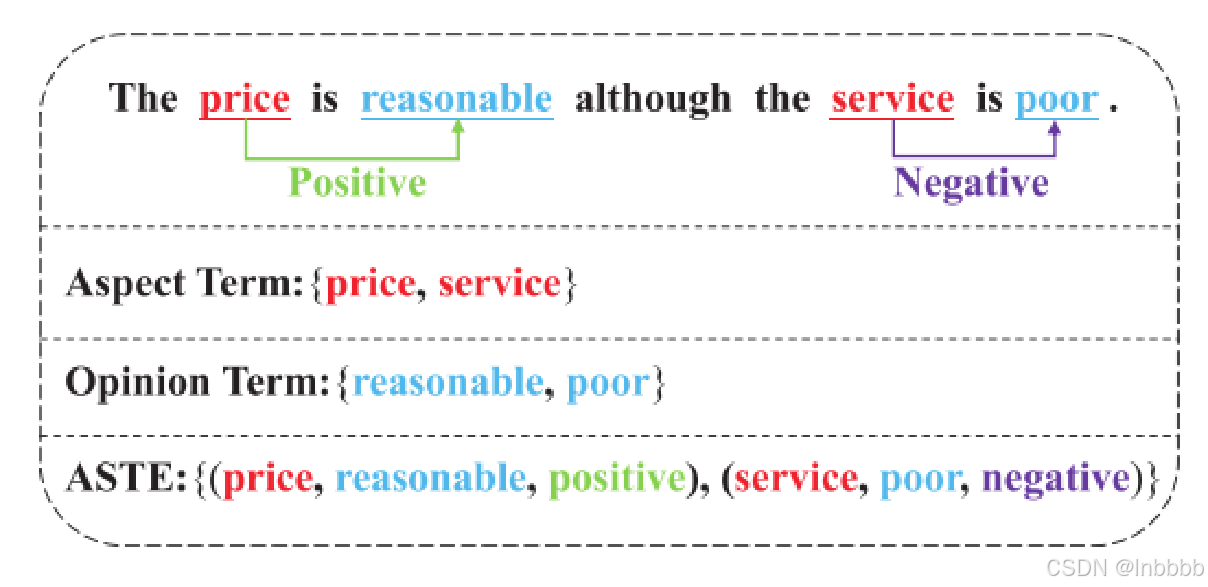

1. ASTE任务介绍:

如图,有这样一个文本:虽然服务很差,但是价格很合理 ASTE的任务就是把价格、服务这两个方面词,以及合理的、差的这两个意见词提取出来,然后根据意见词预测方面词的情感极性,最后输出为一个(方面词,意见词,情感极性)的三元组

2. Contribution

1. 提出一个增强句法和语义信息表达的双通道编码器

2. 提出一个HFIM(异构特征交互模块),这个模块可以使模型更有效的选择和捕获输入特征中的句法和语义信息

3. 提出一种分离句法和语义相似性的策略 其实前3个贡献就是本文的3个创新点

4. 达到sota

3. Methodology

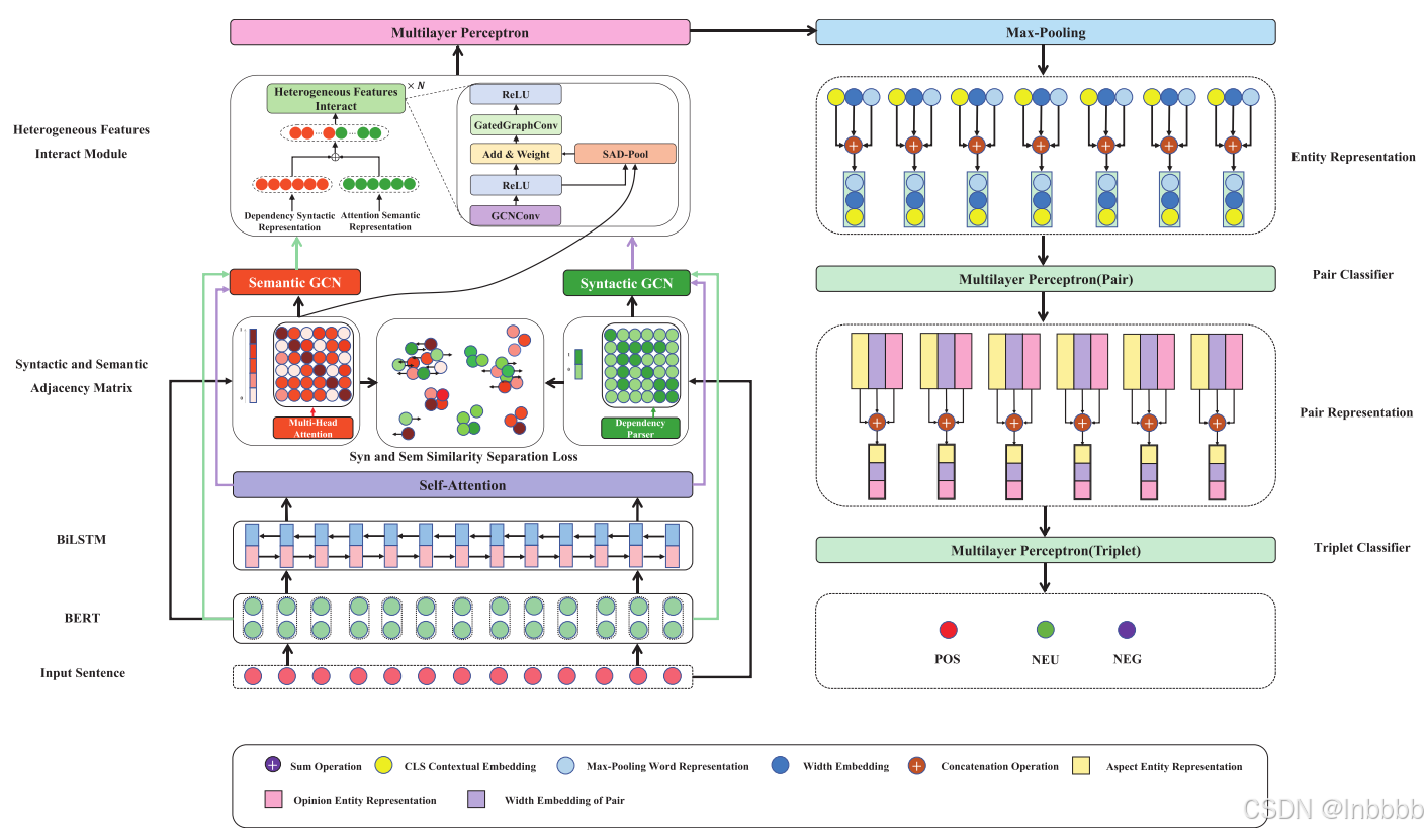

模型总览:

3.1 Task Definition

识别句子X = {w1, w2, . . . , wn}中的(方面项,意见项,情感极性)三元组

3.2. D2E2S Model

3.2.1. Input and Encoding Layer

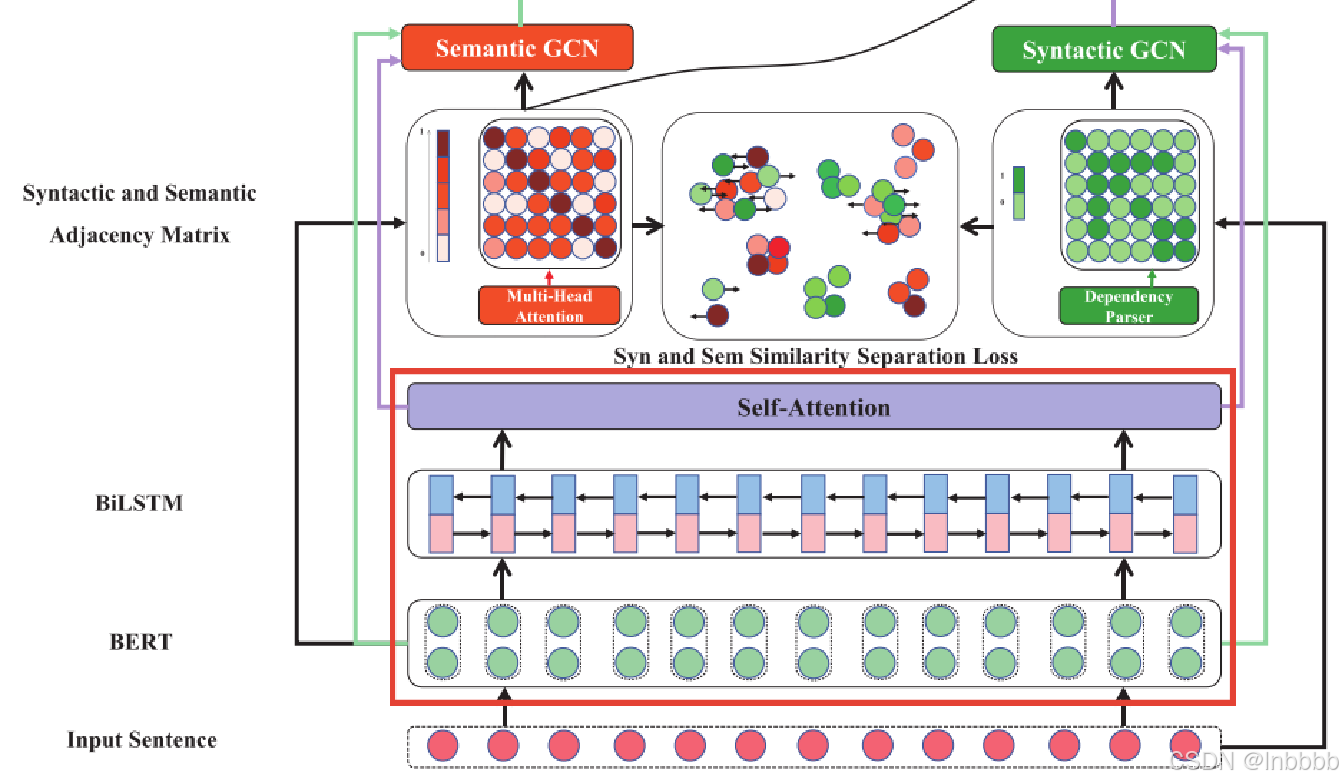

首先是模型的输入和编码层,这是本文的第一个贡献也是第一个创新点,也就是使用一个双编码器。如下图所示

· 编码器组成:这个双编码器包括两个编码器,一个是BERT,一个图中的标红框里的,这是一个增强的LSTM,这个增强的LSTM包括Bert+BiLSTM+self-attention,这两个编码器的输出分别对应绿色箭头和紫色箭头。

· 每个编码器作用:其中BERT用于捕获语义信息,增强版LSTM用于捕获词之间的局部依赖关系(attention)和序列信息(BiLSTM),也就是语法信息。

对于一个长度为n的输入句子,通过分别输入这两个编码器进行编码,可以得到如下面这两个公式所展现的两个隐藏状态向量表示,其中H为一句话,h为一个单词

<

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9436

9436

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?