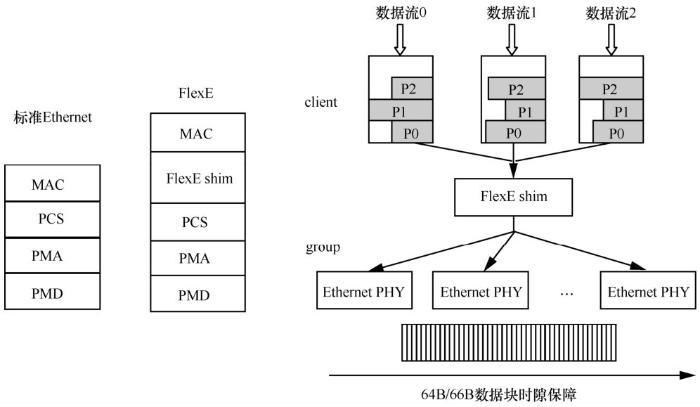

FlexE 技术由光互联论坛(Optical Internetworking Forum,OIF)定义,是基于IEEE 802.3 定义的高速 Ethernet接口,通过Ethernet MAC层与PHY 层解耦而实现的低成本、高可靠、可动态配置的电信级接口技术。该技术利用了业界最广泛、最强大的Ethernet生态系统,并且契合了视频、云计算以及5G等业务的发展需求,自2015年提出以来,受到业界广泛关注。FlexE技术通过在标准的Ethernet 架构基础上,引入FlexE shim层实现了Ethernet MAC与PHY层的解耦,从而实现了灵活的速率匹配。FlexE技术与Ethernet标准关系及FlexE shim功能如图1所示。

灵活以太基于client/group架构来定义,如图2所示,可以支持任意多个不同子接口(FlexE client)在任意一组PHY(FlexE group)上的映射和传输,从而实现捆绑、通道化及子速率的功能。具体如下。

● FlexE client:对应于网络的各种用户接口,与现有IP/Ethernet网络中的传统业务接口一致。FlexE client可根据带宽需求灵活配置,支持各种速率的以太网MAC数据(如10 Gbit/s、40 Gbit/s、n×25 Gbit/s数据流,甚至非标准速率数据流),并通过 64B/66B 编码方式将数据流传递至FlexE shim层。

图1

图1 FlexE技术与Ethernet标准关系及FlexE shim功能

图2

图2 FlexE通用架构

● FlexE shim:作为插入传统以太网架构的MAC 与 PHY(PCS 子层)中间的一个额外逻辑层,通过基于 calendar 的 slot 分发机制实现FlexE技术的核心架构。

● group:本质上就是IEEE 802.3标准定义的各种以太网 PHY 层。由于重用了现有 IEEE 802.3定义的以太网技术,FlexE架构得以在现有以太网MAC/PHY基础上进一步增强。

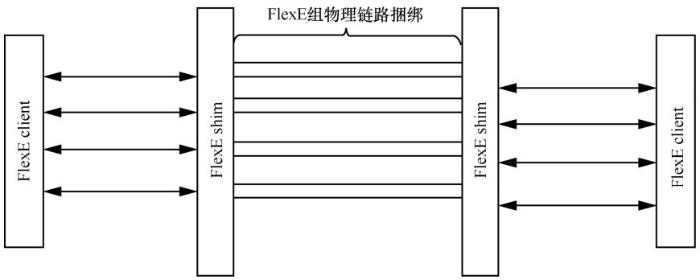

以 FlexE 作为点对点连接场景的物理层接口为例,多路以太网 PHY 组合在一起成为 FlexE group,并承载通过FlexE shim分发、映射过来的一路或者多路FlexE client数据流。

FlexE的核心功能通过FlexE shim层实现,它可以把FlexE group中的每个100GE PHY划分为20个slot(时隙)的数据承载通道,每个PHY所对应的这一组slot被称为一个sub-calendar,其中每个 slot 所对应的带宽为 5 Gbit/s。FlexE client原始数据流中的以太网帧以block原子数据块(为64B/66B编码的数据块)为单位进行切分,这些原子数据块可以通过FlexE shim实现在FlexE group中的多个PHY与时隙之间的分发。

按照OIF FlexE 2.0标准,每个FlexE client的数据流带宽可以设置为10 Gbit/s、40 Gbit/s或者m×25 Gbit/s。由于FlexE group的100 GE PHY中每个slot数据承载通道的带宽为5 Gbit/s粒度, FlexE client理论上也可以按照5 Gbit/s的速率颗粒度进行任意数量的组合设置,支持更加灵活的多速率承载。

2.2 FlexE应用

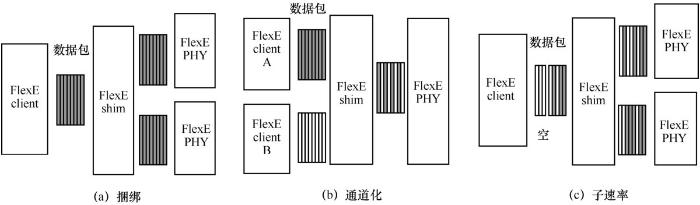

根据FlexE的技术特点,client可向上层应用提供各种灵活的带宽而不拘泥于物理PHY带宽。根据client与group的映射关系,FlexE可提供3种主要功能,如图3所示。

● 捆绑(bonding):多路PHY一起工作,支持更高速率。如8路100 GE PHY捆绑来支持800GE MAC速率。

● 通道化(channelization):多路低速率MAC数据流共享一路或者多路PHY。如最初定义在100GE PHY上承载25 Gbit/s、35 Gbit/s、20 Gbit/s与20 Gbit/s的四路MAC数据流;随着标准逐步成熟,可以在100GE PHY上承载以 5 Gbit/s 颗粒度带宽的 MAC 数据流,1 Gbit/s颗粒度的MAC数据流标准也有厂商正在推动标准立项。

● 子速率(sub-rate):单一低速率MAC数据流共享一路或者多路PHY,并通过特殊定义的error control block实现降速工作。如在100GE PHY上仅仅承载50 Gbit/s MAC数据流。

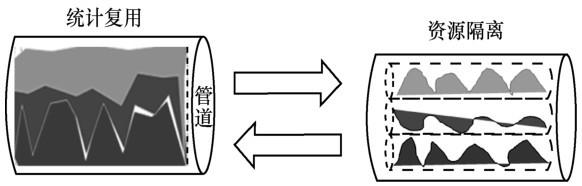

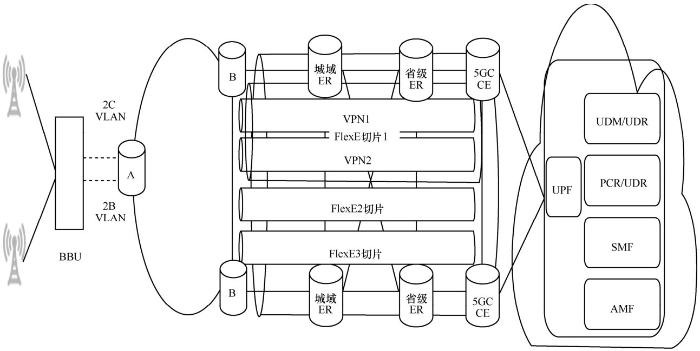

3 基于FlexE技术的STN承载网架构

灵活以太的通道化技术提供了接口级不同FlexE client之间的物理硬切分及相互隔离,可以进一步与路由器数据面的可编程转发、流量管理及调度相结合,构建满足5G低时延要求的端到端专用管道。这种灵活以太专用管道,是基于硬分片隔离的通道化技术,将一个物理以太网端口划分为多个以太网弹性硬管道。既可以支持承载网络实现独占带宽资源的保证,又可以在每一个通道化的子接口内部采用基于IP/MPLS技术的流量管理机制,实现同一分片内业务统计复用,分片之间业务互不影响。采用基于QoS的报文调度成为降低网络端到端低时延的关键,QoS 技术通过流量监管、流量整形、拥塞管理、拥塞避免等基于共享缓存队列调度的机制,实现不同业务的差分服务。这种报文调度引起的时延主要分为两部分:队列缓存时延和调度算法执行的调度器响应时延。队列调度算法的性能直接影响时延,调度算法通过有效性、公平性、可编程性,成为降低报文调度时延的主要手段。层次化 QoS (hierarchical quality of service,HQoS),是一种通过多级队列调度机制,解决DiffServ(区分服务)模型下多用户多业务带宽保证的技术。通过多级调度,可以精细区分不同用户和不同业务的流量,提供区分的带宽管理。统计复用与硬管道隔离的区别示意图如图4所示。

图3

图3 FlexE的3种主要功能

图4

图4 统计复用与硬管道隔离的区别示意图

这种 IP/MPLS 网络基于 QoS 提供差异化SLA保证的调度机制,进一步与通道化的灵活以太接口配合,在物理层可以完全消除报文传输所引起的抖动。相对于在数据平面不支持硬件隔离及 SLA 业务保证的软分片技术,可以进一步提供针对5G应用中对于有界时延业务的保证,达到5G承载的时延保证要求。基于QoS技术的流量调度模块,可以根据业务的 SLA 要求,为每个业务分配相应的硬件缓存资源,相当于在报文调度中为每个业务划分独立的缓存及数据通道,不同业务的数据通道之间、业务流量传输过程中,这些硬件资源完全不共享。在每个FlexE通道化接口对应的分片资源内部,采用 IP/MPLS技术的流量管理技术进行缓存调度。缓存资源的独占,使得各个业务在QoS调度中得到硬隔离,有效避免流量突发时,出现各业务争抢缓存资源,导致业务SLA劣化等问题。FlexE技术应用于STN架构示意图如图5所示。

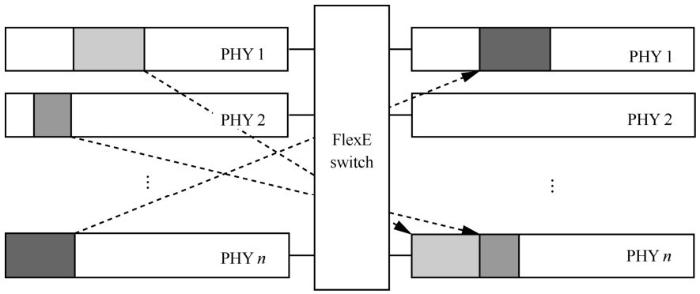

4 5G STN承载网切片技术与FlexE电路交叉分析

业界在探讨灵活以太应用于 5G 承载网络的技术方案时,还在探讨基于TDM技术直接在以太接口L1层实现FlexE switch的思路。FlexE switch原理示意图如图6所示。在这种方案中,每一个转发节点中的数据报文在入接口直接基于FlexE shim 结构中定义的 64B/66B 数据块进行交叉,不再进行 STN承载网络中灵活以太接口MAC层报文恢复以及基于报文信息的IP/MPLS调度处理。

这种基于TDM机制的FlexE switch在每个交叉节点上的时延是确定的,包括报文在入口基于相应通道化接口带宽决定的并行化时延,64B/66B数据块通过switch矩阵的时延,以100GE灵活以太接口提供1 Gbit/s通道化为例,受不同的芯片实现方式影响,时延一般在100~500 ns范围。考虑5G多业务承载的不同需求,引入基于TDM交换的 FlexE 技术还需要考虑如下几个关键问题:全网基于每条业务类型对应的 FlexE 交叉时间片进行统一规划、调度;每条业务需要精确映射到全网时间片资源中;由于运营商网络的规模较大和海量的链接,这些规划及部署比较挑战,很多情况下存在 NP-hard 问题,学术界在这方面正在进行研究。

图5

图5 FlexE技术应用于STN架构示意图

图6

图6 FlexE switch原理示意图

基于FlexE 64B/66B数据块的时分复用交叉(TDM switch)机制,等同于直通式(cut-through)的转发方式(不存储转发方式),由于在每一个节点不进行逐跳完整报文的校验,需要基于E2E链路的机制保证报文可靠的传输。如何满足5G承载多业务,不同带宽需要数据流的可靠传输,也是这方面需要面临的挑战,尤其是在通道化灵活以太支持小粒度接口时的大容量转发芯片设计中。

在ITU-T G.mtn正在开展FlexE接口进行通道化并在物理层建立E2E的L1层TDM的承载技术。目前这一技术面临两个较大的挑战:首先,为了支持承载业务,需要考虑 OAM 如何通过FlexE接口与更底层的Ethernet PHY进行传输。当前正在进行如何建立起合适的OAM机制的讨论中,包括利用 FlexE 接口开销帧中的段层管理通道(section management channel)或者采用额外的 1~3 个 66 bit 数据码块进行标识。其中,第一个码块被编码为有序集(ordered set),该有序集码块包含24 bit的OAM信息。并进一步考虑扩展第二块和第三块OAM码块,则后续的码块均为64 bit的OAM信息。这一机制的 OAM 码块虽然符合 64B/66B 编码格式,但已经超出IEEE 802.3标准定义的编码表,这使得G.mtn OAM码块与传统以太接口的不兼容以至于无法对接。其次,在 G.mtn 中处于对接的两端需要额外的空闲码块增删机制以调整适应每个 G.mtn 段层的时钟速率偏差,这一种处理方式也是目前传统以太接口不支持的。G.mtn的空闲码块增删是基于 64B/66B 数据块进行。而传统以太网接口是基于空闲控制字段(idle character)进行增删的。这也是G.mtn需要进一步去脱离本生的灵活以太技术去额外定义。G.mtn成功应用于5G承载网络仍需要大量技术研究和标准化工作。

5G承载网络的多业务灵活组网,要求逐节点的进行基于IP/MPLS报文信息的转发、SLA保证业务处理等。因此,一旦基于FlexE switch的TDM机制需要在每一个节点恢复报文进行 L2/L3 层的转发及流量调度处理,则需要采用本文探讨的5G STN承载网络切片创新技术:基于IP/MPLS机制以及结合“通道化灵活以太接口”的架构才能满足要求。

5 结束语

中国电信针对IP/MPLS网络中提供SLA可保障的业务承载已经进行了完善及全面的研究和分析,并进一步应用于 4G/5G 融合的承载网络中。IETF 起草了很多有关保证业务的服务模型和机制。其中比较常见的有:综合服务(简称IntServ)模型、区分服务(简称DiffServ)模型。IntServ通过RSVP信令机制提供端到端的QoS保证,特定应用在传输报文前先向网络提出带宽、时延等服务申请,每个网络节点视当前资源使用状况为其分配资源,并监视应用连接每条流的状态。如果请求不符合要求节点将发送一个差错信息给接收端,并且中断信令的处理过程。如果请求被接受,就按照约定服务水平为该业务分配链路带宽和缓冲区空间。承载网络在传送业务报文过程中执行报文的分类、流量监管、排队调度等。这种体系能够明确区分并保证每一个业务流的服务质量,为网络提供最细粒度化的服务质量区分。RFC 2212 进一步定义了有保障的服务(guaranteed service),对带宽、时延、丢包率提供定量的要求和质量保证措施。这些服务模型由于规避了传送过程中的拥塞及冲突,可以满足时延敏感业务的承载。DiffServ模型是一种多服务模型,根据每个报文携带的优先级将网络上传输的业务分成不同的业务流,通过逐跳行为(PHB)为每种业务提供差分服务。业界在IEEE/IETF标准中已经在基于这些思想进行 5G承载技术方案的讨论和制定,并且充分论证了基于IP/MPLS的创新架构及机制可以达到等同于 TDM 网络的最差时延上界,这也是 STN 承载技术的研究成果体现。

综上所述,基于支持 5G 多业务差异化服务的SLA保障机制与FlexE切片技术结合是中国电信 STN 智能承载网在提供低时延及业务保证的关键技术方案。通过基于IP/MPLS架构上的进一步精细独立缓存资源,物理端口基于时隙切片,两者灵活组合实现业务流量硬隔离,做到业务从承载网络入口到出口的端到端SLA保障,是进一步满足4G/5G融合承载关键网络技术。

The authors have declared that no competing interests exist.

作者已声明无竞争性利益关系。

本文介绍了FlexE技术,它是一种电信级接口技术,可实现Ethernet MAC与PHY层解耦。阐述了其应用功能,如捆绑、通道化和子速率。还分析了基于FlexE技术的STN承载网架构,以及5G STN承载网切片技术与FlexE电路交叉问题,指出两者结合是关键技术方案。

本文介绍了FlexE技术,它是一种电信级接口技术,可实现Ethernet MAC与PHY层解耦。阐述了其应用功能,如捆绑、通道化和子速率。还分析了基于FlexE技术的STN承载网架构,以及5G STN承载网切片技术与FlexE电路交叉问题,指出两者结合是关键技术方案。

3815

3815