目录

1、ollama安装

1.1、windows下载ollama并安装

1.1、进入ollama官网(Ollama)

1.2、点击Download,我这里下载的是windows的

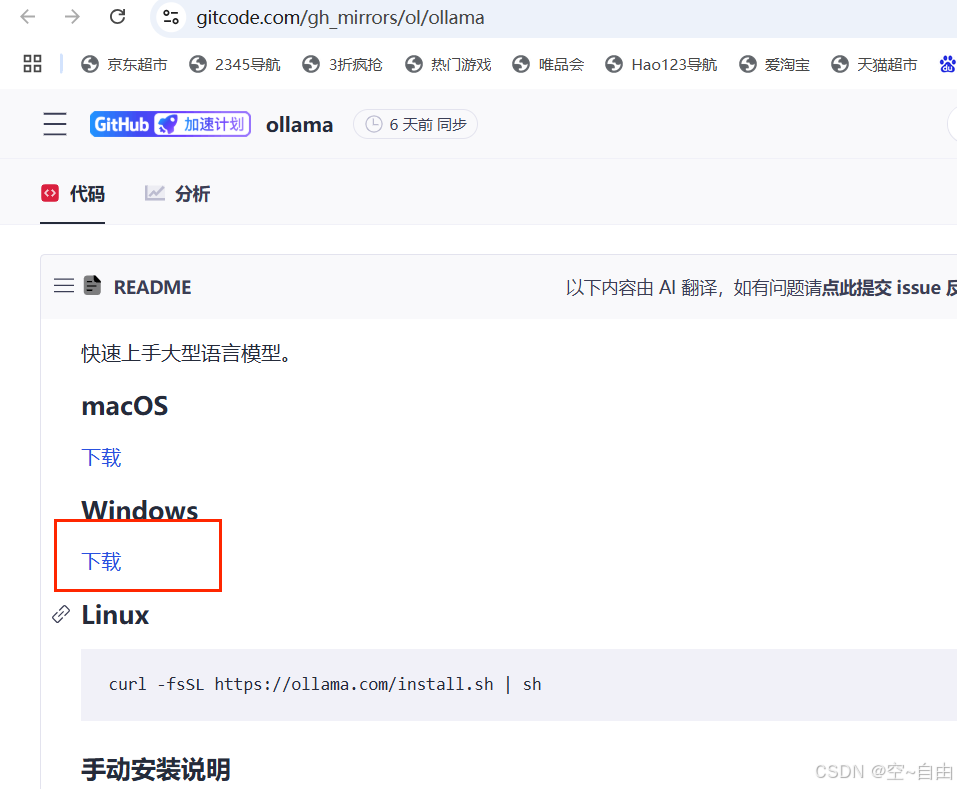

如果下载失败,可以从GitCode - 全球开发者的开源社区,开源代码托管平台下载

注意:如果还是下载失败,可以从百度网盘下载:Ollama

链接: 百度网盘 请输入提取码 提取码: 77i5

1.3、下载完后,双击,点击install安装

运行安装程序:下载完成后,双击运行安装包,并按照提示完成安装

验证安装:安装完成后,打开命令提示符(cmd)窗口,输入ollama命令,如果显示Ollama相关的信息,则证明安装已经成功

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

8413

8413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?