一、诊断偏差和方差

当你运行一个学习算法时,如果这个算法的表现不理想,那么多半是出现两种情况: 要么是偏差比较大,要么是方差比较大。换句话说,出现的情况要么是欠拟合,要么是过拟 合问题。那么这两种情况,哪个和偏差有关,哪个和方差有关,或者是不是和两个都有关? 搞清楚这一点非常重要,因为能判断出现的情况是这两种情况中的哪一种。其实是一个很有效的指示器,指引着可以改进算法的最有效的方法和途径。

训练集误差和交叉验证集误差近似时:偏差/欠拟合

交叉验证集误差远大于训练集误差时:方差/过拟合

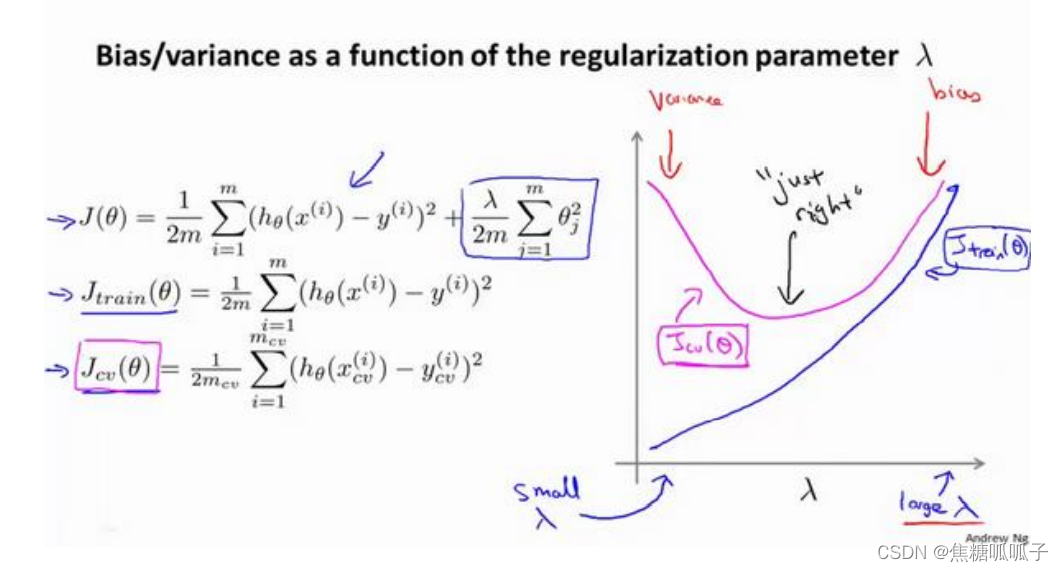

二、正则化与偏差/方差

在我们在训练模型的过程中,一般会使用一些正则化方法来防止过拟合。但是我们可能 会正则化的程度太高或太小了,即我们在选择 λ 的值时也需要思考与刚才选择多项式模型次 数类似的问题。

我们选择一系列的想要测试的 𝜆 值,通常是 0-10 之间的呈现 2 倍关系的值(如: 0,0.01,0.02,0.04,0.08,0.15,0.32,0.64,1.28,2.56,5.12,10共 12 个)。我们同样把数据分为训练 集、交叉验证集和测试集。

选择𝜆的方法为:

1.使用训练集训练出 12 个不同程度正则化的模型

2.用 12 个模型分别对交叉验证集计算交叉验证误差

3.选择交叉验证误差最小的模型

4.运用步骤 3 中选出模型对测试集计算得出推广误差,我们也可以同时将训练集和交叉验证集模型的代价函数误差与 λ 的值绘制在一张图表上:

• 当 𝜆 较小时,训练集误差较小(过拟合)而交叉验证集误差较大

• 随着 𝜆 的增加,训练集误差不断增加(欠拟合),而交叉验证集误差则是先减小后增加。

• 最终选择的 𝜆 取值为使交叉验证集误差最小的 𝜆。

1. 获得更多的训练实例——解决高方差

2. 尝试减少特征的数量——解决高方差

3. 尝试获得更多的特征——解决高偏差

4. 尝试增加多项式特征——解决高偏差

5. 尝试减少正则化程度 λ——解决高偏差

6. 尝试增加正则化程度 λ——解决高方差

本文探讨了机器学习中模型表现不佳时可能遇到的偏差和方差问题,以及它们与欠拟合和过拟合的关系。通过训练集和交叉验证集误差的比较,可以判断模型的偏差或方差是否过高。正则化是防止过拟合的有效手段,通过选择合适的λ值,可以在训练和交叉验证误差间找到平衡。文章还提出了调整模型的多种策略,包括增减特征、改变正则化程度等,以优化模型性能。

本文探讨了机器学习中模型表现不佳时可能遇到的偏差和方差问题,以及它们与欠拟合和过拟合的关系。通过训练集和交叉验证集误差的比较,可以判断模型的偏差或方差是否过高。正则化是防止过拟合的有效手段,通过选择合适的λ值,可以在训练和交叉验证误差间找到平衡。文章还提出了调整模型的多种策略,包括增减特征、改变正则化程度等,以优化模型性能。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?