PMD是Poll Mode Driver的缩写,即基于用户态的轮询机制的驱动。本文将介绍PMD的基本原理。

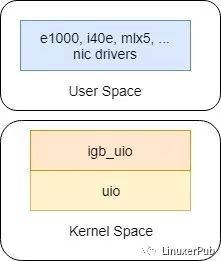

在不考虑vfio的情况下,PMD的结构图如下:

图1. PMD结构图

虽然PMD是在用户态实现设备驱动,但还是依赖于内核提供的策略。其中uio模块,是内核提供的用户态驱动框架,而igb_uio是DPDK kit中拥有与uio交互,bind指定网卡的内核模块。

当使用DPDK脚本dpdk-devbind来bind网卡时,会通过sysfs与内核交互,让内核使用指定驱动来匹配网卡。具体的行为向/sys/bus/pci/devices/(pci id)/driver_override写入指定驱动名称,或者向/sys/bus/pci/drivers/igb_uio(驱动名称)/new_id写入要绑定网卡的PCI ID。前者是配置设备,让其选择驱动。后者是是配置驱动,让其支持新的PCI设备。按照内核的文档https://www.kernel.org/doc/Documentation/ABI/testing/sysfs-bus-pci,这两个动作都会促使驱动bind新设备。但是在dpdk-devbind脚本中,还是通过向/sys/bus/pci/drivers/igb_uio(驱动名称)/bind写入pci id来保证bind。—— 也许是处于兼容性考虑吧。

当使用igb_uio bind指定设备后,内核会调用igb_uio注册的struct pci_driver的probe函数,即igbuio_pci_probe。在这个函数中,设置PCI的一些操作(如设置PCI BAR、DMA等),不是重点,那是驱动工程师的职责:) 对于PMD来说,重点是与UIO的交互。

1. 调用igbuio_setup_bars,设置uio_info的uio_mem和uio_port。

PMD(Poll Mode Driver)是DPDK中的用户态驱动,依赖于内核的uio模块。当使用DPDK的dpdk-devbind工具绑定网卡时,内核会调用igb_uio的probe函数,设置PCI BAR并注册uio设备。PMD通过uio_open打开设备,并在用户态进行中断处理,实现轮询机制读取网卡数据。

PMD(Poll Mode Driver)是DPDK中的用户态驱动,依赖于内核的uio模块。当使用DPDK的dpdk-devbind工具绑定网卡时,内核会调用igb_uio的probe函数,设置PCI BAR并注册uio设备。PMD通过uio_open打开设备,并在用户态进行中断处理,实现轮询机制读取网卡数据。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4016

4016

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?