一、问题引入:

在信息论中,相对熵(Relative Entropy),也称为Kullback-Leibler散度(Kullback-Leibler Divergence,简称KL散度),是两个概率分布之间差异的一种度量。理解相对熵的非负性对于掌握信息论的基本概念至关重要。

二、问题简述:

若和

是相对于同一信源的两个概念测度,人们通常希望度量概率分布

和

之间的差异,这时需要定义一个量,称为相对熵(relative entropy)。

相对于

的相对熵定义为:

相对熵具有非负性,下面来证明相对熵的非负性。

三、证明过程:

①当P、Q两信源为离散信源时,此时相对熵的定义为:

对于任何 ,有:

,当且仅当

时等号成立。(文末补充证明)

∴项不影响结果

∵

∴

∴

综上可得:

当且仅当P与Q分布完全一致时,等号成立。

②当P、Q两信源为连续信源时,此时相对熵的定义为:

其中 和

是两个概率密度函数,满足

和

,并且它们的积分都等于1。

对于任何 ,有:

当且仅当 时等号成立。(文末补充证明)

设 ,则:

将上述不等式代入相对熵的定义中,得到:

简化上述表达式:

由于 和

,上式可改写为:

综上可得:

当且仅当P与Q分布完全一致时,等号成立。

下面来补充证明不等式:

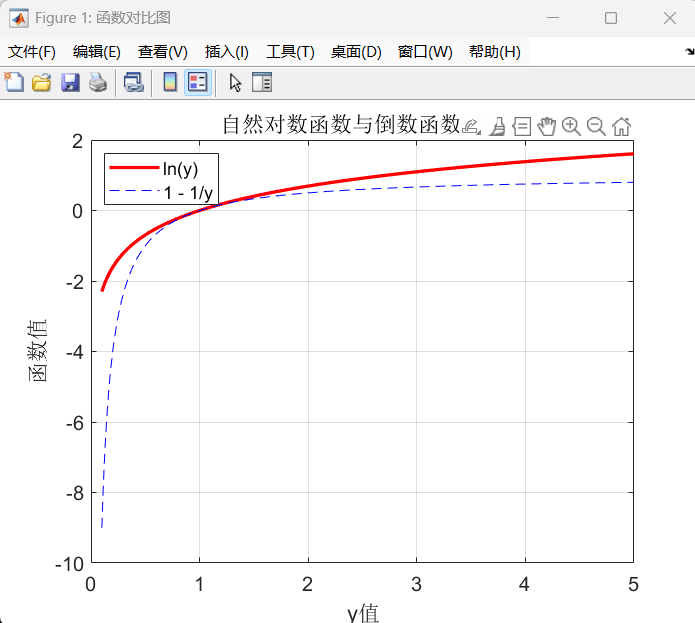

使用MATLEB软件,利用函数图像证明。

代码部分如下:

clear

clc

close all

% 定义y的取值范围(避免y=0时对数无定义的情况)

y_values = linspace(0.1, 5, 491); % 使用linspace替代冒号运算符

% 使用cellfun计算函数值

funcs = {@(y) log(y), @(y) 1 - 1./y}; % 定义两个匿名函数

f_vals = funcs{1}(y_values); % 计算第一个函数的值

g_vals = funcs{2}(y_values); % 计算第二个函数的值

% 创建图形窗口并设置样式

fig = figure('Name', '函数对比图', 'Color', 'white'); % 创建白色背景的图形窗口

ax = axes(fig); % 创建坐标轴

% 绘制两条函数曲线

plot(ax, y_values, f_vals, 'Color', 'r', 'LineWidth', 2, 'DisplayName', 'ln(y)');

hold on;

plot(ax, y_values, g_vals, 'Color', 'b', 'LineStyle', '--', 'DisplayName', '1 - 1/y');

% 添加坐标轴标签和标题

xlabel('y值'); % x轴标签

ylabel('函数值'); % y轴标签

title('自然对数函数与倒数函数对比'); % 图形标题

% 配置坐标轴和图例样式

grid on; % 显示网格

set(ax, 'FontSize', 12); % 设置字体大小

legend('show', 'Location', 'northwest'); % 在左上角显示图例

生成的函数图像如下:

371

371

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?