##决策树

互信息:衡量2个变量是否独立的指标,若独立则联合概率等于概率的乘积,既I(X,Y)=p(x,y)log1=0,不独立则不等于0

条件熵等于熵减互信息

信息增益

信息增益率:信息增益除以本身的熵

基尼系数

评价

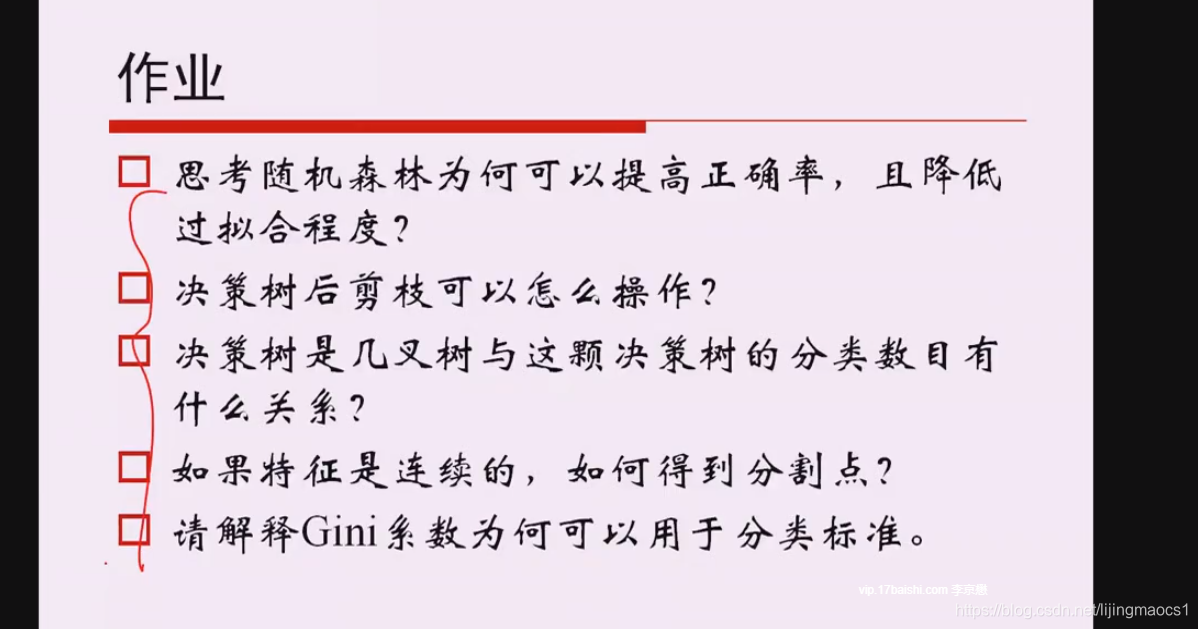

剪枝

随机森林

out of bag

随机森林每一颗树的样本数可以跟总样本数一样,也可以不一样;特征的选择也是随机的

随机森林每棵树的训练样本不一样

极限森林:多了一项,分裂条件随机(不是最好的分裂条件),一般是选择使得信息增益最大的阈值作为分裂条件,但是极限森林是给每个候选特征随机阈值,在这些随机给出的阈值中选择信息增益最大的作为分裂条件。

投票机制

样本不均衡的处理方法

例:正例990,负例10

重采样:10个负例重复使用(10*10),10个负例当中每个负例重复的次数可能不同(构造多个分类器,集成)

降采样:10个负例全要,正例按一定比例随机抽取(构造多个分类器,集成)

**一般降采样效果好于重采样

聚类法:将数量多的样本聚类成N个簇,再与数量小的样本进行分析

插值法:随机差值生成新的小样本

RF计算样本相似度

思想:2个样本经过决策树分类后若被分到同一个叶子节点则说明2个样本比较相似。统计N颗决策树中,2个样本被分到不同叶子节点的次数,若2个样本出现在相同叶子节点的次数越多,则越相似

RF计算特征重要度

RF异常检测

决策树处理回归问题时,y值为叶子节点对应所有x对应y的均值

8689

8689

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?