原文地址:enhancing-llms-reasoning-with-step-back-prompting

论文地址:https://arxiv.org/pdf/2310.06117.pdf

2023 年 11 月 6 日

概述

在大型语言模型不断发展的领域中,一个持续的挑战是它们处理复杂任务的能力,这些任务需要深入理解微妙的细节和上下文。

"后退提示"(Step-Back Prompting)现象已经作为一种创新方法出现,以解决这一问题,它识别了许多包含无数复杂性的任务。

这些任务可能使得大型语言模型难以有效地检索和应用相关信息。

Step Back提示

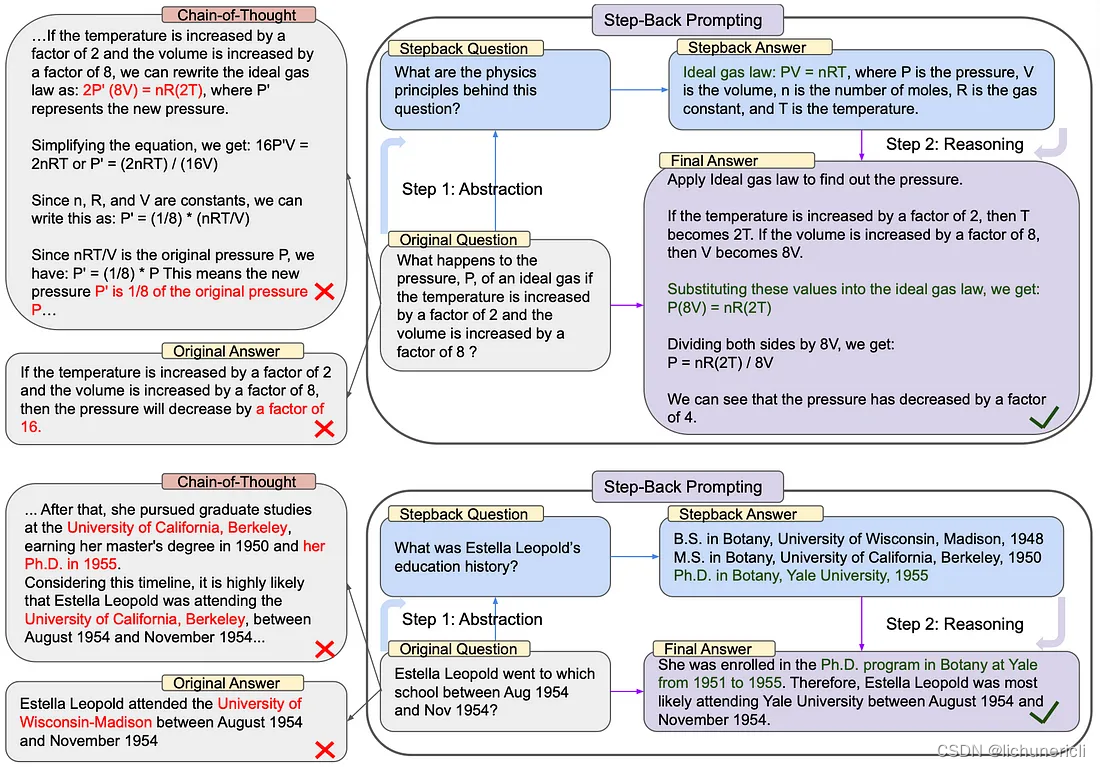

后退提示是一种用于增强语言模型的推理和问题解决能力的技巧,特别是LLMs。它涉及鼓励LLM从一个给定的问题或问题后退一步,提出一个更抽象、更高级的问题,涵盖原始查询的本质。

后退提示背后的概念是,许多复杂的问题或任务包含许多复杂的细节和约束,这使得LLMs难以直接检索和应用相关信息。

通过引入一个后退问题,这个问题通常更容易回答,并且围绕一个更广泛的概念或原则,LLMs 可以更有效地构建它们的推理。

后退提示的典型过程包括两个主要步骤:

- 抽象化:这时大型语言模型(LLM)不会立即尝试回答原始问题。相反,它会提出一个关于更大想法或规则的一般性问题。这有助于它思考和寻找事实。

- 推理:在得到一般性问题的答案后,LLM使用这些信息来思考和回答原始问题。这称为“基于抽象的推理”。它使用来自更大想法的信息来对原始的、更难的问题给出好的答案。

LangChain 实现

提供一些少样本示例,这将展示后退提示是如何工作的。然后我们将转换这些示例信息。

# Few Shot Examples

examples = [

{

"input": "What is the birthplace of Albert Einstein?",

"output": "what is Albert Einstein's personal history?",

},

{

"input": "Can a Tesla car drive itself?",

"output": "what can a Tesla car do?",

},

{

后退提示(Step Back Prompting)是一种提升大型语言模型(LLMs)推理能力的方法。通过让LLM先提出一个更抽象的问题,然后再基于此进行推理,从而更好地处理复杂任务。本文介绍了Step Back提示的概念、过程,并通过LangChain实现展示了其工作原理。

后退提示(Step Back Prompting)是一种提升大型语言模型(LLMs)推理能力的方法。通过让LLM先提出一个更抽象的问题,然后再基于此进行推理,从而更好地处理复杂任务。本文介绍了Step Back提示的概念、过程,并通过LangChain实现展示了其工作原理。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

545

545

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?