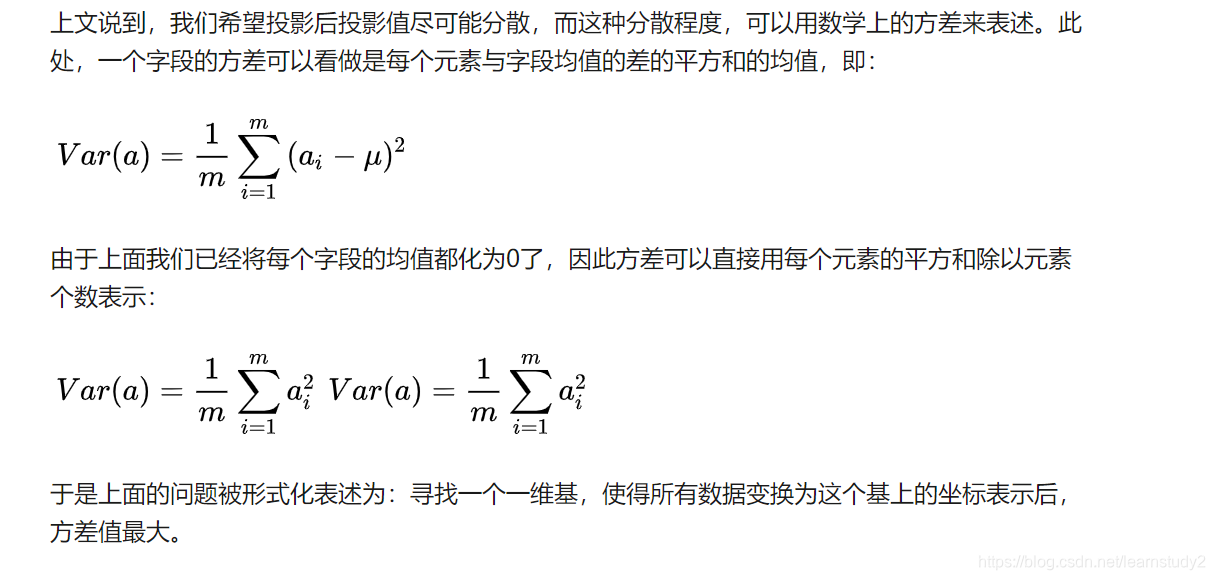

对于上面二维降成一维的问题来说,找到那个使得方差最大的方向就可以了。不过对于更高维,还有一个问题需要解决。考虑三维降到二维问题。与之前相同,首先我们希望找到一个方向使得投影后方差最大,这样就完成了第一个方向的选择,继而我们选择第二个投影方向。

如果我们还是单纯只选择方差最大的方向,很明显,这个方向与第一个方向应该是“几乎重合在一起”,显然这样的维度是没有用的,因此,应该有其他约束条件。从直观上说,让两个字段尽可能表示更多的原始信息,我们是不希望它们之间存在(线性)相关性的,因为相关性意味着两个字段不是完全独立,必然存在重复表示的信息。

当协方差为0时,表示两个字段完全独立。为了让协方差为0,我们选择第二个基时只能在与第一个基正交的方向上选择。因此最终选择的两个方向一定是正交的。

至此,我们得到了降维问题的优化目标:将一组N维向量降为K维(K大于0,小于N),其目标是选择K个单位(模为1)正交基,使得原始数据变换到这组基上后,各字段两两间协方差为0,而字段的方差则尽可能大(在正交的约束下,取最大的K个方差)。

PCA的思想是将n维特征映射到k维上(k<n),这k维是全新的正交特征。这k维特征称为主成分,是重新构造出来的k维特征,而不是简单地从n维特征中去除其余n-k维特征。

最大特征值相应的特征向量的方向就是所有原数据在投影方差最大的方向,就是在所有的方向中,投影方差最大的那个方向。

引用《线性代数的几何意义》的描述:“矩阵乘法对应了一个变换,是把任意一个向量变成另一个方向或长度都大多不同的新向量。在这个变换的过程中,原向量主要发生旋转、伸缩的变化。如果矩阵对某一个向量或某些向量只发生伸缩变换,不对这些向量产生旋转的效果,那么这些向量就称为这个矩阵的特征向量,伸缩的比例就是特征值。”

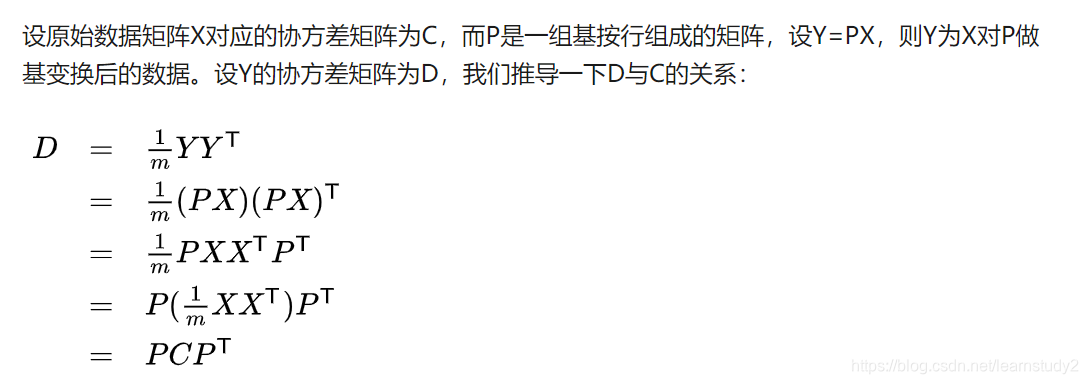

协方差矩阵

协方差矩阵的每个元素是各个向量元素之间的协方差

协方差矩阵为对称非负定矩阵

数学期望

期望(mean):也就是均值,是概率加权下的“平均值”,是每次可能结果的概率乘以其结果的总和,反映的是随机变量平均取值大小。

连续性

E

(

X

)

=

∫

−

∞

∞

x

f

(

x

)

d

x

E(X)=\int_{-\infin}^\infin xf(x)dx

E(X)=∫−∞∞xf(x)dx

离散型

E

(

X

)

=

∑

i

x

i

p

i

E(X)=\displaystyle \sum_ix_ip_i

E(X)=i∑xipi

假设

C

C

C为一个常数

E

(

C

)

=

C

E

(

C

X

)

=

C

E

(

X

)

E

(

X

+

Y

)

=

E

(

X

)

+

E

(

Y

)

E(C)=C \\ E(CX)=CE(X) \\ E(X+Y) = E(X) + E(Y)

E(C)=CE(CX)=CE(X)E(X+Y)=E(X)+E(Y)

如果

X

X

X与

Y

Y

Y相互独立,那么

E

(

X

Y

)

=

E

(

X

)

E

(

Y

)

E(XY)=E(X)E(Y)

E(XY)=E(X)E(Y)

如果

E

(

X

Y

)

=

E

(

X

)

E

(

Y

)

E(XY)=E(X)E(Y)

E(XY)=E(X)E(Y),那么

X

X

X与

Y

Y

Y不相关

E

(

X

+

Y

)

=

∑

x

∑

y

(

x

+

y

)

P

(

X

=

x

,

Y

=

y

)

E(X+Y)=\sum_x\sum_y(x+y)P(X=x,Y=y)

E(X+Y)=x∑y∑(x+y)P(X=x,Y=y)

E

(

X

+

Y

)

=

∫

−

∞

∞

∫

−

∞

∞

(

x

+

y

)

f

(

x

,

y

)

d

x

d

y

E(X+Y)=\int_{-\infin}^\infin\int_{-\infin}^\infin(x+y)f(x,y)dxdy

E(X+Y)=∫−∞∞∫−∞∞(x+y)f(x,y)dxdy

方差

D

(

X

)

=

∑

i

=

1

n

p

i

(

x

i

−

μ

)

2

D

(

X

)

=

∫

a

b

(

x

−

μ

)

2

f

(

x

)

d

x

D(X) =\sum_{i=1}^np_i(x_i-\mu)^2 \\ D(X)=\int_a^b(x-\mu)^2f(x)dx

D(X)=i=1∑npi(xi−μ)2D(X)=∫ab(x−μ)2f(x)dx

D ( X ) = E ( ( X − E ( X ) ) 2 ) = E ( X 2 ) − ( E ( X ) ) 2 D(X)=E((X-E(X))^2)=E(X^2)-(E(X))^2 D(X)=E((X−E(X))2)=E(X2)−(E(X))2

假设

C

C

C为一个常数

D

(

C

)

=

0

D

(

C

X

)

=

C

2

D

(

X

)

D

(

C

+

X

)

=

D

(

X

)

D

(

X

±

Y

)

=

D

(

X

)

+

D

(

Y

)

±

2

C

o

v

(

X

,

Y

)

D(C)=0 \\ D(CX)=C^2D(X) \\ D(C+X) = D(X) \\ D(X\pm Y)= D(X) + D(Y) \pm 2Cov(X,Y)

D(C)=0D(CX)=C2D(X)D(C+X)=D(X)D(X±Y)=D(X)+D(Y)±2Cov(X,Y)

如果

X

X

X与

Y

Y

Y不相关,那么

D

(

X

±

Y

)

=

D

(

X

)

+

D

(

Y

)

D(X\pm Y)= D(X) + D(Y)

D(X±Y)=D(X)+D(Y)

协方差

C

o

v

(

X

,

Y

)

=

E

{

(

X

−

E

(

X

)

)

(

Y

−

E

(

Y

)

}

Cov(X,Y) = E\{(X-E(X))(Y-E(Y)\}

Cov(X,Y)=E{(X−E(X))(Y−E(Y)}

假设

a

,

b

a,b

a,b为常数,那么

C

o

v

(

X

,

Y

)

=

C

o

v

(

Y

,

X

)

C

o

v

(

a

X

,

b

Y

)

=

a

b

C

o

v

(

X

,

Y

)

C

o

v

(

X

1

+

X

2

,

Y

)

=

C

o

v

(

X

1

,

Y

)

+

C

o

v

(

X

2

,

Y

)

Cov(X,Y) =Cov(Y,X) \\ Cov(aX,bY) = abCov(X,Y) \\ Cov(X_1+X_2,Y)=Cov(X_1,Y) + Cov(X_2,Y)

Cov(X,Y)=Cov(Y,X)Cov(aX,bY)=abCov(X,Y)Cov(X1+X2,Y)=Cov(X1,Y)+Cov(X2,Y)

若

C

o

v

(

X

,

Y

)

>

0

Cov(X,Y)>0

Cov(X,Y)>0,则

X

X

X与

Y

Y

Y变化趋势相同

若

C

o

v

(

X

,

Y

)

<

0

Cov(X,Y)<0

Cov(X,Y)<0,则

X

X

X与

Y

Y

Y变化趋势相反

若

C

o

v

(

X

,

Y

)

=

0

Cov(X,Y)=0

Cov(X,Y)=0,则

X

X

X与

Y

Y

Y不相关,也就是其变化没有什么相关性

本文深入探讨了PCA(主成分分析)的降维原理,解释了如何通过选择使方差最大化的方向来降低数据维度,同时保持数据的主要特性。讨论了在高维数据中寻找正交基的重要性,以及如何确保投影后的字段间协方差为零,从而实现信息的最大保留。

本文深入探讨了PCA(主成分分析)的降维原理,解释了如何通过选择使方差最大化的方向来降低数据维度,同时保持数据的主要特性。讨论了在高维数据中寻找正交基的重要性,以及如何确保投影后的字段间协方差为零,从而实现信息的最大保留。

267

267

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?