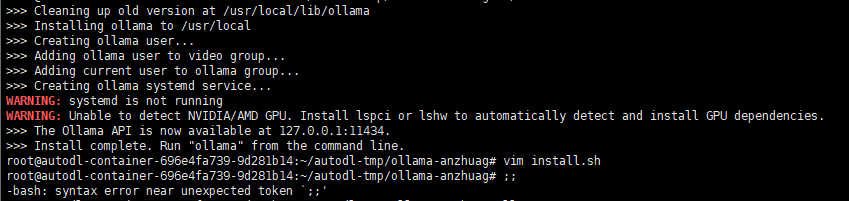

一, 下载脚本和安装包

- 下载脚本

wget https://ollama.com/install.sh

- 修改脚本

#注释掉下面4行代码

#status "Downloading Linux ${ARCH} bundle"

#curl --fail --show-error --location --progress-bar \

# "https://ollama.com/download/ollama-linux-${ARCH}.tgz${VER_PARAM}" | \

# $SUDO tar -xzf - -C "$OLLAMA_INSTALL_DIR"

#接着添加这行代码

$SUDO tar -C "$OLLAMA_INSTALL_DIR" -xzf ./ollama-linux-amd64.tgz

- 修改权限:

sudo chmod a+x install.sh

-

下载安装包

github地址

[后续放在网盘里]

根据cpu选择对应的,我的是ollama-linux-amd64.tgz , 注意install.sh 和 ollama-linux-amd64.tgz 在相同路径下 -

执行安装

./install.sh

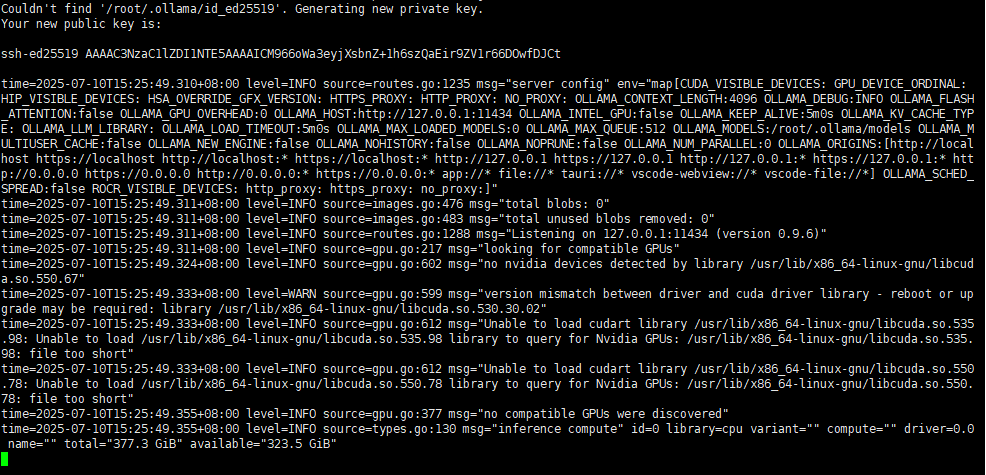

二,启动测试

- 启动

ollama serve

2.查询版本

root:~/ollama-model# ollama -v

ollama version is 0.9.6

- 关闭服务

service ollama stop

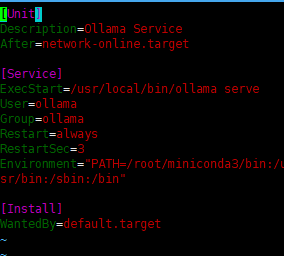

三,添加开机自启服务

- 修改配置文件

sudo vim /etc/systemd/system/ollama.service

根据上图进行修改

- 把User改为 你的linux系统用户名 ,Group 改为 你的linux用户组

- 添加 Environment=“OLLAMA_MODELS=/path/ollama_cache” 改为你的路径

- 添加 Environment=“OLLAMA_HOST=0.0.0.0:11434” 配置ollama 服务监听所有IP和端口11434

修改后如下:

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/local/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

Environment="OLLAMA_MODELS=/root/ollama-model"

Environment="OLLAMA_HOST=0.0.0.0:11434

Environment="PATH=/root/miniconda3/bin:/usr/local/bin:/usr/local/nvidia/bin:/usr/local/cuda/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin"

[Install]

WantedBy=default.target

2.重新加载配置

systemctl daemon-reload

3.启动ollama

systemctl start ollama

如果是autoDL服务器,它的系统未使用 systemd 作为初始化系统,因此无法通过 systemctl 命令管理服务,只手工启动即可

# 前台启动(适合调试,关闭终端则服务停止)

ollama serve

# 后台启动(推荐,服务在后台运行)

ollama serve &

# 停止服务

service ollama stop

- 查询模型配置文件

ollama show deepseek --modelfile

5234

5234

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?