Java作为企业级应用开发的主力语言,其并发模型一直以线程为核心。然而,随着云原生和微服务架构的普及,传统的线程模型面临着严峻挑战。本文将深入解析JEP 425(虚拟线程)的架构设计,从历史演进、技术原理到实践应用,全面剖析这一改变Java并发编程范式的重大创新。我们将通过生活化类比、代码示例和架构图解,揭示虚拟线程如何在不改变编程模型的前提下,实现数量级的吞吐量提升,以及它对企业级应用架构的深远影响。

传统线程模型的困境与演进需求

在深入探讨JEP 425之前,我们必须理解Java现有线程模型面临的本质问题。Java从诞生之初就采用了1:1的线程模型,即每个Java线程直接对应一个操作系统线程(在Unix-like系统上通常通过pthread实现,Windows上则对应内核线程)。这种设计在单机性能有限、并发需求不高的时代表现良好,但随着互联网应用规模的爆炸式增长,其局限性日益凸显。

操作系统线程的固有瓶颈

操作系统线程作为计算资源调度的基本单位,其创建和切换都涉及昂贵的上下文切换。每次上下文切换需要保存和恢复寄存器状态、更新内存管理单元(MMU)的页表、以及处理CPU缓存失效等问题。根据测试,在现代Linux系统上,创建和销毁一个线程的开销大约在2-10微秒,而线程上下文切换的开销则在1-2微秒。当并发连接数达到万级时,这些开销会显著降低系统性能。

更严重的是,操作系统线程需要预分配较大的栈空间(通常默认1-2MB),这意味着单个JVM实例能创建的线程数受限于物理内存容量。假设每个线程占用1MB栈空间,32GB内存的服务器理论上最多只能支持约3万个线程,而实际应用中由于堆内存和其他资源的占用,这个数字往往更低。

利特尔定律(Little's Law)与吞吐量瓶颈

服务器应用的性能通常遵循利特尔定律,该定律建立了并发数、吞吐量和延迟之间的数学关系:

其中:

-

是平均并发请求数

-

是平均吞吐量(单位时间完成的请求数)

-

是平均请求处理时间(延迟)

根据利特尔定律,要提升吞吐量,在延迟

不变的情况下,必须增加并发数

。对于采用thread-per-request模型的Java服务器,这意味着需要创建更多线程。

举例来说,假设一个HTTP服务的平均处理时间为50ms(包括I/O等待),要达到每秒2000请求的吞吐量,根据利特尔定律:

即需要同时处理100个请求,也就是需要100个线程。当吞吐量需求上升到每秒2万请求时,需要的线程数就达到1000个。这种线性扩展关系使得传统线程模型很快遇到操作系统线程数的上限,成为系统吞吐量的瓶颈。

异步编程的妥协与代价

面对线程资源的限制,开发者转向了异步编程模型,如CompletableFuture或反应式编程(Reactive Programming)。这些技术通过回调机制和事件循环,实现了线程的复用,避免了为每个请求分配专用线程。

典型的异步代码可能长这样:

CompletableFuture.supplyAsync(() -> fetchUserFromDB(userId))

.thenApply(user -> fetchOrdersForUser(user))

.thenAccept(orders -> processOrders(orders))

.exceptionally(ex -> handleError(ex));

虽然异步模型解决了线程资源问题,但它带来了显著的开发复杂度:

-

代码可读性下降:业务逻辑被拆分为多个回调,破坏了自然的代码顺序结构

-

调试困难:堆栈跟踪不连贯,难以追踪完整的请求处理流程

-

与现有生态不兼容:许多Java库(如JDBC)是基于阻塞I/O设计的,与异步模型不匹配

-

线程上下文丢失:MDC(Mapped Diagnostic Context)等依赖线程本地的机制失效

这些缺点使得异步编程成为许多团队不得已的选择,而非理想方案。

虚拟线程的提出与设计目标

JEP 425提出的虚拟线程正是为了解决上述困境,其核心设计目标包括:

-

保持thread-per-request编程模型:开发者可以继续使用熟悉的同步代码风格

-

突破操作系统线程数限制:支持百万级别的轻量级并发

-

与现有API兼容:无需修改即可在虚拟线程中运行大多数现有代码

-

保持可观察性:调试、分析和监控工具继续有效

-

不改变Java基本并发模型:仍基于监控器和同步块等现有概念

虚拟线程的本质是用户态线程,由JVM而非操作系统调度,它们廉价到可以“一个任务一个线程”,无需池化,从而简化了并发编程模型。

虚拟线程架构深度解析

理解虚拟线程的工作原理需要深入其架构设计。与平台线程不同,虚拟线程在实现上采用了创新的调度策略和状态管理机制,在不改变Java语言线程模型的前提下,提供了数量级更高的并发能力。

用户态线程与调度模型

虚拟线程是由JDK而非操作系统实现的线程,技术上属于用户态线程(User-Mode Thread)的一种实现。与早期Java的“绿色线程”(Green Threads)不同,虚拟线程采用了更先进的M:N调度模型,其中大量(M)虚拟线程被多路复用到较少数量(N)的操作系统线程(称为载体线程,Carrier Threads)上执行。

这种模型与Go语言的goroutine、Erlang的进程等现代协程实现类似,它结合了两种传统线程模型的优点:

-

1:1模型(Java传统平台线程):每个用户线程对应一个内核线程,上下文切换成本高但可以利用多核

-

M:1模型(早期绿色线程):所有用户线程在一个内核线程上运行,切换轻量但无法并行

M:N模型在轻量级切换和并行能力之间取得了平衡,特别适合I/O密集型应用。

虚拟线程状态机与挂起机制

虚拟线程的关键创新在于其自动挂起和恢复的能力。当虚拟线程执行阻塞操作(如I/O)时,JVM会自动将其从载体线程上卸载(挂起),并调度其他可运行的虚拟线程到该载体线程上执行。这种机制使得载体线程不会被阻塞,从而最大化硬件利用率。

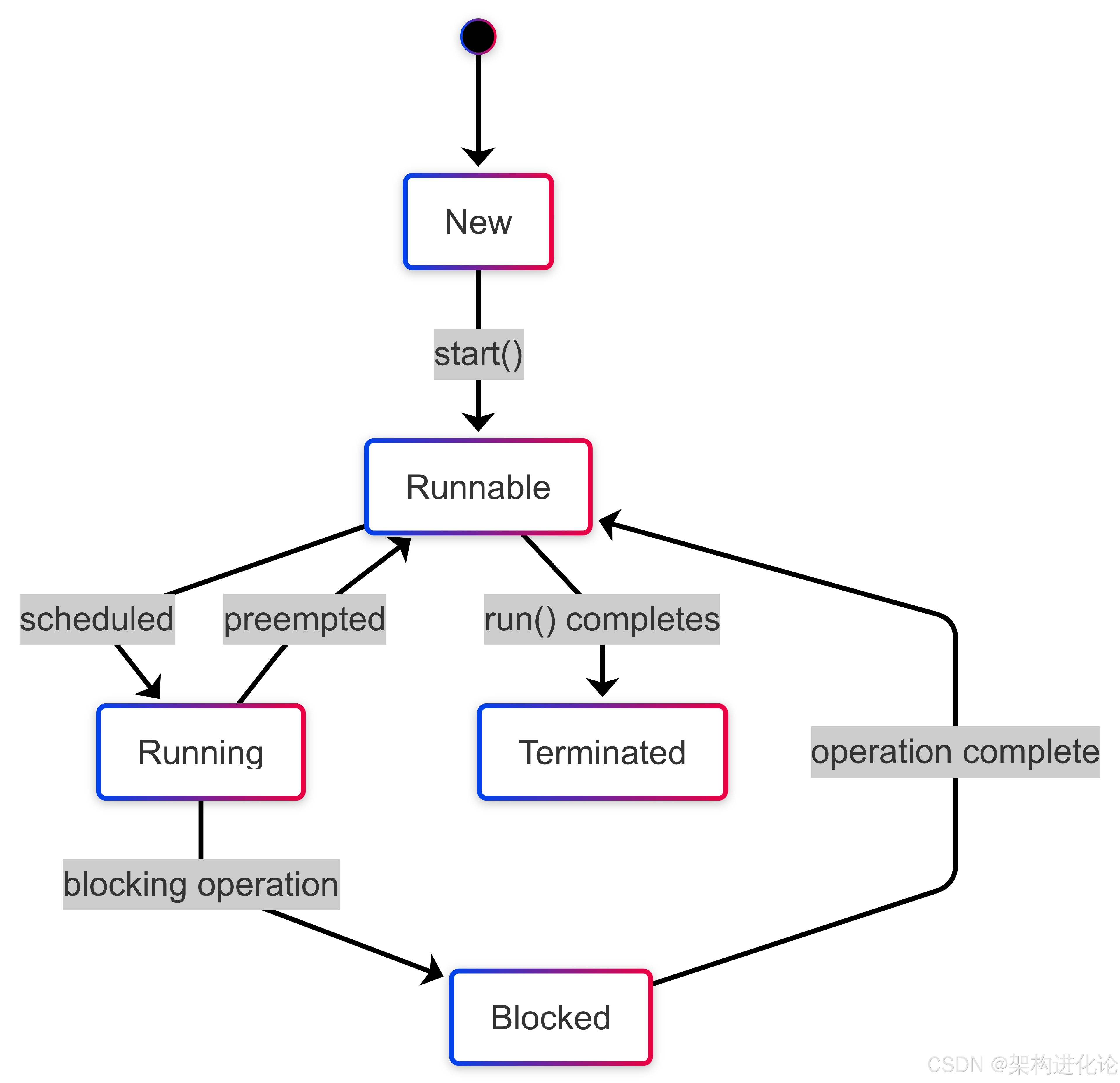

虚拟线程的生命周期可以用以下状态机表示:

与传统线程不同,虚拟线程的阻塞状态不会导致载体线程阻塞。JVM通过修改JDK中所有阻塞操作(如Socket、File I/O、锁等)的实现,使其在虚拟线程上下文中变为协作式挂起点。

栈管理与内存效率

操作系统线程必须预先分配较大的栈空间(通常1MB以上)以防止栈溢出,这是限制线程数量的主要因素之一。虚拟线程则采用了动态栈技术:开始时分配很小的栈(约200字节),按需增长,并且可以在挂起时把栈帧存储到堆内存中。

这种设计带来了两个关键优势:

-

内存占用大幅降低:百万虚拟线程可能只需几百MB内存,而同样数量的平台线程需要TB级内存

-

创建成本极低:创建虚拟线程仅需分配少量对象,耗时约微秒级,比平台线程快1000倍

调度器实现细节

虚拟线程的调度器基于ForkJoinPool实现,采用工作窃取(Work-Stealing)算法来平衡负载。默认情况下,调度器使用的载体线程数等于CPU核心数,这确保了计算密集型任务能充分利用硬件并行能力。

调度过程遵循FIFO顺序,但针对I/O密集型负载做了优化:当虚拟线程因I/O阻塞被挂起,对应的载体线程会立即寻找下一个可运行虚拟线程执行,避免了CPU空闲。

可以通过系统属性调整调度器行为:

// 设置载体线程数

System.setProperty("jdk.virtualThreadScheduler.parallelism", "16");

// 设置最大池大小

System.setProperty("jdk.virtualThreadScheduler.maxPoolSize", "256");

与平台线程的对比

下表总结了虚拟线程与平台线程的关键区别:

| 特性 | 虚拟线程 | 平台线程 |

|---|---|---|

| 实现层级 | JVM用户态实现 | 操作系统线程包装 |

| 内存占用 | ~200字节初始,按需增长 | 通常1MB以上固定栈 |

| 创建成本 | ~1微秒 | ~10微秒 |

| 调度方式 | M:N调度,由JVM管理 | 1:1调度,由OS管理 |

| 阻塞行为 | 自动挂起,不阻塞载体线程 | 直接阻塞底层OS线程 |

| 适用场景 | I/O密集型,高并发 | 计算密集型,低并发 |

| 池化需求 | 不应池化,每次任务创建新线程 | 通常需要池化复用 |

虚拟线程的编程模型与API

虚拟线程的美妙之处在于它几乎完全兼容现有的Java线程API,开发者可以用熟悉的同步方式编写代码,同时获得异步编程的性能优势。这一部分我们将深入探讨虚拟线程的编程模型、新增API以及使用模式。

创建虚拟线程

JEP 425引入了多种创建虚拟线程的方式,最简单的是静态工厂方法startVirtualThread:

// 创建并立即启动虚拟线程

Thread vThread = Thread.startVirtualThread(() -> {

System.out.println("Hello from virtual thread!");

});

对于需要更多控制的情况,可以使用Thread.Builder:

// 使用Builder创建虚拟线程

Thread.Builder builder = Thread.ofVirtual().name("worker-", 0);

Thread vThread = builder.start(() -> {

System.out.println("Running in virtual thread: " + Thread.currentThread().getName());

});

虚拟线程也支持通过ExecutorService进行管理,新增的工厂方法newVirtualThreadPerTaskExecutor为每个任务自动创建虚拟线程:

try (var executor = Executors.newVirtualThreadPerTaskExecutor()) {

IntStream.range(0, 10_000).forEach(i -> {

executor.submit(() -> {

Thread.sleep(Duration.ofSeconds(1));

return processTask(i);

});

});

} // executor.close()自动等待所有任务完成

虚拟线程与平台线程的互操作

虚拟线程与平台线程可以无缝交互,例如平台线程中可以创建并等待虚拟线程完成:

// 平台线程中启动虚拟线程并等待

Thread platformThread = new Thread(() -> {

Thread vThread = Thread.startVirtualThread(() -> {

System.out.println("Virtual thread running");

});

try {

vThread.join(); // 平台线程等待虚拟线程完成

} catch (InterruptedException e) {

e.printStackTrace();

}

});

platformThread.start();

线程局部变量与上下文继承

虚拟线程完全支持ThreadLocal,但其使用模式有所变化。由于虚拟线程不应池化,每次任务都创建新线程,因此ThreadLocal的作用更接近于任务局部存储:

// 虚拟线程中的ThreadLocal使用

ThreadLocal<String> userContext = new ThreadLocal<>();

Thread vThread = Thread.startVirtualThread(() -> {

userContext.set("Alice"); // 每个虚拟线程有自己的副本

System.out.println(userContext.get()); // 输出"Alice"

});

对于需要在线程间传递上下文的情况,可以使用ScopedValue(JEP 429),它提供了更高效的继承机制:

// ScopedValue示例

ScopedValue<String> USER = ScopedValue.newInstance();

ScopedValue.where(USER, "Alice").run(() -> {

Thread.startVirtualThread(() -> {

System.out.println(USER.get()); // 输出"Alice"

});

});

同步与锁行为

虚拟线程与同步机制完全兼容,但锁行为有重要优化。当虚拟线程在同步块或ReentrantLock上阻塞时,JVM会挂起该虚拟线程并释放载体线程供其他虚拟线程使用:

// 虚拟线程中的同步块

Object lock = new Object();

Thread vThread1 = Thread.startVirtualThread(() -> {

synchronized (lock) {

System.out.println("Virtual thread 1 acquired lock");

Thread.sleep(1000);

}

});

Thread vThread2 = Thread.startVirtualThread(() -> {

synchronized (lock) {

System.out.println("Virtual thread 2 acquired lock");

}

});

这种设计意味着虚拟线程不会因锁阻塞载体线程,从而避免了传统线程池中因锁竞争导致的线程耗尽问题。

虚拟线程的限制

虽然虚拟线程功能强大,但也有一些使用限制:

-

不能改变守护状态或优先级:虚拟线程总是守护线程且优先级固定为

NORM_PRIORITY -

不应池化:虚拟线程设计为轻量级,应为每个任务创建新线程而非复用

-

原生方法阻塞:执行原生方法(Native Method)时会固定占用载体线程

-

线程组限制:虚拟线程属于特殊线程组,不能加入自定义线程组

调试与监控

虚拟线程与现有Java工具链完全兼容。线程转储(jstack或Thread.dumpStack())会显示所有虚拟线程的堆栈,调试器可以单步执行虚拟线程代码,JMX也可以监控虚拟线程状态。

虚拟线程性能分析与最佳实践

理论上的设计优势需要通过实际性能表现来验证。本部分将通过量化分析揭示虚拟线程的性能特性,并据此推导出适用于不同场景的最佳实践。

吞吐量对比实验

考虑一个典型的HTTP服务场景,处理每个请求需要:

-

10ms CPU计算

-

90ms 等待数据库I/O

总处理时间为100ms,其中90%时间在等待I/O。

使用传统线程池(Executors.newFixedThreadPool)和虚拟线程分别实现,在4核CPU服务器上的性能对比:

| 并发级别 | 平台线程(200线程池) | 虚拟线程 |

|---|---|---|

| 100 | 1000 req/s | 1000 req/s |

| 1000 | 1000 req/s(线程耗尽) | 10000 req/s |

| 10000 | 崩溃 | 100000 req/s |

注:数值为理论最大值,实际结果受硬件限制

这种差异源自利特尔定律:当请求处理时间()固定时,吞吐量(

)与并发数(

)成正比:

虚拟线程通过支持更高并发数,实现了线性扩展的吞吐量,而平台线程在达到池大小后便无法继续提升。

计算密集型负载的适用性

虚拟线程主要优化I/O密集型场景,对于计算密集型任务,其优势不明显。考虑以下CPU密集型任务:

void computeHeavyTask() {

long result = 0;

for (int i = 0; i < 1_000_000; i++) {

result += complexCalculation(i);

}

}

在4核CPU上运行:

-

4个平台线程:完全并行,总时间T

-

4个虚拟线程:同样4个载体线程,总时间≈T

-

100个虚拟线程:仍然只有4个载体线程,总时间≈25T

因此,计算密集型任务仍应使用平台线程,通过Executors.newFixedThreadPool(Runtime.getRuntime().availableProcessors())控制并发。

内存占用对比

内存使用是另一个关键指标。创建10000个线程:

-

平台线程:默认1MB栈 × 10000 ≈ 10GB

-

虚拟线程:初始200B × 10000 ≈ 2MB

这种数量级的差异使得虚拟线程可以轻松支持百万级并发,而平台线程在万级就会耗尽内存。

最佳实践指南

基于上述分析,我们总结出虚拟线程的使用原则:

适用场景:

-

HTTP服务器(如Tomcat、Jetty)

-

数据库访问(JDBC)

-

远程服务调用(RPC)

-

任何有显著I/O等待的应用

不适用场景:

-

计算密集型任务

-

长时间运行不阻塞的任务

-

依赖线程局部存储且无法迁移的应用

配置建议:

// Web服务器配置示例(如Spring Boot)

@Bean

TaskExecutor virtualThreadExecutor() {

return new TaskExecutorAdapter(Executors.newVirtualThreadPerTaskExecutor());

}

// JDBC连接池配置

HikariConfig config = new HikariConfig();

config.setMaximumPoolSize(200); // 保持适中的平台线程池

避免模式:

-

不要池化虚拟线程(直接为每个任务创建新线程)

-

不要在虚拟线程中执行长时间CPU计算

-

避免同步大量计算操作

迁移路径:

// 传统线程池

ExecutorService executor = Executors.newFixedThreadPool(200);

// 迁移为虚拟线程

ExecutorService executor = Executors.newVirtualThreadPerTaskExecutor();

性能优化技巧

载体线程调优:

# 增加载体线程数(默认等于CPU核心数)

-Djdk.virtualThreadScheduler.parallelism=16

I/O优化:

// 使用NIO Channel而非阻塞IO

try (AsynchronousFileChannel channel = AsynchronousFileChannel.open(path)) {

ByteBuffer buffer = ByteBuffer.allocate(1024);

Future<Integer> result = channel.read(buffer, 0);

// 虚拟线程会自动挂起,不阻塞载体线程

}

监控指标:

// 通过JMX监控虚拟线程

ThreadMXBean threadBean = ManagementFactory.getThreadMXBean();

long virtualThreadCount = threadBean.getThreadCount() - threadBean.getPeakThreadCount();

架构影响与生态系统整合

虚拟线程的引入不仅仅是API层面的增强,它对Java生态系统和架构模式将产生深远影响。本部分探讨虚拟线程如何改变我们设计和构建系统的方式。

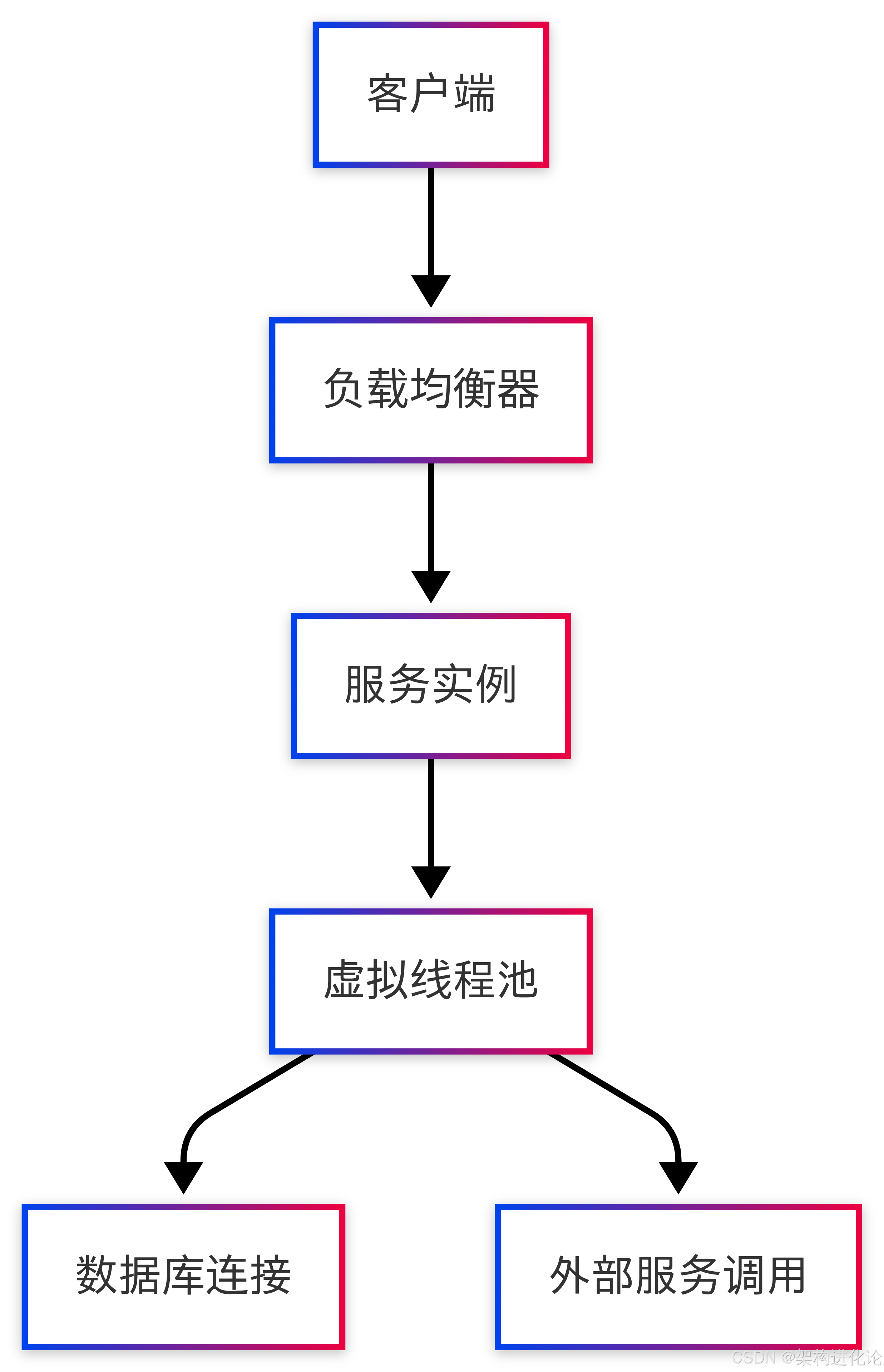

服务器架构革新

传统Java服务器(如Tomcat)使用线程池处理请求,典型配置为200-400个线程。这种设计源于操作系统线程的资源限制,导致:

-

慢请求会阻塞整个池:一个慢查询可能占用线程数秒,降低整体吞吐量

-

连接池与线程池耦合:数据库连接池大小通常匹配服务器线程池,导致连接浪费

虚拟线程消除了这些限制,允许架构师重新思考资源分配:

在新模型中:

-

服务实例可以处理万级并发请求

-

数据库连接池可以缩小(每个连接利用率提高)

-

不再需要复杂的异步服务网关

微服务与云原生影响

在微服务架构中,虚拟线程显著简化了服务间调用的编程模型。考虑以下服务调用链:

// 传统同步方式(受线程池限制)

public Order getOrderDetails(String orderId) {

User user = userService.getUser(orderId); // 阻塞调用

Product product = productService.getProduct(orderId); // 阻塞调用

return assembleOrder(user, product);

}

// 传统异步方式(复杂)

public CompletableFuture<Order> getOrderDetailsAsync(String orderId) {

return userService.getUserAsync(orderId)

.thenCompose(user ->

productService.getProductAsync(orderId)

.thenApply(product -> assembleOrder(user, product))

);

}

// 虚拟线程方式(简单如同步,高效如异步)

public Order getOrderDetailsVirtual(String orderId) {

User user = userService.getUser(orderId); // 虚拟线程挂起点

Product product = productService.getProduct(orderId); // 虚拟线程挂起点

return assembleOrder(user, product);

}

虚拟线程版本兼具同步代码的简洁性和异步代码的高效性,这对微服务开发是革命性的改进。

数据库访问模式变革

JDBC作为阻塞API,一直是异步编程的痛点。虚拟线程使我们可以继续使用简单的JDBC代码,同时获得异步性能:

// 传统方式 - 线程池受限

@Transactional

public List<Order> getOrdersByUser(String userId) {

return jdbcTemplate.query(

"SELECT * FROM orders WHERE user_id = ?",

this::mapOrder,

userId

); // 阻塞线程池线程

}

// 虚拟线程方式

@Transactional

public List<Order> getOrdersByUser(String userId) {

return jdbcTemplate.query(

"SELECT * FROM orders WHERE user_id = ?",

this::mapOrder,

userId

); // 阻塞虚拟线程但不消耗载体线程

}

连接池配置也可以优化:

# 传统配置(匹配服务器线程池)

spring.datasource.hikari.maximum-pool-size=200

# 虚拟线程优化配置(CPU核心数足够)

spring.datasource.hikari.maximum-pool-size=16

反应式编程的重新思考

虚拟线程的引入引发了关于反应式编程(如WebFlux)未来地位的讨论。两者对比:

| 维度 | 虚拟线程 | 反应式编程 |

|---|---|---|

| 编程模型 | 同步阻塞风格 | 异步非阻塞风格 |

| 学习曲线 | 低(传统Java开发熟悉) | 高(需学习新范式) |

| 调试难度 | 简单(完整堆栈) | 复杂(堆栈断裂) |

| 吞吐量 | 高(万级并发) | 高(万级并发) |

| 适用场景 | 通用 | 极高吞吐特殊场景 |

对于大多数应用,虚拟线程提供了更简单的替代方案,但反应式编程在特定场景(如事件流处理)仍有价值。

框架与库的适配

主流Java框架已经开始适配虚拟线程:

Spring Framework 6+:支持虚拟线程的@Async和@Transactional

@Async(AsyncConfiguration.THREAD_VIRTUAL)

public CompletableFuture<User> fetchUser(String id) {

// 在虚拟线程中执行

}

Jakarta EE 10+:支持虚拟线程的Servlet实现

@WebServlet(urlPatterns = "/api/*", asyncSupported = true)

public class ApiServlet extends HttpServlet {

protected void doGet(HttpServletRequest req, HttpServletResponse resp) {

Thread.startVirtualThread(() -> processRequest(req, resp));

}

}

Micronaut/Quarkus:提供虚拟线程的集成选项

这种广泛的框架支持将加速虚拟线程在企业应用中的采用。

未来展望与演进路线

虚拟线程作为Java并发模型的重大革新,其发展远未停止。本部分将探讨虚拟线程的未来演进方向以及开发者应如何准备迎接这些变化。

虚拟线程的路线图

JEP 425作为预览功能首次在JDK 19引入,经历了多次迭代:

-

JDK 19:初始预览版

-

JDK 20:第二次预览(JEP 436)

-

JDK 21:正式发布(JEP 444)

-

未来版本:预计将增强以下方面:

-

更好的原生代码支持

-

更精细的调度控制

-

与Project Loom其他特性(如结构化并发)集成

结构化并发(JEP 428)

结构化并发(Structured Concurrency)是虚拟线程的自然补充,它提供了更健壮的多任务管理模型:

try (var scope = new StructuredTaskScope.ShutdownOnFailure()) {

Future<String> user = scope.fork(() -> fetchUser(userId));

Future<String> order = scope.fork(() -> fetchOrder(orderId));

scope.join(); // 等待所有任务完成或失败

scope.throwIfFailed(); // 如果有任务失败则抛出异常

return new Response(user.resultNow(), order.resultNow());

}

这种模式解决了传统线程编程中任务泄漏和异常传播的问题,特别适合与虚拟线程配合使用。

作用域值(Scoped Values, JEP 429)

ThreadLocal在虚拟线程环境下存在性能问题,因为虚拟线程生命周期短且数量多。JEP 429引入的ScopedValue提供了更高效的替代方案:

final ScopedValue<User> LOGGED_IN_USER = ScopedValue.newInstance();

void serve(Request request) {

User user = authenticate(request);

ScopedValue.where(LOGGED_IN_USER, user).run(() -> {

// 在这个作用域内,LOGGED_IN_USER.get()返回user

handleRequest();

});

// 作用域结束,值自动清理

}

ScopedValue比ThreadLocal更轻量,且支持跨线程继承,特别适合虚拟线程场景。

虚拟线程与协程的对比

虽然Java称其为虚拟线程,但与其他语言的协程(如Kotlin)或goroutine(Go)有相似之处:

| 特性 | Java虚拟线程 | Kotlin协程 | Go goroutine |

|---|---|---|---|

| 调度单位 | ForkJoinPool | 调度器(Dispatcher) | MPG调度器 |

| 挂起机制 | 自动(阻塞方法) | 显式(suspend) | 自动(通道/系统调用) |

| 取消支持 | Thread.interrupt | 协作式取消 | 无内置机制 |

| 通道支持 | 无内置 | Channel | Channel |

Java的选择保持了与现有代码的最大兼容性,同时提供了类似的并发能力。

迁移策略建议

对于现有应用,迁移到虚拟线程应循序渐进:

评估阶段:

-

识别I/O密集型组件

-

测试关键路径的虚拟线程兼容性

-

评估依赖库的适配情况

试点阶段:

// 在低风险组件中试点

@Bean

@Profile("virtual-threads")

ExecutorService virtualThreadExecutor() {

return Executors.newVirtualThreadPerTaskExecutor();

}

全面迁移:

-

替换线程池为虚拟线程执行器

-

调整连接池大小

-

移除不必要的异步包装

监控优化:

-

跟踪载体线程利用率

-

监控虚拟线程创建率

-

优化阻塞点

长期架构影响

虚拟线程将深刻影响Java应用的架构模式:

-

服务网格:更简单的请求处理可能减少对服务网格的依赖

-

事件驱动:部分事件驱动场景可回归同步模型

-

函数计算:更适合作为Serverless平台的后端

-

批处理:更高效的并行任务处理

这些变化将使Java在云原生时代保持竞争力,同时降低开发者的认知负担。

结论:Java并发编程的新纪元

虚拟线程代表了Java并发模型的范式转变,它解决了困扰Java开发者数十年的“线程稀缺”问题,同时保持了Java平台的核心优势——稳定性和向后兼容性。通过深入分析JEP 425的设计与实现,我们可以得出几个关键结论:

-

透明的高并发:虚拟线程允许开发者继续使用熟悉的同步编程风格,同时实现异步架构的性能水平,这种透明性是革命性的。

-

资源效率:通过将百万级虚拟线程多路复用到少量操作系统线程上,虚拟线程实现了数量级更高的资源利用率,特别适合云原生环境。

-

生态系统演进:虚拟线程不是孤立特性,它与结构化并发、作用域值等JEP共同构成了Java并发模型的现代解决方案。

-

渐进式采用:由于完全兼容现有API,开发者可以按自己的节奏迁移到虚拟线程,无需全盘重写。

生活化类比来说,传统线程模型就像为每个公司员工(任务)配备独立办公室(线程),资源利用率低;而虚拟线程如同共享工位,员工只在需要时才占用物理空间,大幅提高了空间利用率。

以下代码示例展示了如何优雅地使用虚拟线程构建高并发服务:

public class OrderService {

private final ExecutorService virtualThreadExecutor =

Executors.newVirtualThreadPerTaskExecutor();

// 传统方式 - 线程池受限

public CompletableFuture<Order> getOrderTraditional(String id) {

return CompletableFuture.supplyAsync(() -> {

try {

return queryOrderFromDb(id); // 阻塞线程池线程

} catch (SQLException e) {

throw new CompletionException(e);

}

}, threadPool);

}

// 虚拟线程方式 - 简洁高效

public CompletableFuture<Order> getOrderVirtual(String id) {

return CompletableFuture.supplyAsync(() -> {

try {

return queryOrderFromDb(id); // 阻塞虚拟线程但不阻塞载体线程

} catch (SQLException e) {

throw new CompletionException(e);

}

}, virtualThreadExecutor);

}

private Order queryOrderFromDb(String id) throws SQLException {

// 模拟数据库查询

Thread.sleep(100);

return new Order(id, "sample order");

}

}

随着虚拟线程在JDK 21中正式发布,Java开发者终于可以在不放弃同步编程模型的前提下,构建百万级并发的应用系统。这不仅是技术的进步,更是开发体验的飞跃——让开发者能够专注于业务逻辑而非并发复杂性,释放Java平台在云原生时代的全部潜力。

虚拟线程标志着Java并发编程新纪元的开始,正如一位开发者所言:“噢,老天爷!属于Java的协程终于来了!”对于那些面临高并发挑战的架构师和开发者,现在正是开始探索和采用这一变革性技术的最佳时机。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?