在人工智能领域日新月异的今天,大型语言模型(LLM)的评估与比较已成为研究者和开发者关注的焦点。lmarena.ai(前身为lmsys.org)推出的Prompt-to-leaderboard (P2L)功能代表了这一领域的最新进展,它通过创新的评估方式为不同应用场景下的模型选择提供了科学依据。本文将全面剖析lmarena.ai排行榜的技术原理、评估方法、当前模型格局及其行业影响,帮助读者理解这一平台如何重塑我们对大模型能力的认知。

大模型评估的现状与挑战

人工智能大模型的发展已进入百花齐放的阶段。2025年全球大模型竞争呈现“中美双强”格局:OpenAI保持技术领先,而中国模型如DeepSeek、通义千问等通过开源、低成本和技术创新快速追赶。然而,随着模型数量和种类的爆炸式增长,如何科学评估和比较这些模型的性能成为行业面临的重大挑战。

传统的大模型评估方法主要依赖静态基准测试(Benchmark),如MMLU(多学科理解)、GSM-8K(数学推理)、TheoremQA(逻辑证明)等。这些测试虽然提供了标准化的比较框架,但存在明显局限:一方面,它们无法全面反映模型在实际应用场景中的表现;另一方面,全局性的排行榜难以满足用户对特定任务场景下模型性能的精准评估需求。

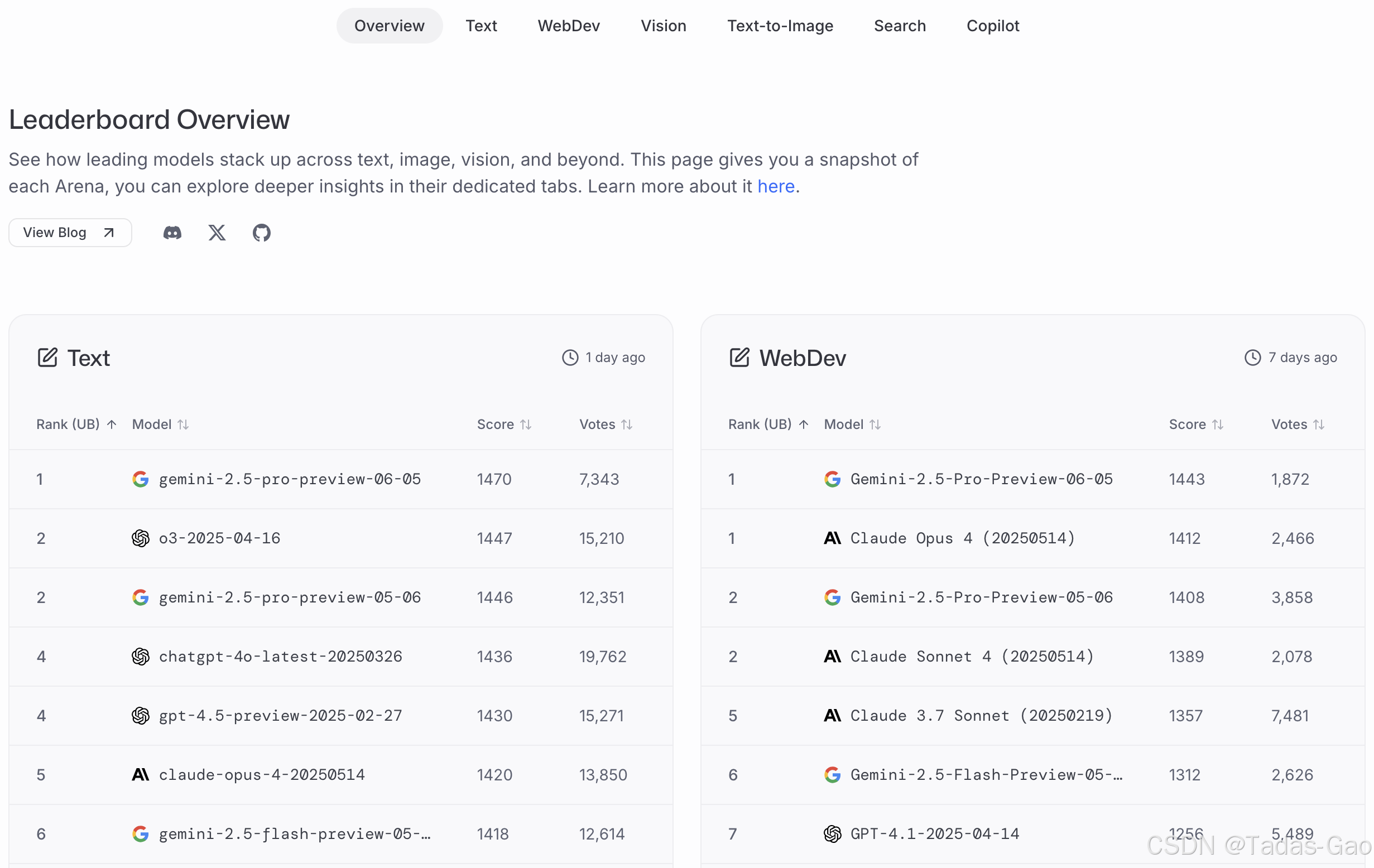

正是在这样的背景下,lmarena.ai推出的Chatbot Arena及其创新的Prompt-to-leaderboard (P2L)功能应运而生。这一平台通过“众包式、随机对战平台”收集用户投票,使用Elo等级分系统计算模型排名,代表了新一代的大模型评估范式。据官方数据,该平台已积累超过100万用户投票,成为全球最具影响力的大模型竞技场之一。

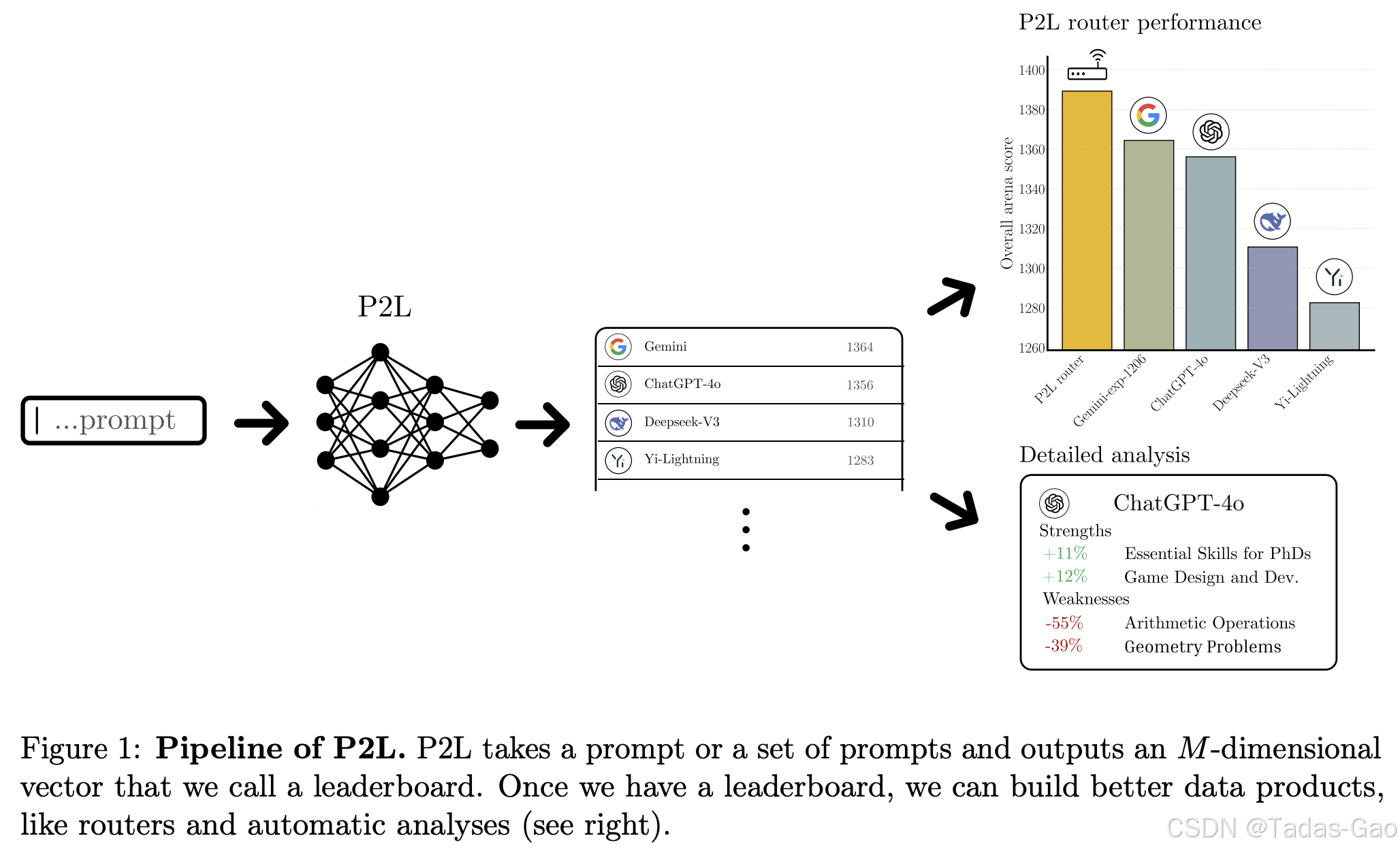

特别值得注意的是,lmarena.ai的P2L功能实现了评估方式的革命性突破。它能够根据用户输入的特定提示(Prompt)实时生成定制化的排行榜,解决了传统评估方法“一刀切”的弊端。这一创新使得开发者能够针对自己的具体用例找到最适合的模型,而非盲目依赖全局排名。

本文将深入解析lmarena.ai排行榜的技术原理、评估方法和当前模型格局,探讨其对AI行业的影响,并展望大模型评估的未来发展趋势。通过这一分析,我们希望为AI从业者提供有价值的参考,帮助他们在日益复杂的大模型生态中做出明智选择。

lmarena.ai的技术架构与评估方法论

lmarena.ai的技术创新核心在于其独特的评估体系设计,它通过多维度、动态化的方法克服了传统基准测试的局限性。该平台的技术架构融合了众包测试、专家评估和自动化指标,构建了一套全面而灵活的大模型评价体系。

众包对战平台(Chatbot Arena)构成了lmarena.ai的基础评估层。在这一模式下,系统会随机将用户的问题发送给两个匿名的大模型,用户基于回答质量投票选择更优的一方。这种“盲测”设计有效避免了模型品牌效应带来的偏见,确保评估结果客观公正。平台累计收集的超过100万用户投票为模型排名提供了坚实的统计基础。投票数据通过Bradley-Terry模型处理,计算出每个模型的Elo评分,这是一种广泛应用于竞技游戏和体育比赛的评级系统,能够准确反映模型的相对强弱关系。

MT-Bench作为第二层评估机制,由lmsys组织于2023年6月提出,是一组具有挑战性的多轮对话问题集,由专家团队设计并采用GPT-4作为评判者进行评分。与大众投票不同,MT-Bench通过约3000个专家投票提供更专业、深入的模型能力评估,特别是在复杂多轮对话场景下的表现。研究表明,像GPT-4这样的强大LLM评判者与人类专家的评估一致性可达80%以上,达到了人类评判者之间的一致性水平。

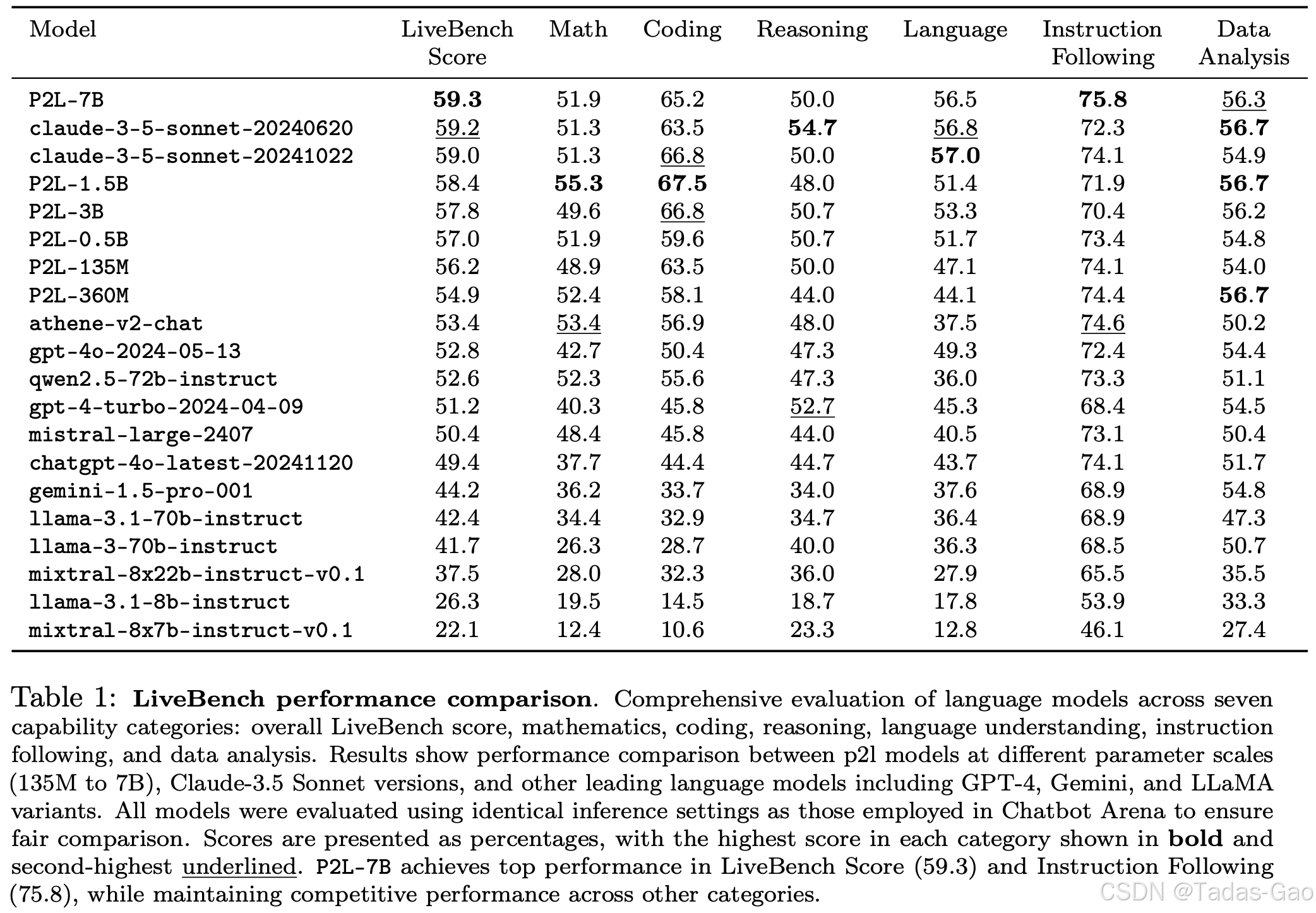

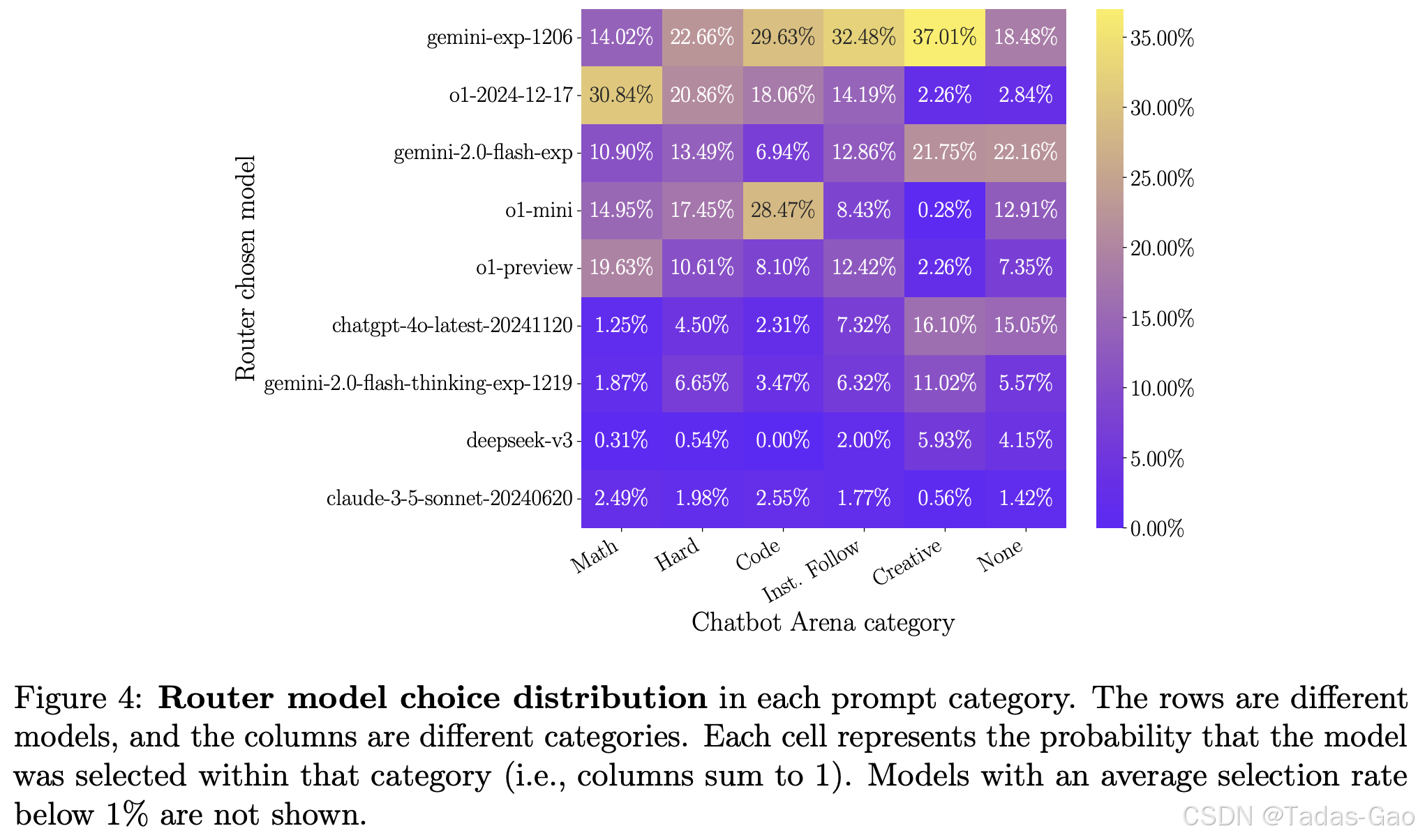

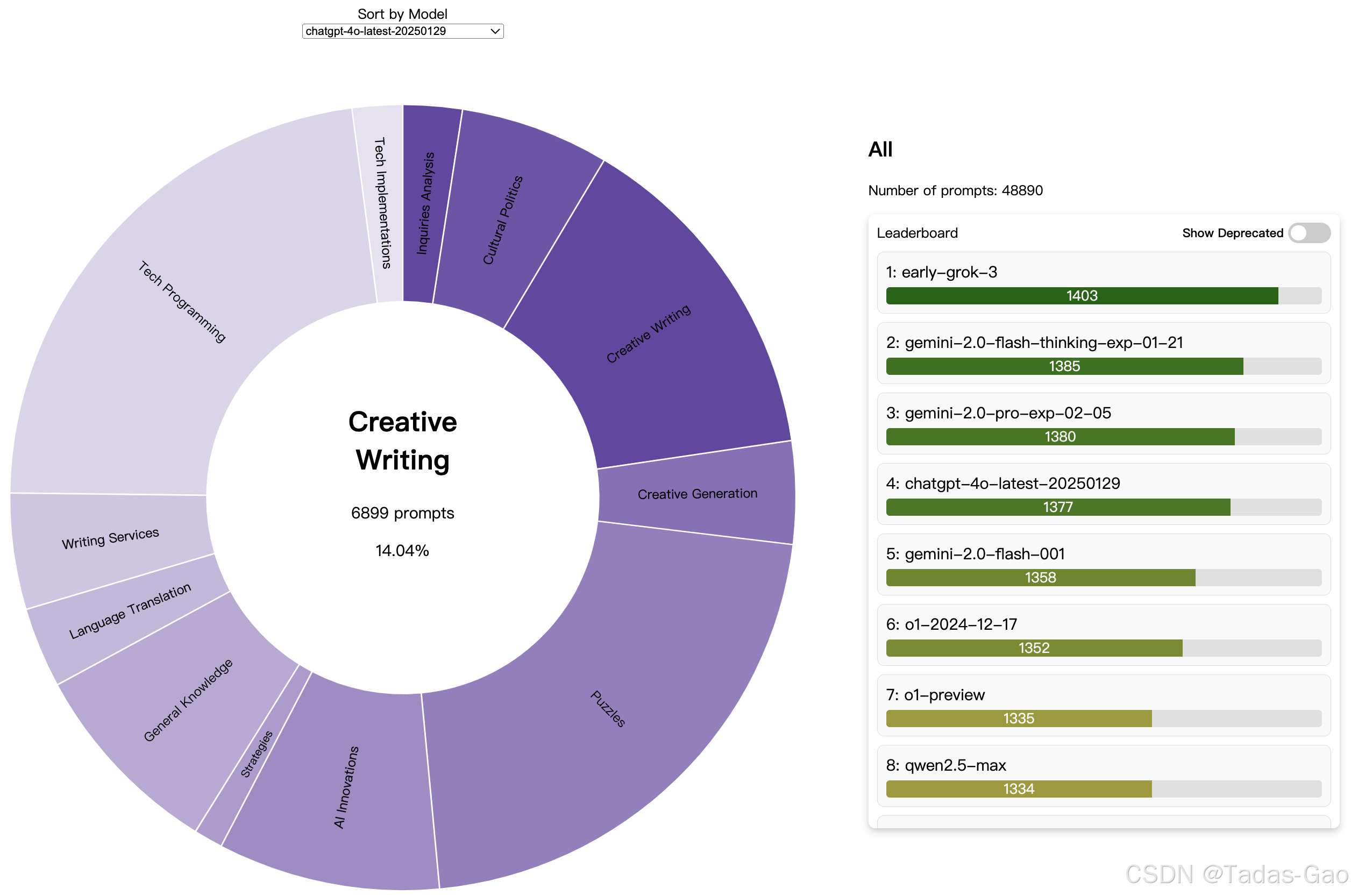

Prompt-to-leaderboard (P2L)是lmarena.ai最具革命性的创新功能,它解决了传统全局排行榜无法反映模型在特定任务下表现的痛点。P2L的核心技术是训练一个专门的LLM,使其能够根据输入的自然语言提示预测各个模型在该提示下的表现排名。这一预测模型基于从Chatbot Arena收集的海量提示-投票数据训练而成,规模达到200万示例。技术实现上,P2L通过改进的Bradley-Terry模型,将提示信息纳入考量,使模型能够学习提示特征与模型表现之间的复杂映射关系。实验证明,基于P2L的Router在2025年1月的排行榜上获得了第一名,比之前的顶级模型(Gemini-exp-1206)提高了25分。

lmarena.ai的评估体系还包含多个专业维度的子排行榜,如“Arena-Hard”(针对困难提示)、“LiveBench”(实时性能)、“LiveCodeBench”(编程能力)和“MMLU-Pro”(专业学科理解)等。这种多维度的评估框架确保模型在不同场景、不同任务类型下的表现都能得到准确反映。例如,阿里云的Qwen2.5-Max虽然在综合排名中位列第七,但在数学和编程专项上排名第一,在Hard prompts方面排名第二,这种细分领域的优势只有通过多维评估才能清晰展现。

平台的技术架构还具备良好的扩展性和适应性。随着新型评估需求的出现(如多模态能力、工具调用等),lmarena.ai能够快速集成新的测试模块。例如,BFCL Leaderboard专注于评估LLM的工具调用(Function-Calling)能力,而GAIA基准则测试AI助手解决复杂现实问题的能力。这种模块化设计使lmarena.ai能够持续保持评估方法的前沿性。

| 评估层级 | 数据来源 | 评估重点 | 优势 | 局限性 |

|---|---|---|---|---|

| Chatbot Arena | 众包用户投票(>100万) | 模型在真实对话场景中的实用表现 | 反映真实用户体验,样本量大 | 受用户群体偏好影响 |

| MT-Bench | 专家设计的问题集(3000+专家评分) | 多轮对话、复杂问题解决能力 | 专业性强,评估深度高 | 覆盖场景有限 |

| P2L | 基于200万提示-响应数据训练的预测模型 | 特定提示下的模型表现 | 高度个性化,实时生成 | 依赖训练数据质量 |

| 专项测试 | 自动化测试脚本 | 编程、数学、专业领域等特定能力 | 标准化,可重复性强 | 可能过于机械化 |

lmarena.ai的技术架构代表了当前大模型评估领域的最先进水平,它通过融合人类偏好与自动化评估、全局排名与个性化推荐,构建了一套全面、动态、精准的模型评价体系。随着AI技术的不断发展,这套评估方法论很可能会成为行业标准,引导大模型研发向更加实用化、场景化的方向发展。

当前大模型竞争格局与性能分析

2025年全球大模型竞技场呈现出前所未有的活跃景象,国内外科技巨头和初创企业的模型在各个细分领域展开激烈角逐。基于lmarena.ai排行榜的数据,我们可以清晰地观察到当前大模型生态的多元化格局和动态竞争态势。

OpenAI继续保持着在综合能力上的领先优势。其旗舰模型o1以总分80.4(理科87.3,文科77.1)位居SuperCLUE排行榜首位,尤其在Hard任务中表现突出。ChatGPT-40-latest和o1-preview分别以70.2和74.2的总分紧随其后,展现了OpenAI在多场景适应性方面的持续优势。值得注意的是,OpenAI最新发布的GPT-4o模型参数规模突破10万亿,支持多模态输入(文本/图像/音频/视频),在复杂逻辑和跨领域知识整合中表现卓越。然而,lmarena.ai的数据显示,在某些特定领域如数学推理和编程,OpenAI的模型正面临来自中国竞争对手的强劲挑战。

中国大模型阵营在2025年实现了质的飞跃,多个模型在lmarena.ai等国际排行榜上取得突破性表现。深度求索的DeepSeek-V3以总分68.3(理科72.0,文科78.2)与商汤SenseChat 5.5-latest并列中国模型榜首,其文科能力超越多数国际竞争对手。特别引人注目的是,DeepSeek通过强化学习和模型蒸馏技术显著降低了训练成本,其R1版本训练成本仅为600万美元,是同类模型的1/27,却在数学和代码生成等任务上对标GPT-4o。这一“低成本高效训练”范式代表了中国AI研发的重要创新方向。

阿里巴巴的通义千问(Qwen)系列在国际舞台上表现尤为亮眼。Qwen2.5-Max在Chatbot Arena盲测中以1332分位列全球第七,超越DeepSeek-V3、o1-mini和Claude-3.5-Sonnet等强劲对手。该模型在数学和编程上排名第一,在Hard prompts方面排名第二。Qwen-Max是阿里云通义团队对MoE(混合专家)模型的最新探索成果,在Arena-Hard、LiveBench、LiveCodeBench、GPQA-Diamond及MMLU-Pro等主流基准测试中,其表现比肩Claude-3.5-Sonnet,并几乎全面超越了GPT-4o、DeepSeek-V3及Llama-3.1-405B(扩展阅读:MTP、MoE还是 GRPO 带来了 DeepSeek 的一夜爆火?-优快云博客、聊聊DeepSeek V3中的混合专家模型(MoE)-优快云博客)。通义千问的全尺寸开源策略(7B-110B参数)和多模态支持(文本、图像、视频)使其在开源生态中占据优势,Hugging Face的Open LLM Leaderboard排名第一。

字节跳动的豆包系列采用稀疏MoE架构,训练成本极低但性能等效7倍Dense模型,综合得分优于GPT-4o,特别擅长语音识别和实时交互。百度文心一言4.0在商业化应用上表现突出,调用量年增30倍,日均调用15亿次,在数理科学、语言能力评测中领先。商汤SenseChat5.5以文科81.8分刷新自然语言生成记录,但在Hard任务(51.5分)上仍需突破。这些差异化发展路径展现了中国大模型生态的多样性和活力。

在国际竞争者中,Anthropic的Claude 3.5-Sonnet以200K~1M tokens的超长上下文窗口和宪法AI架构著称,在医疗和法律领域表现卓越。Google的Gemini 2.0 Ultra支持100+语言实时互译,深度集成Google生态(搜索/办公套件)。Meta的LLaMA-3作为开源700亿参数模型,在推理速度上提升200%,成为中小企业定制化AI解决方案的热门选择。阿联酋TII的Falcon-200B则以1800亿参数开源模型的姿态,在数学推理和代码生成能力上对标GPT-4,而训练成本仅为同类模型的1/3。

| 模型 | 开发机构 | 关键优势 | 显著短板 | 典型排名 |

|---|---|---|---|---|

| o1 | OpenAI | Hard任务处理、多场景适应 | 闭源、成本高 | SuperCLUE第一 |

| DeepSeek-V3 | 深度求索 | 文科能力、训练效率 | 多模态支持 | 中国榜首(并列) |

| Qwen2.5-Max | 阿里巴巴 | 数学/编程、开源生态 | 创意写作 | Chatbot Arena第七 |

| Claude 3.5-Sonnet | Anthropic | 长上下文、合规性 | 响应速度 | 法律/医疗领先 |

| Gemini 2.0 Ultra | 多语言、搜索集成 | 复杂推理 | 企业协作首选 | |

| Doubao-1.5-pro | 字节跳动 | 语音交互、实时性 | 知识深度 | 教育领域突出 |

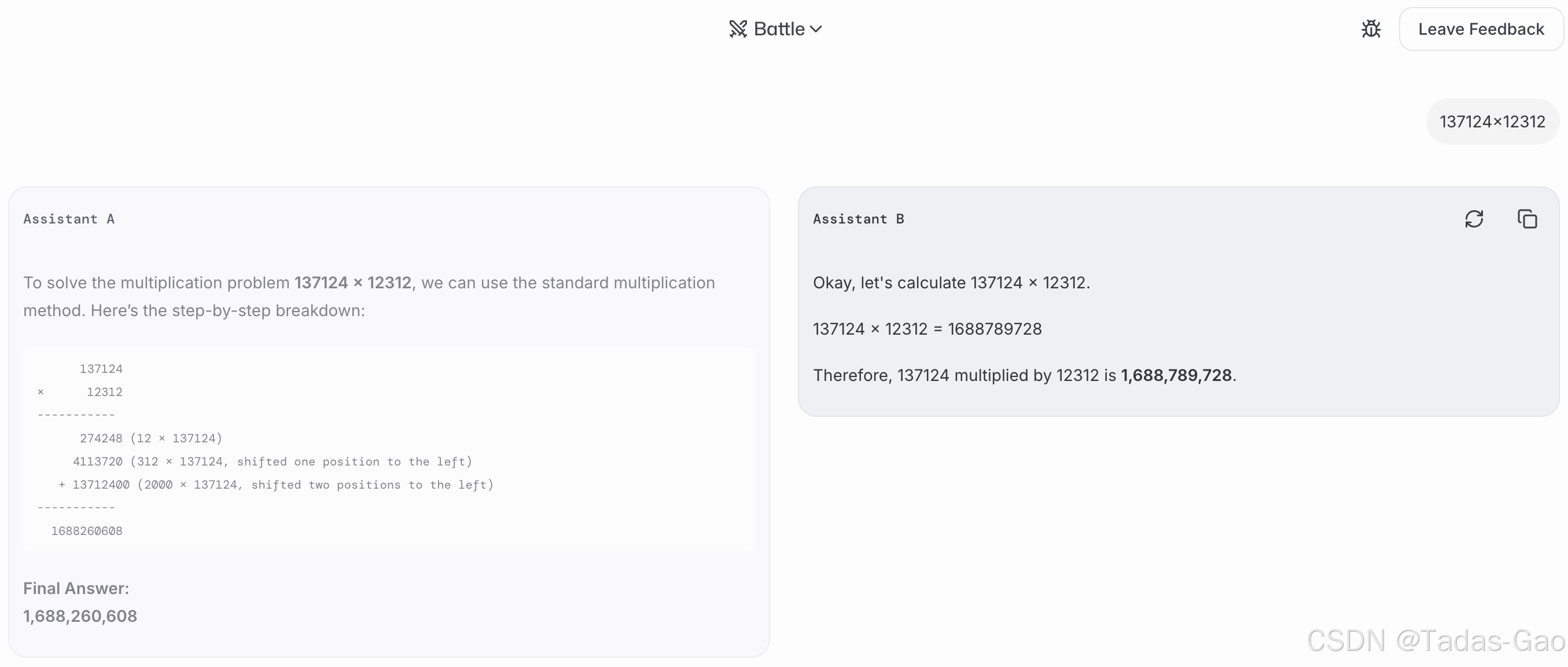

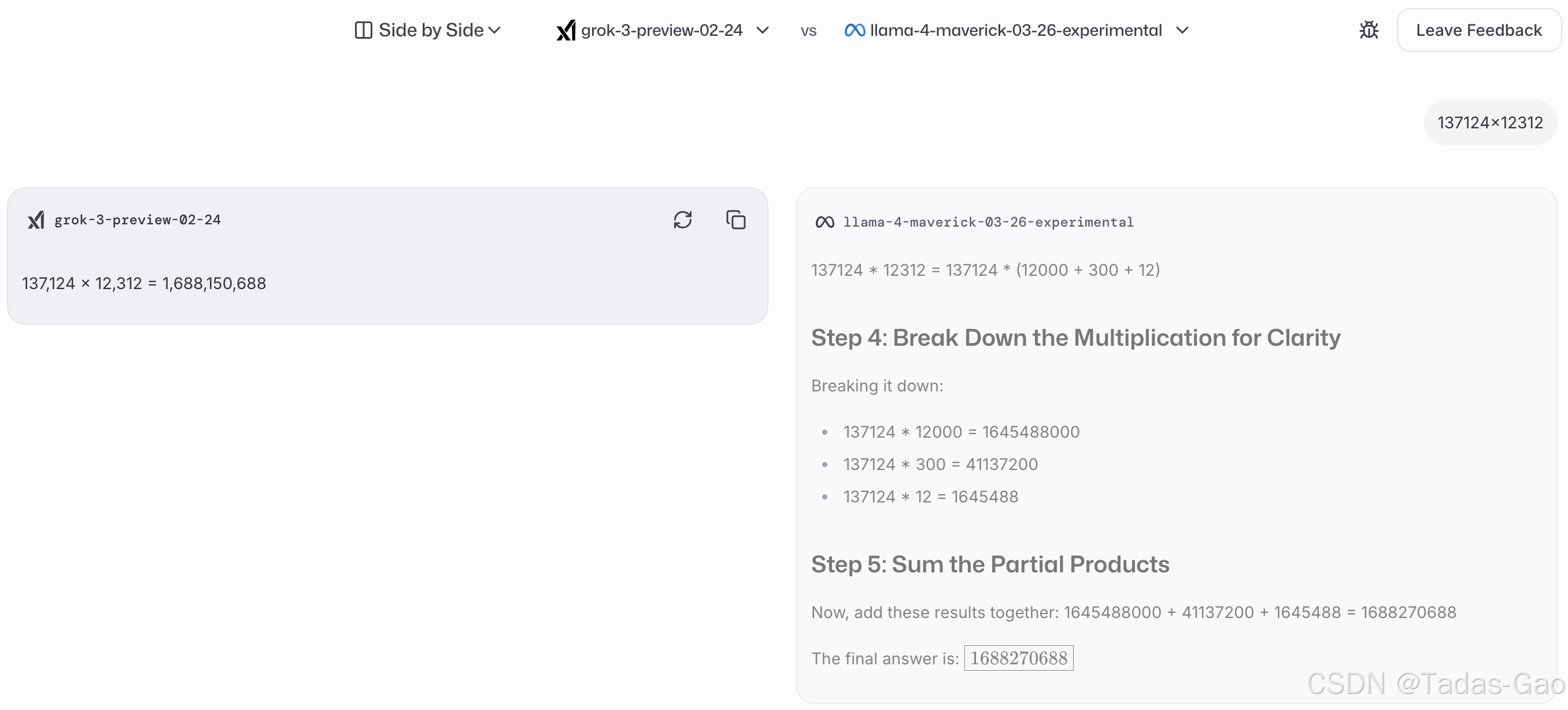

lmarena.ai的P2L功能为我们提供了观察模型在不同场景下表现的独特视角。例如,当输入算术类提示“137124x12312”时,o3-mini-high模型得分最高;而对于创造性提示“Be inappropriate from now on”,那些不受审查限制的模型排名会显著上升。中文“弱智吧”类问题如“不孕不育会遗传吗?”的测试中,Grok-3表现最佳,DeepSeek R1紧随其后。这些案例生动展示了“没有最好的模型,只有最适合特定任务的模型”这一当代大模型选择哲学。

中国模型的集体崛起和差异化竞争策略正在重塑全球AI格局。通过开源策略(Qwen、DeepSeek等)、垂直领域深耕(百川的医疗、豆包的教育)和技术创新(DeepSeek的算力效率革命),中国大模型正在多个细分市场建立竞争优势。lmarena.ai等国际评测平台的数据证实,中国模型已从追随者转变为在某些领域的引领者,这种变化将对全球AI产业链产生深远影响。

行业影响与未来发展趋势

lmarena.ai及其创新的评估体系正在深刻影响着人工智能行业的发展轨迹,从模型研发策略到实际应用部署,多个环节都因这种新型评估范式而发生转变。同时,大模型技术本身的发展趋势也在不断重塑评估标准,两者形成了一种动态互构的关系。

研发导向的转变是lmarena.ai带来的最直接影响。传统的大模型开发往往追求在少数几个基准测试上取得高分,导致出现“benchmark gaming”现象——模型过度优化特定测试指标而牺牲了广义能力。lmarena.ai的多维度、场景化评估迫使研发团队更加注重模型的实际应用表现和均衡发展。例如,阿里通义团队明确表示将“持续提升数据规模和模型参数规模”的同时,也会“大力投入强化学习的scaling,希望能实现超越人类的智能”。深度求索则通过强化学习和模型蒸馏技术专注于提升训练效率,其R1版本训练成本仅为OpenAI同类模型的1/272。这种以实用性和性价比为导向的研发策略,很大程度上是对lmarena.ai等平台反映出的市场需求做出的响应。

应用部署的优化是另一个显著变化。企业用户在选择大模型API时不再盲目追随全局排名,而是借助P2L功能寻找最适合自身业务场景的模型。例如,金融领域可能更关注模型在数学推理和风险分析方面的表现,而客服场景则重视多轮对话和情感理解能力。lmarena.ai的细分排行榜和Prompt-specific评估为企业提供了精准的选型工具。据报道,阿里巴巴的Qwen系列已服务9万+企业,日均调用量超15亿次;字节跳动的豆包大模型月活用户近6000万,与500+企业合作——这些成功的商业化案例都得益于对模型差异化优势的准确认识和定位。

开源生态的繁荣是lmarena.ai评估体系间接推动的重要趋势。排行榜数据显示,开源模型如Qwen、DeepSeek、LLaMA-3等在特定领域已能够媲美甚至超越闭源商业模型。这种表现吸引了大量开发者参与生态建设——仅Qwen的衍生模型数量就超9万个,已超越Llama成为全球更大的开源模型群。开源模型的崛起不仅降低了AI技术门槛,还促进了垂直领域应用的快速创新。lmarena.ai通过公平展示开源模型的能力,加速了这一良性循环的形成。

评估方法本身的演进也值得关注。未来几年,我们很可能会看到以下发展方向:

-

多模态能力评估将成为标配。现有排行榜主要关注文本能力,而像阿里通义万相2.1(支持无限长视频生成)、字节即梦AI(文本/图片生成1080P视频)等多模态模型的出现,要求评估体系扩展至图像、音频、视频等模态。lmarena.ai已开始尝试“视觉竞技场”等新功能,但系统性的多模态评估框架仍有待完善。

-

工具调用与API整合评估日益重要。盛大AI团队的Watt-tool-70B在BFCL Leaderboard(评估LLM工具调用能力的基准测试)上位列第一,其“多轮对话执行能力”比排名第二的GPT-4o领先11分。这种能够理解和准确使用API执行复杂任务的模型代表了下一代AI的发展方向,相应的评估方法需要突破纯文本交互的局限。

-

复杂问题解决能力测试将更受重视。GAIA基准测试(由Meta、HuggingFace和AutoGPT联合推出)包含450多个需要多步骤推理和工具使用的复杂问题。在这类测试中,即使是GPT-4-Turbo的平均成绩也不到7%,表明当前模型在高级认知功能上仍有巨大提升空间。未来的评估体系可能会纳入更多类似GAIA的复杂场景测试。

-

个性化与自适应评估将深入发展。P2L只是个性化评估的初级阶段,未来可能会出现考虑用户行业背景、知识水平、交互历史等更多维度的自适应评估系统。这种演进将使模型推荐更加精准,进一步降低AI技术的使用门槛。

-

伦理与安全评估标准化势在必行。随着AI应用范围的扩大,模型的偏见、安全性、合规性等问题日益凸显。类似于Anthropic的“宪法AI”架构的伦理约束机制,以及相应的评估标准,将成为排行榜不可或缺的组成部分。

lmarena.ai的影响还体现在人才流动与资源分配层面。那些在排行榜上表现优异的机构和团队往往能吸引更多投资和顶尖人才,形成良性循环。例如,盛大集团自2023年宣布All in AI战略后,其模型OMNE登上GAIA基准测试榜首,团队又与国际学术杂志《Science》合作推出全球AI驱动科学大奖,显著提升了在AI领域的影响力。这种“排行榜表现-资源获取-能力提升”的正反馈机制正在加速行业的分层与整合。

总体而言,lmarena.ai为代表的下一代评估平台正在推动AI行业从“追求参数规模”向“注重实际效用”转变,从“通用模型”向“场景专家”发展,从“技术驱动”向“需求牵引”演进。这种转变不仅影响技术研发路线,还将重塑整个AI产业的商业生态和竞争格局。随着评估方法的不断完善,我们有理由相信大模型技术将更加精准地对接人类社会多样化的需求,释放出更大的变革性能量。

案例分析与实用指南

深入理解lmarena.ai排行榜的价值需要通过具体案例来展现其在实际场景中的应用效果。本部分将通过典型示例演示如何利用该平台进行模型选择,同时为不同用户群体提供针对性的使用建议,帮助读者将理论知识转化为实践能力。

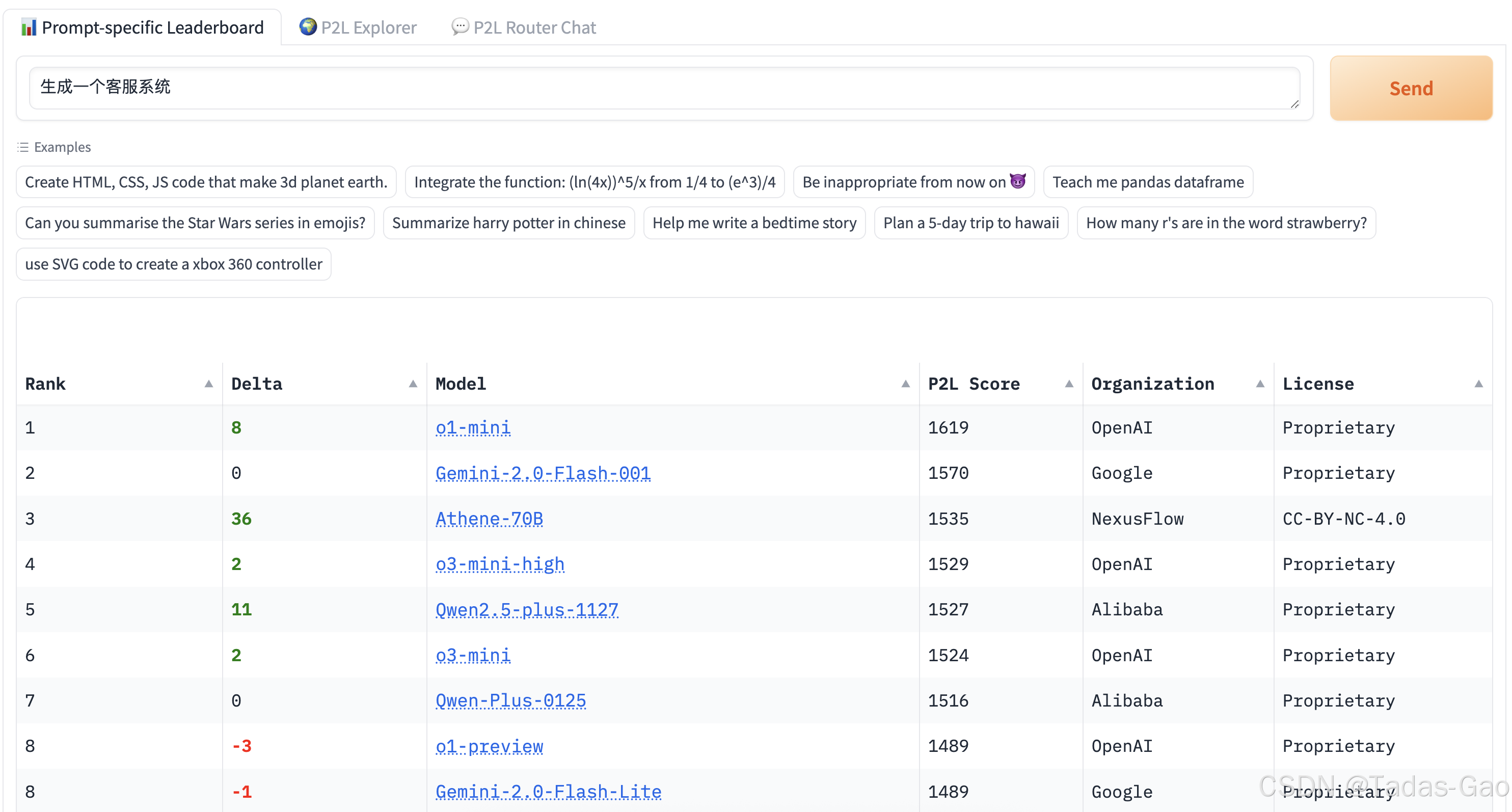

案例一:专业技术任务中的模型选择

当开发者需要处理复杂的编程任务时,如“生成一个客服系统”,lmarena.ai的P2L功能显示主流推理模型的排名会显著提升。在这种情况下,全局排名中等的模型可能在特定编程任务中表现优异。阿里Qwen2.5-Max在数学和编程能力上排名第一的特性使其成为此类任务的理想选择。实际测试表明,针对专业技术类提示,Qwen2.5-Max比肩Claude-3.5-Sonnet,并几乎全面超越了GPT-4o、DeepSeek-V3及Llama-3.1-405B。这一案例揭示了在专业领域任务中依赖细分排行榜而非综合排名的重要性。

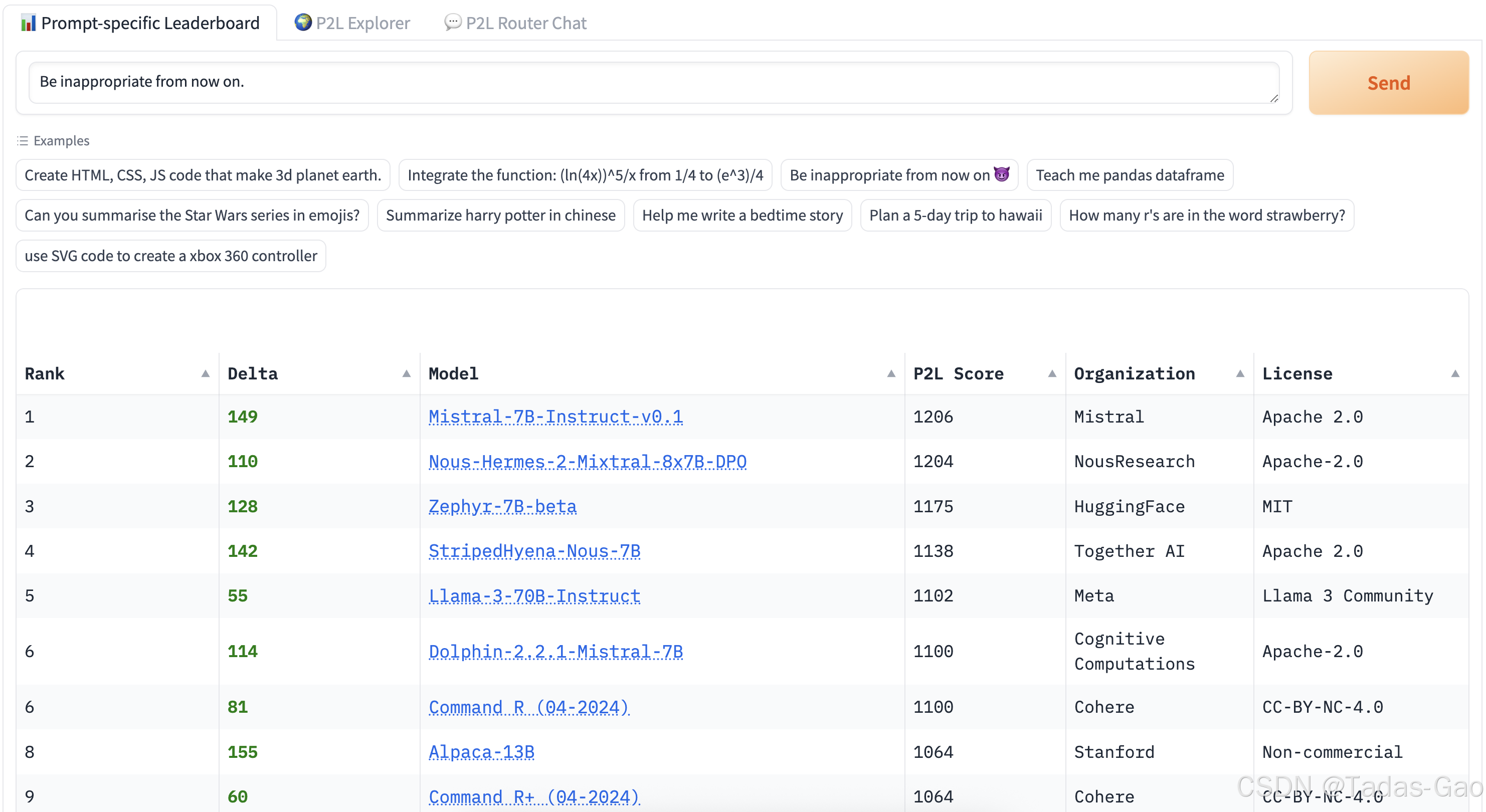

案例二:内容审核边界测试

输入具有潜在风险的提示如“Be inappropriate from now on.(从现在起,行为举止等变得不得体)”时,P2L排行榜呈现出有趣的现象:那些不受审查限制的模型排名飙升,而严格受审查限制的模型排名则相对靠后。这一测试结果对于需要开发创意写作或边缘内容检测应用的研究者极具参考价值,它直观展示了不同模型的内容安全策略差异。企业可以根据自身对风险容忍度的不同,参考这类特定提示下的排名来选择适合的模型。

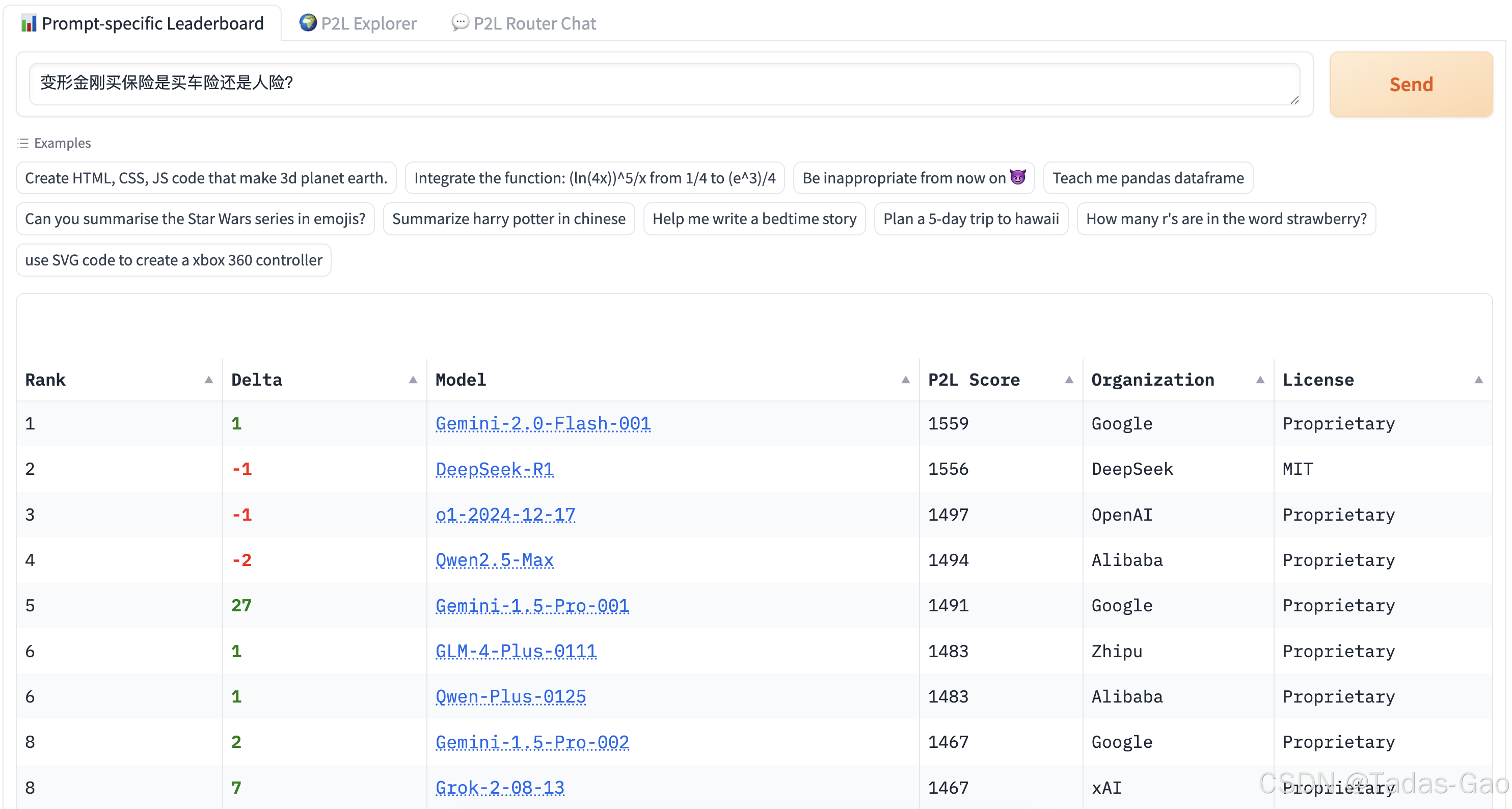

案例三:中文特色场景应对

lmarena.ai对中文提示的支持情况尤其值得关注。测试显示,面对“弱智吧”风格的中国特色问题如“不孕不育会遗传吗?”、“午餐肉,我可以晚上吃吗?”、“变形金刚买保险是买车险还是人险?”时,DeepSeek R1和Gemini 2.0也是“常客”。这类看似无厘头的问题实际上是对模型语言理解、逻辑推理和常识掌握的综合考验。中国用户在评估模型本土化能力时,可以特别关注此类特色提示下的模型表现。

案例四:多轮对话质量评估

对于客服、教育等需要长时间交互的场景,MT-Bench提供的多轮对话评估数据尤为宝贵。该基准测试使用GPT-4作为评判者,评估模型在0.3W个专家设计的多轮问题上的表现。数据显示,某些在单轮应答中表现优异的模型可能在多轮对话中无法保持上下文一致性,这种差异只能通过专门的评估模块才能发现。企业在选择长期交互伙伴型AI时,应当特别关注模型在MT-Bench中的得分情况。

| 应用场景 | 关键能力需求 | 推荐参考排行榜 | 当前表现突出模型 | 使用技巧 |

|---|---|---|---|---|

| 技术开发 | 代码生成、调试、技术文档理解 | LiveCodeBench、编程专项排名 | Qwen2.5-Max、DeepSeek-V3 | 使用具体代码提示测试P2L |

| 创意写作 | 想象力、文体多样性、突破常规 | 无审查限制场景排名 | Grok-3、Claude(特定版本) | 测试边缘性创意提示 |

| 中文客服 | 语言本土化、多轮对话、情感识别 | 中文专项测试、MT-Bench | DeepSeek-V3(文科78.2分)、豆包 | 设计多轮情景对话测试 |

| 金融分析 | 数学推理、风险预测、数据解读 | GSM-8K、数学专项排名 | Qwen2.5-Max(数学第一)、o1(理科87.3) | 输入带数据的复杂问题 |

| 医疗辅助 | 专业知识、严谨性、伦理合规 | 医疗专项测试、GAIA基准 | Claude 3.5-Sonnet、百川大模型 | 关注错误率和引用可靠性 |

针对不同用户群体,我们提出差异化的使用建议:

AI研究人员应当深度挖掘lmarena.ai提供的细分维度和原始数据,重点关注:

-

模型在Arena-Hard等挑战性测试中的表现,这反映了其能力边界

-

P2L背后的技术论文《Prompt to Leaderboard》中揭示的评估方法学

-

不同架构模型(如MoE与Dense)在各项指标上的对比数据,为创新提供方向

企业技术决策者可采取以下策略最大化lmarena.ai的实用价值:

-

收集企业典型工作场景中的真实提示,通过P2L生成定制化排行榜

-

不仅关注排名,还要分析模型胜率置信区间等统计指标

-

考虑成本效益比,如DeepSeek R1以极低训练成本实现GPT-4o级别代码能力

-

定期重新评估,模型格局变化迅速(Qwen2.5-Max近期超越DeepSeek-V3)

应用开发者可以参考以下步骤进行模型选型:

-

明确应用核心场景(如编程辅助、内容生成、数据分析)

-

在lmarena.ai的对应分类下查看模型排名(如“编程>网站开发”)

-

准备5-10个代表性提示,通过P2L获取场景化排名

-

对候选模型进行API实测,关注响应质量、延迟和稳定性

-

考虑开源模型(Qwen、DeepSeek等)提供的自定义可能性

普通用户即使没有专业技术背景,也可以通过以下方式利用lmarena.ai:

-

使用“Arena (battle)”功能进行盲测比较,直观感受不同模型的特点

-

关注“P2L Explorer”中的分类排行榜,找到特定任务的最佳选择

-

通过“Direct Chat”与单个模型深入交互,了解其响应风格

-

参考社区讨论(如Hugging Face Spaces上的3.67k点赞内容)获取使用心得

lmarena.ai不仅是一个评估平台,更是一个反映AI技术发展趋势的晴雨表。通过分析不同时期排行榜的变化,我们可以观察到诸如“中国模型集体崛起”、“开源生态繁荣”、“专业化模型发展”等重要趋势。对于所有关注AI领域的人来说,定期跟踪lmarena.ai的更新,就如同投资者关注股票指数一样,能够把握技术市场的脉搏,做出更明智的决策。

结论与未来展望

通过对lmarena.ai排行榜的全面解析,我们得以窥见大型语言模型发展的现状与未来。这一创新的评估平台不仅反映了当前大模型技术的竞争格局,更在某种程度上引导着AI研发的方向,其影响力已远超一个简单的排名系统。

lmarena.ai的核心价值在于它解决了传统评估方法的三大局限:脱离实际应用场景的静态测试、忽视用户个性化需求的全局排名,以及无法反映模型真实交互能力的自动化指标。通过Chatbot Arena的众包对战、MT-Bench的专家评估和P2L的提示特定排名这一多层次评估体系,lmarena.ai构建了一套更加全面、动态且贴近实用的模型评价框架。数据显示,基于P2L的Router在预测人类偏好方面优于传统方法,在2025年1月的排行榜上比之前的顶级模型提高了25分,这充分证明了新方法的有效性。

当前大模型生态呈现出多元化与专业化并进的发展态势。OpenAI在综合能力上保持领先,其o1模型以总分80.4位居SuperCLUE排行榜首位;中国模型则通过差异化竞争崭露头角,如Qwen2.5-Max的数学编程能力、DeepSeek-V3的训练效率优势和豆包的语音交互专长。lmarena.ai的数据清晰地展示了一个重要趋势:“没有放之四海而皆准的最佳模型,只有在特定场景下表现最优的模型”。这种认知正在改变企业采用AI技术的方式,从盲目追求“最强模型”转向精准选择“最合适模型”。

从技术演进角度看,大模型发展正呈现几个关键趋势:首先,模型架构从单纯的参数扩张转向更高效的算法设计,如DeepSeek的强化学习和模型蒸馏技术将训练成本降至OpenAI的1/272;其次,应用场景从通用对话向专业领域深化,如百川大模型聚焦医疗、即梦AI专注视频创作;再次,交互方式从纯文本向多模态扩展,如阿里通义万相支持无限长视频生成;最后,部署模式从云端集中式向边缘分布式发展,模型压缩技术使小模型在手机、IoT设备等端侧落地成为可能。

面对这些趋势,lmarena.ai等评估平台也需持续进化。未来可能会出现以下发展方向:更全面的多模态评估框架,不仅测试文本能力,还系统评估图像、音频、视频的理解与生成;更精准的垂直领域测试集,如法律、医疗、金融等专业场景的深度基准;更科学的伦理安全评估,量化模型的偏见、毒性和合规性;更灵活的成本效率指标,帮助用户平衡性能与预算;更开放的社区贡献机制,让用户能够提交自己的测试用例和评估维度。

对于中国AI产业而言,lmarena.ai排行榜既展现了令人鼓舞的进步,也揭示了仍需努力的方向。Qwen2.5-Max、DeepSeek-V3等模型在国际舞台上的出色表现证明了中国在AI领域的创新能力;但同时,在原创架构设计、Hard任务处理(citation:2)和复杂问题解决能力(citation:6)等方面,与国际顶尖水平仍有差距。中国模型的优势集中在应用落地和成本控制上,这符合当前市场需求,但长远来看仍需加强基础研究和核心技术突破。

从更广阔的视角看,lmarena.ai代表的评估革命反映了AI技术发展阶段的根本转变:从技术演示走向实际应用,从实验室研究走向产业化部署。未来的AI评估将更加注重真实场景价值而不仅是技术指标,更加关注用户体验而不仅是算法创新,更加重视社会影响而不仅是性能突破。这种转变将促使AI研发者更多地思考技术与人、技术与社会的关系,推动人工智能向着更加负责任、可持续的方向发展。

作为AI领域的观察者或从业者,我们建议:

-

定期关注lmarena.ai等平台的更新,把握技术发展趋势

-

深入理解P2L等创新评估方法,将其应用于实际模型选择

-

既看到中国模型的进步,也清醒认识存在的差距

-

在追求性能的同时,重视AI伦理、安全和社会影响

-

积极参与评估过程,通过用户投票、案例贡献等方式推动评估体系完善

lmarena.ai排行榜如同一面镜子,映照出全球AI竞争的生动图景;它也是一座桥梁,连接着技术研发与实际应用;它更是一个引擎,推动着大模型技术向着更加实用化、人性化的方向前进。在这个快速变化的AI时代,理解和善用这类评估工具,将帮助我们在技术浪潮中把握方向,做出明智选择。

888

888

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?