OpenAI新推出的Deep Research功能,属实有些惊艳,也验证了去年的一些观点,之后的大模型工作流会呈现一些截然不同的形态,有敏捷型的例如语音端到端的及时对话,也会有异步长流程的复杂任务,去做例如课题研究,信息收集,实验设计,假设验证等等。

而Deep Research的效果类似O1的长思考是非常长的行为链,OpenAI也直接表明Deep Research是使用和O1相同的RL训练得到的。但这里比O1更难的就是数据集的设计,训练过程动态行为数据的引入和RL目标的选择。

这一章我们分别介绍从两个不同角度使用RL优化Agent行为链路的方案,其中PaSa更类似Deep Research的链式行为链使用RL直接优化行为路径,而ARMAP则是使用RL优化Verifier指导行为链的生成。

Bytedance-PaSa

- PaSa: An LLM Agent for Comprehensive Academic Paper Search

- PaSa: Paper Search Agent

- GitHub - bytedance/pasa: PaSa -- an advanced paper search agent powered by large language models. It can autonomously make a series of decisions, including invoking search tools, reading papers, and selecting relevant references, to ultimately obtain comprehensive and accurate results for complex scholarly queries.

PaSa是字节推出的自动搜索相关论文(引用论文)的Agent,通过RL优化Policy模型,优化论文搜索和论文筛选行为,实现更全面,精准的论文搜索,充分考虑到论文搜索场景的长尾性,query的复杂性,以及论文引用的关联性等特点。

其实论文引用收集这个目标也可以用于综述类论文写作任务,因为写作类的开放任务很难使用基于规则的RL目标进行优化,但是如果假设模型的写作能力已经足够应对常见的任意写作任务,那是否收集足够的论据和论文就是综述类论文写作的一个间接衡量目标了。

数据集

对于智能体的行为优化,比较核心的部分就是数据集的构建,毕竟O1可以依赖更多有标准答案的Math和Coding数据集,而Agent优化需要依赖和现实世界交互获得的实时数据。这里论文开源了

- AutoScholarQuery训练数据:训练验证测试的划分分别为33511/1000/1000

- RealScholarQuery Benchmark: 包含50个标注的高质量

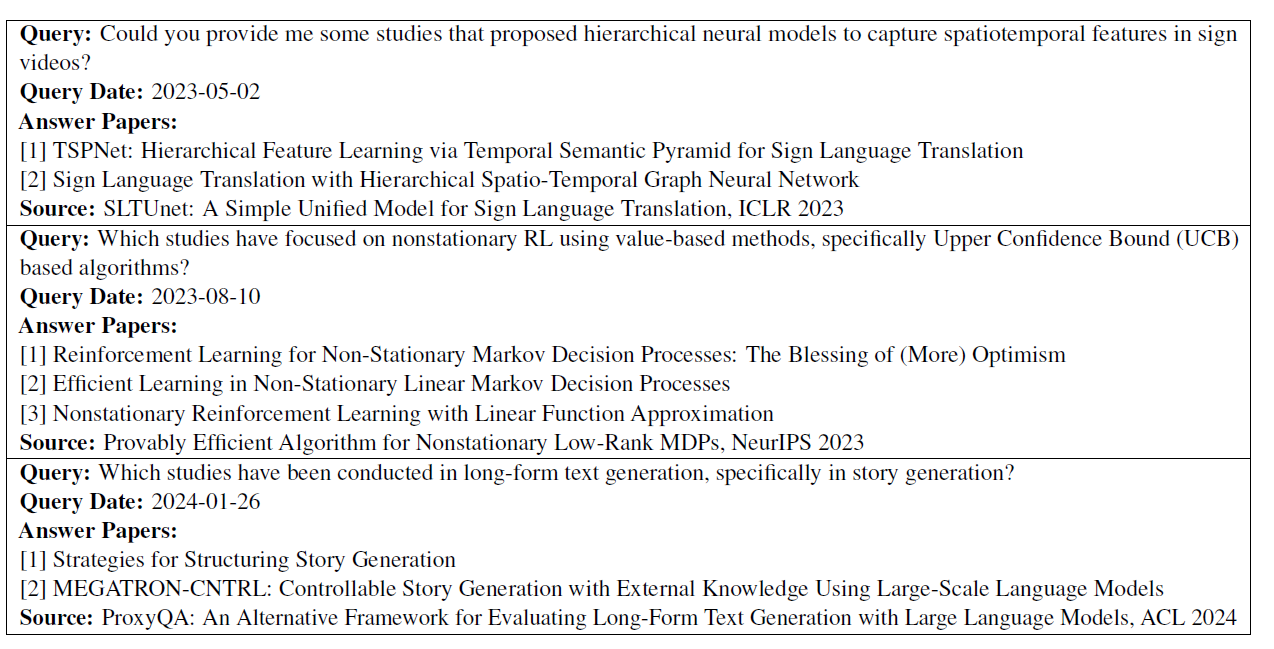

数据格式如下,包含用户的搜索query,搜索时间,以及和Query相关的论文标题列表

其中AutoScholarQuery的构建方式是搜集了2023,2024年的ICLR,ICML,N二UIPS,ACL,CVPR的论文,每篇论文都会使用Related work部分的内容,使用以下Prompt让GPT4-o生成研究员可能使用哪些Query来收集这些相关论文。这样Query和Related Work部分的论文就构成了以上的样本,时间用了比较宽松的论文发布时间。作者人工抽检了100条样本,整体query和论文的相似度在90%+。

RL优化Agent行为路径的两种方案

RL优化Agent行为路径的两种方案

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4078

4078

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?