1、jobmanager日志

在yarn上可以直接看

2、taskmanager日志

在flink的webui中可以看,但是flink任务失败后,webui就不存在了,那怎么看?

这是jobmanager的地址

你要看taskmanager的地址,首先我们要知道taskmanager运行在哪里

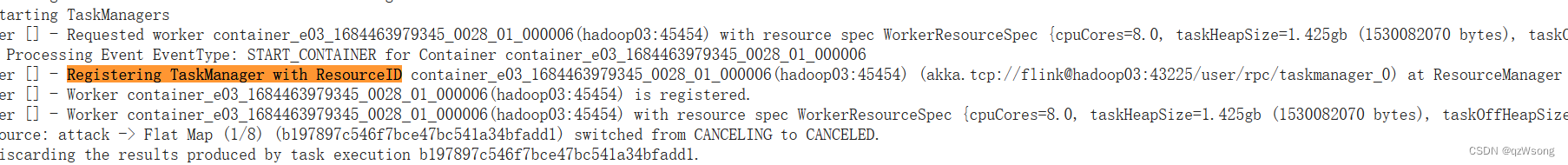

打开Jobmanager日志

全局搜索

Registering TaskManager with ResourceID

后边就是taskmanager地址因此,替换一下url就可以得到这个taskmanger的地址

后边就是taskmanager地址因此,替换一下url就可以得到这个taskmanger的地址

2023-05-30 03:19:35,136 INFO org.apache.flink.runtime.resourcemanager.active.ActiveResourceManager [] - Registering TaskManager with ResourceID container_e03_1684463979345_0028_01_000003(hadoop03:45454) (akka.tcp://flink@hadoop03:43225/user/rpc/taskmanager_0) at ResourceManager 2023-05-30 03:19:35,147 INFO org.apache.flink.runtime.resourcemanager.active.ActiveResourceManager [] - Worker container_e03_1684463979345_0028_01_000003(hadoop03:45454) is registered.

http://hadoop02:19888/jobhistory/logs/{taskmangerIp}:45454/{taskmanager的容器名}/{taskmanager的容器名}/root

http://hadoop02:19888/jobhistory/logs/{taskmangerIp}:45454/{taskmanager的容器名}/{taskmanager的容器名}/root

taskmanager容器名:container_e03_1684463979345_0028_01_000003

taskmangerIp: hadoop03

http://hadoop02:19888/jobhistory/logs/{taskmangerIp}:45454/{taskmanager的容器名}/{taskmanager的容器名}/root

注意:应该会有好多个taskmanger

4246

4246

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?