一、本文介绍

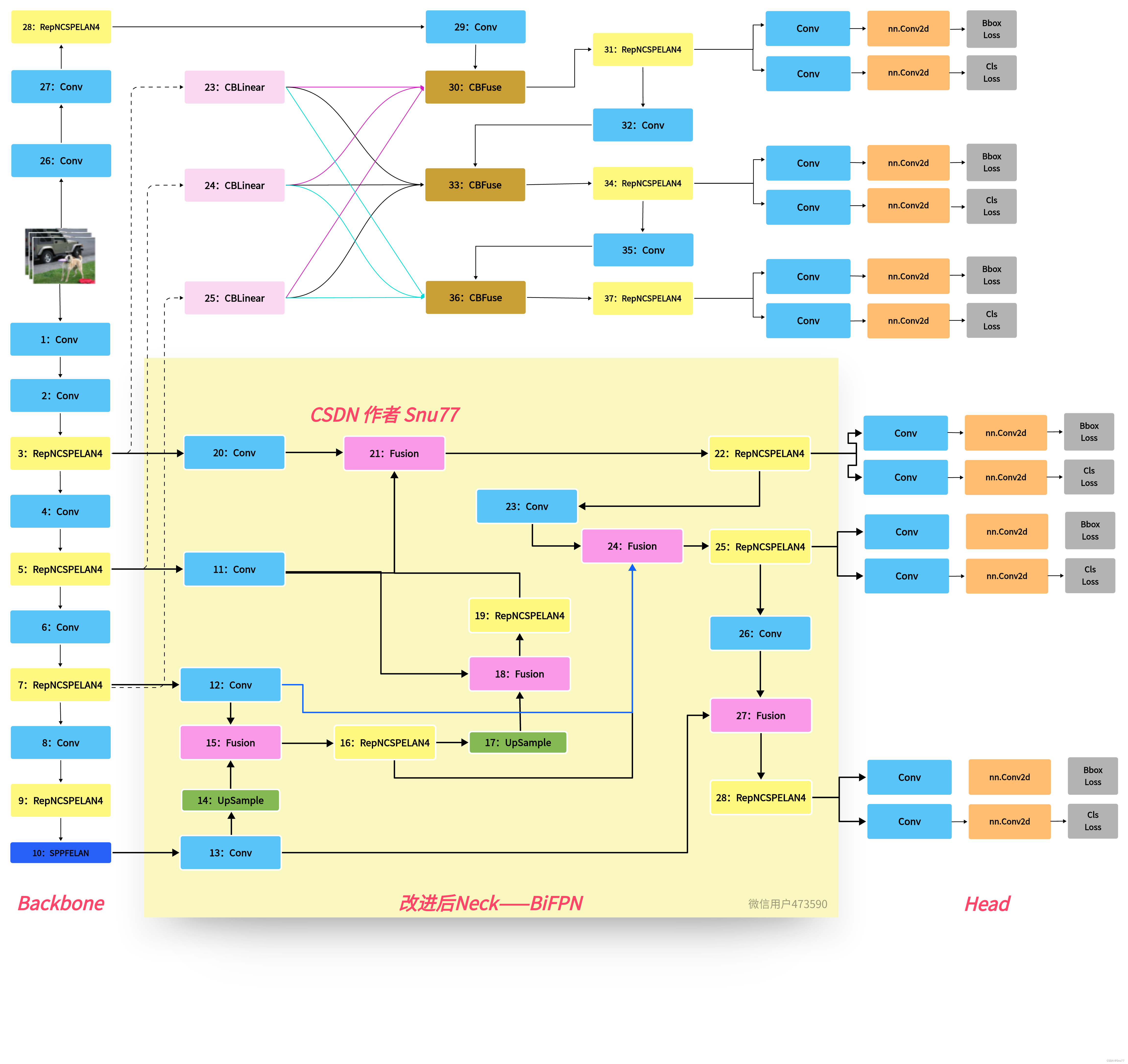

本文给大家带来的改进机制是BiFPN双向特征金字塔网络,其是一种特征融合层的结构,也就是我们本文改进YOLOv9模型中的Neck部分,它的主要思想是通过多层级的特征金字塔和双向信息传递来提高精度。本文给大家带来的结构可以让大家自行调节网络结构大小,同时能够达到一定的轻量化效果,本专栏每周更新3-5篇最新机制,更有包含我所有改进的文件和交流群提供给大家,同时本专栏目前改进基于yolov9.yaml文件,后期如果官方放出轻量化版本,专栏内所有改进也会同步更新,请大家放心。

欢迎大家订阅我的专栏一起学习YOLO!

推荐指数:⭐⭐⭐⭐⭐

目录

本文详细介绍了Bi-FPN(双向特征金字塔网络)的原理,包括双向特征融合、加权融合机制和结构优化,以此增强YOLOv9的性能。提供了代码和修改教程,帮助读者理解和应用Bi-FPN到YOLOv9模型中,以实现更高效的目标检测。

本文详细介绍了Bi-FPN(双向特征金字塔网络)的原理,包括双向特征融合、加权融合机制和结构优化,以此增强YOLOv9的性能。提供了代码和修改教程,帮助读者理解和应用Bi-FPN到YOLOv9模型中,以实现更高效的目标检测。

订阅专栏 解锁全文

订阅专栏 解锁全文

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?