一、本文介绍

本文给大家带来的改进机制是利用Swin Transformer替换YOLOv5中的骨干网络其是一个开创性的视觉变换器模型,它通过使用位移窗口来构建分层的特征图,有效地适应了计算机视觉任务。与传统的变换器模型不同,Swin Transformer的自注意力计算仅限于局部窗口内,使得计算复杂度与图像大小成线性关系,而非二次方。这种设计不仅提高了模型的效率,还保持了强大的特征提取能力。Swin Transformer的创新在于其能够在不同层次上捕捉图像的细节和全局信息,使其成为各种视觉任务的强大通用骨干网络。亲测在小目标检测和大尺度目标检测的数据集上都有涨点效果。

推荐指数:⭐⭐⭐

涨点效果:⭐⭐⭐

目录

二、Swin Transformer原理

论文地址:官方论文地址

代码地址:官方代码地址

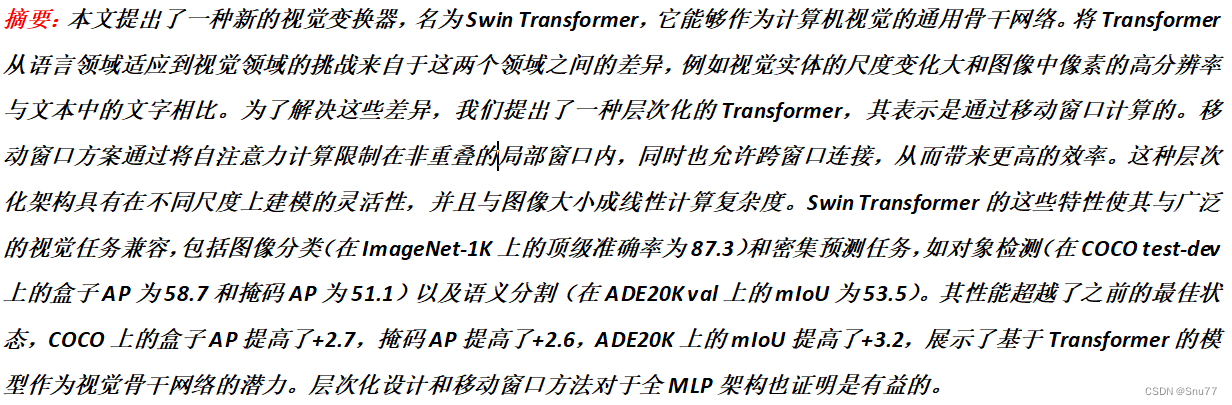

本文详细介绍了如何使用Swin Transformer改进YOLOv5目标检测模型,通过替换原来的骨干网络,利用Swin Transformer的局部自注意力计算和移动窗口自注意力来提高模型效率和性能。文章深入讲解了Swin Transformer的基本原理,包括层次化特征映射、局部自注意力计算、移动窗口自注意力和移动窗口分区,并提供了完整的代码和修改步骤,以帮助读者实现在自己的YOLOv5项目中应用Swin Transformer。

本文详细介绍了如何使用Swin Transformer改进YOLOv5目标检测模型,通过替换原来的骨干网络,利用Swin Transformer的局部自注意力计算和移动窗口自注意力来提高模型效率和性能。文章深入讲解了Swin Transformer的基本原理,包括层次化特征映射、局部自注意力计算、移动窗口自注意力和移动窗口分区,并提供了完整的代码和修改步骤,以帮助读者实现在自己的YOLOv5项目中应用Swin Transformer。

订阅专栏 解锁全文

订阅专栏 解锁全文

1088

1088

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?