一、本文介绍

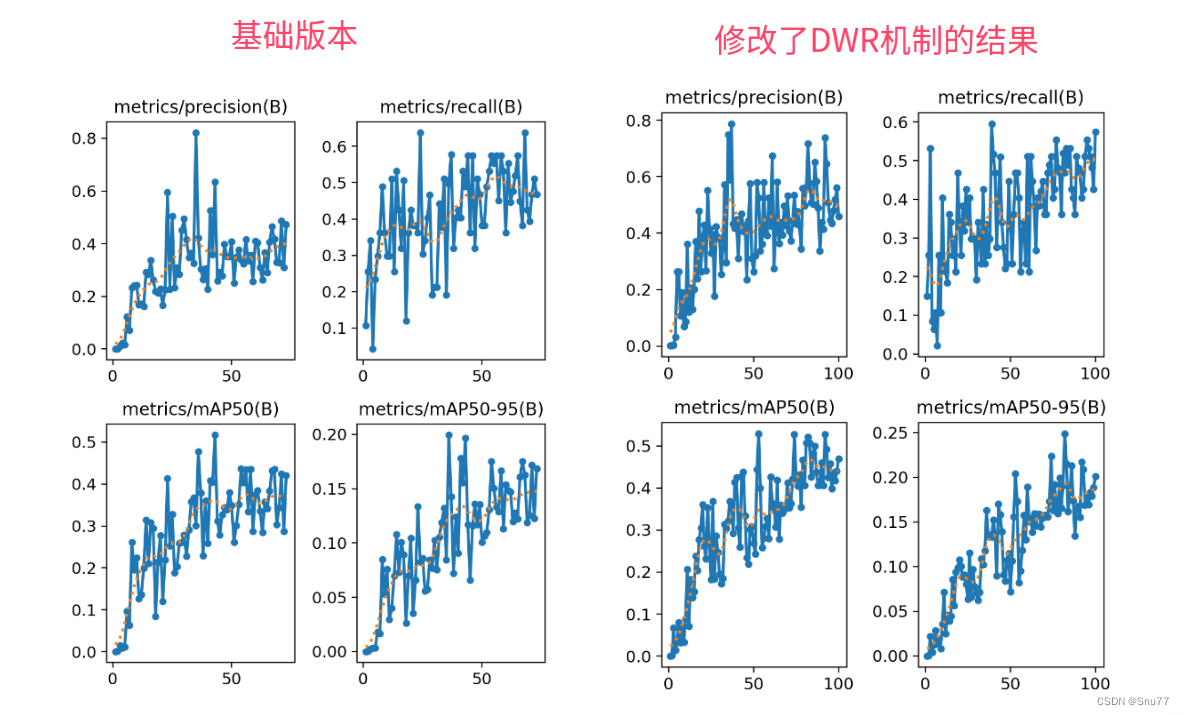

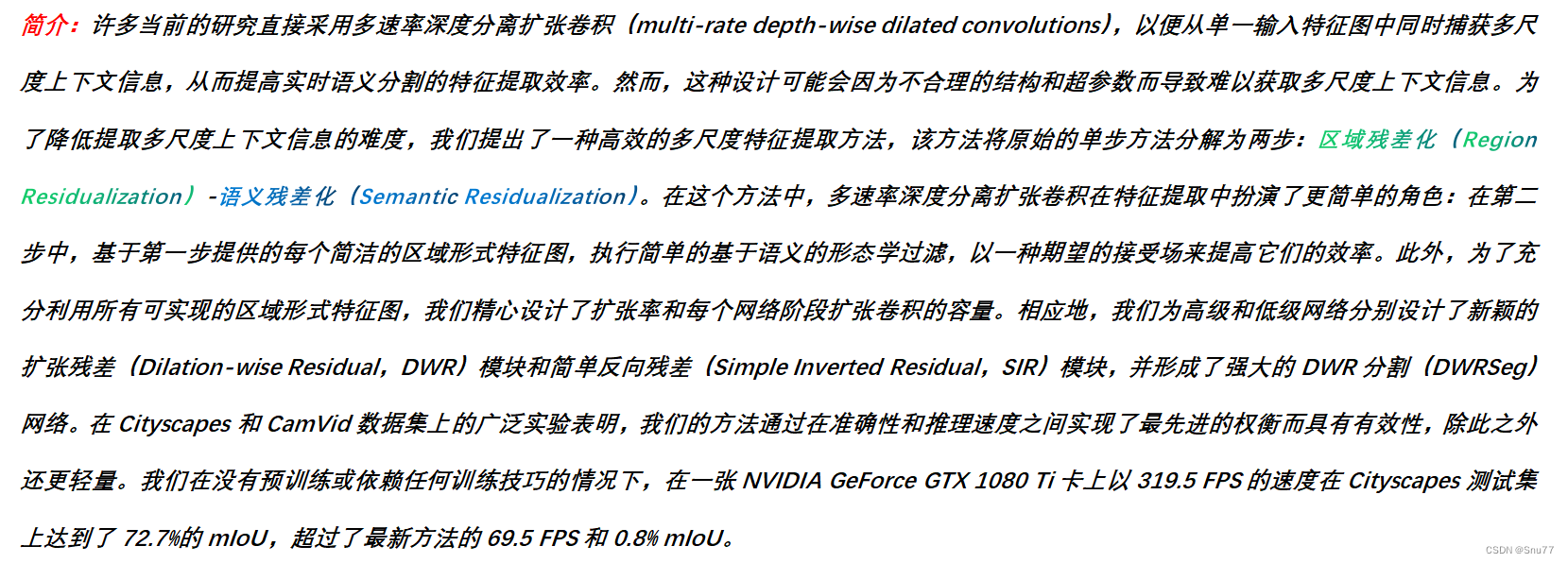

本文内容给大家带来的DWRSeg中的DWR模块来改进YOLOv8中的C2f和Bottleneck模块,主要针对的是小目标检测,主要创新点可以总结如下:多尺度特征提取机制的深入研究和创新的DWR模块和SIR模块的提出,这种方法使得网络能够更灵活地适应不同尺度的特征,从而更准确地识别和分割图像中的物体。 通过本文你能够了解到:DWRSeg的基本原理和框架,并且能够在你自己的网络结构中进行添加(DWRSeg需要增加一定的计算量一个DWR模块大概增加0.4GFLOPs)。

目录

二、DWRSeg的原理介绍

论文地址:官方论文地址

代码地址:该代码目前还未开源,我根据论文内容进行了复现内容在文章末尾。

本文介绍了如何利用DWRSeg中的DWR模块改进YOLOv8的C2f和Bottleneck,增强小目标检测能力。详细探讨了DWRSeg的多尺度特征提取机制和DWR、SIR模块,提供了添加DWR模块的教程及配置文件。

本文介绍了如何利用DWRSeg中的DWR模块改进YOLOv8的C2f和Bottleneck,增强小目标检测能力。详细探讨了DWRSeg的多尺度特征提取机制和DWR、SIR模块,提供了添加DWR模块的教程及配置文件。

订阅专栏 解锁全文

订阅专栏 解锁全文

4490

4490