目录

ReLU(Rectified Linear Units)函数

前言

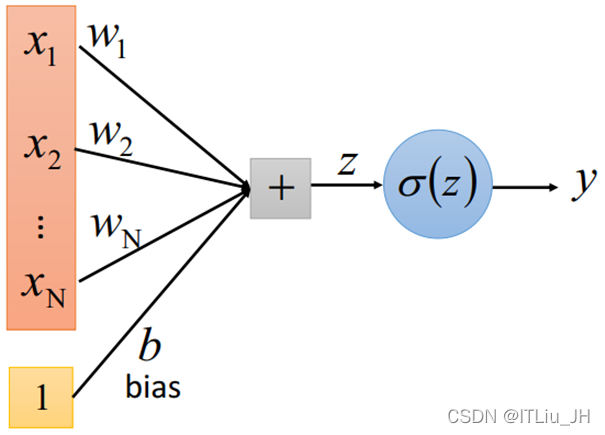

神经网络的节点如图。

为n个输入,

为输入对应的权重,b为偏置,

为激活函数。

![]()

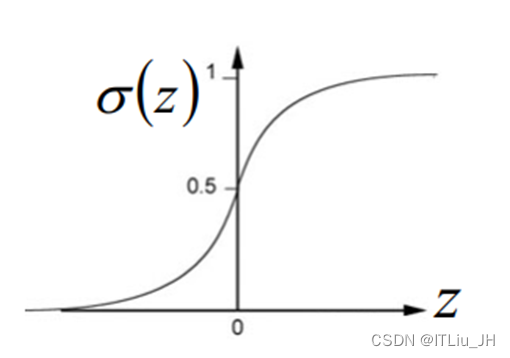

z与x为线性关系,不论多少层,每层多少节点, 输入与输出始终为线性关系。

激活函数加入非线性因素的,解决线性模型的表达能力不够的问题。

![]()

常用的激活函数

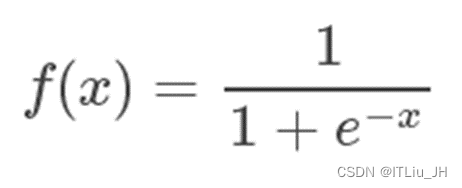

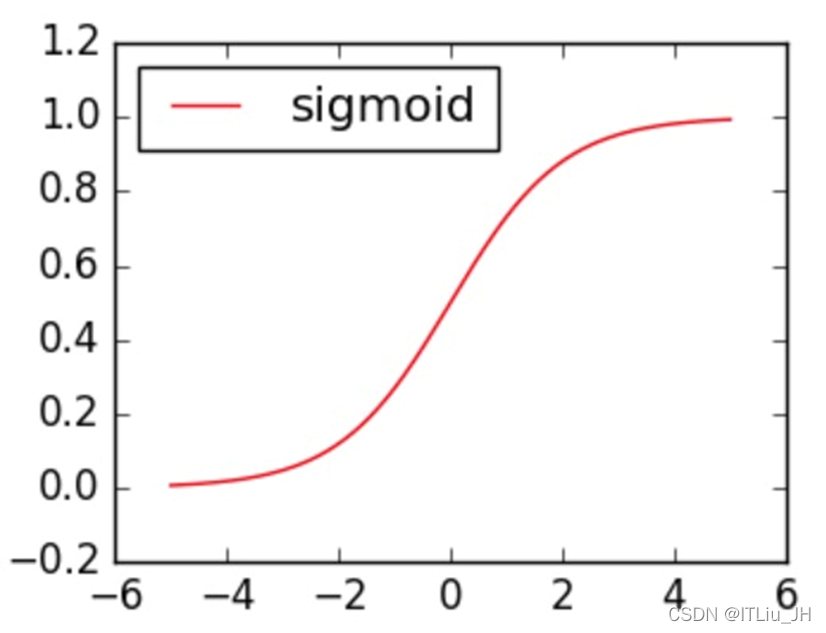

Sigmoid函数

优点

具有较好的可解释性

输出范围有限

单调连续

缺点

函数饱和,梯度容易消失

输出不以0为中心

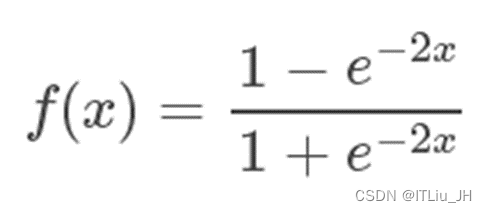

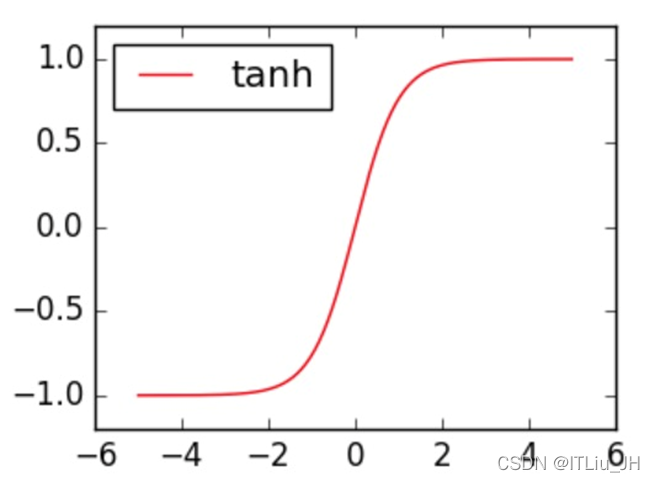

Tanh函数

优点

比Sigmoid收敛速度快

输出以0为中心

缺点

函数饱和,梯度容易消失

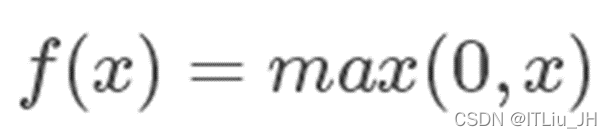

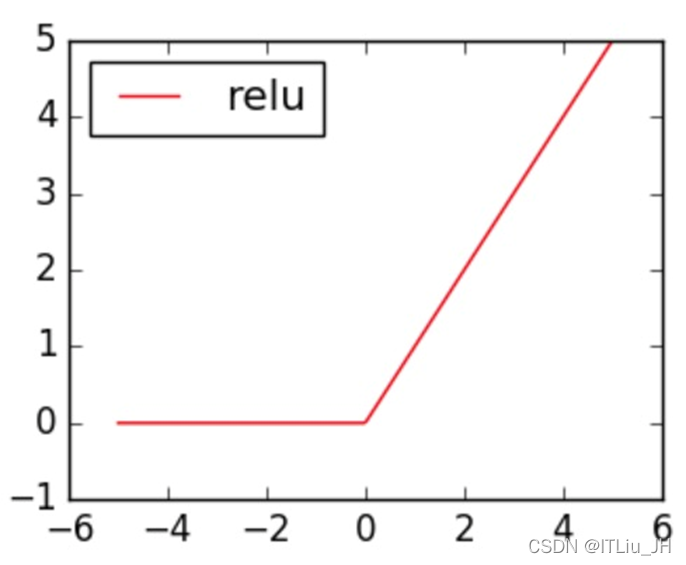

ReLU(Rectified Linear Units)函数

优点

收敛速度比上述激活函数更快

计算简单

缺点

当输入小于0时,训练参数将无法更新

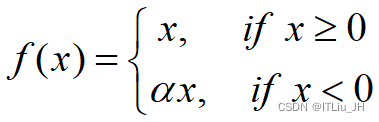

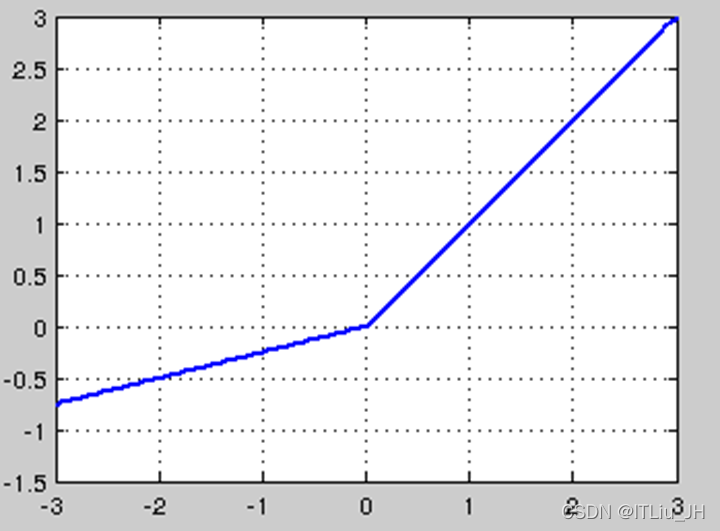

Leaky-ReLU函数

优点

收敛速度快

解决神经元死亡现象

缺点

实际应用中发现效果不稳定

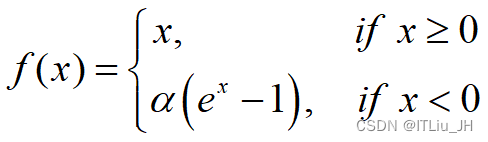

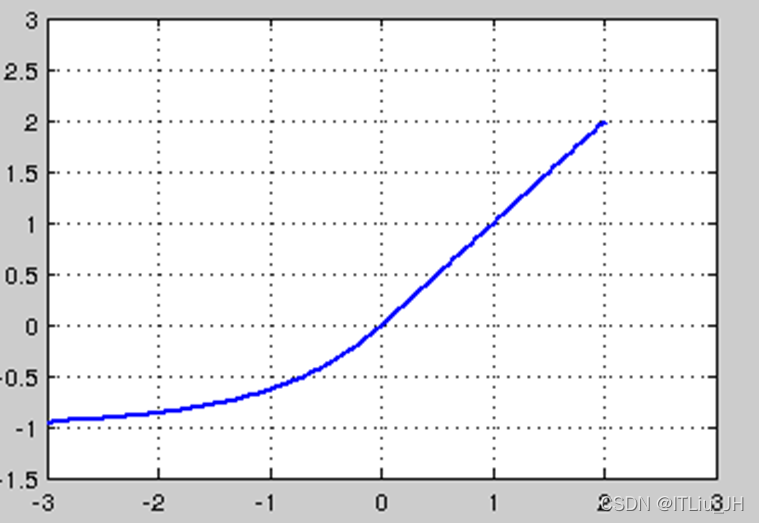

ELU函数

优点

收敛速度快

缓解梯度消失

对输入变化更鲁棒

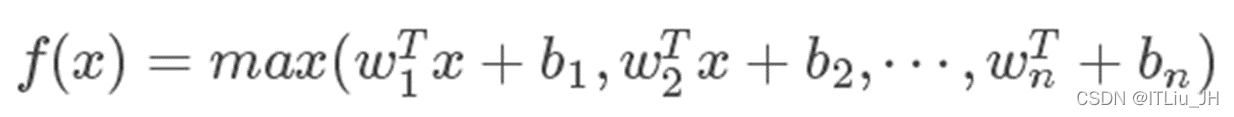

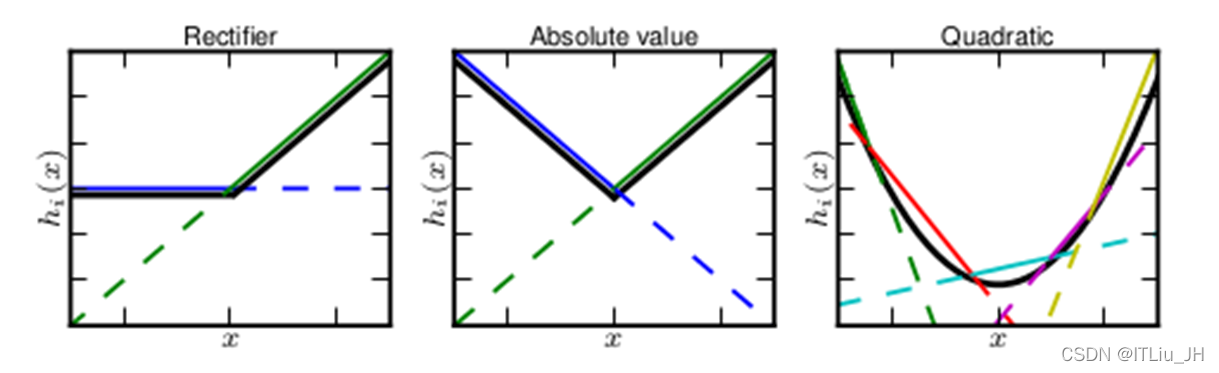

Maxout函数

优点

收敛速度快

不饱和

可以拟合任意凸函数

缺点

参数量增加,计算复杂度增大

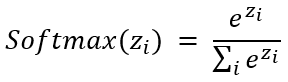

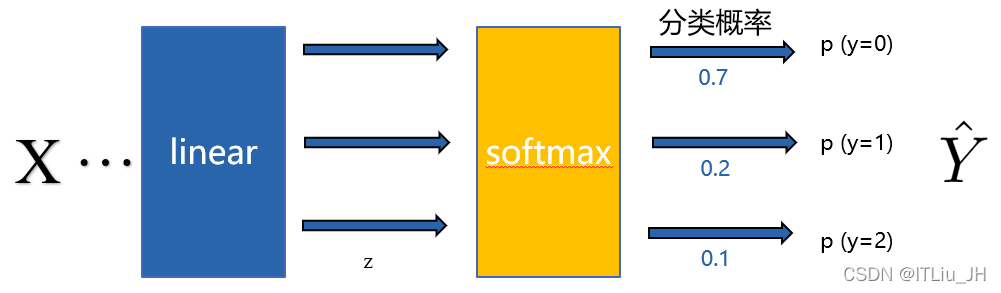

Softmax 函数

将多个神经元输出映射到区间(0, 1) ,常用于多分类问题

本文介绍了神经网络中常见的激活函数,包括Sigmoid、Tanh、ReLU及其变种Leaky-ReLU和ELU,还有Maxout及Softmax等。讨论了它们的优点和缺点,以及在不同场景下的适用性。

本文介绍了神经网络中常见的激活函数,包括Sigmoid、Tanh、ReLU及其变种Leaky-ReLU和ELU,还有Maxout及Softmax等。讨论了它们的优点和缺点,以及在不同场景下的适用性。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?