实验内容与要求:

- 虚拟机的创建

虚拟化软件为:VMware(版本不限)

网址:https://www.vmware.com/sg/products/workstation-pro.html

该处勾选稍后安装操作系统。我们在创建虚拟后启动时下载Ubuntu操作系统

//处理器数量一定要选1

创建虚拟机成功后启动,下载Ubuntu系统。

下载成功后。

以管理员身份运行Window的PowerShell

然后输入./netsh winscock reset或者netsh winsock reset

启动所建立的虚拟机,选择VMware软件中的虚拟机的安装VMware Tools命令,此时就会在所建立的虚拟机桌面上显示VMware Tools的光盘图标。打开VMware Tools的光盘图标,打开VMware Tools文件夹,将里面的VMware Tools的压缩包拖到桌面上。

之后,打开Linux终端,输入以下命令解压VMware Tools的压缩文件

//进入桌面目录

cd desktop或者cd 桌面

//解压

Tar -zxvf VMwareTools-10.3.21-14772444.tar.gz注意这里版本不一样输入也不同

//从桌面进入vmware-tools-distrib文件夹并安装

Cd vmware-tools-distrib

Sudo ./vmware-install.pl

之后只需输入yes或者按Enter键即可。最后必须重启虚拟机,使VMware Tools的安装生效,并可以拖动一个文件到虚拟机来测试安装是否成功

先在Window环境下安装JDK,然后将安装文件拖到虚拟机

//安装JDK到/usr/local目录下

cd 桌面//进入桌面目录下

//将安装文件解压到/usr/local目录下

sudo tar -zxvf jdk-8u161-linux-x64.tar.gz -C/usr/local

在上述解压完成后还需要配置JDK在虚拟机的环境变量

//打开环境变量配置文件s

vim ~/.bashrc

sudo apt-get install vim//安装vim

vim ~/.bashrc 或者vim /home/hadoop/.bashrc进入bashrc

进入.bashrc后在文件末端输入

export JAVA_HOME=/usr/local/jdk1.8.0_161

export JRE_HOME=${JAVA_HOME}/jre

Export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$ PATH

检验source ~/.bashrc

Java -version

将window下载后的IDEA移到linux

sudo tar -zxvf ideaIC-2016.2.5.tar.gz -C/usr/local

cd /usr/local

sudo mv idea-IC-162.2228.15 idea2016

进入IDEA目录cd /usr/local/idea2016

./bin/idea.sh

vim ~/.bashrc进入文件后,在文件末端输入

IDEA_HOME=/USR/LOCAL/IDEA2016

PATH= $ {IDEA_HOME}/bin: $ PATH

启动IDEA idea.sh

将安装文件移动到linux终端

然后sudo tar -zxvf apache-maven-3.5.0-bin.tar.gz -C/usr/local

cd /usr/local

sudo mv apache_maven-3.5.0 maven

在安装完成文件后,将Maven的安装路径加到系统的环境变量

vim ~/.bashrc

MAVEN_HOME=/usr/local/maven

PATH= $ {MAVEN_HOME}/bin:$ PATH

然后检验是否成功 mvn -version

在通过 Maven 自动地从中央仓库中下载依赖的 jar 包时,下载的 jar 在本地存放的位置为本地仓库。人们可以通过配置 settings . xml 文件来修改本地仓库的路径。比如,将/home / hadoop 目录下的 maven_ localRepository 文件夹设置为本地仓库,则可以通过在 Maven 安装文件 conf 目录下的 settings . xml 文件中添加如下一行信息来实现。

Maven 中央仓库往往都在国外,因此下载依赖的 jar 包时速度往往很慢。在这种情况下,可以改为从国内的 Maven 中央仓库的镜像(如阿里云的 Maven 镜像)去下载依赖包。这需要在 conf 目录下的 settings . xml 文件中添加如下的镜像信息。

< mirrors >

< mirror >

< id > alimaven </ id >

< name > aliyun maven </ name >

< url >https://maven.aliyun.com/repository/central</ url >

< mirrorOf > central </ mirrorOf >

</ mirror >

</ mirrors >

当第一次启动 IDEA 进入欢迎页面之后,可以通过选择" Create Project "命令来创建个项目。当选择" Create Project "命令之后 会 在该界面中,们选择左侧列表中的 Maven 选项,创建 Maven 项目,然后单击右侧顶部的 Project SDK 下按钮,便可在下拉列表中选择所安装的 JDK 的位置。选择完成之后,单击" OK "按钮即完成项目中 JDK 的配置。

在配置完 JDK之后,单击" Next "按钮,在弹出的界面中会要求填写 Groupld 、 Artifac - tld 和 Version 信息,如图2-15所示。 Groupld 是创建这个项目的组织的标识。 ArtifactId 是这个项目产出的标识,一般是项目产生的 jar 包的名称。 Version 是 Artifact 的版本号。当输入默认的保存位置为当前用户的根目录。完这些信息之后,进一步输入项目的名称以及项目的保存位置,即完成了项目的创建。项目

在创建完项目之后,选择 IDEA 的" File "→" Settings "菜单命令,即可进入图2-16所示的 Maven 配置窗口。在该窗口的左侧输入栏中输入 maven ,窗口的右侧即会显示当前项目的 Maven 的设置信息。在这些信息中,我们需要修改窗口下部的 Maven home directory 、 Usersettings file 和 Local repository 这3个信息,将 Maven home directory 修改为所安装的 Maven 的路径,将 User settings file 修改为 Maven 安装文件 conf 目录中的 settings . xml 文件,将 Local repository 修改为所设置的本地仓库的路径。当修改完上述信息之后,单击" OK "按钮即完成项目中 Maven 的配置。在上述配置完成之后,在 IDEA 中进行的应用程序编写就是修改 pom . xml 文件以及在 main 目录下建立新的 class 文件。如果要进行单元测试,还需要在 test 目录下建立单元测试的 class 文件。

打开Linux终端

输入sudo apt-get install openssh-server //安装SSH Server

ssh localhost //登录localhost,第一次登录输入yes,并且登录时发现是需要密码的

exit //注销,退出登录

cd ~/.ssh //进入用户根目录下的。ssh目录

ssh-keygen -t rsa //生成密钥

cat ./id_rsa.pub >> ./authorized_keys //追加到用户根目录

ssh localhost //登录

Window下载后移到linux

sudo tar -zxvf hadoop-2.10.0.tar.gz -C/usr/local

cd /usr/local

sudo mv hadoop-2.10.0 hadoop//将安装文件重命名

sudo chown -R hadoop .Hadoop //赋予zylj用户使用当前目录下hadoop目录的权限

vim ~/.bashrc

//配置环境

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH :${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin

hadoop -version

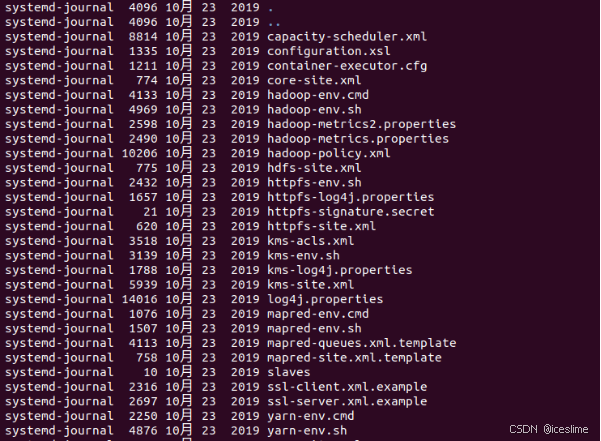

将如下命令输入到hadoop-env.sh文件

export JAVA_HOME=/usr/local/jdk1.8.0_161

将如下命令输入到core-site.xml文件的<configuration>标签中

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories. </description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

将如下命令输入到hdfs-site.xml文件中的<configuration>标签中

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

调用如下命令对NameNode进行格式化。

hdfs namenode -format

在终端调用start-dfs.sh命令来启动HDFS,并通过jps命令来查看是否 启动出现“成功”界面说明安装成功

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?