目录

1. 窗口函数功能介绍

在利用Spark SQL按分组统计每个组内topN,或者相对某个指标归一化到[0,1]区间上时,可以使用spark的窗口函数:

(1) rank: 分数相同的行,排序编号也一致。当有2行数据排序并列第一时,它们的编号都是1,排第三的编号是3

(2) dense_rank:分数相同的行,排序编号也一致。当有2行数据排序并列第一时,它们的编号都是1,排第三的编号是2

(3) row_number: 每一行的编号唯一,当有2行数据相同时,随机分配编号

(4) percent_rank:结果可以视作为rank()的结果,除以最大的编号

一个简单的例子

package high_quality._history

import org.apache.spark.sql._

import org.apache.spark.sql.functions._

import org.apache.spark.sql.expressions.Window

object test {

def main(args: Array[String]) {

val spark = SparkSession.builder().master("local[2]").appName("test").config("spark.hadoop.validateOutputSpecs", "false").getOrCreate()

import spark.implicits._

Seq("22", "27", "37", "47", "57")

.toDF("x1")

.withColumn("x2", percent_rank().over(Window.orderBy($"x1"))).show()

}

}

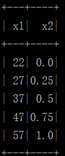

结果为:

一个复杂的例子

假设有数据如下表(例子转自https://blog.youkuaiyun.com/kwame211/article/details/81325261):

本文介绍了Spark窗口函数如rank(), row_number(), percent_rank()在处理大数据时可能导致的OOM问题,并提供了三种解决方法:通过SQL处理,转换为rdd进行排序,以及数据量过多时的分组随机打散策略,以实现近似排序。"

135749080,10856630,Qt5.9在Linux上的完整安装教程,"['Qt', 'Linux', '开发环境', '软件安装', 'C++']

本文介绍了Spark窗口函数如rank(), row_number(), percent_rank()在处理大数据时可能导致的OOM问题,并提供了三种解决方法:通过SQL处理,转换为rdd进行排序,以及数据量过多时的分组随机打散策略,以实现近似排序。"

135749080,10856630,Qt5.9在Linux上的完整安装教程,"['Qt', 'Linux', '开发环境', '软件安装', 'C++']

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

405

405

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?