集群脑裂数据丢失问题

所谓的脑裂,就是指在主从集群中,同时有两个主节点,它们都能接收写请求。而脑裂最直接的影响,就是客户端不知道应该往哪个主节点写入数据,结果就是不同的客户端会往不同的主节点上写入数据。而且,严重的话,脑裂会进一步导致数据丢失。

redis的集群脑裂是指因为网络问题,导致redis master节点跟redis slave节点和sentinel集群处于不同的网络分区,此时因为sentinel集群无法感知到master的存在,所以将slave节点提升为master节点。此时存在两个不同的master节点,就像一个大脑分裂成了两个。

集群脑裂问题中,如果客户端还在基于原来的master节点继续写入数据,那么新的master节点将无法同步这些数据,当网络问题解决之后,sentinel集群将原先的master节点降为slave节点,此时再从新的master中同步数据,将会造成大量的数据丢失。

数据丢失的原因

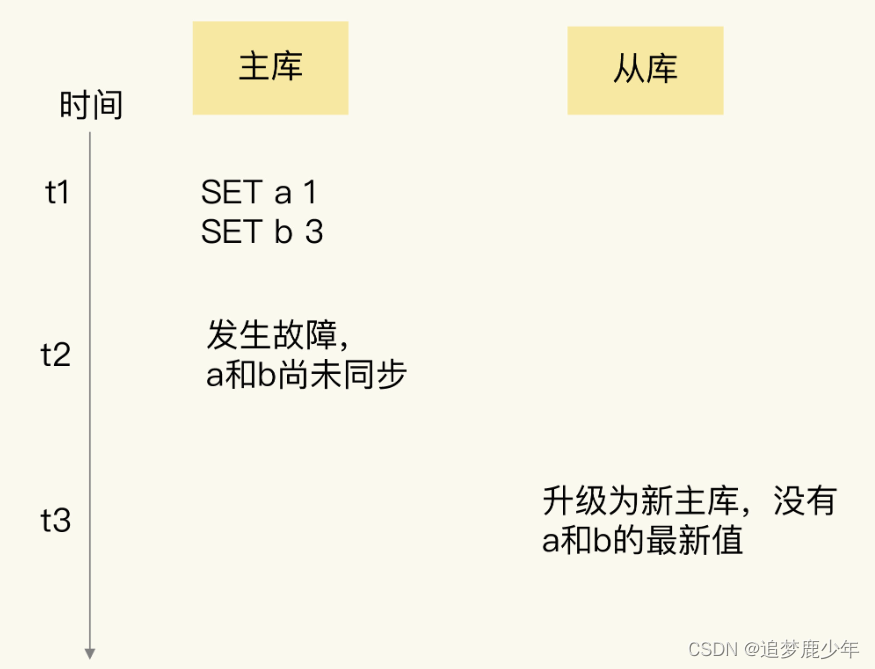

- 确认是不是数据同步出现了问题 在主从集群中发生数据丢失,最常见的原因就是主库的数据还没有同步到从库,结果主库发生了故障,等从库升级为主库后,未同步的数据就丢失了。

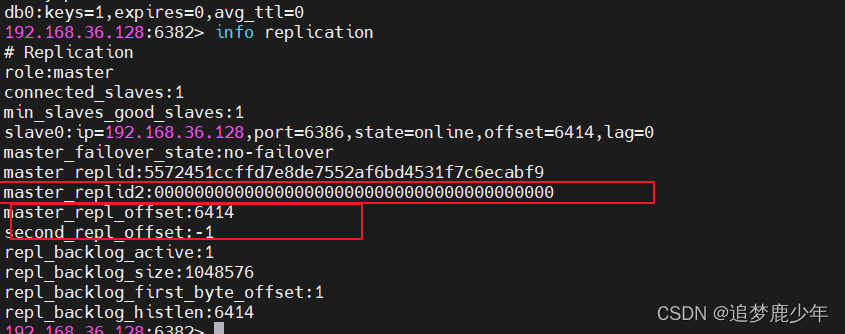

如果是这种情况的数据丢失,我们可以通过比对主从库上的复制进度差值来进行判断,也就是计算 master_repl_offset 和 slave_repl_offset 的差值。如果从库上的 slave_repl_offset 小于原主库的 master_repl_offset,那么,我们就可以认定数据丢失是由数据同步未完成导致的。

本文探讨了Redis集群中的脑裂现象,即因网络问题导致两个主节点并存,引发数据丢失。文章分析了数据丢失的原因,并提出预防脑裂的解决方案,包括设置min-slaves-to-write和min-slaves-max-lag参数。同时,讨论了集群在不完整状态下是否仍能提供服务,以及为何推荐使用奇数个master节点。

本文探讨了Redis集群中的脑裂现象,即因网络问题导致两个主节点并存,引发数据丢失。文章分析了数据丢失的原因,并提出预防脑裂的解决方案,包括设置min-slaves-to-write和min-slaves-max-lag参数。同时,讨论了集群在不完整状态下是否仍能提供服务,以及为何推荐使用奇数个master节点。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1030

1030

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?