Rehash 执行过程

字典的 rehash 操作实际上就是执行以下任务:

- 创建一个比 ht[0]->table 更大的 ht[1]->table ;

- 将 ht[0]->table 中的所有键值对迁移到 ht[1]->table ;

- 将原有 ht[0] 的数据清空,并将 ht[1] 替换为新的 ht[0] ;

经过以上步骤之后, 程序就在不改变原有键值对数据的基础上, 增大了哈希表的大小。

dict的rehash 本质就是扩容,就是将数组+链表结构中的数组扩容;

这个过程,需要开辟一个更大空间的数组,将老数组中每个非空索引的bucket,搬运到新数组;搬运完成后再释放老数组的空间。

作为例子, 以下四个小节展示了一次对哈希表进行 rehash 的完整过程。

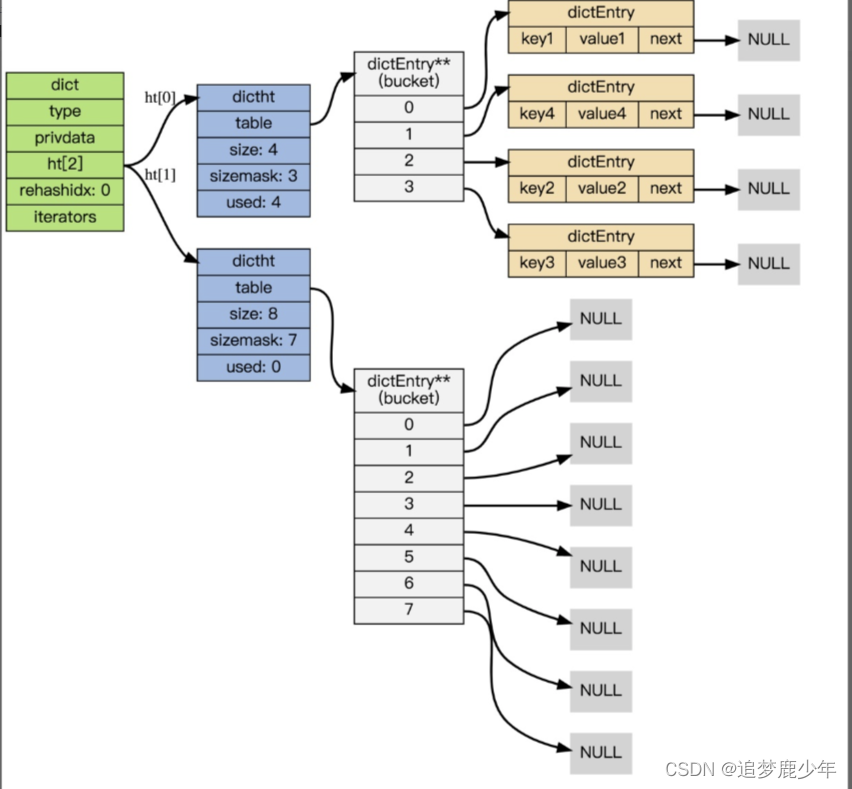

1: 开始 rehash

这个阶段有两个事情要做:

- 设置字典的 rehashidx 为 0 ,标识着 rehash 的开始;

- 为 ht[1]->table 分配空间,大小至少为 ht[0]->used 的两倍;

这时的字典是这个样子:

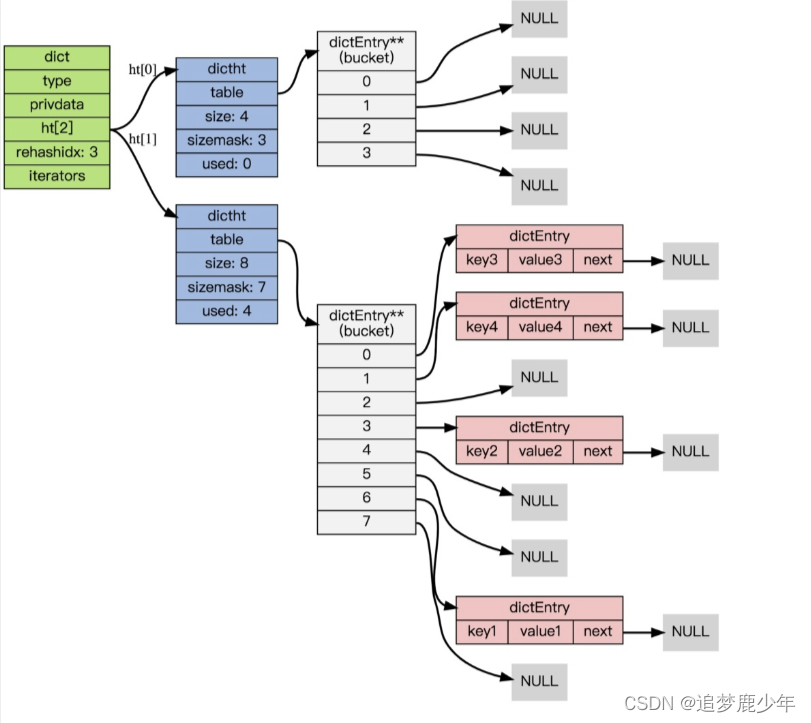

2: Rehash 进行中

在这个阶段, ht[0]->table 的节点会被逐渐迁移到 ht[1]->table , 因为 rehash 是分多次进行的(细节在下一节解释), 字典的 rehashidx 变量会记录 rehash 进行到 ht[0] 的哪个索引位置上。

注意除了节点的移动外, 字典的 rehashidx 、 ht[0]->used 和 ht[1]->used 三个属性也产生了变化。

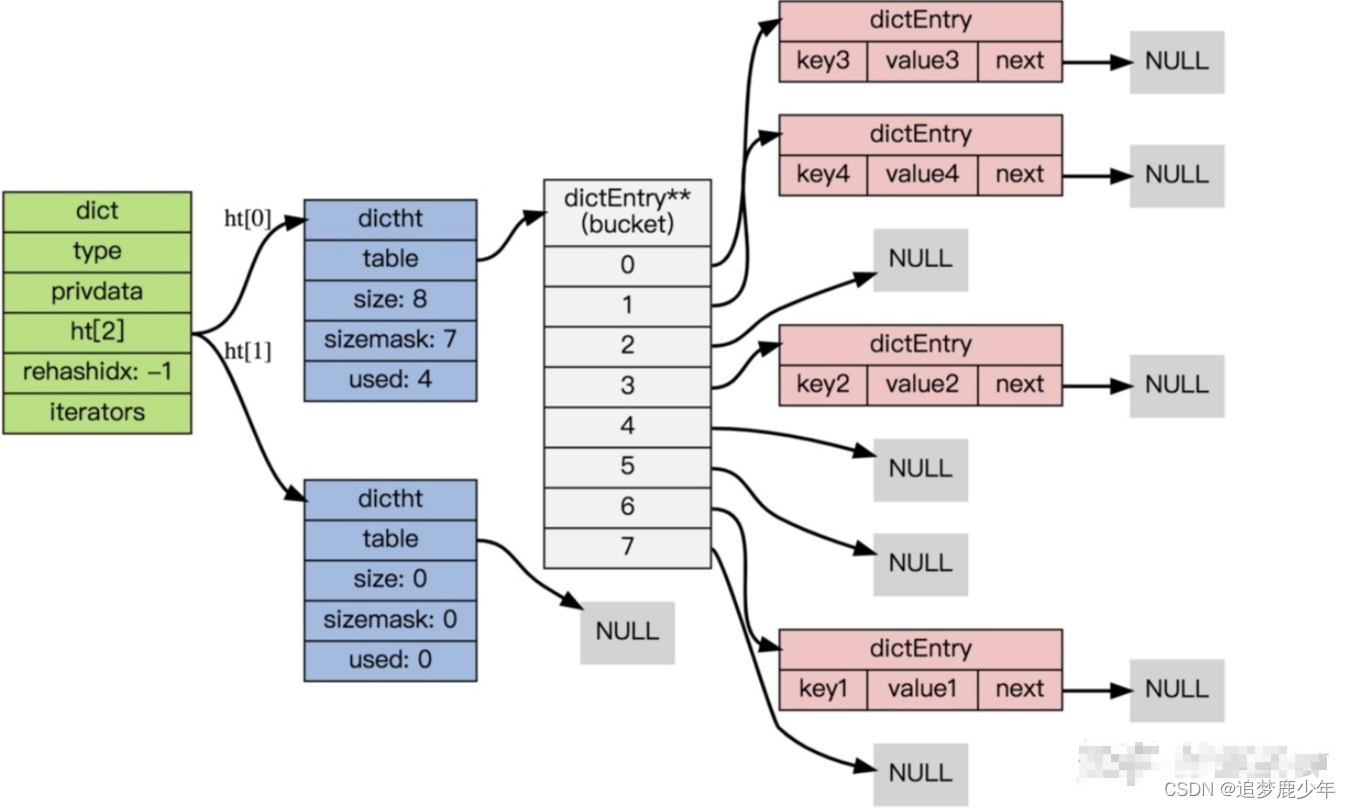

3: 节点迁移完

到了这个阶段,所有的节点都已经从 ht[0] 迁移到 ht[1] 了:

4: Rehash 完毕

在 rehash 的最后阶段,程序会执行以下工作:

- 释放 ht[0] 的空间;

- 用 ht[1] 来代替 ht[0] ,使原来的 ht[1] 成为新的 ht[0] ;

- 创建一个新的空哈希表,并将它设置为 ht[1] ;

- 将字典的 rehashidx 属性设置为 -1 ,标识 rehash 已停止;

以下是字典 rehash 完毕之后的样子:

incremental rehashing 增量/渐进式rehash

在前面我们已经了解了字典的 rehash 过程, 需要特别指出的是,rehash 并不是在触发之后,马上就执行直到完成, 而是分多次、渐进式地完成的

rehash会产生的问题

- rehash的过程,会使用两个哈希表,创建了一个更大空间的ht[1],此时会造成内存陡增;

- rehash的过程,可能涉及大量KV键值对dictEntry的搬运,耗时较长;

如果这个 rehash 过程必须将所有键值对迁移完毕之后才将结果返回给用户, 这样的处理方式将不满足Redis高效响应的特性。

rehash会产生的问题

- 主要层面就是内存占用陡增、和处理耗时长的问题

- 基于这两点,还会带来其他影响。

为了解决这些问题, Redis 使用了incremental rehashing,是一种 增量/渐进式的 rehash 方式: 通过将 rehash 分散到多个步骤中进行, 从而避免了集中式的计算/节点迁移。

dictAdd 添加键值对到dict,检查到需要进行rehash时,会将dict.rehashidx 设置为 0 ,标识着 rehash 的开始;

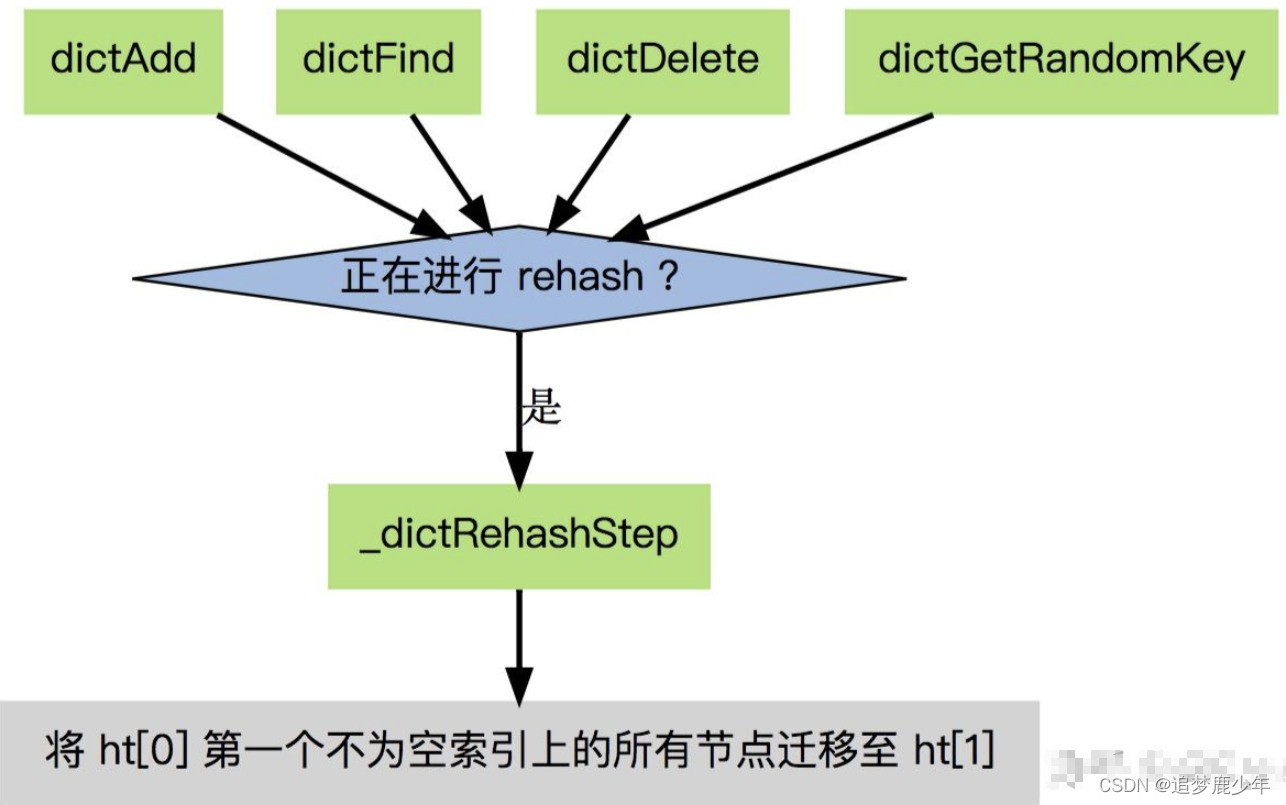

后续请求,在执行add、delete、find操作时,都会判断dict是否正在rehash,如果是,就执行_dictRehashStep()函数,进行增量rehash。

每次执行 _dictRehashStep , 会将ht[0]->table 哈希表第一个不为空的索引上的所有节点就会全部迁移到 ht[1]->table 。

也就是在某次dictAdd 添加键值对时,触发了rehash;后续add、delete、find命令在执行前都会检查

- 如果dict正在rehash,就先不急去执行自己的命令,先去帮忙搬运一个bucket;

- 搬运完一个bucket,再执行add、delete、find命令 原有处理逻辑。

实际上incremental rehashing增量/渐进式rehash,只解决了第二个:耗时长的问题,将集中式的节点迁移分摊到多步进行,ht[1]占用的双倍多内存,还一直占用。

下面我们通过dict的查找(dictFind)来看渐进式rehash过程;

dict的查找(dictFind)

dictEntry *dictFind(dict *d, const void *key)

{

dictEntry *he;

unsigned int h, idx, table;

if (d->ht[0].used + d->ht[1].used == 0) return NULL; /* dict is empty */

if (dictIsRehashing(d)) _dictRehashStep(d);// 如果哈希表在rehashing,则执行单步rehash

h = dictHashKey(d, key);

for (table = 0; table <= 1; table++) {

idx = h & d->ht[table].sizemask;

he = d->ht[table].table[idx];

while(he) {

if (key==he->key || dictCompareKeys(d, key, he->key))

return he;

he = he->next;

}

if (!dictIsRehashing(d)) return NULL;

}

return NULL;

}

上述dictFind的源码,根据dict当前是否正在rehash,依次做了这么几件事:

- 如果当前正在进行rehash,那么将rehash过程向前推进一步(即调用_dictRehashStep)。实际上,除了查找,插入和删除也都会触发这一动作。这就将rehash过程分散到各个查找、插入和删除操作中去了,而不是集中在某一个操作中一次性做完。

- 计算key的哈希值(调用dictHashKey,里面的实现会调用前面提到的hashFunction)。

先在第一个哈希表ht[0]上进行查找。在table数组上定位到哈希值对应的位置(如前所述,通过哈希值与sizemask进行按位与),然后在对应的dictEntry链表上进行查找。查找的时候需要对key进行比较,这时候调用dictCompareKeys,它里面的实现会调用到前面提到的keyCompare。如果找到就返回该项。否则,进行下一步。 - 判断当前是否在rehash,如果没有,那么在ht[0]上的查找结果就是最终结果(没找到,返回NULL)。否则,在ht[1]上进行查找(过程与上一步相同)。

下面我们有必要看一下增量式rehash的_dictRehashStep的实现。

static void _dictRehashStep(dict *d) {

if (d->iterators == 0) dictRehash(d,1);

}

/*

* Note that a rehashing step consists in moving a bucket (that may have more

* than one key as we use chaining) from the old to the new hash table, however

* since part of the hash table may be composed of empty spaces, it is not

* guaranteed that this function will rehash even a single bucket, since it

* will visit at max N*10 empty buckets in total, otherwise the amount of

* work it does would be unbound and the function may block for a long time.

*/

int dictRehash(dict *d, int n) {

int empty_visits = n*10; /* Max number of empty buckets to visit. */

if (!dictIsRehashing(d)) return 0;

while(n-- && d->ht[0].used != 0) {

dictEntry *de, *nextde;

/* Note that rehashidx can't overflow as we are sure there are more

* elements because ht[0].used != 0 */

assert(d->ht[0].size > (unsigned long)d->rehashidx);

while(d->ht[0].table[d->rehashidx] == NULL) {

d->rehashidx++;

if (--empty_visits == 0) return 1;

}

de = d->ht[0].table[d->rehashidx];

/* Move all the keys in this bucket from the old to the new hash HT */

while(de) {

unsigned int h;

nextde = de->next;

/* Get the index in the new hash table */

h = dictHashKey(d, de->key) & d->ht[1].sizemask;

de->next = d->ht[1].table[h];

d->ht[1].table[h] = de;

d->ht[0].used--;

d->ht[1].used++;

de = nextde;

}

d->ht[0].table[d->rehashidx] = NULL;

d->rehashidx++;

}

/* Check if we already rehashed the whole table... */

if (d->ht[0].used == 0) {

zfree(d->ht[0].table);

d->ht[0] = d->ht[1];

_dictReset(&d->ht[1]);

d->rehashidx = -1;

return 0;

}

/* More to rehash... */

return 1;

}

根据dictRehash函数的注释,rehash的单位是bucket,也就是从老哈希表dictht中找到第一个非空的下标,要把该下标整个链表搬运到新数组。

如果遍历老数组,访问的 前N*10 个都是空bucket,则不再继续往下寻找。

dictAdd、dictDelete、dictFind在rehash过程中的特殊性

在哈希表进行 rehash 时, 字典还会采取一些特别的措施, 确保 rehash 顺利、正确地进行:

- 因为在 rehash 时,字典会同时使用两个哈希表,所以在这期间的所有查找dictFind、删除dictDelete等操作,除了在 ht[0] 上进行,还需要在 ht[1] 上进行。

- 在执行添加操作dictAdd时,新的节点会直接添加到 ht[1] 而不是 ht[0] ,这样保证 ht[0] 的节点数量在整个 rehash 过程中都只减不增。

dict的缩容

上面关于 rehash 的章节描述了通过 rehash 对字典进行扩展(expand)的情况, 如果哈希表的可用节点数比已用节点数大很多的话, 那么也可以通过对哈希表进行 rehash 来收缩(shrink)字典。

收缩 rehash 和上面展示的扩展 rehash 的操作几乎一样,执行以下步骤:

- 创建一个比 ht[0]->table 小的 ht[1]->table ;

- 将 ht[0]->table 中的所有键值对迁移到 ht[1]->table ;

- 将原有 ht[0] 的数据清空,并将 ht[1] 替换为新的 ht[0] ;

Redis的dict最显著的一个特点,就在于它的rehash。它采用了一种称为增量式(incremental rehashing)的rehash方法,在需要扩容时避免一次性对所有key进行rehash,而是将rehash操作分散到对于dict的各个增删改查的操作中去。

这种方法能做到每次只对一小部分key进行rehash,而每次rehash之间不影响dict的操作。dict之所以这样设计,是为了避免rehash期间单个请求的响应时间剧烈增加,这与前面提到的“快速响应时间”的设计原则是相符的。

- Redis的dict也是使用数组+链表实现;

- 当冲突增加、链表增长,也是采用rehash(数组扩容)来将链表变短;

- dict数组扩容,也是按2的指数次幂,使用位运算,替代求余操作,计算更快;

- 渐进式rehash,其实是辅助式的;不是让触发rehash的一个人搬运完所有dictEntry,而是让后来者一起参与搬运。

Redis在哈希表扩容时采用增量式Rehash策略,避免一次性迁移所有键值对,将rehash分散到多个操作中进行,以减少响应时间并平滑内存占用。在rehash过程中,新添加的元素直接进入新哈希表,查找、删除等操作同时在两个表上执行,确保数据一致性。

Redis在哈希表扩容时采用增量式Rehash策略,避免一次性迁移所有键值对,将rehash分散到多个操作中进行,以减少响应时间并平滑内存占用。在rehash过程中,新添加的元素直接进入新哈希表,查找、删除等操作同时在两个表上执行,确保数据一致性。

1520

1520

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?