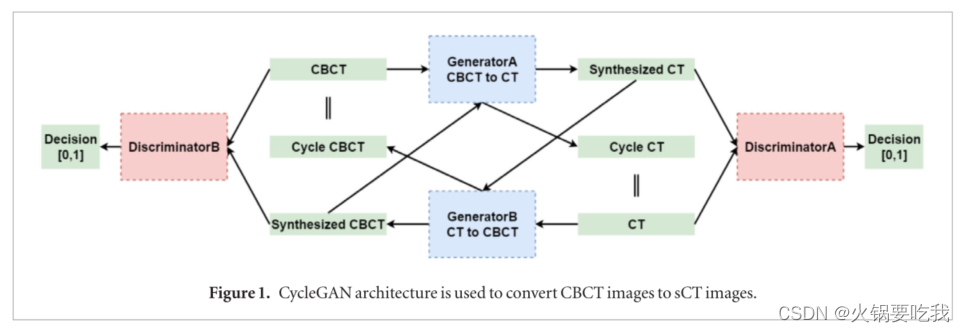

一、利用CycleGAN完成CBCT到CT的转换

LIANG, XIAO, CHEN, LIYUAN, DAN NGUYEN, et al. Generating synthesized computed tomography (CT) from cone-beam computed tomography (CBCT) using CycleGAN for adaptive radiation therapy[J]. Physics in medicine and biology.,2019,64(12):125002. DOI:10.1088/1361-6560/ab22f9.

目的:基于锥形束CT图像合成CT图像,并保留重要的解剖结构

生成器:典型的UNet结构

判别器:PatchGAN

实验结果:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1529

1529

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?