背景:

文笔不够,技术来凑。其实应该配合爬虫,把文章爬到本地,再批量分析,效果会更好。但是代理ip要钱,之前免费站点没了。所以先做了一个简陋版。

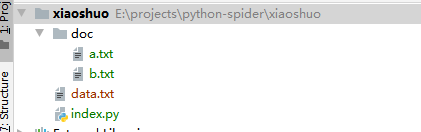

目录结构:

代码:

import re

import copy

import os

# ================================ 变量 ============================================

"""

公共变量

"""

#文件夹目录

path = "./doc"

#得到文件夹下的所有文件名称

files= os.listdir(path)

#key(按下面的分组,对应的关键字去收集)

keyList = [

['眼','眸','瞳','眼底'],

['嘴','唇'],

['眉'],

['脸颊']

]

#变量存储

# eye = []

# mouth = []

result =[];

resultList = [[] for i in range(len(keyList))];

# ================================ 函数 ============================================

"""

返回删除所有空值后的arr

"""

def get_real_arr(arr):

arr_copy = copy.deepcopy(arr)

arr_copy = list(filter(None, arr_copy))

while '' in arr_copy:

arr_copy.remove('')

return arr_copy

"""

遍历文件,过滤字符

"""

本文介绍了一个使用Python实现的小说素材收集器。虽然没有利用爬虫和代理IP,但仍然提供了一种简陋但实用的方法来收集小说素材。通过分析和处理,可以提升小说创作的效率。

本文介绍了一个使用Python实现的小说素材收集器。虽然没有利用爬虫和代理IP,但仍然提供了一种简陋但实用的方法来收集小说素材。通过分析和处理,可以提升小说创作的效率。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

690

690

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?