1.写在前面

本来工作后比较懒,很久不写博客了,因为实习小同学时不时问到一些问题,网上的资料比较分散、不够通俗透彻,决定重新开启这个系列,本周更新下word2vec和bert,为了通俗可能不严谨,但是大面上应该没啥问题,注意目的是为了意会,细节的去看论文和github,依然是抛砖引玉。

对于新的机器学习模型,大家可以按照这个思路去快速熟悉:

1.这模型干啥用的,最终产出个啥;

2. input是怎么处理为模型输入需要的,比如切词or 构建token,token级别embedding,position的embedding等;

3. 已经处理好的输入数据在模型中的flow,最后output是啥,中间维度是怎么变化的;

4. Loss Function是怎么构建的;

5. 训练的复杂度大概是什么级别,串行还是并行(LSTM、CNN),作者做了哪些改进

6. 作者的一些trick和想法

2.word2vec得到了啥

word2vec训练后得到一个词表,有词汇的分布式向量表示。

词汇可以是一个英文单词、一个汉字或者一个词语、一个token等,这取决于你的训练集制作,得到的向量是一个稠密向量。

与之相对的是稀疏的one-hot表示,我在这个博客文本分类+机器学习浅谈?里举过例子。

-

这种稠密向量表达有什么好处

答:信息量更大,假设20w大小的词典one-hot表示"梨子"为[0,0,1,0,0,…0],表示"苹果"为[0,0,0,0,1,0,…,0],你能得到的信息只是"梨子"在词典中是第3个词汇,"苹果"这个词是第5个,仅此而已,所以你用这两个向量计算余弦相似度会发现为0,计算欧式距离也毫无意义(词典的位置变化,距离也会变化)。而word2vec得到稠密向量后,"梨子"和"苹果"的vector就会表现出相似度高,而"梨子"和"汽车"就会表现出相似度低,符合我们的认知。

也就是说,这种稠密向量带来了先验知识,"梨子"的vector可能包含水果、很甜、可以吃、手掌大小等信息。 -

向量里包含的先验知识哪里来的?

答:word2vec训练时学习到的,你给模型吃了这么多语料,就跟小时候你语文老师天天给你看书一样,总能学点东西进去吧。

3.word2vec咋训练

“无监督语料,有监督训练”

无监督语料:比如使用人民日报、中小学课文、百度百科、维基百科的文本。

有监督训练:制作训练集,比如输入为某个词上下文的词汇,label为该词,举个例子,拿朱自清的《背影》作为语料制作训练集,“我与父亲不相见已二年余了,我最不能忘记的是他的背影 …”,data1:(“我”,“父亲”)->“与”;data2(“与”,“不”) ->“父亲”…

(这里切词、做词表什么的就太基础不说了哈。)

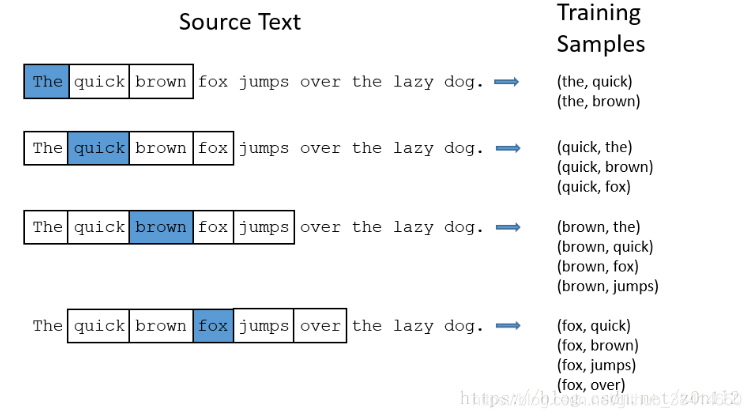

有两种制作训练集的思路,一种是上下文预测中间词,一种是中间词预测上下文,分别叫cbow和skip-gram。

下面以skip-gram为例说说这两个思路模型是如何前向传播和反向计算的。

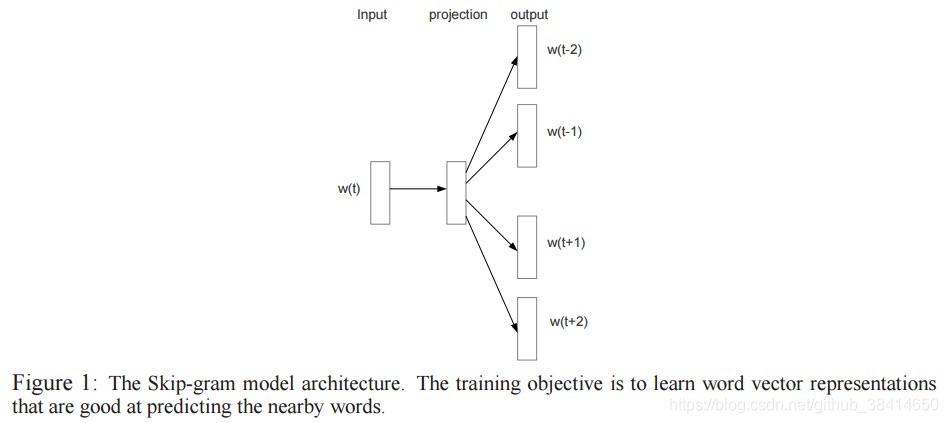

skip-gram

按上图的样子结合朱自清语料,某条data应该张这样:input:“父亲”,右边的label为:“我”,“与”,“不”,"相见"4个词

当然你也可以将上述data拆开为4条data去训练:input:“父亲”,label:“我”;input:“父亲”,label:“与”,…类似下图,原理上区别不大。

在构造词表的时候假设有2w个词,每个词的向量维度为128维度,随机初始化,通过上述训练集来优化这2w个向量,即word2vec。

怎么优化的:

上图中input->projection,取那个词表里取出对应词"父亲"的128维向量,projection->output层,就是一个128 * 20000全连接层,经过全连接层+softmax后得到一个1 * 20000维度的向量,与此同时,“我”,“与”,“不”,"相见"4个词同样可以按照词表表示为一个1 * 20000维度向量,比如[0,0,1,0,1,0,1,0,0,…,0,1,0],即这4个词在词表的one-hot表示。

对两个1 x 20000的向量做交叉熵loss

最小化loss,反向传播,优化词"父亲"的128维向量

恩,cbow同理

4.word2vec训练复杂度

接着看上文,以skip-gram为例,主要计算量在那个全连接层,计算量为20000 * 128,也就是词表大小N * 向量维度H,反向传播再来一遍;假如训练集制作了M条data,迭代K次,粗鲁的一算,训练计算量就是2 * N * H * M * K

如何减少训练时的计算量呢,从后面的全连接入手

-

NEGATIVE SAMPLING,每次使用和更新全连接参数的一部分

1)以skip-gram为例,上述前向传播时经过全连接层最终生成了一个1 * 20000维度的向量,对应其中4个正样本,19996个负样本,那么如果负样本不用全体的,而是随机抽样S个比如20个,那么那个全连接层就会变为128*(20+4)。或者理解为对于那个全连接层的权重,每次只更新 负样本数S+正样本数4 列,其他的不参与计算。

2)有人使用了很多高大上的方法来采样,比如什么gibt采样啊,不能是周围的词啊,等等,最终速度比NEGATIVE SAMPLING慢,效果没有任何区别。

3)怎么随机选的,论文中有公式。

4)简单粗暴,效果不错。 -

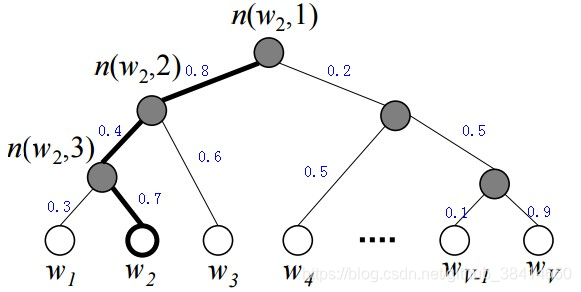

Hierarchical Softmax,不全连接了

1)用上图代替projection->output层的全连接+softmax层,这个树的叶子节点为词表中的词,非叶子节点是一个H维向量,向左的概率为projection的向量与该节点的向量点积+sigmoid。

2)举个例子,仍然对于上述样本input:“父亲”,label:“我”,假设"我"对应的上图的w2,那么"父亲"这个H维向量先与第一个黑色节点H维向量相乘+sigmoid,得到往左的概率为p1,同样第二个黑色节点往左的概率p2,第三个黑色节点往右的概率1-p3,于是到达w2的概率为p1 * p2 * (1-p3)。

3)于是loss为log(p1 * p2 * (1-p3)),反向传播更新黑色节点向量以及projection的向量。

4)这棵树怎么建:随机二叉树或者哈弗曼树?

NEGATIVE SAMPLING这个优化,整体上复杂度降低约为原来的(负样本数S+正样本数)/词表大小N;Hierarchical Softmax这个优化降低为log(2,V)

5.word2vec的其他

- Subsampling frequent words

Word2Vec中使用一个公式得到保留一个词的概率,概率性删除高频词。

1)剔除单词来 dilutes (稀疏的意思) 高频单词. subsampling 在创建 windows 之前执行,比如 The dog is chasing a ball, context window size=2时, 在挖掉高频词汇 the, is, a 后, ball 就在 dog 的 context 中了)

2)不仅仅降低计算需求(弱意义的data少了),对最后词向量的质量提高也有所帮助(留下的大多是有意义的词) - Word Pairs and “Phrases”

字面意思就没错,词组。

论文作者指出类似”Boston Globe”(一份报纸的名字)的词组和”Boston”,”Globe”两个单独的词含义有很大区别, 所以可以把”Boston Globe”当作一个词处理。

论文中的”Learning Phrases”节介绍了词组检测。

行了,就先这样,图是之前收藏的博客上摘下来的,有些本来直观的说明自己懒得写的也复制了点,作者有意见找我哈。

参考:

1.https://blog.youkuaiyun.com/z0n1l2/article/details/81035244

2.https://yq.aliyun.com/articles/64423?spm=5176.100239.blogcont64424.13.PKOeiK

3.http://kissg.me/2017/12/25/word_embeddings_0to1/

本文深入浅出地介绍了word2vec模型的工作原理,包括其训练过程、优化技巧以及如何获得高质量的词向量。同时探讨了word2vec在自然语言处理任务中的应用价值。

本文深入浅出地介绍了word2vec模型的工作原理,包括其训练过程、优化技巧以及如何获得高质量的词向量。同时探讨了word2vec在自然语言处理任务中的应用价值。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?