文档参考Tutorial/docs/L1/Evaluation at camp4 · InternLM/Tutorial (github.com)

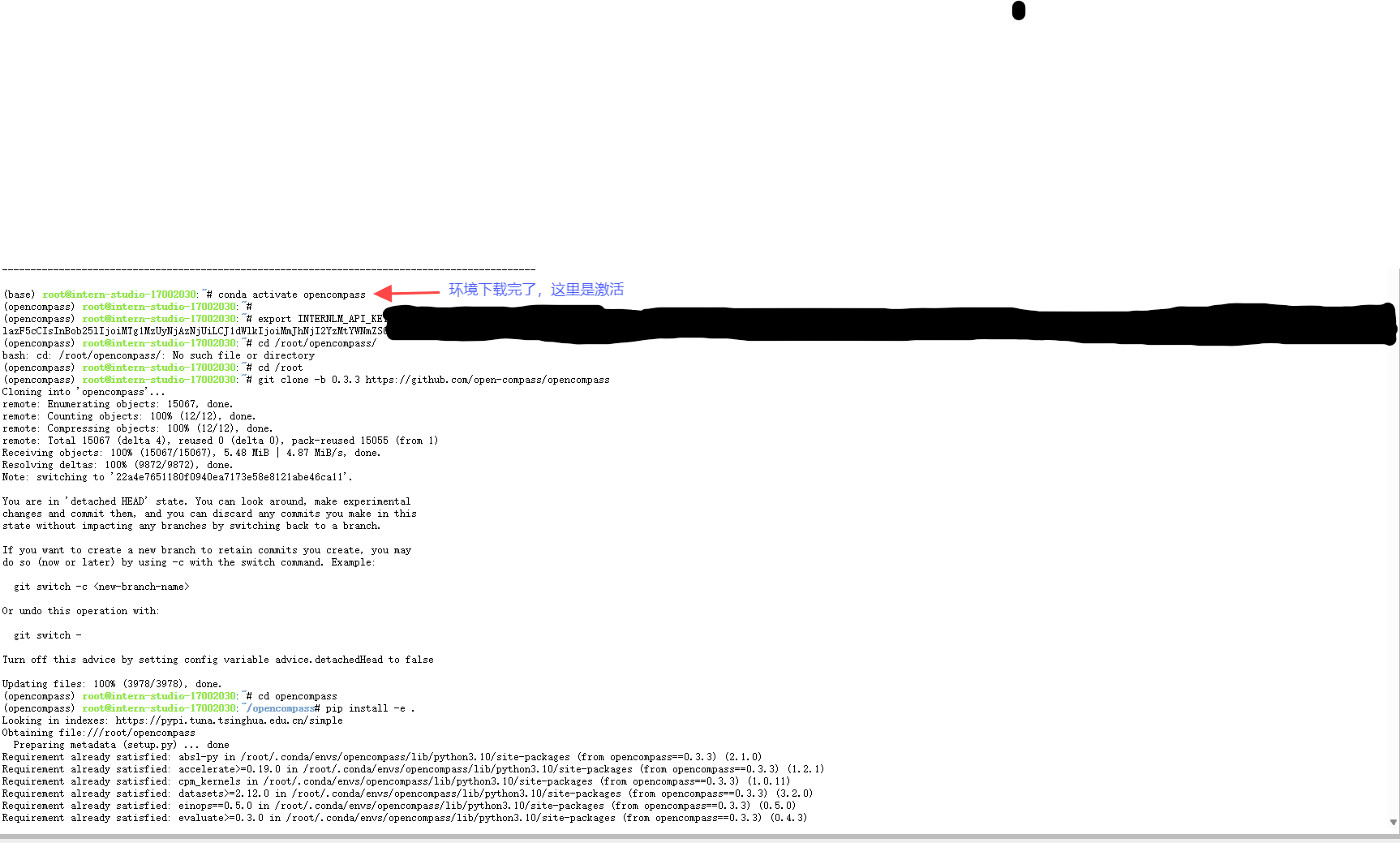

首先在训练营提供的开发机上创建用于评测 conda 环境:

conda create -n opencompass python=3.10

conda activate opencompass

cd /root

git clone -b 0.3.3 https://github.com/open-compass/opencompass

cd opencompass

pip install -e .

pip install huggingface_hub==0.25.2

pip install importlib-metadata

评测 API 模型

-

获取 API 密钥:在 OpenAI 官网申请一个 API Key。

-

配置评测框架:在评测配置文件中设置 API Key 和相关的模型参数。

-

发送测试用例:评测框架自动向模型服务发送测试用例。

-

获取模型回复:模型服务返回回复,评测框架进行打分分析。

-

确保网络连接正常:确保网络连接顺畅,无需担心本地计算资源或模型文件。

此处以internlm 模型为例

export INTERNLM_API_KEY=xxxxxxxxxxxxxxxxxxxxxxx # 填入你申请的 API Key- 配置模型: 在终端中运行

cd /root/opencompass/和touch opencompass/configs/models/openai/puyu_api.py, 然后打开文件, 贴入以下代码:

import os

from opencompass.models import OpenAISDK

internlm_url = 'https://internlm-chat.intern-ai.org.cn/puyu/api/v1/' # 你前面获得的 api 服务地址

internlm_api_key = os.getenv('INTERNLM_API_KEY')

models = [

dict(

# abbr='internlm2.5-latest',

type=OpenAISDK,

path='internlm2.5-latest', # 请求服务时的 model name

# 换成自己申请的APIkey

key=internlm_api_key, # API key

openai_api_base=internlm_url, # 服务地址

rpm_verbose=True, # 是否打印请求速率

query_per_second=0.16, # 服务请求速率

max_out_len=1024, # 最大输出长度

max_seq_len=4096, # 最大输入长度

temperature=0.01, # 生成温度

batch_size=1, # 批处理大小

retry=3, # 重试次数

)

]- 配置数据集: 在终端中运行

cd /root/opencompass/和touch opencompass/configs/datasets/demo/demo_cmmlu_chat_gen.py, 然后打开文件, 贴入以下代码:

from mmengine import read_base

with read_base():

from ..cmmlu.cmmlu_gen_c13365 import cmmlu_datasets

# 每个数据集只取前2个样本进行评测

for d in cmmlu_datasets:

d['abbr'] = 'demo_' + d['abbr']

d['reader_cfg']['test_range'] = '[0:1]' # 这里每个数据集只取1个样本, 方便快速评测.

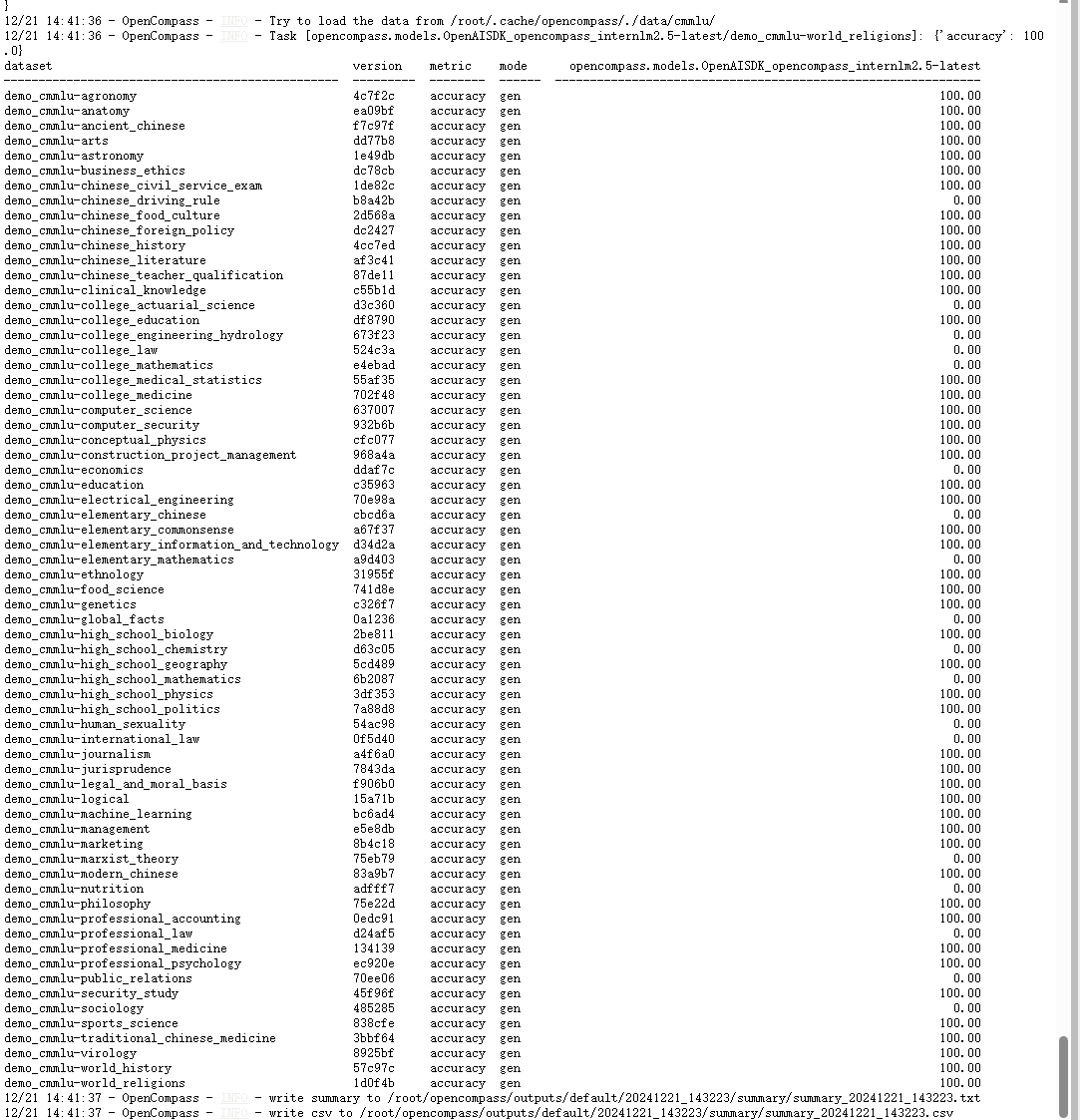

这样我们使用了 CMMLU Benchmark 的每个子数据集的 1 个样本进行评测.

完成配置后, 在终端中运行: python run.py --models puyu_api.py --datasets demo_cmmlu_chat_gen.py --debug. 预计运行10分钟后, 得到结果:

评测本地模型

-

获取模型权重文件:从 Hugging Face 等平台下载完整的开源模型文件。</

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1538

1538

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?