一、Nginx 高并发核心原理

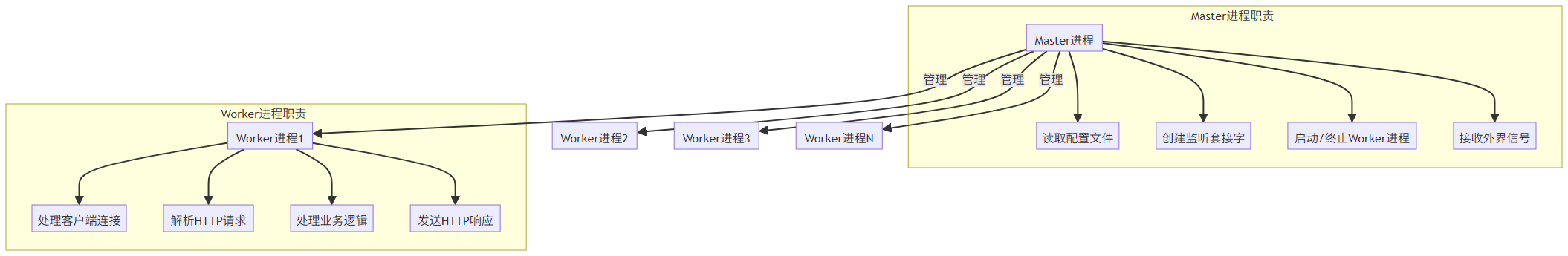

1.1 架构模型:多进程事件驱动

Nginx 采用master-worker 进程模型,通过事件驱动机制实现高并发处理,其架构如图所示:

核心特点:

- 进程隔离:Worker 进程独立运行,单个 Worker 故障不影响整体服务

- 多核利用:Worker 进程数通常等于 CPU 核心数,充分利用多核资源

- 事件驱动:每个 Worker 通过 epoll/kqueue 等机制高效处理数千并发连接

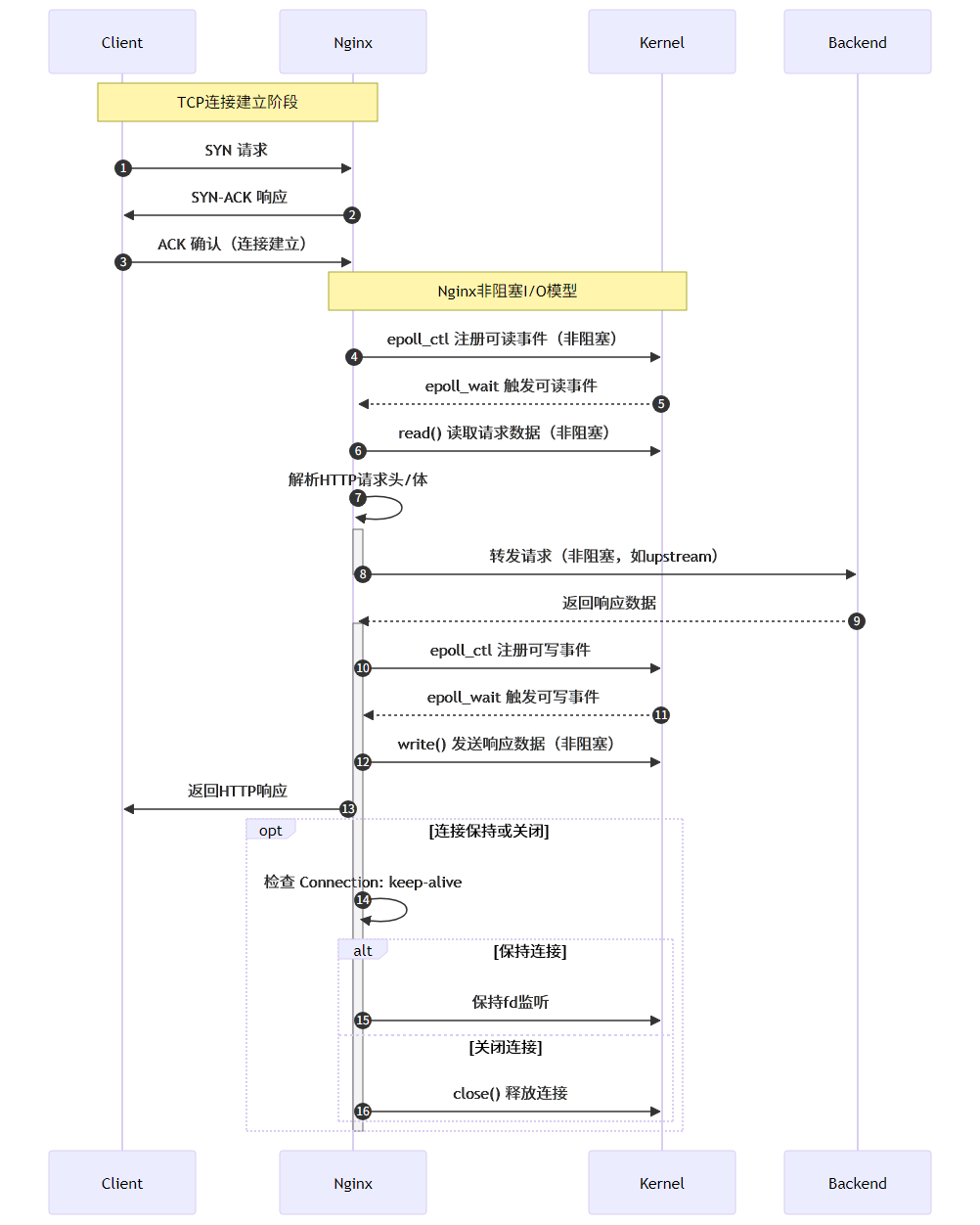

1.2 事件驱动模型:异步非阻塞 IO

Nginx 的高并发能力源于其异步非阻塞 IO 模型,核心是通过事件驱动机制处理连接,而非为每个连接创建线程:

关键技术:

- epoll 机制(Linux):高效的 IO 事件通知机制,支持水平触发和边缘触发

- 事件多路复用:单个 Worker 进程可同时监控数千个连接的 IO 状态

- 非阻塞操作:IO 操作不阻塞进程,等待期间可处理其他连接

1.3 性能优势:为何 Nginx 比 Apache 更快?

Nginx 与传统 Web 服务器(如 Apache)的性能差异主要源于架构设计:

|

特性 |

Nginx |

Apache(prefork 模式) |

|

并发模型 |

事件驱动(单线程多连接) |

多进程模型(一个连接一个进程) |

|

内存占用 |

低(约 2-10MB/Worker) |

高(约 20-30MB / 进程) |

|

最大并发连接 |

理论无上限(受系统限制) |

数千(受内存限制) |

|

静态资源处理 |

零拷贝(sendfile) |

常规文件 IO |

|

上下文切换开销 |

极低 |

高 |

|

适用场景 |

高并发 Web 服务、反向代理 |

动态内容较多的中小型网站 |

性能测试数据:在相同硬件条件下(4 核 8GB 服务器),Nginx 可支持 10 万 + 并发连接,而 Apache 通常在 1 万连接时出现性能瓶颈。

二、Nginx 核心配置与性能优化

2.1 基础性能配置

Nginx 的性能很大程度上取决于配置参数,以下是基础性能优化配置:

# 主配置段

worker_processes auto; # 自动设置为CPU核心数

worker_cpu_affinity auto; # 自动绑定CPU核心

# 事件模块配置

events {

worker_connections 10240; # 每个Worker最大连接数

use epoll; # 使用epoll事件模型

multi_accept on; # 一次接受所有新连接

worker_aio_requests 1024; # AIO请求数量

}

# HTTP核心配置

http {

# 连接管理

keepalive_timeout 65; # 长连接超时时间

keepalive_requests 100; # 单个长连接最大请求数

tcp_nopush on; # 发送数据时合并包

tcp_nodelay on; # 小数据包不延迟发送

# 高效文件传输

sendfile on; # 启用零拷贝

aio on; # 启用异步IO

directio 1024m; # 大文件直接IO

# 缓冲区配置

client_body_buffer_size 10K;

client_header_buffer_size 1k;

large_client_header_buffers 4 4k;

# 打开文件缓存

open_file_cache max=10000 inactive=20s;

open_file_cache_valid 30s;

open_file_cache_min_uses 2;

}

2.2 性能参数调优指南

针对不同场景,需调整关键参数以达到最佳性能:

|

参数 |

作用 |

调优建议 |

|

worker_processes |

Worker 进程数量 |

设为 CPU 核心数(auto自动适配) |

|

worker_connections |

单个 Worker 最大连接数 |

结合系统ulimit设置,建议 10240-65535 |

|

keepalive_timeout |

长连接超时时间 |

静态资源服务:15-30 秒;API 服务:60-120 秒 |

|

worker_rlimit_nofile |

进程最大文件句柄数 |

设为worker_connections的 2-3 倍 |

|

sendfile |

启用零拷贝传输 |

静态文件服务必须开启,动态代理可关闭 |

|

client_body_buffer_size |

请求体缓冲区大小 |

小请求(如 API)设为 16k;大文件上传设为 1m |

系统级优化(需配合 Nginx 配置):

# 提高文件描述符限制

echo "nginx soft nofile 65535" >> /etc/security/limits.conf

echo "nginx hard nofile 65535" >> /etc/security/limits.conf

# 调整TCP参数

cat >> /etc/sysctl.conf << EOF

net.core.somaxconn = 65535

net.ipv4.tcp_max_tw_buckets = 10000

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_fin_timeout = 10

EOF

sysctl -p

2.3 静态资源优化配置

Nginx 处理静态资源(HTML/CSS/JS/ 图片)的效率远超 Apache,关键优化配置如下:

server {

listen 80;

server_name static.example.com;

root /var/www/static;

# 启用gzip压缩

gzip on;

gzip_comp_level 5; # 压缩级别(1-9)

gzip_types text/plain text/css application/javascript image/svg+xml;

gzip_vary on; # 告知客户端使用压缩

# 浏览器缓存设置

location ~* \.(jpg|jpeg|png|gif|ico|css|js)$ {

expires 30d; # 缓存30天

add_header Cache-Control "public, max-age=2592000";

access_log off; # 不记录静态资源日志

}

# 图片处理(需nginx-image-filter模块)

location ~* \.(jpg|png)$ {

image_filter resize 800 -; # 限制最大宽度为800px

image_filter_jpeg_quality 80; # JPG质量80%

}

}

优化效果:

- 静态资源响应时间从 50ms 降至 5ms 以内

- 带宽消耗减少 60% 以上(gzip 压缩 + 图片优化)

- 服务器负载降低 50%(缓存 + 关闭日志)

三、负载均衡架构设计

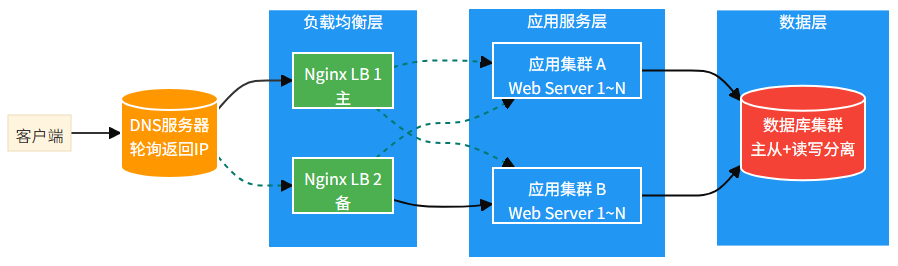

3.1 负载均衡基础架构

Nginx 作为反向代理服务器,可实现后端服务器的负载均衡,核心架构如下:

核心作用:

- 流量分发:将客户端请求均匀分配到后端服务器

- 高可用:自动剔除故障服务器,保障服务连续性

- 扩展性:通过增加后端服务器轻松扩展系统容量

3.2 负载均衡算法与配置

Nginx 支持多种负载均衡算法,适用于不同业务场景:

# 定义后端服务器集群

upstream backend_servers {

# 1. 轮询(默认):按顺序分配请求

# server 192.168.1.101:8080;

# server 192.168.1.102:8080;

# 2. 加权轮询:性能高的服务器分配更多请求

server 192.168.1.101:8080 weight=5; # 50%请求

server 192.168.1.102:8080 weight=3; # 30%请求

server 192.168.1.103:8080 weight=2; # 20%请求

# 3. IP哈希:同一IP请求固定到同一服务器(会话保持)

# ip_hash;

# 4. 最少连接:请求分配给连接数最少的服务器

# least_conn;

# 5. 健康检查配置

keepalive 32; # 保持32个长连接到后端

max_fails 3; # 3次失败标记为不可用

fail_timeout 30s; # 30秒后重试

}

# 负载均衡配置

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://backend_servers;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

# 故障转移配置

proxy_next_upstream error timeout http_500 http_502 http_503;

}

}

算法选择建议:

- 无状态服务(如 API):加权轮询或最少连接

- 有状态服务(如用户会话):IP 哈希或会话共享

- 异构服务器集群:加权轮询(按性能分配权重)

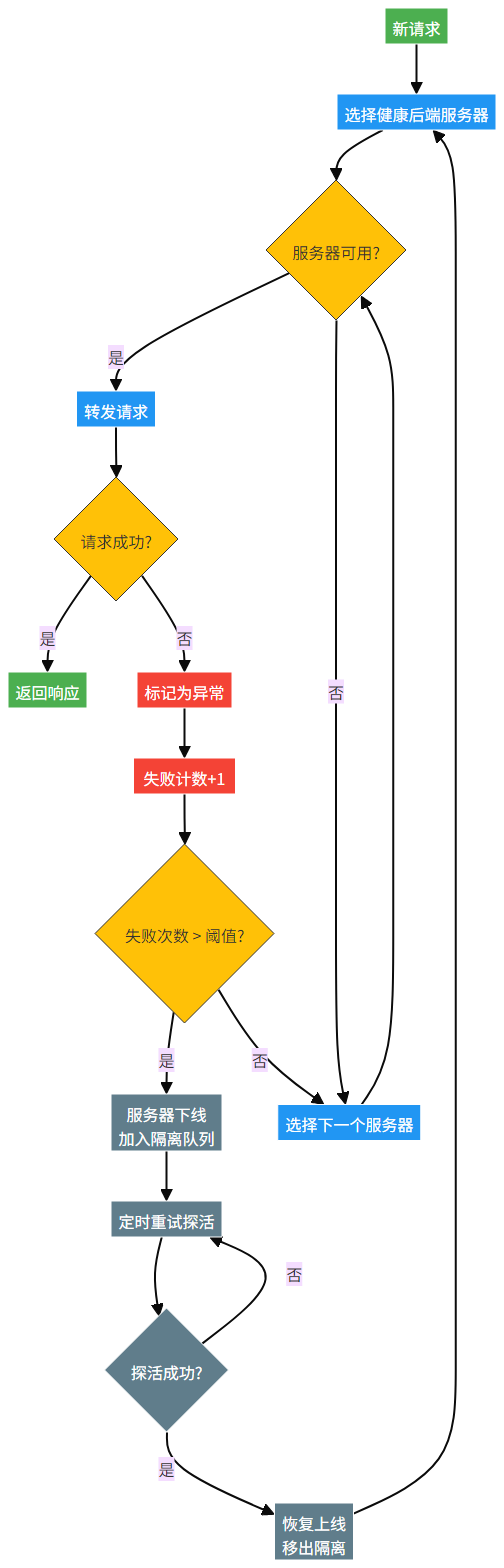

3.3 健康检查与故障转移

Nginx 通过被动健康检查机制识别故障服务器,并自动实现故障转移:

关键配置参数:

- max_fails:失败次数阈值(默认 1 次)

- fail_timeout:失败后重试时间(默认 10 秒)

- proxy_next_upstream:触发故障转移的条件(错误 / 超时 / 5xx 状态码)

四、高可用架构设计

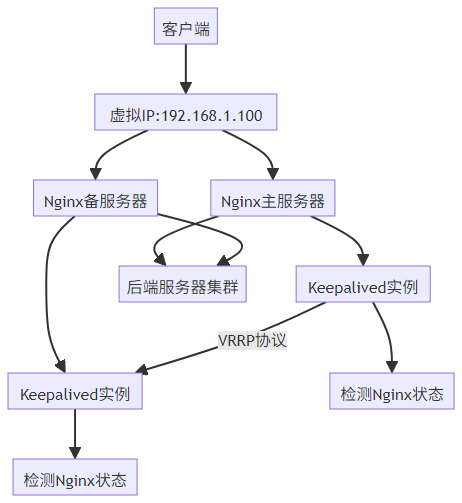

4.1 双机热备:Keepalived+Nginx

为避免 Nginx 单点故障,生产环境通常采用双机热备架构,通过 Keepalived 实现虚拟 IP(VIP)漂移:

配置示例:

# Keepalived配置(主服务器)

vrrp_instance VI_1 {

state MASTER

interface eth0

virtual_router_id 51

priority 100 # 主服务器优先级更高

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.1.100

}

# 监控Nginx状态

track_script {

check_nginx

}

}

vrrp_script check_nginx {

script "/etc/keepalived/check_nginx.sh"

interval 2 # 每2秒检查一次

weight -20 # 检查失败优先级减20

}

故障转移流程:

- 主服务器 Nginx 故障,Keepalived 检测到异常

- 主服务器优先级降低,低于备服务器

- 备服务器接管虚拟 IP(VIP)

- 客户端请求自动路由到备服务器

- 主服务器恢复后,自动夺回 VIP(主备模式)或保持备机状态(双主模式)

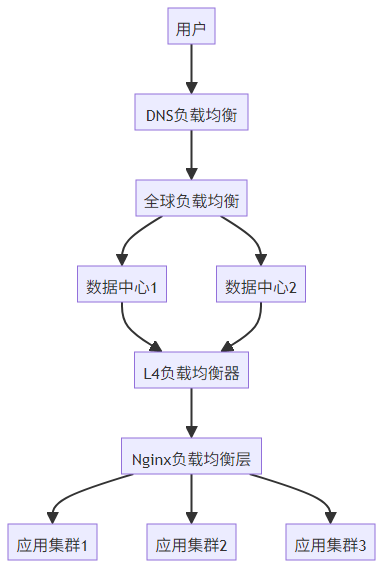

4.2 多级负载均衡架构

大型系统通常采用多级负载均衡架构,结合 DNS、L4(TCP)和 L7(HTTP)负载均衡:

各级负载均衡作用:

- DNS 负载均衡:基于地理位置分配到最近的数据中心

- GSLB:实现跨数据中心的容灾与负载分担

- L4 负载均衡:基于 IP + 端口的四层转发(如 F5/HAProxy)

- L7 负载均衡:基于 URL/Host 的七层转发(Nginx)

4.3 限流与熔断机制

高并发场景下,需通过限流与熔断机制保护系统,避免被流量击垮:

# 限流配置

http {

# 定义限流区域(按IP)

limit_req_zone $binary_remote_addr zone=api_limit:10m rate=100r/s;

# 定义连接数限制

limit_conn_zone $binary_remote_addr zone=per_ip:10m;

server {

listen 80;

server_name api.example.com;

# API接口限流

location /api/ {

limit_req zone=api_limit burst=20 nodelay; # 允许20个突发请求

limit_conn per_ip 10; # 每个IP最多10个连接

proxy_pass http://api_servers;

}

# 登录接口特殊限流

location /api/login {

limit_req zone=login_limit rate=10r/s; # 更严格的限制

proxy_pass http://api_servers;

}

}

}

限流算法对比:

- 漏桶算法:limit_req,控制请求速率,平滑流量

- 令牌桶算法:burst参数,允许一定突发流量

- 连接数限制:limit_conn,限制并发连接数

五、安全防护与性能监控

5.1 安全加固配置

Nginx 安全加固需从多个维度入手,防止常见攻击:

# 基础安全配置

server {

# 隐藏版本信息

server_tokens off;

# HTTP响应头安全设置

add_header X-Frame-Options "SAMEORIGIN"; # 防止点击劫持

add_header X-XSS-Protection "1; mode=block"; # 防XSS攻击

add_header X-Content-Type-Options "nosniff"; # 防止MIME类型嗅探

add_header Content-Security-Policy "default-src 'self'; script-src 'self'";

# HTTPS配置(必须)

listen 443 ssl;

ssl_certificate /etc/nginx/ssl/example.com.crt;

ssl_certificate_key /etc/nginx/ssl/example.com.key;

ssl_protocols TLSv1.2 TLSv1.3; # 仅支持安全的TLS版本

ssl_ciphers ECDHE-ECDSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-GCM-SHA256;

ssl_prefer_server_ciphers on;

# 限制请求方法

if ($request_method !~ ^(GET|POST|HEAD)$) {

return 405;

}

# 防CC攻击

location / {

# 5秒内超过10次请求的IP临时封禁

limit_req zone=cc_limit burst=5 nodelay;

proxy_pass http://backend;

}

}

关键安全措施:

- 强制 HTTPS,禁用不安全的 TLS 协议

- 设置安全响应头,防御 XSS/CSRF/ 点击劫持

- 限制请求频率和方法,防止 CC 攻击

- 隐藏服务器版本信息,减少攻击面

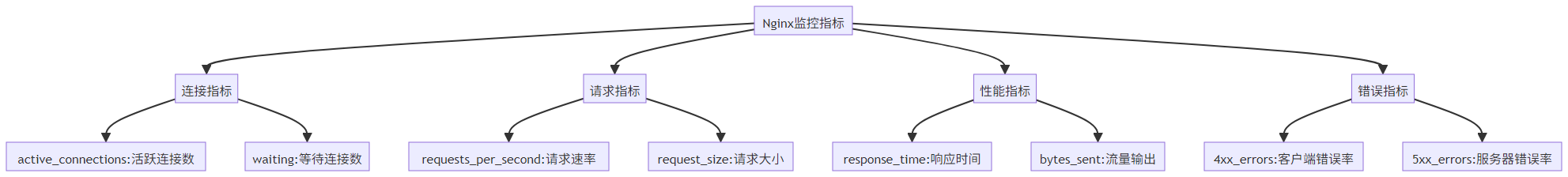

5.2 监控体系:Prometheus+Grafana

构建完善的监控体系,实时掌握 Nginx 运行状态:

# 启用状态监控模块

server {

listen 8080;

allow 127.0.0.1; # 仅允许本地访问

deny all;

# 基础状态监控

location /nginx_status {

stub_status on;

access_log off;

}

# 详细指标监控(nginx-prometheus-exporter)

location /metrics {

proxy_pass http://localhost:9113/metrics;

}

}

监控指标体系:

告警阈值建议:

- 活跃连接数 > 80% worker_connections

- 5xx 错误率 > 1%

- 响应时间 > 1 秒

- CPU 使用率 > 80% 持续 5 分钟

六、最佳实践与性能调优总结

6.1 性能调优清单

|

优化方向 |

关键配置 |

性能提升 |

|

进程配置 |

worker_processes = CPU 核心数worker_cpu_affinity 绑定 CPU |

10-30% |

|

连接管理 |

worker_connections = 10240+keepalive_timeout = 60s |

30-50% |

|

事件驱动 |

use epollmulti_accept on |

10-20% |

|

静态资源 |

sendfile ongzip on浏览器缓存 |

50-80% |

|

网络优化 |

tcp_nopush ontcp_nodelay on系统参数调优 |

20-40% |

6.2 高并发架构设计原则

- 分层设计:前端 CDN→负载均衡层→应用层→数据层,每层独立扩展

- 无状态设计:应用服务无状态化,便于水平扩展

- 多级缓存:浏览器缓存→CDN→Nginx 缓存→应用缓存→数据库缓存

- 限流熔断:保护核心服务,牺牲非核心功能

- 监控告警:全链路监控,提前发现潜在问题

6.3 常见问题解决方案

|

问题现象 |

可能原因 |

解决方案 |

|

连接数上不去 |

ulimit 限制worker_connections 过小 |

提高文件描述符限制增大 worker_connections |

|

响应时间变长 |

后端服务慢缓存失效 |

优化后端服务检查缓存配置 |

|

502 错误 |

后端服务崩溃连接数满 |

增加后端服务调整 keepalive 参数 |

|

CPU 使用率高 |

正则匹配效率低压缩级别过高 |

优化正则表达式降低 gzip_comp_level |

|

内存泄漏 |

模块 bug连接池配置不当 |

升级 Nginx 版本调整连接池参数 |

通过合理的架构设计和参数优化,Nginx 可轻松支撑每秒数万请求的高并发场景,同时保持稳定可靠的服务质量。关键是理解其事件驱动模型,结合业务场景进行针对性优化,并建立完善的监控和高可用机制。

942

942

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?