1、多个训练样本的代价函数简化表示

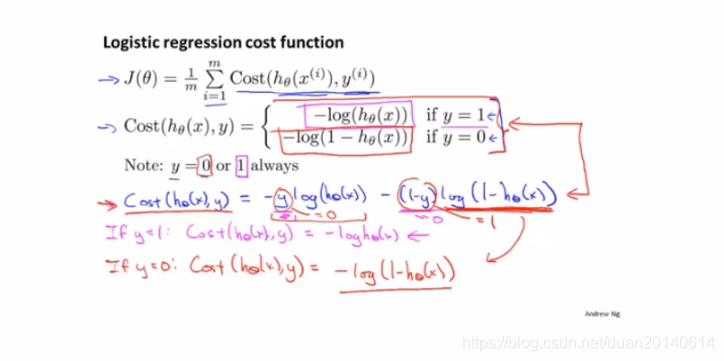

前一篇文章中,我们我们已经知道了单训练样本cost(hθ(x),y)cost(h_{\theta}(x),y)cost(hθ(x),y)的分段表示,实际上,它还可以写成更紧凑的形式:

cost(hθ(x),y)=−ylog(hθ(x))−(1−y)log(1−hθ(x))cost(h_{\theta}(x),y)=-ylog(h_{\theta}(x))-(1-y)log(1 - h_{\theta}(x))cost(hθ(x),y)=−ylog(hθ(x))−(1−y)log(1−hθ(x))

该函数(也叫交叉熵)具有以下性质:

ify==1, cost(hθ(x),y)=−log(hθ(x))ify==0 cost(hθ(x),y)=−log(1−hθ(x))ify==1,\ \ \ cost(h_{\theta}(x),y)=-log(h_{\theta}(x))\\

ify==0\ \ \ \ cost(h_{\theta}(x),y)=-log(1- h_{\theta}(x))ify==1, cost(hθ(x),y)=−log(hθ(x))ify==0 cost(hθ(x),y)=−log(1−hθ(x))

当训练集的大小为m时,其代价函数J(θ)J(\theta)J(θ)为:

J(θ)=1m∑i=1mcost(hθ(x(i)),y(i))J(\theta)=\frac{1}{m}\sum_{i=1}^{m}cost(h_{\theta}(x^{(i)}),y^{(i)})J(θ)=m1i=1∑mcost(hθ(x(i)),y(i))

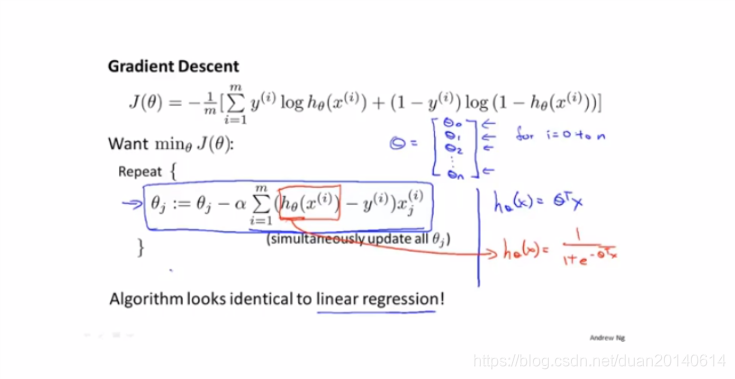

2、逻辑回归的梯度下降法

逻辑回归的梯度下降公式如下所示:

参数的更新形式和线性回归基本一样,只是假设函数不同。

本文深入探讨了逻辑回归中的代价函数表示,包括交叉熵概念及其简化表达,并介绍了梯度下降法在逻辑回归中的应用,详细展示了参数更新的公式。

本文深入探讨了逻辑回归中的代价函数表示,包括交叉熵概念及其简化表达,并介绍了梯度下降法在逻辑回归中的应用,详细展示了参数更新的公式。

1070

1070

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?