一、文章来源

> Du Y, Wang S, Guo X, et al. Graphgt: Machine learning datasets for graph generation and transformation[C]//Thirty-fifth Conference on Neural Information Processing Systems Datasets and Benchmarks Track (Round 2). 2021.

二、概述

1、文章提出的意义相应的真实世界数据集很少,仅限于分子和引用网络等领域,为了填补这一空白,提

出相应的方法。为了帮助研究人员更好地探索数据集。

2、文章的贡献

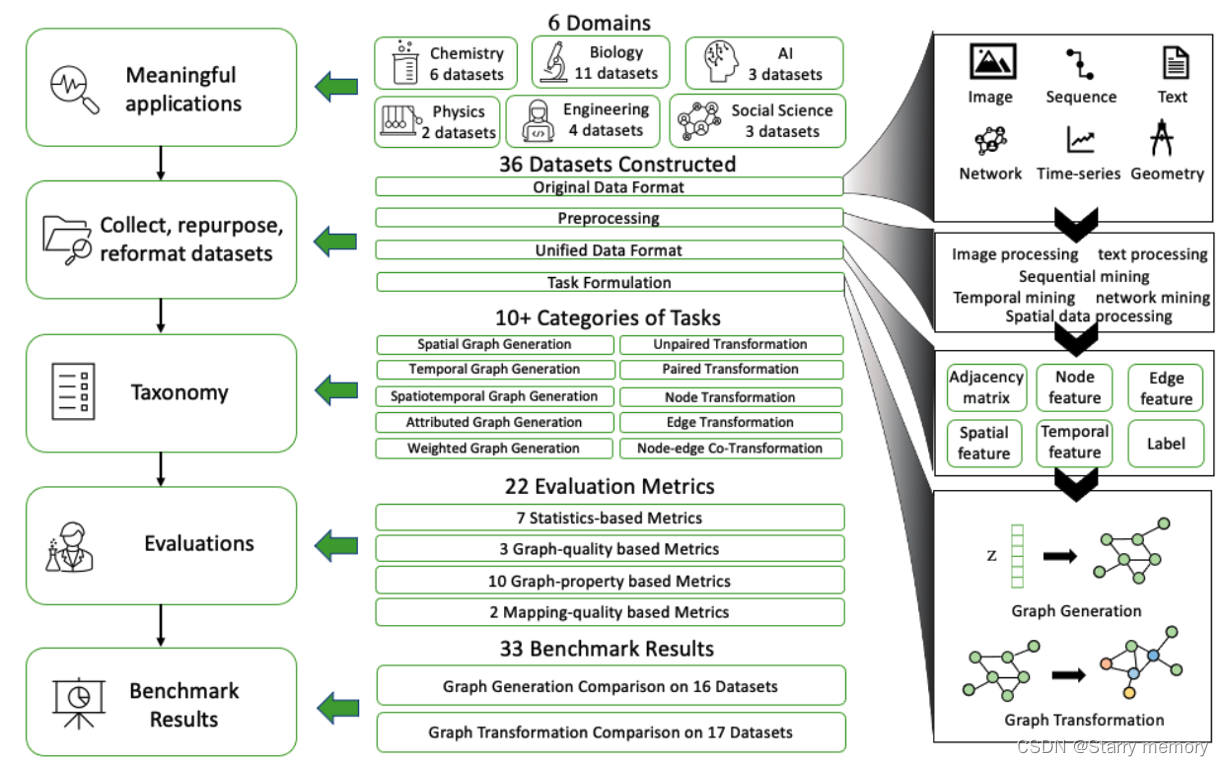

贡献1:提出GraphGT,搞了一个数据集和,包含6个主题的9个领域、36个数据集

贡献2: 基于研究任务、图类型和应用领域对数据集进行系统回顾和分类介绍

贡献3:简化了图形数据加载、实验设置和模型评估的过程

3、文章摘要细节

图生成在网络设计和移动性综合等应用中显示出巨大的潜力,是图的机器学习中增长最快的领域之一。尽管图形生成取得了成功,但相应的真实世界数据集很少,仅限于分子和引用网络等领域。为了填补这一空白,我们引入了GraphGT,这是一个用于图形生成和转换问题的大型数据集集合,它包含来自6个主题的9个领域的36个数据集。为了帮助研究人员更好地探索数据集,我们根据研究任务、图类型和应用领域对数据集进行了系统回顾和分类。我们已经显著地(重新)处理了来自不同领域的所有数据,以适应图生成和转换问题的统一框架。此外,GraphGT提供了一个易于使用的图形生成管道,简化了图形数据加载、实验设置和模型评估的过程。最后,我们比较了流行的图生成模型在16个图生成和图转换数据集中的性能,展示了GraphGT在区分和评估模型能力和缺点方面的强大力量。GraphGT已定期更新,并欢迎来自社区的意见。GraphGT在https://GraphGT.github.io/上公开,也可以通过开放的Python库访问。

三、介绍

图是普遍存在的数据结构,用于捕捉单个单元(即节点)之间的连接(即边)。图上机器学习的一个核心问题是数据挖掘和机器学习模型[1,2,3]所偏好的离散图拓扑信息和连续数值向量之间的差距。这直接导致了现代机器学习中图研究的两个主要方向:1)图表示学习[2,4,5,6],其目的是将图结构信息编码到(低维)向量空间中;2)图生成[7,8],其相反目的是从(低维的)向量空间构建图结构数据。在过去的几年里,图表示学习在机器学习中得到了爆炸性的发展。DeepWalk[9]、图卷积网络(GCN)[10]和图注意力网络(GAT)[11]等技术已被提出用于各种任务,包括节点分类[12]、链接预测[13,14,15]、聚类[2,4]和其他[16,17]。

除了图表示学习之外,近年来,通过机器学习的图生成和转换开始获得越来越多的关注。它实现了对潜在未知图生成或转换过程的端到端学习,这是对传统规定图模型(如随机图和随机块模型)的重大进步。这需要强大的人类先验知识和手工制定的规则。因此,通过机器学习生成和转换图在分子设计、迁移网络合成和蛋白质折叠统计建模等许多具有挑战性的任务中具有巨大潜力。近年来,在开发图生成和转换的模型和算法方面付出了大量努力,其中一些模型和算法已针对特定领域进行了研究,如GraphVAE[18]、MolGAN[19]和JT-VAE[20]。

与图表示学习不同,图表示学习享有各种基准数据集,如用于节点分类的CORA、CITESEER和PUBMED [21]、用于链接预测的OAG[22]和用于图级预测的Molecule-LLENET[23],通过机器学习生成和转换图形仍处于初级阶段,缺乏全面的基准数据集,无法很好地覆盖不同的关键现实应用程序和图形模式类型。现有的数据集基本上仅限于引用网络和分子等少数领域[7,24]。这样的数据稀缺问题进一步导致了以下瓶颈,阻碍了这一快速增长的图生成和转换领域的发展:

(1)格式化困难:图结构数据本质复杂;并且不同域中的原始数据可能需要非常不同的过程来处理或重新处理,以便适应统一的格式。

(2) 应用领域数量有限:尽管图生成和转换是一个非常广泛的通用概念,涵盖了从地理到生物学、物理学、社会学到工程等领域的图,但现有的数据集只涵盖有限的领域,这阻碍了图生成模型的开发以及在更多样化领域的应用。

(3) 缺乏分类法:随着图生成和转换领域的发展,研究任务是多样化的,因此需要定义明确的分类,以便将数据集置于正确的类别下,用于评估相应的任务。

(4) 缺乏统一的评估程序:现有研究工作中使用的评估指标非常多样化,需要制定评估程序和指标的金标准。此外,现有数据集的稀缺性可能会使高程度量的选择产生偏差,以适应有限数量的现有数据集(例如,分子),但可能对其他数据集不通用。

(5) 缺乏全面的模型比较:现有模型通常在非常集中的领域中的少数数据集中进行评估,有些模型可能已经倾向于“过度拟合”这些数据集,这对现有方法的差异化、评估和进步提出了重大挑战

为了应对上述挑战,我们引入了GraphGT,这是一个用于机器学习中图形生成和转换的大型数据集集合,它

(1)收集、重新使用、重新格式化大量的图形数据集,

(2)涵盖各种领域和主题,

(3)对数据集进行系统的回顾和分类,

(4)对模型评估程序进行标准化,以及

(5)在大量数据集上提供基准结果。

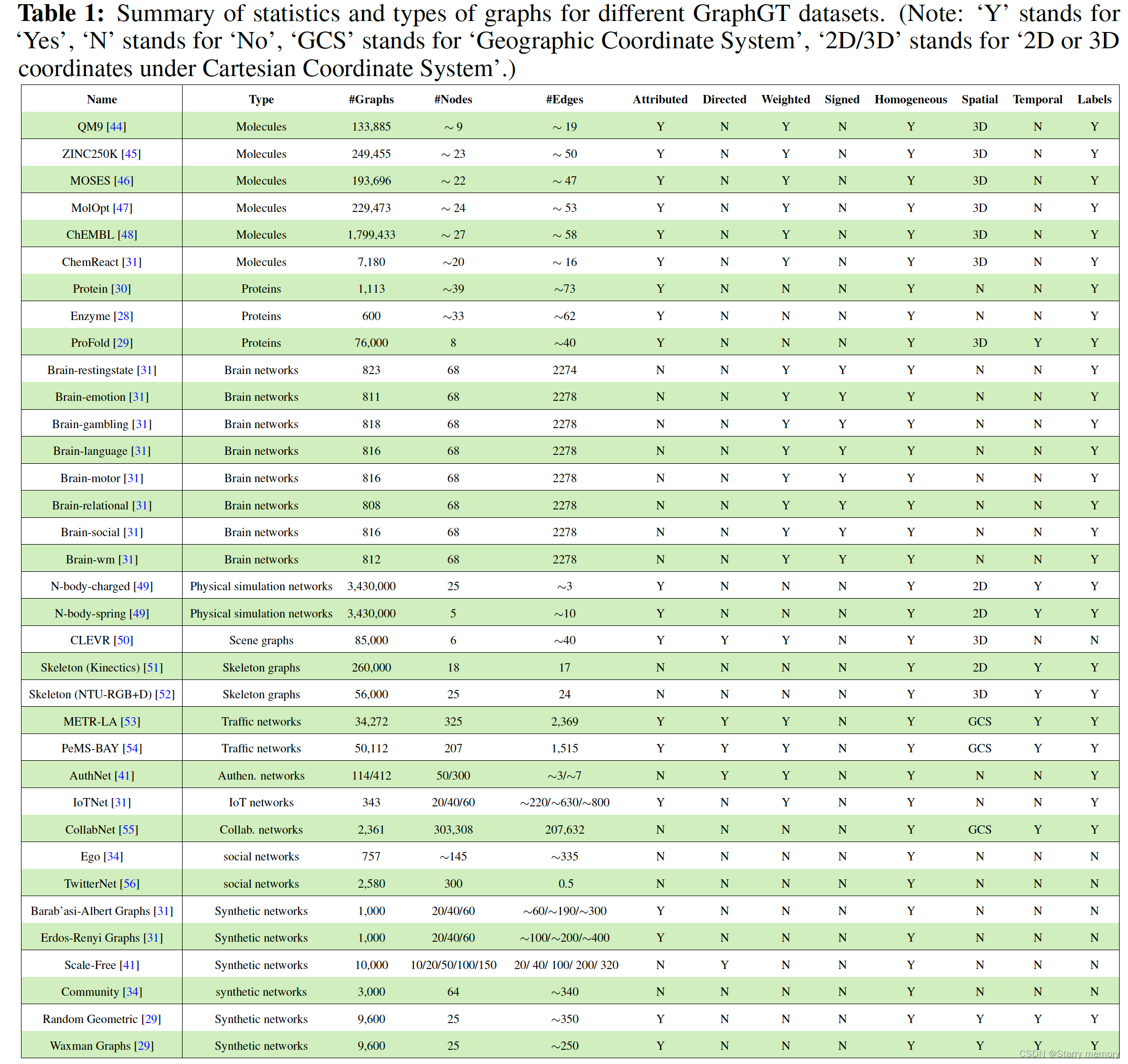

主要贡献如下。36个数据集以各种图形类型发布,涵盖6个学科(包括生物学、物理学、70个化学、人工智能、工程和社会科学)和 9个领域(包括蛋白质、脑网络、物理模拟、视觉、分子、运输科学、电气和计算机工程(ECE)、社交网络和合成数据)。在所有36个数据集中,我们从头开始收集并构建了CollabNet数据集和7个脑网络数据集,用于图形生成和转换。另外8个数据集被我们从其他应用程序中首次重新用于图形生成和转换任务。其余的来自非常不同的领域,它们共享非常不同的术语、格式和数据结构,我们首次将其重新格式化为统一的格式,以便以标准化的方式轻松访问和使用。我们使用流行的图生成和转换模型提供并分析了16个数据集上的图生成以及17个数据集的图转换的结果。我们观察到,在不同领域的不同数据集(例如,具有不同的图大小、特征类型等)中,比较方法的性能可能相当不同。因此,GraphGT可以非常有助于区分比较方法,找出它们的缺点,并进一步推进它们。•易于使用的Python API让用户根据自己的兴趣,根据特定的学科、领域和应用程序查询和访问预处理的数据集。我们还在附录中提供了实现的详细教程。除了通过Python API访问外,GraphGT是开源的,可通过GitHub下载,网址为https://graphgt.github.io

四、相关工作

随着图表示学习在机器学习中的爆炸式增长,DeepWalk[9]、图卷积网络(GCN)[10]和图注意力网络(GAT)[11]等众多研究工作已被提出用于各种任务,包括节点分类[12]、链接预测[13,14]和聚类[2,4]。除此之外,还提出了一些数据集,如节点分类数据集(CORA、CITESEER和PUBMED)[21]、链接预测数据集(OAG)[22]和图级预测(Molecule LENET)数据集[25]。为了总结和标准化这些数据集,已经提出了许多用于图表示学习的数据集。斯坦福网络分析平台(SNAP)是一个通用的网络分析和图形挖掘库,包含具有数亿节点和数十亿条边的大规模网络[26]。OPEN GRAPH BENCHMARK(OGB)是一组具有挑战性和现实性的基准数据集,旨在促进可扩展、稳健和可重复的图形机器学习(ML)研究[27]。然而,用于图表示学习研究的大多数数据集不能用作图生成基准,因为后者需要大量的单个整图才能学习它们的分布。而上述数据集要么包含一个用于节点分类和链接预测的巨型图,要么包含一组来自不同分布的图用于图分类。图的生成和转换由于其在各个领域的重要作用而越来越受到社会的关注。尽管已经提出了许多先进的方法,但用于该研究主题的数据集数量有限。酶数据集[28]、ProFold数据集[29]和蛋白质数据集[30]用于蛋白质结构生成。ZINC分子数据库用于生成具有所需性质的最佳分子[20]。此外,还为图生成任务生成了一些合成数据集来学习图分布,如Erdos-Renyi图[31]和Waxman随机图[29]。很少有数据收集系统地组织来自不同领域的图生成数据集。

五、图生成和转换

5.1 图生成

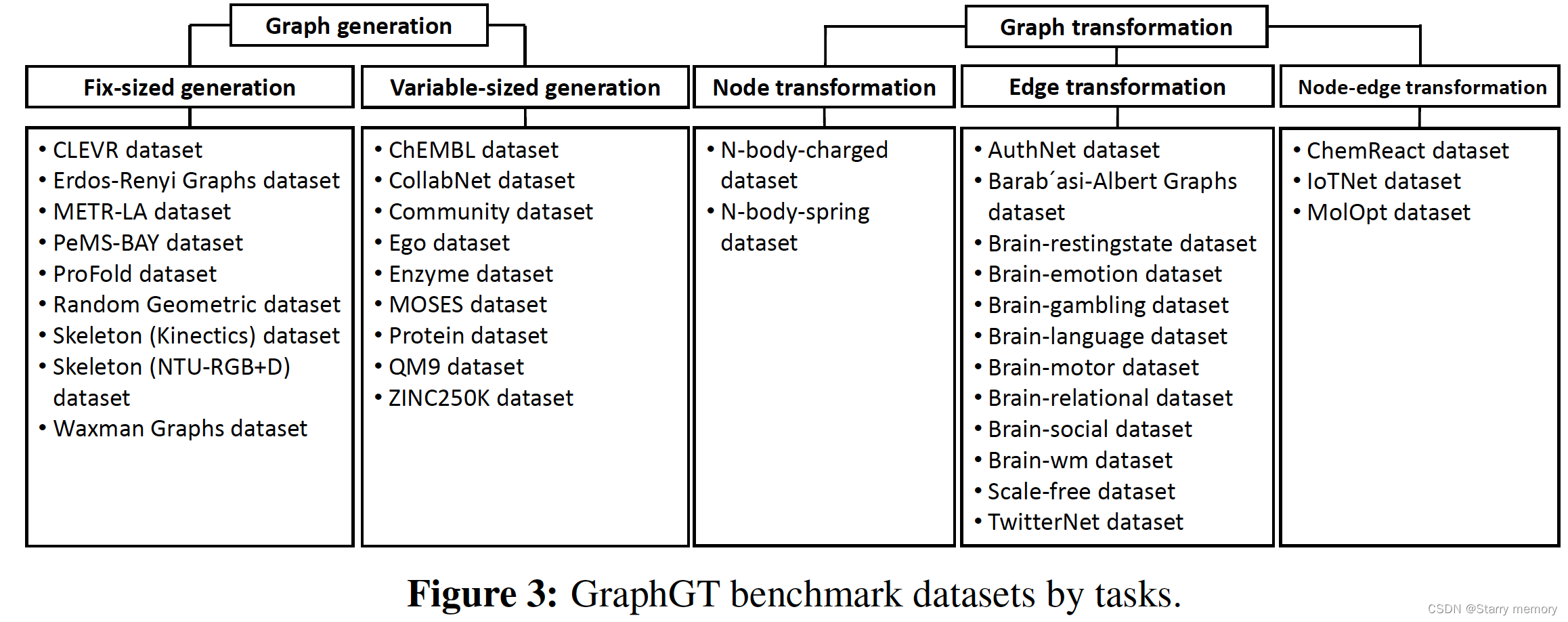

图生成旨在通过精心设计的概率模型对新颖的图进行采样[7]。更正式地说,给定一组具有任意数量节点和边的观测图,图生成模型旨在学习观测图的分布p(G),然后可以通过从学习的分布G中采样图G来实现图生成G⇠ p(G)。根据生成图的大小,图生成任务可以分为两类:

(1) 固定大小生成,其中节点的数量在不同的图样本之间是固定的;例如,在人脑网络(例如,功能连接)中,不同受试者的大脑区域数量通常相同;

(2)当节点的数量在图样本之间变化时的可变大小的生成。例如,不同的分子可以被认为是具有不同原子数的图。这两个类别包含不同类型的数据集。最近关于图生成的研究可以分为两个分支,

1)one-shot生成。

2)顺序生成,根据它们对生成过程的选择。

具体而言,一次生成为生成的图特征构建概率矩阵,图结构可以通过一次生成中的最大概率节点和边来获得[18,32,19,33]。在顺序生成时,将图生成公式化为顺序过程,并逐个生成节点和边[34,35,36,37]。

5.2 图转换

图转换旨在将源域中的一个图转换为目标域中的另一个图。它也可以看作是对另一个图的图生成条件。例如,在神经科学中,在给定相应的结构连接性的情况下,探索功能连接性是很有趣的。在硬件设计领域,给定集成电路设计,可以要求通过添加额外的门和密钥(即,可以被视为节点)来混淆它,但保持相同的功能。更正式地说,图变换问题可以形式化为学习生成映射T:(V0,TE0,E0,F0)-> (V0’,TE0’,E0’,F0’)其中(V0,E0,E0,F0)对应于源域中的图,(V0’,TE0’,E0’,F0’)表示目标域中的图形。基于转换过程中转换的实体,关于图转换的问题可以分为三种主要场景:(1)节点转换将节点和/或其属性从源域转换到目标域;(2) 边缘变换将图拓扑和/或边缘属性从源域映射到目标域;在(3)节点-边缘协同变换中,节点和边缘信息在变换过程中都会发生变化。最近的工作涵盖了三类图转换模型中的每一种。交互网络是一种节点转换技术,提供对对象、关系和物理的推理[38]。DCRNN将扩散卷积与seq2seq框架集成在一起,以处理节点变换[39]。提出了一种用于化学反应建模的图卷积策略网络。DCGAN已被用于产生新的蛋白质结构[40]。GC-GAN可以处理恶意软件网络合成[41]。对于节点-边共变换,JT-VAE[20]和Mol-CycleGAN[42]被设计用于分子优化。DG-DAGRNN用于推广有向无环图结构上序列上的堆叠RNN[43]

六 GraphGT基准数据集的描述

6.1 分类

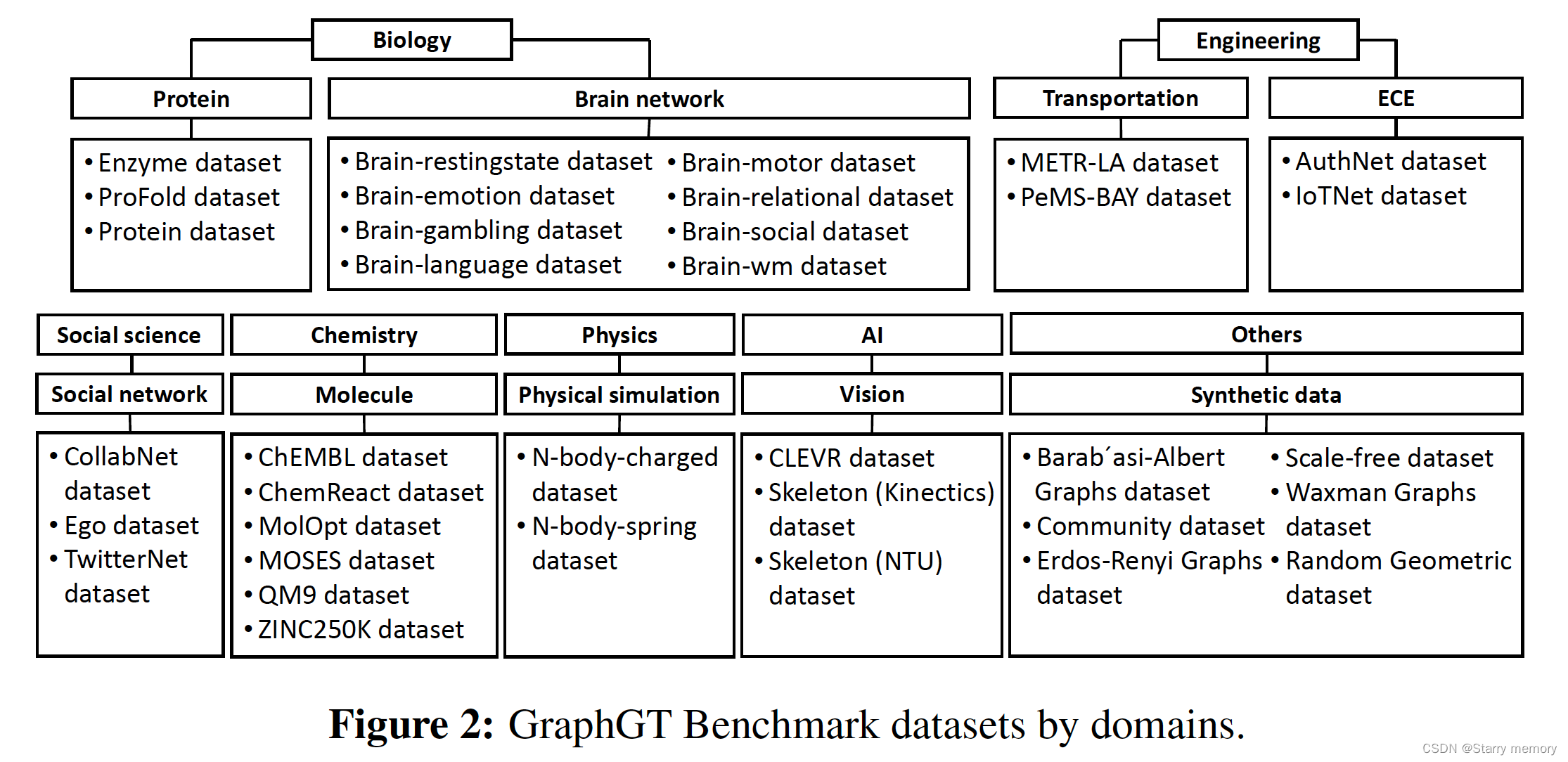

GraphGT Benchmark涵盖了来自不同领域和任务的36个数据集。不同领域的分类如图2所示,共有9个领域,包括蛋白质、脑网络、物理模拟、视觉、分子、运输科学、电气和计算机工程、社交网络和合成数据,涉及6门学科,包括生物学、物理学、人工智能、化学、工程和社会科学。此外,不同任务的分类如图3所示。对于图形生成任务,他们可以提取用于固定大小生成或可变大小生成的数据集。对于图转换任务,我们提供了用于节点转换、边缘转换以及节点和边缘协同转换的数据集。

6.2 数据细节

本文提在图2中介绍的跨不同主题的代表性数据集的规范。还将提供它们在诸如图生成或转换任务之类的任务中的潜在用途。表1总结了不同数据集的一般概况。每个数据集和管理方法的更详细描述可在附录C中找到。

6.2.1 生物学动机

在生物学领域,我们有两个主题,即蛋白质和大脑网络。蛋白质对所有生命都至关重要,与重要的生物医学相关任务高度相关,如蛋白质设计[57]和药物设计[58,59,60,61,62,63]。从头蛋白质设计[64]是一个很有前途的领域,它在蛋白质折叠的物理原理的指导下,探索全序列空间,估计只有200个残基的蛋白质有20200个可能的氨基酸序列。除了蛋白质结构外,大脑网络还包括两种主要类型的连接,结构和功能,它们分别反映了人类大脑不同区域之间的纤维-神经连接和共激活关系。理解和建模大脑网络以及结构连接和功能连接之间的相关性是神经科学的关键任务[65]。

任务:蛋白质结构可以被认为是图,其中氨基酸作为节点,接触作为边缘连接。产生新的蛋白质是应对生物医学和纳米技术挑战的基础[64,57,58,66,67,68,67]。在大脑网络中,大脑区域被表示为节点,每对区域之间的连接被表示为边缘。图形转换模型可以帮助理解人脑中从结构连接到静息状态或任务特定功能连接的转换[31]。

数据集构造:我们在GraphGT中重新格式化了3个蛋白质结构数据集用于图形生成,8个脑网络数据集用于图转换。对于蛋白质数据,我们从氨基酸坐标开始,然后根据氨基酸的相互距离提取蛋白质结构图。节点特征(氨基酸类型)也被提取并记录在GraphGT中。我们通过对磁共振成像(MRI)数据中的两种连接性进行标准神经图像处理、时间序列处理和网络构建,构建了7个脑网络数据集,以获得脑图,边缘属性作为两个区域之间的Pearson相关性,节点属性作为节点索引。我们还重新格式化了一个已经用于图形转换任务的脑网络数据集(brain restingstate)[31]。

6.2.2 人工智能动机

图结构数据在人工智能的子领域计算机视觉中得到了广泛的应用。我们在GraphGT中存储了两种最常见的计算机视觉图结构数据,即骨架图和场景图。例如,生成场景图对于理解场景(即图像)中的关系非常重要[73]。除了场景图生成外,生成新的人体骨架图在计算机视觉、图形和游戏中也有广泛的应用,其中可以生成角色并与人类玩家交互[74,75]。

任务:在场景图中,对象表示为节点,对象对之间的关系表示为边。图形生成模型可以应用于场景图,以帮助社区理解场景中对象之间的关系,例如生成具有不同关系的场景图(骑马的人与站在马旁边的人)。在人体骨骼图中,关节表示为节点,每对关节之间的骨骼表示为边。类似地,可以为骨架图设计图形生成模型,以帮助社区处理视频中人类玩家和角色之间的交互(例如,生成具有逼真手势和动作的AI玩家)

数据集构造:我们将一个数据集重新用于场景图,将两个数据集用于骨架图,这些数据集尚未用于图生成任务。对于场景图,我们从CLEVR数据集开始,该数据集包含图像中具有不同3D位置的10个对象。然后,我们以不同形状的对象作为节点特征,以两个对象之间的相对位置作为边缘特征,形成有向图。对于骨架图,我们从人类动作数据集的视频片段开始,然后使用OpenPose工具箱为每个受试者生成具有位置和关节的骨架。时间信息也被记录下来,并作为时间特征被封装到我们的数据中。

6.2.3 社交科学动机

社交网络是一种重要的图形类型,人们或其他主体通过友谊和合作等关系连接在一起,并在社会科学、统计学和物理学中通过网络(生成)建模技术进行了广泛探索。图生成模型的进步通过处理数据的不同方面进一步刺激了社交网络的研究。例如,DYMOND通过借用网络结构的构建块来捕捉远程交互,从而在社交网络上实现图形生成[84]。另一个图生成模型TagGen可以在社交网络中建模交互的过程中保留结构和时间信息[85]。

任务:社交网络可以形式化为图,其中社交主体是节点,它们的关系是边。社区网络已被用于建立图生成模型,以便对人或社区之间的关系进行建模和理解[34]。

数据集构造:我们从Citeseer数据集重新格式化Ego数据集。节点表示文档,边表示引用关系。我们还重新使用了[56]中的TwitterNet。两个数据集都没有节点或边属性。我们通过选择作者作为节点,选择共同作者作为边,从头开始构建CollabNet的图。为了将图分割成块,我们根据论文的研究领域生成子图。对于每个字段,我们生成一个时空图。

6.2.4 合成动机

现实世界中可用数据的数量有限,特别是用于图生成和变换问题的特定几何属性[86,8788]的图数据,限制了该领域的发展。合成数据是克服这一障碍并延长图生成和转换任务进展的一种方法。这促使我们在GraphGT中重新格式化一些模拟合成数据集,以满足社区评估图生成和转换任务的各种需求。

任务:合成数据集包含与各种几何性质相对应的图,包括无标度图、Erdos-Renyi图、随机几何图等。大量关于图生成和转换的工作一直在使用合成数据集来评估其模型。NEC-DGT用Barab’asi-Albert图和Erdos-Renyi图进行评估[31]。另一个图转换模型GT-GAN通过无标度图进行评估[41]。

数据集构造:我们通过将原始稀疏矩阵转换为密集矩阵,并将其重塑为预定义的维度来重新格式化合成数据集。所有合成数据集都是基于特定的几何特性或定律进行模拟的

七、基准实验

7.1 图生成

7.1.1 评估指标

图形生成性能的评估已被广泛认为是一项具有挑战性的任务[34,37],并且缺乏一个能够提供全面评估程序和指标的统一框架。在对图形生成进行调查[7]之后,我们使用易于使用的评估工具增强了部署的API。GraphGT中的评估指标阐述如下。

在基于统计的评估度量中,通过计算实图的图统计分布与生成图之间的距离来访问生成图的质量。在部署的API中,考虑了七种典型的图形统计,总结如下:

(1)节点度分布:图的经验节点度分布,可以对其局部连通性模式进行编码。

(2) 聚类系数分布:图的经验聚类系数分布。直观地,节点的聚类系数被计算为该节点可能是其一部分的三角形的潜在数量与该节点是其中一部分的实际三角形数量的比率。

(3) 轨道数分布;图的节点4轨道的计数的分布。直观地说,轨道计数指定节点是这4个轨道子结构中的一部分。该度量有助于理解模型是否能够匹配高阶图统计,而不是表示局部(或接近局部)接近度的节点度和聚类系数。

(4) 最大连通分量:图形中最大连通分量的大小。

(5) 三角形计数:图形中计数的三角形数。

(6) 特征路径长度:图中所有节点对沿最短路径的平均步数。

(7) 关联性:图中连接节点度的皮尔逊相关性。为了计算与上述统计有关的距离,使用了平均Kullback-Leibler散度和最大平均差异(MMD)。

在基于自我质量的评估中,测量生成图的质量,即有效性、唯一性和新颖性。三个度量的定义和计算如下:

(1)有效性:有效性通过判断图是否保留特定属性来评估图。例如,对于循环图/树图,有效性计算为生成的循环图或树图的百分比[8]。对于分子图,有效性是基于特定领域规则的化学有效分子的百分比[36]。

(2) 唯一性:理想情况下,高质量生成的图应该是多样和相似的,但不是完全相同的。因此,利用唯一性来捕获生成的图的多样性[89,8,36]。为了计算生成图的唯一性,首先去除与其他生成图同构的子图的生成图。此操作后剩余图形的百分比定义为“唯一性”。例如,如果模型生成100个图,所有图都相同,则唯一性为1/100=1%。

(3) 新颖性。新颖性度量生成的图不是训练图的子图的百分比,反之亦然[89]。注意,相同图被定义为彼此同构的子图。换句话说,新颖性检查模型是否学会了推广看不见的图。

7.1.2 基准结果

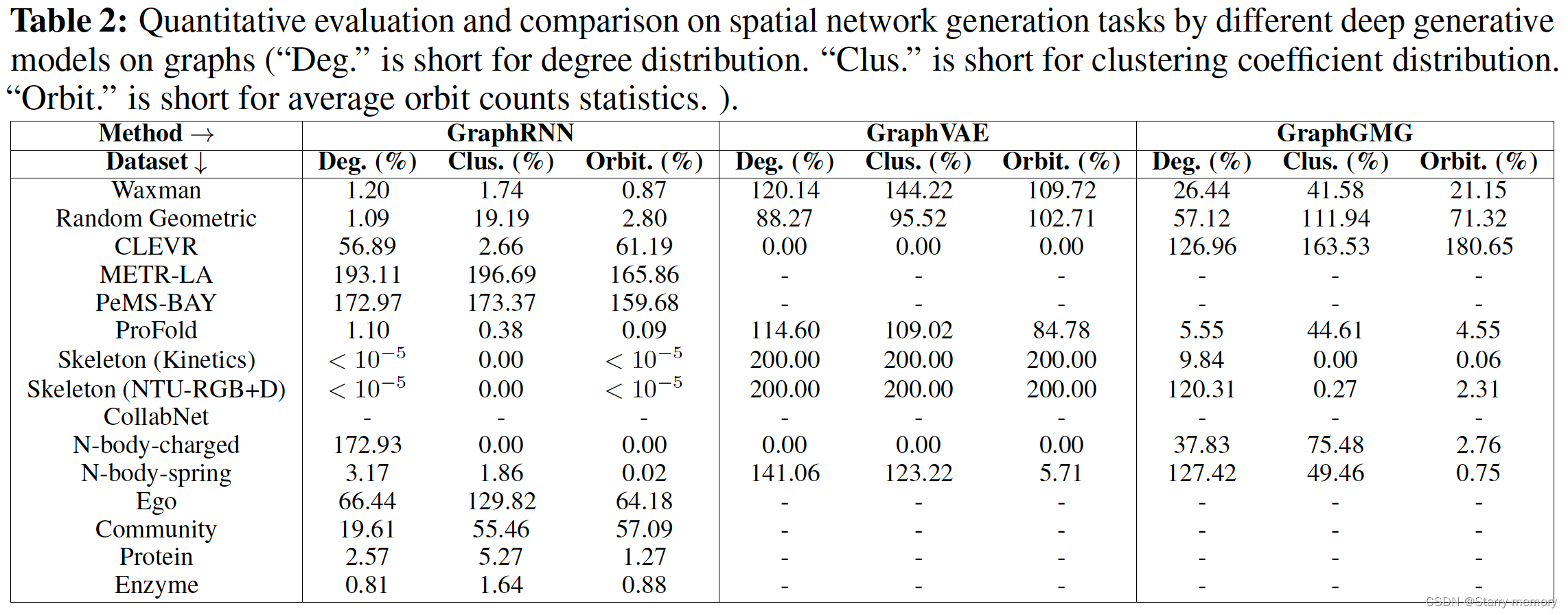

对于图生成,我们使用GraphRNN[34]、GraphVAE[18]和GraphGMG[8]这三个常见的图生成基线对GraphGT中的16个图生成数据集进行了基准测试。每个基线模型的详细描述可以在附录D中找到。我们评估了图生成模型在三个基于统计的指标上的性能,即度分布、聚类系数分布和轨道计数统计。对于效率问题,GraphVAE和GraphGMG无法扩展到多个大型数据集,例如METR-LA、蛋白质、酶等。请注意,CollabNet太大,即使GraphRNN也无法扩展。从表2中,我们可以观察到GraphRNN在大多数数据集中都优于GraphVAE和GraphGMG。值得注意的是,GraphRNN利用了顺序图生成的优势,可以扩展到大型图,而GraphVAE由于其成本高昂的一次性生成方法而无法实现。此外,GraphRNN在相对较小的图形数据集上工作得非常好,例如Profold、N-body、Skeleton,而在流量网络等大型图形上表现较差。GraphVAE在CLEVR和N-body-charged这两个特定的数据集中表现非常好,这两个数据集都很小,模拟过程是随机的。GraphGMG在一个骨架图和一个蛋白质数据集中表现良好,这两个图的结构都是固定的和简单的。此外,GraphVAE在CLEVR和N-body-charged数据集上的性能优于基于序列的模型。我们相信,一次性生成方法更容易学习与空间位置相关的拓扑,因为它不必学习序列相关的过程。

7.2 图转换

7.2.1 评估指标在基于图属性的评估中,我们通过以下度量直接将每个生成的图与其目标图进行比较:

(1)使用基于随机行走的图核[90]的随机行走核相似性;

(2) Hamming和Ipsen-Michailov距离的组合(HIM)[91];

(3) 密度矩阵的谱熵;

(4) 特征向量中心距离[92];

(5) 贴近-中心距离[93];

(6) Weisfiler-Lehman核相似性[94];

(7) 邻域子图成对距离核[95],通过匹配具有不同半径和距离的子图对;

(8) Jensen–Shannon距离;

(9)Bhattacharyya距离和

(10)Wasserstein距离。

在基于映射关系的评估中,我们测量输入和生成的图之间的学习关系是否与输入和真实图之间的真实关系一致。有两种关系需要考虑[7]:

(1)显式映射关系。考虑到输入条件和生成图之间的真实关系事先已知的情况,评估可以如下进行:我们定量比较生成图和输入图的属性得分,看看变化是否确实符合要求。例如,在分子优化任务[96]中,可以计算从输入分子到优化分子的logP分数的提高。

(2) 隐含映射关系。当从输入图到真实目标图的映射的基本模式是隐含的并且难以定义和测量时,可以使用基于分类器的评估度量[41]。通过将输入图和目标图视为两类,它假设能够区分生成的目标图的分类器也将成功地将真实目标图与输入图区分开来。具体地,首先基于输入和生成的目标图来训练图分类器。然后对训练后的图分类器进行测试,对输入图和真实目标图进行分类,并将结果用作评估指标。

7.2.2 基准结果

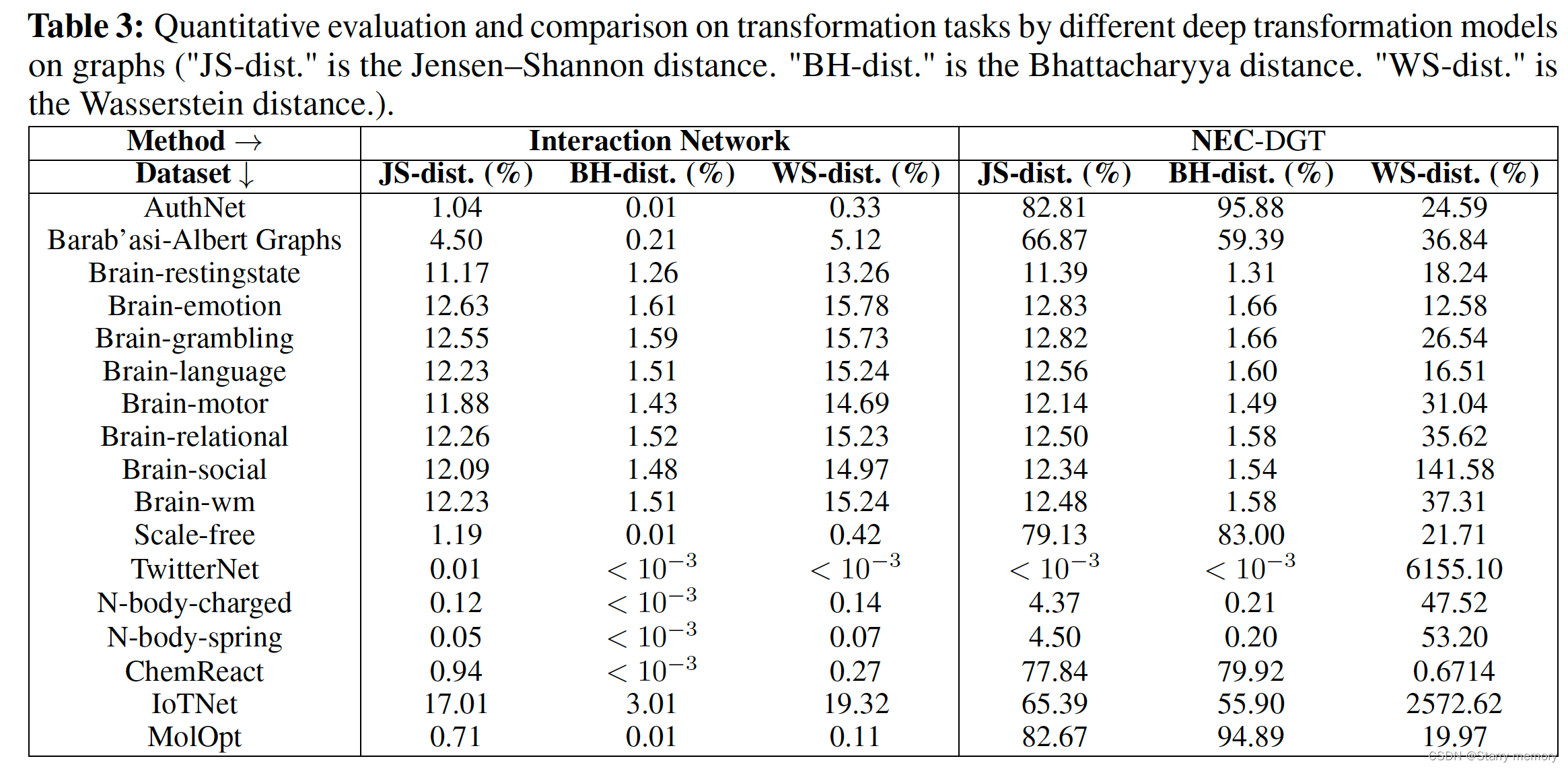

在这里,GraphGT中的图转换任务有17个转换数据集进行了基准测试。借用了两个最先进的图转换模型,交互网络(IN)[38]和节点边缘协同深度图转换器(NEC-DGT)[31]来分析这些数据集。Jensen–Shannon距离、Bhattacharyya距离和Wasserstein距离三个度量用于测量生成图的分布与目标图之间的距离。关于实验设置的详细信息可以在附录D中找到。我们发现,在大多数数据集上,两个模型在图转换方面的性能非常接近。这并不奇怪,因为两个模型遵循相似的原理来处理图中的节点交互。通过交互网络,在TwitterNet上实现了最小的Jensen–Shannon和Bhattacharyya距离,该距离与NEC-DGT一致。TwitterNet也有最接近的Wasserstein距离,无论大脑情感对NEC-DGT的Wasser斯坦距离是否最接近。这种差异可能源于处理两个模型的节点或边缘特征的能力,或者不同的超参数设置。交互网络可以处理边缘属性,这些属性可用于Brain情感数据集,但不可用于TwitterNet数据集,而NEC-DGT可以处理节点和边缘属性,这两个属性都不可用于Twitter。我们还发现,对于同一模型,来自不同领域的数据集具有不同的性能。在交互网络评估时,与大多数其他数据集相比,我们观察到8个脑网络数据集的三个指标之间的距离相对较大。然而,当通过NEC-DGT进行评估时,这8个数据集的距离相对较小。这反映了大脑网络领域的复杂性[97],需要处理更先进的模型,如NEC-DGT。当由两个模型进行评估时,与大多数其他数据集相比,N-body-charged和N-body-spring数据集的距离通常较小。这是由于物理模拟领域中的图形大小相对较小(表3)。

八、结论

本文介绍了GraphGT,一个用于图形生成和转换问题的大型数据集集合。GraphGT涵盖了6个受试者的9个领域的数据集,其中CollabNet数据集和7个脑网络数据集是从头开始收集和构建的,用于图形生成和转换。另外8个数据集被我们从其他应用程序中首次重新用于图形生成和转换任务。其余的来自非常不同的领域,它们共享非常不同的术语、格式和数据结构,我们首次将其重新格式化为统一的格式,以便以标准化的方式轻松访问和使用。此外,我们还提供了3种类型的Python API,包括数据集下载器、图生成数据处理器、图转换数据处理器和评估器,供用户根据自己的兴趣根据特定的学科、领域和应用程序查询和访问数据集。最后,我们提供了16个图生成基准测试结果和17个图转换基准测试结果。我们相信GraphGT可以推动社区解决图生成和转换方面的重大挑战。

文章提出GraphGT,这是用于图生成和转换问题的大型数据集集合,涵盖6个主题的9个领域、36个数据集。它对数据集系统回顾分类,简化数据加载等过程。文中介绍了图生成和转换的相关概念、评估指标,并给出基准实验结果,认为其能推动解决相关重大挑战。

文章提出GraphGT,这是用于图生成和转换问题的大型数据集集合,涵盖6个主题的9个领域、36个数据集。它对数据集系统回顾分类,简化数据加载等过程。文中介绍了图生成和转换的相关概念、评估指标,并给出基准实验结果,认为其能推动解决相关重大挑战。

5887

5887

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?