还记得上周发布的"人生教练"吗?没想到反响这么热烈!

有位创业者朋友跟我说:"这个回答直接戳中痛点啊"

更有意思的是,有个技术大佬直接撸起袖子,做了个MCP来实现本地版的对话功能。看到这个我坐不住了——不能让大家等太久,我得赶紧把官方版的记忆功能做出来!

为什么记忆功能这么重要?

想象一下,如果你的人生教练每次对话都像初次见面,那多尴尬?

"嗨,我是你的人生教练,请问你是谁?"

这不就成了失忆症患者了吗?

有了记忆功能后,人生教练变成了这样:

"上次你提到想转行做AI产品经理,这周的准备进展如何?我记得你说要先学习Python基础..."

这才是真正的教练该有的样子!

实测效果:它真的记住了我

昨天晚上,我测试新版人生教练时,被它的表现惊到了。

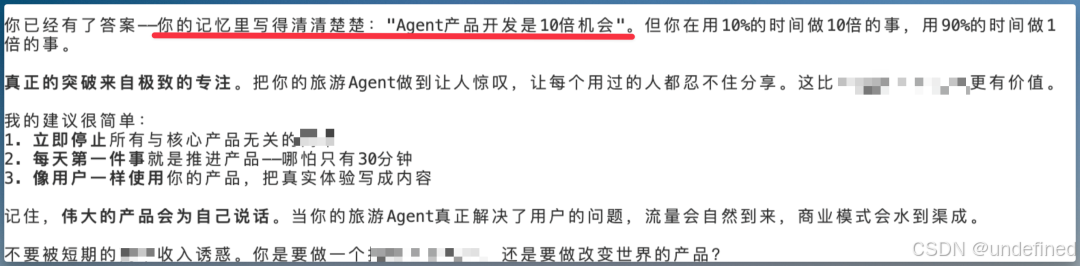

我随口问了句:"最近有点迷茫,不知道该专注做 内容 还是继续做 产品+内容"

它竟然翻出了我三个月前的一段记录:

我都忘了自己说过这话,它却记得一清二楚。

更绝的是,它还能把不同时期的想法串联起来:

最佳拍档:Cursor + Claude Code = 最强CP

实现记忆功能的技术栈其实不复杂:

1. Claude Code作为主要的工具:能够使用最强模型,claude opus4,如果没有claude code,用cursor也非常棒

3. 本地Markdown文件存储:所有对话记录都保存为可读的文本文件

3. 飞书多维表格:存储各个智者的人格提示词

4. cursor:作为 claude code 的启动器,解决claude code 不会用的问题

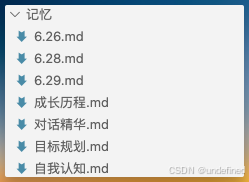

最巧妙的设计是"记忆文件夹"结构:

记忆/├── 自我认知.md # 你对自己的描述├── 成长历程.md # 重要的人生节点├── 目标规划.md # 短期和长期目标└── 对话精华.md # 有价值的历史对话

这样一来,你的Cursor直接变成了你的人生笔记本!

相比传统方案的优势

传统人生教练 vs AI人生教练

| 对比维度 | 传统教练 | AI教练 |

| 费用 | 500-2000元/小时 | 完全免费 |

| 时间 | 需要预约,通常每周1次 | 24小时随时可用 |

| 记忆 | 依赖教练个人记忆和笔记 | 完整记录每次对话 |

| 视角 | 单一教练的经验和认知 | 多位智者的综合智慧 |

| 隐私 | 可能有隐私顾虑 | 数据完全本地化 |

关键差异:AI教练不是要取代人类教练,而是让每个人都能拥有一个"思考伙伴"。

升级后的工作流程

新版人生教练的工作流程分为三个阶段:

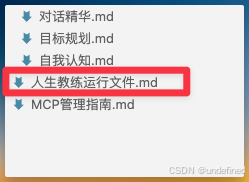

第一阶段:复制我的运行文件

复制下方提示词

https://o90p05z3t4.feishu.cn/wiki/XgxXw3Pnsi7P4akimoYcY58Wnah

新建一个文件,粘贴提示词,并命名为"人生教练运行文件.md"

第二阶段:新建“记忆”

在本地新建一个文件夹,叫“记忆”

可以在里面新建一些背景资料,参考如下

记忆/

├── 自我认知.md # 你对自己的描述

├── 成长历程.md # 重要的人生节点

├── 目标规划.md # 短期和长期目标

└── 对话精华.md # 有价值的历史对话

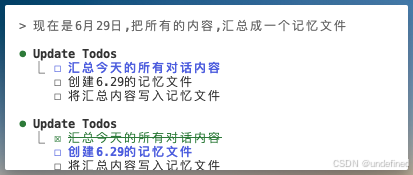

第三阶段:保存对话

当对话是你觉得需要保存的,输入“保存”类命令,AI就会识别指令,把对话存入“记忆”文件夹

实际应用场景

场景1:职业发展困惑

你问:"我是继续在大厂卷,还是出来创业?"

系统响应:

- 查理·芒格:先分析你的能力圈和财务安全边际

- 史蒂夫·乔布斯:探讨你真正的热情所在

- 系统思考大师:构建决策模型,分析长期影响

场景2:情绪管理问题

你问:"最近总是焦虑,怎么办?"

系统响应:

- CBT心理学家:识别触发焦虑的认知模式

- 苏格拉底:通过提问帮你找到焦虑的根源

- 镜像的你:回顾你之前成功应对焦虑的经验

场景3:产品设计难题

你问:"这个功能到底该不该加?"

系统响应:

- 乔布斯:从用户体验角度做减法

- 埃隆·马斯克:用第一性原理重新审视需求

- 问题考古学家:挖掘用户真正想要解决的问题

使用小技巧

1. 定期更新记忆文件

- 每周花10分钟更新"自我认知.md"

- 重大决策后记录在"成长历程.md"

- 建立核心目标在 "目标规划.md"

- 这样AI教练会越来越了解你

2. 善用追问

- 不要只问一次就结束

- 让不同智者产生思想碰撞

- 追问能激发更深层的洞察

3. 建立专属提示词库

- 可以在飞书表格中添加你信任的人物

- 比如你的导师、偶像、甚至是虚构人物

- 让他们成为你的智囊团

当前的局限性

实事求是地说,现在的AI教练还有一些不足:

1. 缺乏情感共鸣:虽然能理解你说什么,但还不能真正"感受"你的情绪

2. 依赖用户输入:记忆质量取决于你愿意分享多少

但这些都是可以改进的方向,而不是无法突破的天花板。

一个意外发现

在测试过程中,我发现了一个特别有意思的现象:

当我让"镜像的我"(AI版的自己)和真实的我对话时,经常能发现自己的认知盲区。AI版的我会说:

"成峰,从你的历史记录来看,你总是在说要专注,但实际上你享受的是探索的过程。与其纠结专注什么,不如承认自己就是一个'专业的探索者'。"

这种"自己和自己对话"的体验,有点像是在照一面特别诚实的镜子。

下一步计划

基于大家的反馈,接下来会重点做这些:

1. 手搓人物

- 聊一下自己是怎么去搓人物的

2. 轻量化部署

- 怎么样降低使用门槛

写在最后

有了记忆功能的人生教练,不再是一个冰冷的AI工具,而更像是一个真正了解你、陪伴你成长的伙伴。

它记得你的每一次困惑,见证你的每一步成长,在你需要的时候,用最合适的智慧为你指路。

更重要的是,通过与它对话,你其实是在与更好的自己对话。

这个项目还很早期,但我相信它的方向是对的——让每个人都能拥有属于自己的智慧伙伴。

如果你也想给自己的人生教练加点特殊功能,欢迎在评论区分享。说不定下个版本就会有你的创意!

我是Agent博主成峰(🔍AI产品自由),下期再见 claude code + MCP 的使用方法!

532

532

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?