博主今天要查看一下服务器上显卡信息,然后确认是否安装cuda,根据网上信息显示,要在cmd窗口中输入nvidia-smi。博主因为这一个小小的问题,着实的搞了半天。

1、注意命令的拼写

注意是nvidia而不是nvida,由于这个博主耽误了些时间;

2、注意命令没有空格

命令式nvidia-smi而不是nvidia -smi,博主当时私自加了空格,结果一直上报:“nvida不是内部或外部命令,也不是可运行的程序或批处理文件”。

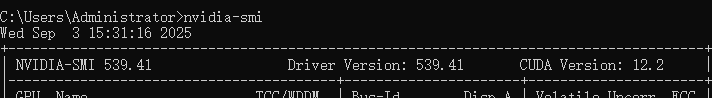

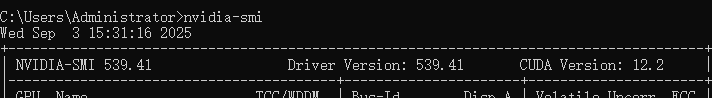

正确的cmd截图

博主今天要查看一下服务器上显卡信息,然后确认是否安装cuda,根据网上信息显示,要在cmd窗口中输入nvidia-smi。博主因为这一个小小的问题,着实的搞了半天。

1、注意命令的拼写

注意是nvidia而不是nvida,由于这个博主耽误了些时间;

2、注意命令没有空格

命令式nvidia-smi而不是nvidia -smi,博主当时私自加了空格,结果一直上报:“nvida不是内部或外部命令,也不是可运行的程序或批处理文件”。

正确的cmd截图

您可能感兴趣的与本文相关的镜像

PyTorch 2.5

PyTorch 是一个开源的 Python 机器学习库,基于 Torch 库,底层由 C++ 实现,应用于人工智能领域,如计算机视觉和自然语言处理

2376

2376

1万+

1万+

650

650

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?