论文地址:https://arxiv.org/pdf/2106.14385.pdf

源码地址:https://github.com/JiYuanFeng/MCTrans

摘要:最近的视觉transformer(即图像分类)学习不同patch标记的非局部注意相互作用。然而,现有技术错过了学习不同像素的跨尺度依赖性、不同标签的语义对应关系、特征表征和语义嵌入的一致性,这对生物医学分割至关重要。本文通过提出一种统一的transformer网络,称为多复合transformer(MCTrans)来解决上述问题,该网络将丰富的特征学习和语义结构挖掘集成到一个统一的框架中。特别地,MCTrans将多尺度卷积特征嵌入为一个标记序列,并在以前的工作中执行尺度内和尺度间的自我注意,而不是单尺度注意。此外,还引入了一种可学习的代理嵌入,分别利用自注意和交叉注意来建模语义关系和特征增强。MCTrans可以很容易地插入一个类似unet的网络,并在生物医学图像分割方面比最先进的方法有了显著的改进。例如,MCTrans在Pannuke,CVC-Clinic,CVC-Colon,Etis,Kavirs,ISIC2018数据集上分别比UNet高 3.64%,3.71%, 4.34%, 2.8%, 1.88%, 1.57%

解决的问题:MCTrans 克服了传统的vision transformer的局限性

- 引入Transformer-Self-Attention(TSA)模块,通过自我注意机制实现跨尺度的像素级上下文建模,从而对不同尺度进行更全面的特征增强。

- 开发Transformer-Cross-Attention(TCA),通过引入代理嵌入来自动学习不同语义类别的语义对应关系。使用这种代理嵌入,通过交叉注意机制与特征表征进行交互。通过对更新后的代理嵌入引入辅助损失,可以有效地提高同一类别的特征相关性和不同类之间的特征可辨别性。

这篇论文的主要贡献有:

- 提出MCTrans,它构建跨尺度上下文依赖结构,并利用语义关系用于精确的生物医学分割。

- 引入了一种新的可学习代理嵌入,分别通过自我注意和交叉注意来构建类别依赖性和增强特征表示。

- 将设计的MCTrans插入一个类似unet的网络,并评估其在6个具有挑战性的分割数据集上的性能。实验表明,MCTrans在所有任务上的性能显著提高,而所有任务的计算量都略有增加。这些结果证明了所提出的网络组件的有效性。

模型架构 :

一、多复合Transformer 网络

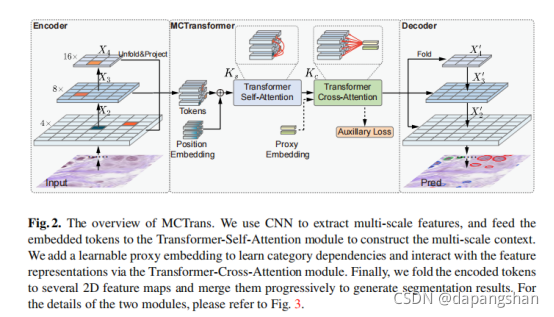

如图2所示,这是在经典的UNet编码器和解码器架构之间引入了MCTransformer,它由Transformer-Self-Attention(TSA)模块和Transformer-Cross-Attention(TCA)模块组成。引入前者来对多个特征之间的上下文信息进行编码,产生丰富而一致的像素级上下文。后者引入了可学习嵌入的语义关系建模,并进一步增强了特征表示。实际上&#x

本文提出多复合Transformer (MCTrans),解决传统transformer在生物医学图像分割中的局限,通过Transformer-Self-Attention (TSA) 和 Transformer-Cross-Attention (TCA) 模块,实现跨尺度上下文依赖结构和语义关系建模。MCTrans在Pannuke等6个数据集上超越UNet,验证了其有效性。

本文提出多复合Transformer (MCTrans),解决传统transformer在生物医学图像分割中的局限,通过Transformer-Self-Attention (TSA) 和 Transformer-Cross-Attention (TCA) 模块,实现跨尺度上下文依赖结构和语义关系建模。MCTrans在Pannuke等6个数据集上超越UNet,验证了其有效性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5048

5048

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?