先拿到awr分析报告:

从报告的汇总结果,看Redo size(bypes)

|

Redo size (bytes): |

3,532,698.9 |

计算下,一天产生的归档日志的总容量

>>> (3532698.9*3600*24)/1024/1024/1024

284.26310509443283

>>>

然后看AWR报告中的Segments by DB Blocks Changes部分,找到DML量比较大的对象,然后再去SQL Statistics部分找相关的SQL

看图片中,temp_dynamic_cost表,的DB Block Changes是166,172,736个,计算下,这些变化最大能产生的归档日志是

>>> (166172736*819)/1024/1024/1024;

126.74878424406052

>>>

126个G。

其它几个表再加起来,基本上占据了90%+的归档日志量,把这几个表的业务梳理下,大概率能知道哪个业务细节导致的。

另外从

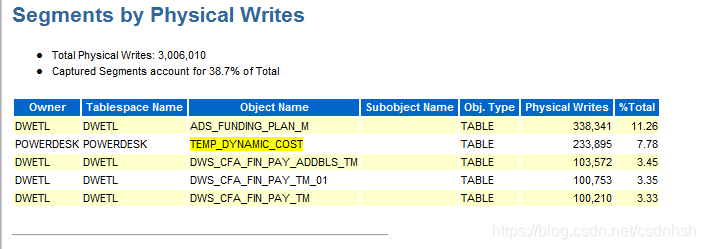

Segments by Physical Writes指标也可以看,只是不太好计算占据的容量

所以,这就很快找到了问题点,接下来就找业务开发人员,定位下这个表的业务细节,就知道是哪里出问题了。

文章介绍通过AWR分析报告定位归档日志问题的方法。先从报告汇总结果计算一天产生的归档日志总容量,再查看Segments by DB Blocks Changes部分找DML量大的对象,结合SQL Statistics部分找相关SQL,计算其产生的归档日志量。还提到Segments by Physical Writes指标可参考但难算容量,最后找业务人员定位问题。

文章介绍通过AWR分析报告定位归档日志问题的方法。先从报告汇总结果计算一天产生的归档日志总容量,再查看Segments by DB Blocks Changes部分找DML量大的对象,结合SQL Statistics部分找相关SQL,计算其产生的归档日志量。还提到Segments by Physical Writes指标可参考但难算容量,最后找业务人员定位问题。

686

686

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?