摘要

本文面向中国AI应用开发者,系统讲解如何基于GIN框架高效集成AI模型服务,涵盖服务架构设计、接口实现、模型调用、性能优化等关键环节。配合架构图、流程图、思维导图、甘特图、饼图等多种可视化展示,辅以详细Python代码示例和最佳实践建议,助力开发者构建高性能、可扩展的AI推理服务。

目录

- 引言

- AI模型服务集成场景

- 系统架构与组件设计

- 接口设计与实现流程

- Python实践:AI模型服务对接

- 性能优化与监控

- 常见问题与注意事项

- 最佳实践与扩展阅读

- 实施计划甘特图

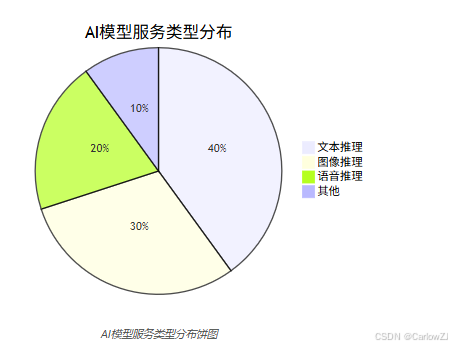

- 模型服务类型分布饼图

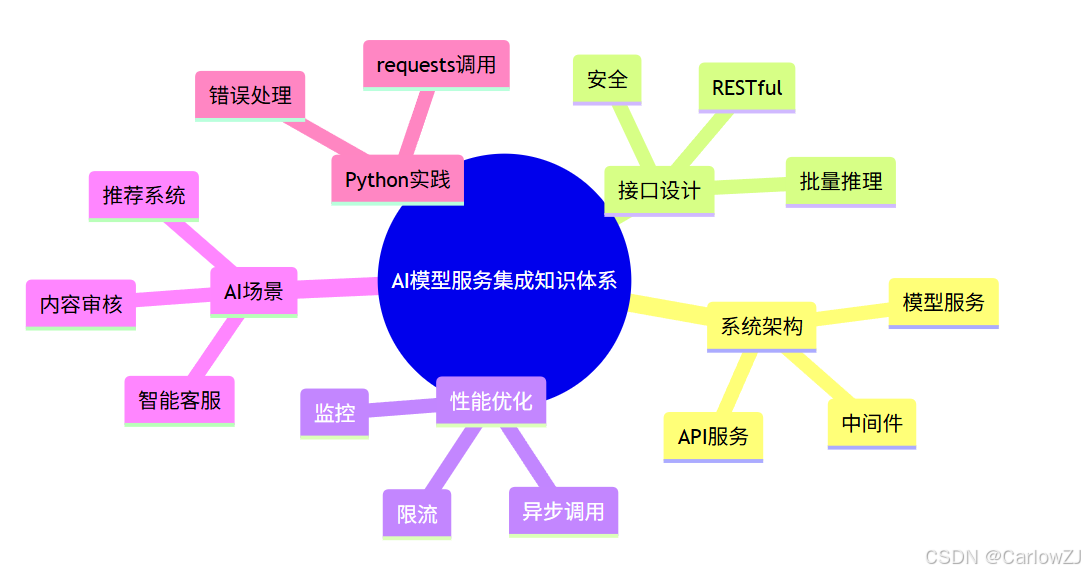

- 知识体系思维导图

- 总结

- 参考资料

引言

AI模型服务集成是智能应用落地的关键。GIN凭借高性能和灵活性,成为AI推理服务的理想选择。本文将带你系统掌握GIN与AI模型服务集成的全流程。

AI模型服务集成场景

- 在线推理API:文本、图像、语音等模型服务

- 批量数据处理:离线批量推理、数据标注

- 多模型管理:模型热更新、A/B测试

- 典型应用:智能客服、推荐系统、内容审核等

重点:

- 服务集成需关注接口设计、性能优化、模型安全等多维度

系统架构与组件设计

Mermaid架构图

AI模型服务集成系统架构图

接口设计与实现流程

- 统一RESTful接口风格,便于前后端协作

- 支持多种输入输出格式(JSON、文件等)

- 支持批量推理、异步任务

- 接口安全:鉴权、限流、日志

Mermaid流程图

AI模型服务接口处理流程

Python实践:AI模型服务对接

代码示例:调用远程AI模型服务

import requests

def call_model_service(text):

"""

调用远程AI模型推理服务

:param text: 输入文本

:return: 推理结果

"""

url = "http://localhost:8000/model/predict"

payload = {"text": text}

try:

response = requests.post(url, json=payload, timeout=5)

response.raise_for_status()

return response.json()

except requests.RequestException as e:

print("模型服务调用失败:", e)

return None

# 示例调用

result = call_model_service("你好,世界!")

print("模型推理结果:", result)

性能优化与监控

- 使用连接池、异步调用提升吞吐量

- 接口限流,防止模型服务被刷爆

- 日志与监控,追踪请求耗时与异常

- 模型服务可用性监控与自动重启

常见问题与注意事项

注意:

- 模型服务超时需合理设置,避免接口阻塞

- 输入输出需严格校验,防止脏数据影响模型

- 日志中避免泄露敏感信息

- 多模型场景需关注模型版本管理

最佳实践与扩展阅读

- 推荐使用RESTful接口风格,便于扩展

- 模型服务建议容器化部署,便于弹性伸缩

- 日志、监控、限流建议用成熟中间件

- 推荐阅读:AI模型服务最佳实践

实施计划甘特图

AI模型服务集成甘特图

模型服务类型分布饼图

知识体系思维导图

mindmap

root((AI模型服务集成知识体系))

系统架构

API服务

中间件

模型服务

接口设计

RESTful

批量推理

安全

性能优化

异步调用

限流

监控

AI场景

智能客服

推荐系统

内容审核

Python实践

requests调用

错误处理

AI模型服务集成知识体系思维导图

总结

本文系统讲解了GIN与AI模型服务集成的架构设计、接口实现、性能优化等关键环节,并结合Python实践演示了模型服务对接方法。建议开发者在AI服务开发中,关注接口健壮性、性能与安全,持续优化服务架构以适应业务发展。

参考资料

如需获取更多GIN与AI开发实战内容,欢迎关注后续系列博客!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?