摘要

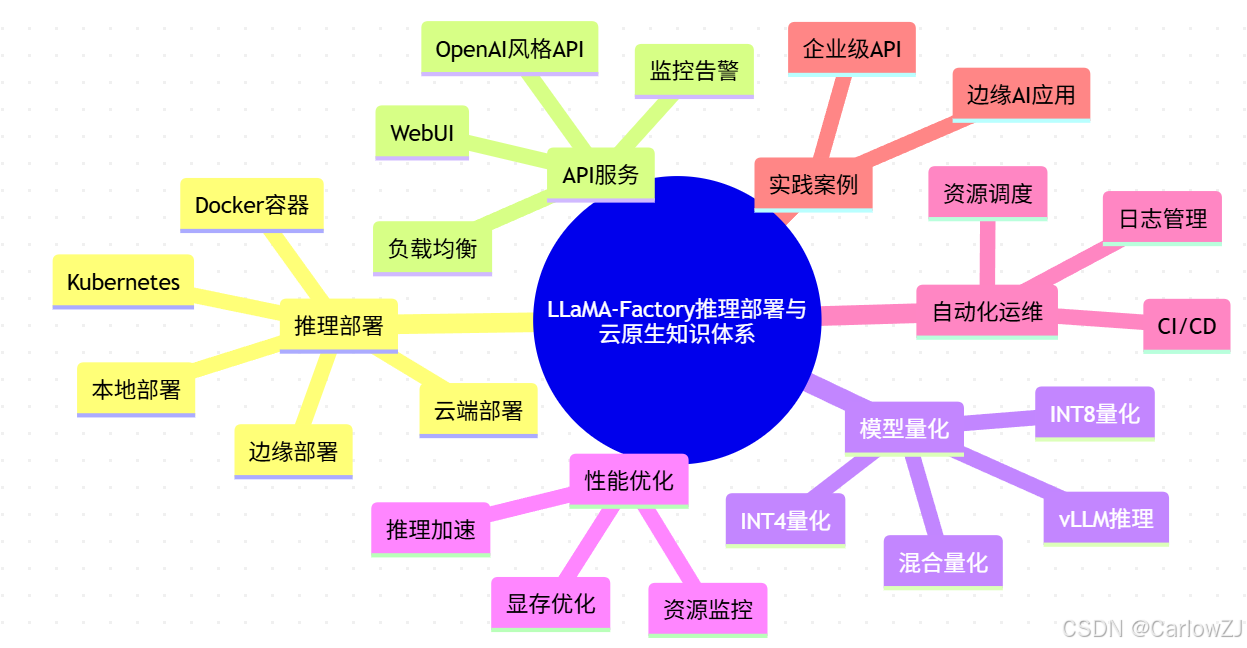

LLaMA-Factory不仅支持高效的大模型微调,还为AI模型推理部署、API服务、模型压缩、边缘部署、云原生与跨平台适配等提供了全流程解决方案。本文系统梳理LLaMA-Factory在推理部署、API服务、模型量化、云原生与自动化运维等方面的核心机制与最佳实践,配合丰富的Python代码、Mermaid图表、常见问题与实施建议,助力中国开发者高效打造可扩展、可维护的AI推理服务平台。

适用人群: AI应用开发者、MLOps工程师、企业技术团队、平台架构师

目录

- 知识体系思维导图

- 系统架构图

- 推理部署方式分布饼图

- 实施计划甘特图

- 推理部署业务流程图

- API推理服务时序图

- 推理部署全景与对比

- API服务与边缘部署

- 模型量化与压缩实践

- 云原生与自动化运维

- 性能优化与监控

- 实践案例与常见问题

- 最佳实践与扩展阅读

- 参考资料

- 总结

1. 知识体系思维导图

mindmap

root((LLaMA-Factory推理部署与云原生知识体系))

推理部署

本地部署

云端部署

边缘部署

Docker容器

Kubernetes

API服务

OpenAI风格API

WebUI

负载均衡

监控告警

模型量化

INT8量化

INT4量化

混合量化

vLLM推理

性能优化

显存优化

推理加速

资源监控

自动化运维

CI/CD

日志管理

资源调度

实践案例

企业级API

边缘AI应用

2. 系统架构图

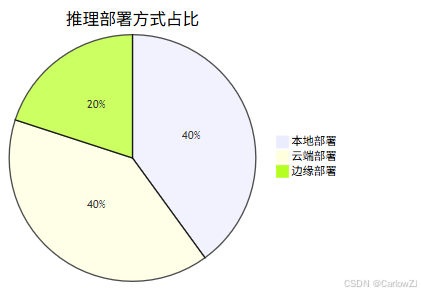

3. 推理部署方式分布饼图

4. 实施计划甘特图

5. 推理部署业务流程图

6. API推理服务时序图

7. 推理部署全景与对比

7.1 推理部署方式

- 本地部署:适合小规模、开发测试场景,配置灵活。

- 云端部署:适合大规模、弹性扩展,支持Kubernetes等云原生方案。

- 边缘部署:适合低延迟、隐私敏感场景,支持模型压缩与量化。

注意:

- 本地部署适合开发测试,云端/边缘部署需关注资源与安全

- 量化与压缩可大幅提升推理效率

8. API服务与边缘部署

8.1 API服务架构

- 支持OpenAI风格API,兼容主流前端

- 支持WebUI可视化推理

- 支持负载均衡与高可用

Python API服务示例

from llamafactory import create_model_and_tokenizer

from fastapi import FastAPI, Request

import uvicorn

app = FastAPI()

model, tokenizer = create_model_and_tokenizer('llama3-8b')

@app.post("/v1/chat/completions")

async def chat(request: Request):

data = await request.json()

prompt = data["messages"][-1]["content"]

# 推理

output = model.generate(tokenizer(prompt, return_tensors="pt").input_ids, max_new_tokens=128)

return {"choices": [{"message": {"content": tokenizer.decode(output[0], skip_special_tokens=True)}}]}

if __name__ == "__main__":

uvicorn.run(app, host="0.0.0.0", port=8000)

8.2 边缘部署架构

- 支持模型压缩、量化,适配低功耗设备

- 支持本地推理与隐私保护

9. 模型量化与压缩实践

9.1 量化方法原理

- INT8/INT4量化:降低模型精度,减少显存与加速推理

- 混合量化:部分模块高精度,兼顾精度与效率

Python量化代码示例

from llamafactory import create_model_and_tokenizer

import torch.quantization

# 加载模型和分词器

model, tokenizer = create_model_and_tokenizer("./output/full_model")

# 应用INT8量化

quantized_model = torch.quantization.quantize_dynamic(

model, {torch.nn.Linear}, dtype=torch.qint8

)

# 保存量化模型

quantized_model.save_pretrained("./output/quantized_model")

最佳实践:

- 量化前后需评估精度变化

- 可结合混合量化提升兼容性

10. 云原生与自动化运维

10.1 Docker容器化

- 提供官方Dockerfile,支持一键构建与部署

- 支持数据卷、GPU加速、端口映射

Dockerfile示例

FROM python:3.9-slim

WORKDIR /app

COPY requirements.txt .

RUN pip install -r requirements.txt

COPY . .

CMD ["uvicorn", "main:app", "--host", "0.0.0.0", "--port", "8000"]

10.2 Kubernetes部署

- 支持多副本弹性扩缩容

- 支持GPU资源调度与监控

Kubernetes部署片段

apiVersion: apps/v1

kind: Deployment

metadata:

name: llama-factory

spec:

replicas: 3

selector:

matchLabels:

app: llama-factory

template:

metadata:

labels:

app: llama-factory

spec:

containers:

- name: llama-factory

image: llama-factory:latest

ports:

- containerPort: 8000

resources:

limits:

nvidia.com/gpu: 1

11. 性能优化与监控

11.1 推理性能优化

- 启用vLLM、模型量化、批处理推理

- 合理配置并发与资源分配

11.2 监控与日志管理

- 监控API响应时间、资源使用、错误率

- 日志记录请求、错误、性能等信息

12. 实践案例与常见问题

12.1 实践案例

- 案例1:企业级API推理服务

- 某互联网企业基于LLaMA-Factory,采用云原生Kubernetes部署,支持高并发API推理服务,显著提升了业务响应速度与系统可维护性。

- 案例2:边缘AI应用

- 某制造企业利用LLaMA-Factory模型量化与压缩能力,将大模型部署到边缘设备,实现本地智能质检与隐私保护。

12.2 常见问题FAQ

- Q:推理部署时显存不足怎么办?

- A:优先使用模型量化、混合精度、批处理推理等技术,或减小batch size。

- Q:API服务不稳定如何排查?

- A:检查资源分配、负载均衡与监控配置,参考官方API部署指南。

- Q:云原生部署镜像拉取失败?

- A:检查网络与镜像仓库配置,建议使用国内镜像源。

- Q:边缘设备推理速度慢?

- A:尝试更深度的模型压缩或调整推理参数。

13. 最佳实践与扩展阅读

13.1 最佳实践

- 资源评估:根据硬件资源选择本地/云端/边缘部署方案

- 配置合理:推理与API服务需精细配置,建议参考官方示例

- 监控全程:推理、API、云原生全流程监控,及时调整

- 安全合规:注意数据隐私与模型安全

- 持续学习:关注社区与官方文档更新

13.2 扩展阅读

14. 参考资料

- LLaMA-Factory官方文档与源码

- HuggingFace Datasets官方文档

- 相关模型量化与云原生部署论文

- 业界开源平台与工具链

15. 总结

LLaMA-Factory以其高效的推理部署、API服务、模型量化与云原生能力,为中国AI开发者和企业团队提供了高效、可扩展、可维护的AI推理服务平台。掌握推理部署、API服务、模型量化、云原生与自动化运维等关键技术,将极大提升AI工程化落地效率。建议结合自身业务场景,灵活集成生态组件,持续优化运维体系,拥抱AI时代的创新浪潮!

如需进一步细化某一章节、添加案例或有其他定制需求,欢迎随时提出!

337

337

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?