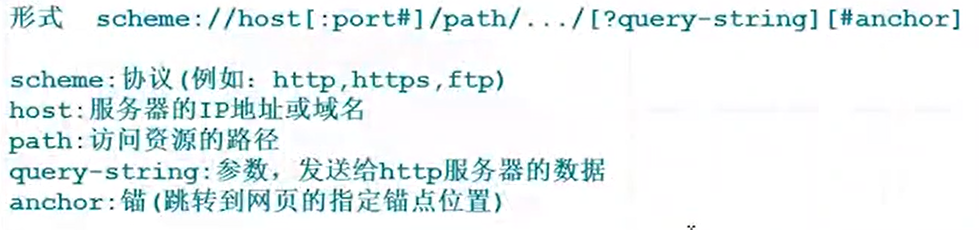

先了解url:

爬虫:web请求响应的过程

服务器端的渲染:

我们的电脑请求别人的电脑,然后别人的电脑上组装好数据再发送给我们,呈现在我们的电脑上(秒显示)

客户端的渲染:

我们的电脑请求别人的电脑后,别人的电脑给了我们一个框架,我们再请求数据,得到数据和框架后,我们在自己的电脑上组装渲染好了呈现出来

查找经过第二次请求的数据:后台抓包 F12 - Network(网络)

点击Fetch/XHR,刷新一下,就能看到一些网址,从这里面找寻第二次请求得到的网址

点击【预览】,找寻想要的数据

找到了,这个在本地渲染出来的数据(这类数据会在打开网址后缓慢显示出来,因为需要时间加载)

怎么看请求的是哪一个网址,看它的【标头】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?