(一)线性可分的情况

支持向量机是一个非常经典的二分类算法。假设有一组数据,这组数据由两种类别组成。要画一条直线将其分开,可以有无数条。那这些直线哪条是最好的呢。

如果把上面的点想象成地雷,士兵要从他们中间开辟一条道路。这条道路当然是越宽越好了(中线离雷区越远越好)。

上面这两张图,明显右边的哪条分界线要好一点。既然要选出离雷区远的边界,那就要计算点到超平面(二维空间下是直线)的距离。

超平面的方程为 ,w为这个超平面的法向量,

,w为这个超平面的法向量, 是超平面上的一点。由此可以得出

是超平面上的一点。由此可以得出 。要求点X到该超平面的距离,可以先求出X到

。要求点X到该超平面的距离,可以先求出X到 的距离,然后在投影到法向量。复习一下向量投影公式

的距离,然后在投影到法向量。复习一下向量投影公式

向量a·向量b=| a |*| b |*cosΘ

Θ为两向量夹角

| b |*cosΘ叫做向量b在向量a上的投影

| a |*cosΘ叫做向量a在向量b上的投影

距离公式为:

假设有数据集:(X1,Y1)(X2,Y2)… (Xn,Yn)

Y为样本的类别: 当X为正例时候 Y = +1 当X为负例时候 Y = -1

决策方程:

(其中 是对数据做了变换,后面继续说)

是对数据做了变换,后面继续说)

如果决策方程大于0,将其分类为正例,反之分类为负例

因此点到超平面的距离可写为

,

,

(由于  所以将绝对值展开原始依旧成立,这就是几何距离,其中分子又单独称为函数距离

所以将绝对值展开原始依旧成立,这就是几何距离,其中分子又单独称为函数距离

我们的优化目标是找到一个超平面(w,b),使得离这个超平面最近的点能够最远,这里比较难理解,但这是看懂后面内容的基础。

优化目标:

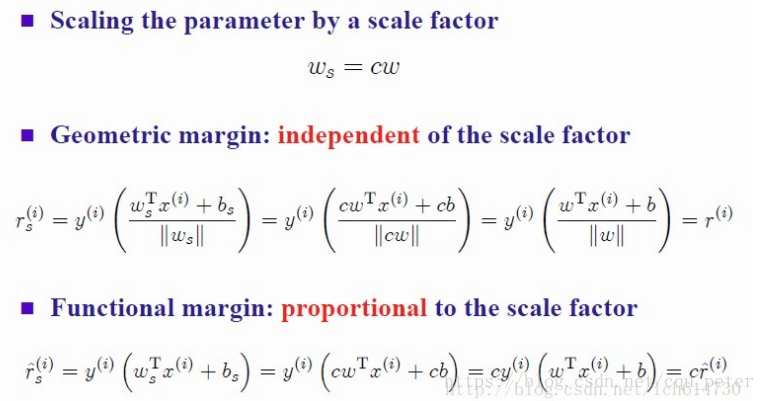

我们可以把w,b同时缩放c倍为cw,cb,这样超平面的方程也不会变的,因此我们可以将函数距离缩放为任意一个值。而且缩放后不会影响几何距离的大小。

因此我们可以通过缩放使函数距离大于等于1

本文介绍了支持向量机(SVM)的概念,重点讲解了在线性可分情况下的超平面选择,如何通过优化目标找到最佳分界线,以及支持向量的作用。此外,还提到了面对噪声点的软间隔处理和非线性可分问题的解决方案——核函数,特别是高斯核的使用。

本文介绍了支持向量机(SVM)的概念,重点讲解了在线性可分情况下的超平面选择,如何通过优化目标找到最佳分界线,以及支持向量的作用。此外,还提到了面对噪声点的软间隔处理和非线性可分问题的解决方案——核函数,特别是高斯核的使用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1536

1536

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?