你好,我是坚持分享干货的 EarlGrey,翻译出版过《Python编程无师自通》、《Python并行计算手册》等技术书籍。

如果我的分享对你有帮助,请关注我,一起向上进击。

Copilot,是一款基于AI的、应用于写程序场景的工具;可以自动地生成高质量代码片段、注释、以及解释代码;它需要付费使用,月订阅费用10美元。

但在本文中,我们将在本地运行Code Llma 7B,从而自制一个免费的Vscode Copilot!

步骤很简单:

设置 Cody 和 VSCode

使用 Ollama 安装本地 Code Llama 7B

使用 Cody 提高编码效率

Cody

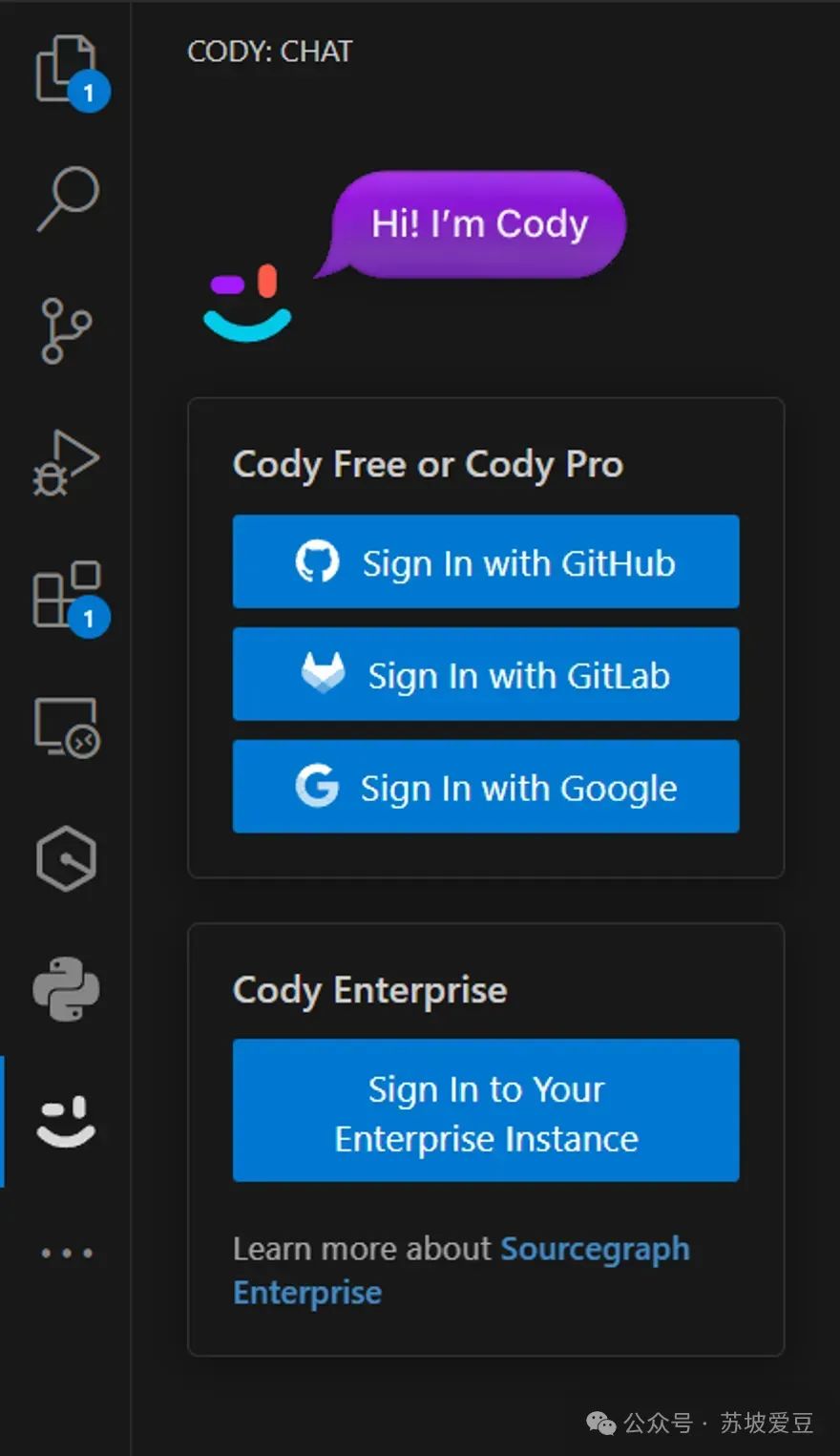

打开 VSCode,导航到“Extension”选项卡并搜索“Cody”。,在搜索结果中找到“Cody AI”并安装“Pre Release Version”

然后,使用google账户或者github账户登录Cody:

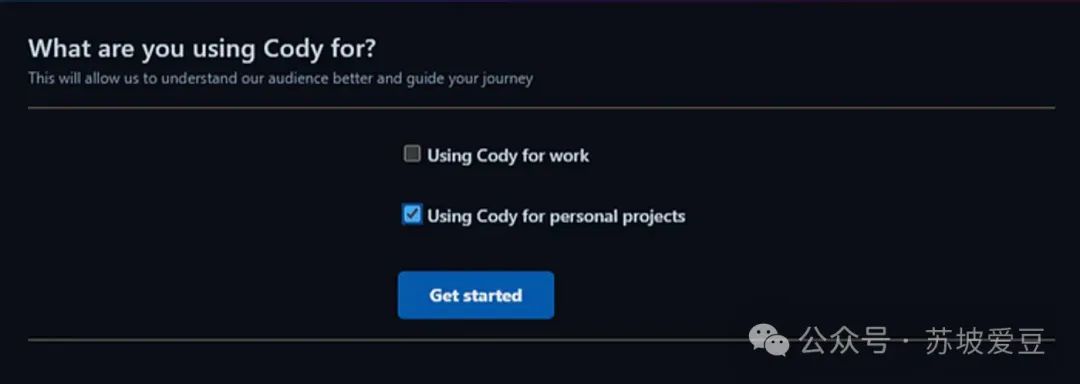

选择您的使用目的:为个人项目

然后,授权 Cody 并复制您的 VSCode 扩展令牌

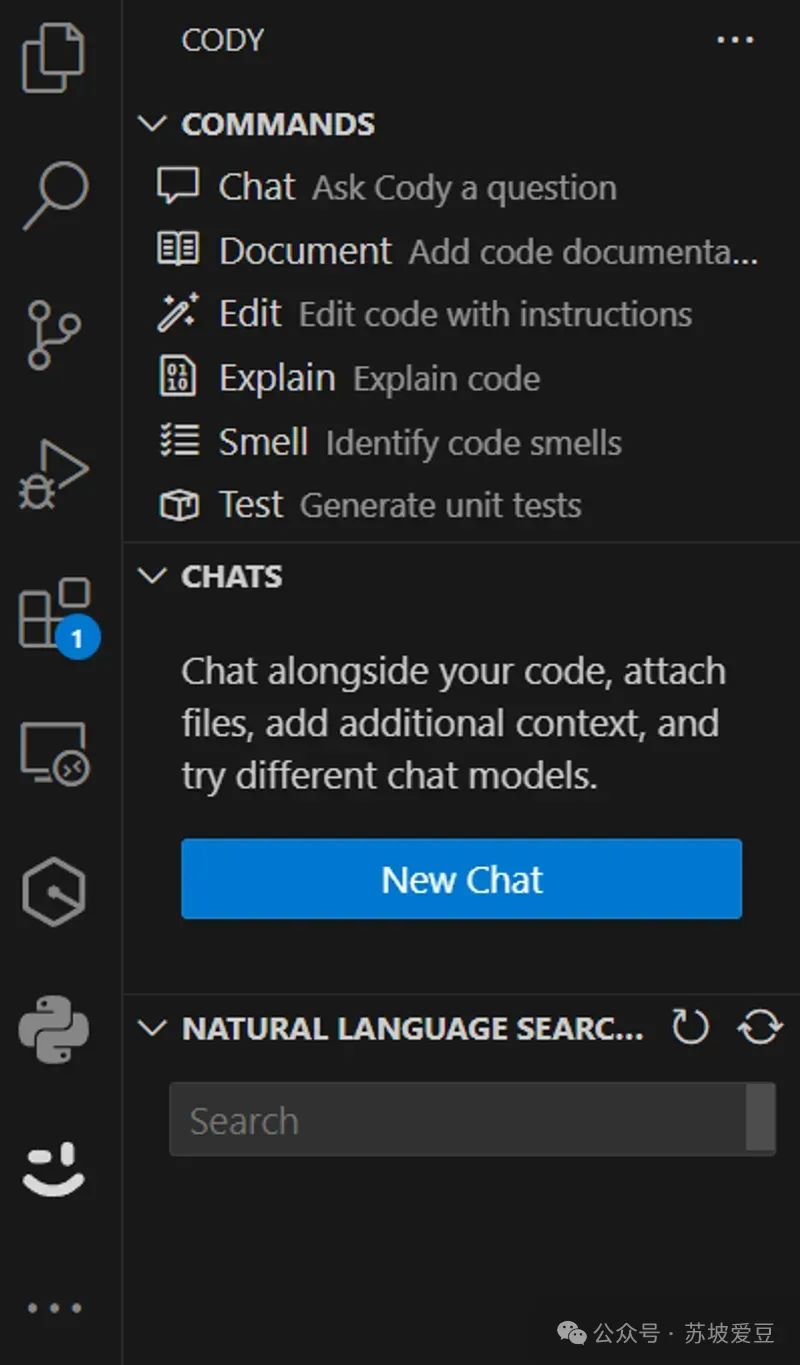

一旦获得授权,它将再次打开 VSCode:如果一切顺利,将会在左边栏看到以下可用指令:

默认情况下,Cody 使用 gpt-4,然后每月费用为 9 美元,这对于我们来说还是太贵了!因此,接下来安装Code-llama,使用本地、免费的模型替代GPT-4!

使用 Ollama 运行 Cody 和本地LLM

首先介绍一下Ollama,它是一个简明易用的本地大模型运行框架,允许用户在mac和linux(Windows即将推出)上轻松部署LLM。

打开浏览器并访问 Ollama.ai ,安装 Ollama,它适用于 macOS 和 Linux。由于我在 Windows 上使用 WSL 2,因此我将设置 Linux 版本。

整个安装过程只需要几秒钟:

配置Code Llama 7B

要开始使用 Ollama,我们首先需要启动 Ollama server:

ollama serve然后打开另一个终端,运行:

ollama pull codellama:7b-code这个命令会下载 Code Llama 7B。

Code Llama 是 Llama 2 的微调版本,在专门的代码数据集上进行了训练。它可以理解和生成代码以及有关代码的注释,相对Llama2,它能更好地回答关于代码的问题。Code Llama 还擅长代码补全和调试,它支持多种流行的编程语言,包括 Python、C++、Java、PHP、Typescript (Javascript)、C# 和 Bash,因此是一个适用于本地copilot的LLM。

下载完成后,模型就可以使用了:

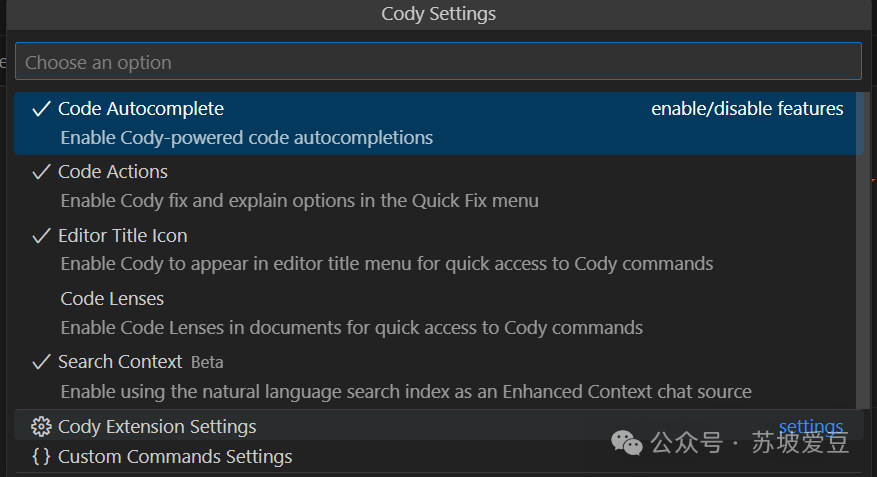

接下来,打开vscode,导航至 Cody 的“设置”

然后单击“Cody Extension Settings”:

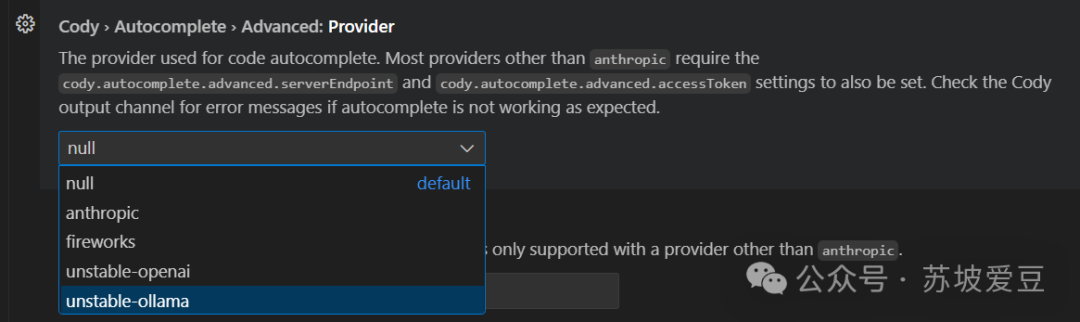

向下滚动并找到“Cody > Autocomplete > Advanced: Provider”,然后选择“unstable-ollama”

现在,使用CodeLlama 7B的Copilot就设置好了!

使用 Cody 和 CodeLlama 7B 进行编码

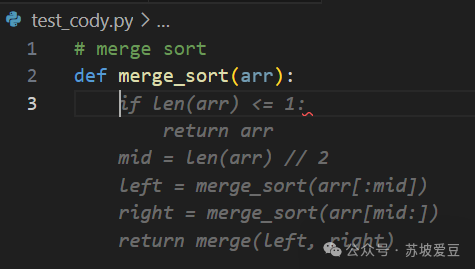

创建一个 python 文件,写一个排序代码,可以看到:在写好注释与函数头之后,Code Llama已经帮我们写好了剩下的代码:

你还可以在右边栏看到和 Cody 聊天的对话框:

我们继续让LLM实现merge方法:

还可以在Vscode终端中看到Cody向 Ollama 服务器发出的请求。

结论

使用Code Llama 7B在本地搭建你自己的Copilot,可以省去gpt4订阅的费用,并且更快地体会到LLM对日常工作带来的便利。探索并应用这些AI工具,我们正在成为这场AI变革趋势的一部分。

- EOF -

文章已经看到这了,别忘了在右下角点个“赞”和“在看”鼓励哦~

推荐阅读 点击标题可跳转

回复下方「关键词」,获取优质资源

回复关键词「 pybook03」,领取进击的Grey与小伙伴一起翻译的《Think Python 2e》电子版

回复关键词「书单02」,领取进击的Grey整理的 10 本 Python 入门书的电子版

👇关注我的公众号👇

告诉你更多细节干货

欢迎围观我的朋友圈

👆每天更新所想所悟

1687

1687

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?