|

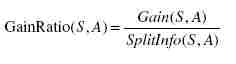

决策树算法是应用最广泛的分类方法之一[51] 。其核心算法是ID3算法和后来的改进算法C4.5算法。与ID3相比,C4.5主要改进如下: ① 用信息增益率来选择属性,克服了用信息增益来选择属性时偏向选择值多的属性的不足。信息增益率定义为:

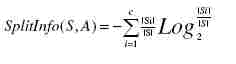

其中Gain(S,A)与ID3算法中的信息增益相同,而分裂信息SplitInfo(S,A)代表了按照属性A分裂样本集S的广度和均匀性。

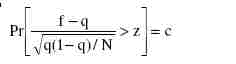

其中,S1到Sc是c个不同值的属性A分割S而形成的c个样本子集。 ② 可以处理连续数值型属性。例如,假设A为一个连续的数值型属性,首先检查样本集中该属性的所有取值,然后将其按升序排列为A1,A2,…,Am。对于每一个Aj,j=1,2,…,m-1,将样本集划分为两个样本子集,一子集是各记录属性A的值均小于等于Aj,另一子集是其各记录属性A的值均大于Aj。对于每个划分,计算相应的信息增益率,然后选择增益率最大的划分,作为属性A的信息增益率。 ③ 为了避免树的高度无节制的增长,避免过度拟合数据,采用了一种后剪枝方法,该方法是从一种称为”规则后修剪”(rule post-pruning)的方法演变而来。该方法使用训练样本集本身来估计剪枝前后的误差,从而决定是否真正剪枝。方法中使用的公式如下:

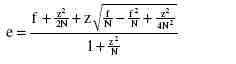

其中N是实例的数量,f=E/N为观察到的误差率(其中E为N个实例中分类错误的个数),q为真实的误差率,c为置信度(C4.5算法的一个输入参数,默认值为0.25),z为对应于置信度c的标准差,其值可根据c的设定值通过查正态分布表得到。通过该公式即可计算出真实误差率q的一个置信度上限,用此上限为该节点误差率e做一个悲观的估计:

通过判断剪枝前后e的大小,从而决定是否需要剪枝。 ④ 对于缺失值的处理。在某些情况下,可供使用的数据可能缺少某些属性的值。假如〈x,c(x)〉是样本集S中的一个训练实例,但是其属性A的值A(x)未知。处理缺少属性值的一种策略是赋给它结点n所对应的训练实例中该属性的最常见值;另外一种更复杂的策略是为A的每个可能值赋予一个概率。例如,给定一个布尔属性A,如果结点n包含6个已知A=1和4个A=0的实例,那么A(x)=1的概率是0.6,而A(x)=0的概率是0.4。于是,实例x的60%被分配到A=1的分支,40%被分配到另一个分支。这些片断样例(fractional examples)的目的是计算信息增益,另外,如果有第二个缺少值的属性必须被测试,这些样例可以在后继的树分支中被进一步细分。C4.5就是使用这种方法处理缺少的属性值。 |

C4.5主要改进

最新推荐文章于 2023-07-26 13:43:09 发布

4933

4933

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?