1、什么是激活函数?

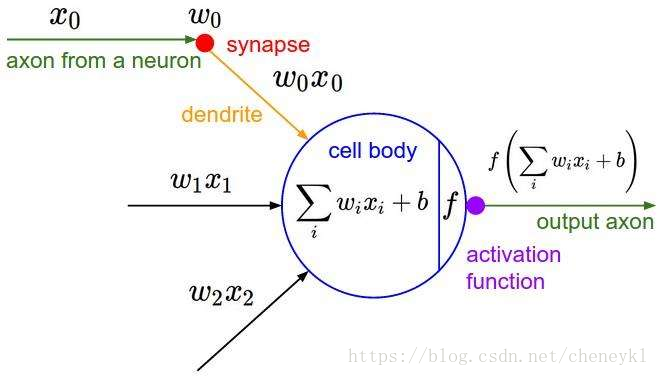

在神经元中,输入input,通过加权求和之后再通过了一个函数的变换处理,这个函数就是激活函数(Activition Function)

2、激活函数的作用?

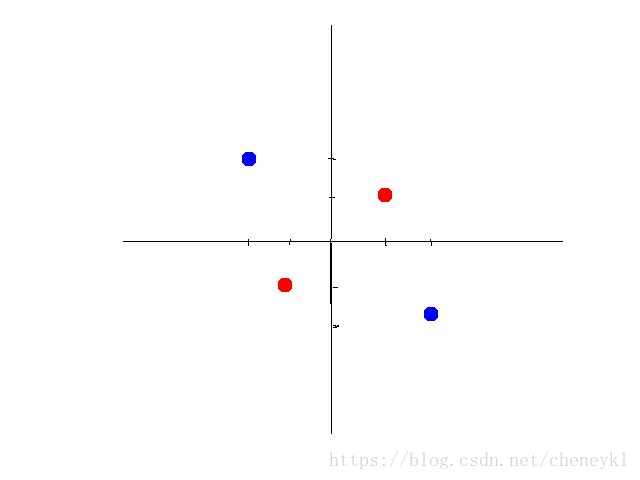

模型的表达能力不够,引入激活函数是为了添加非线性因素。

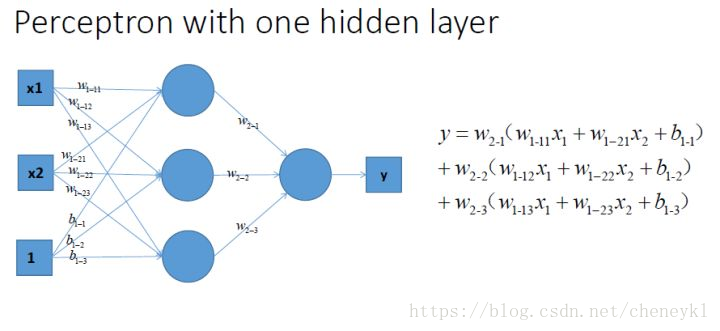

不添加激活函数的时候,无论多少层网络输出都是线性方程

添加了激活函数之后就可以解决类似下图这样一些线性不可分的情况:

通用近似定理:单隐层神经网络只要隐层神经元的个数足够多,可以以任何精度逼近任何连续函数。

所以使用激活函数就能将神经网络运用到很多其他非线性模型中去。

3、常见的激活函数?

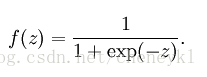

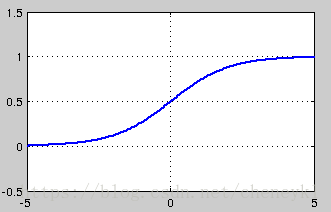

(1)sigmoid 函数

特点:可以将输出压缩到0-1的范围;总是正数;有界;严格递增

缺点:会出现梯度消失(

激活函数是神经网络中的关键元素,其引入增加了模型的非线性能力。sigmoid函数因梯度消失问题而限制了深层网络的训练,ReLU函数解决了这一问题并加速了梯度下降,但存在神经元死亡现象。Tanh函数是对sigmoid的改进,但依然有梯度消失问题。Swish函数作为平滑的非单调函数,表现优秀。选择激活函数需根据网络结构和需求,ReLU和Swish是常用选择。

激活函数是神经网络中的关键元素,其引入增加了模型的非线性能力。sigmoid函数因梯度消失问题而限制了深层网络的训练,ReLU函数解决了这一问题并加速了梯度下降,但存在神经元死亡现象。Tanh函数是对sigmoid的改进,但依然有梯度消失问题。Swish函数作为平滑的非单调函数,表现优秀。选择激活函数需根据网络结构和需求,ReLU和Swish是常用选择。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1248

1248

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?