思考

1. 卷积神经网络如何减少参数量和计算量

- relu激活函数

- dropout

- 使用1×1卷积核进行减少参数量和计算量

- 对标准卷积的拆分(使用深度可分离卷积)

2. 各类经典卷积网络的特点

3. 卷积计算量的计算

4. 注意区分1x1 PW conv 和 1x1 GConv

经典卷积网络

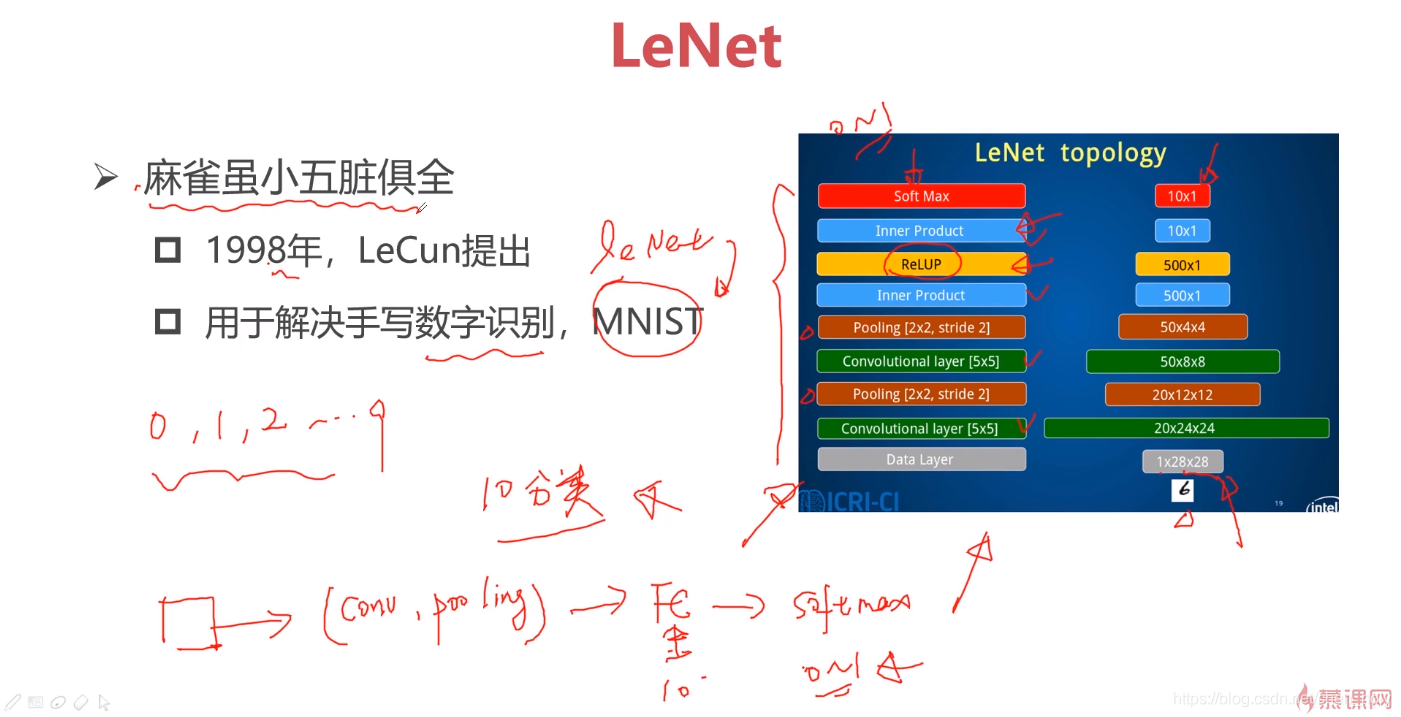

LetNet

通常 简单的分类网络结构:

输入 - 卷积池化(层数未定) - 全连接(层数未定) - 输出

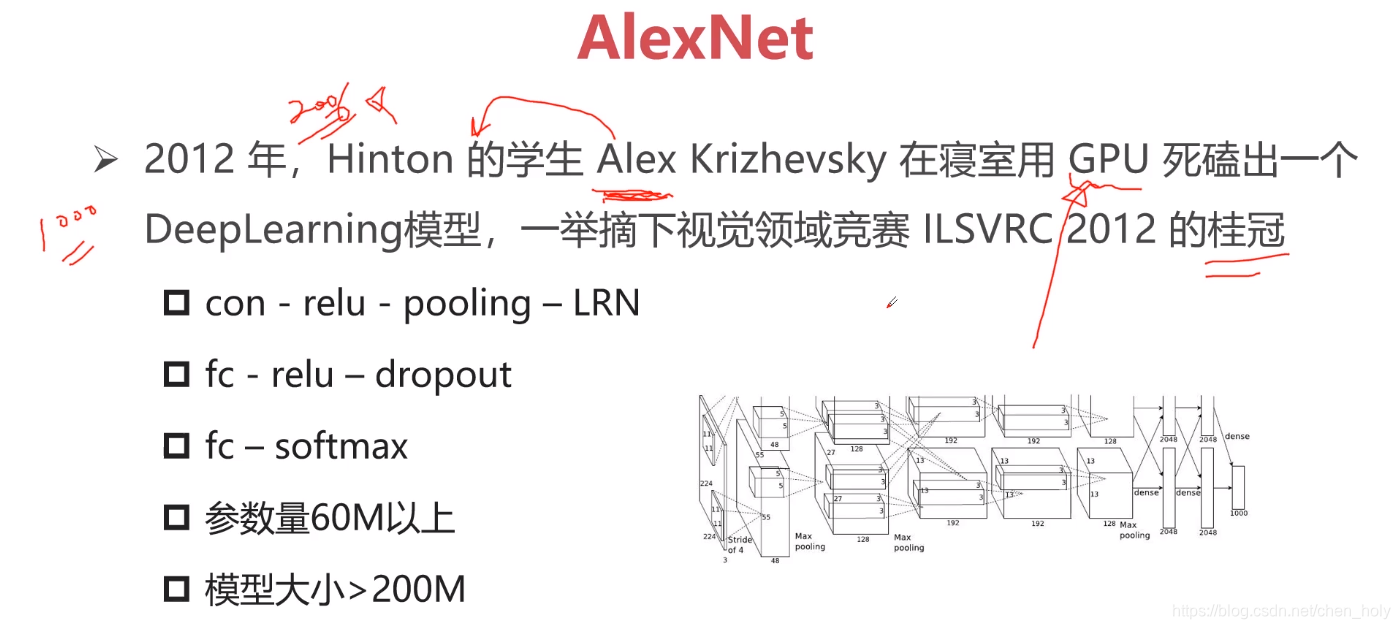

AlexNet

两条分支是因为当时硬件资源有限,将网络分开上下两部分进行训练

- Relu

1.计算速度更快 (相比于有指数运算的激活函数)

2. x>0部分不会出现梯度消失

3. 作为非饱和型函数,可以更好地表现出x对y的影响

- LRN

局部归一化

不过听说作用不大,目前几乎不使用了

- dropout

一般在全连接层使用

但听说也有在卷积层使用的,然后用贝叶斯进行解释

实验证明复杂模型的有效性

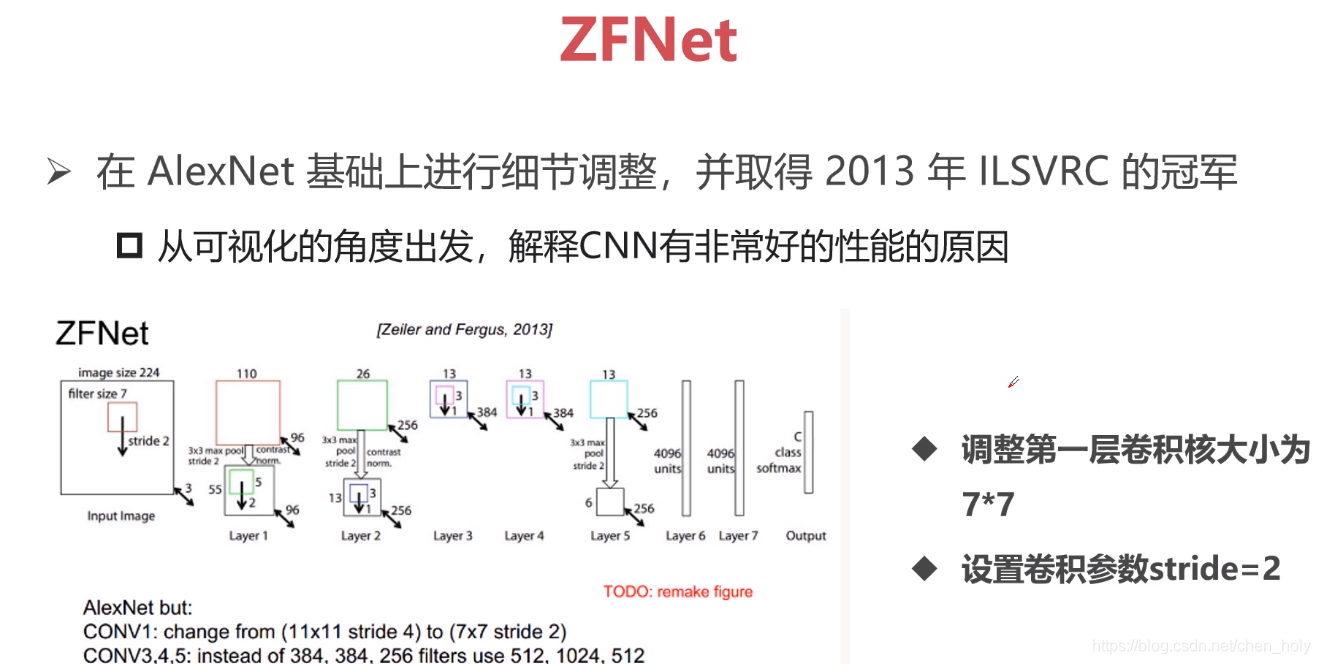

ZFNet

将AlexNet中 11×11的卷积核设置成7×7,4步长设置成2步长

用更小的卷积核以及更小的步长提取出了更好地特征

浅层特征 - 轮廓 纹理信息

深层特征 - 语义信息

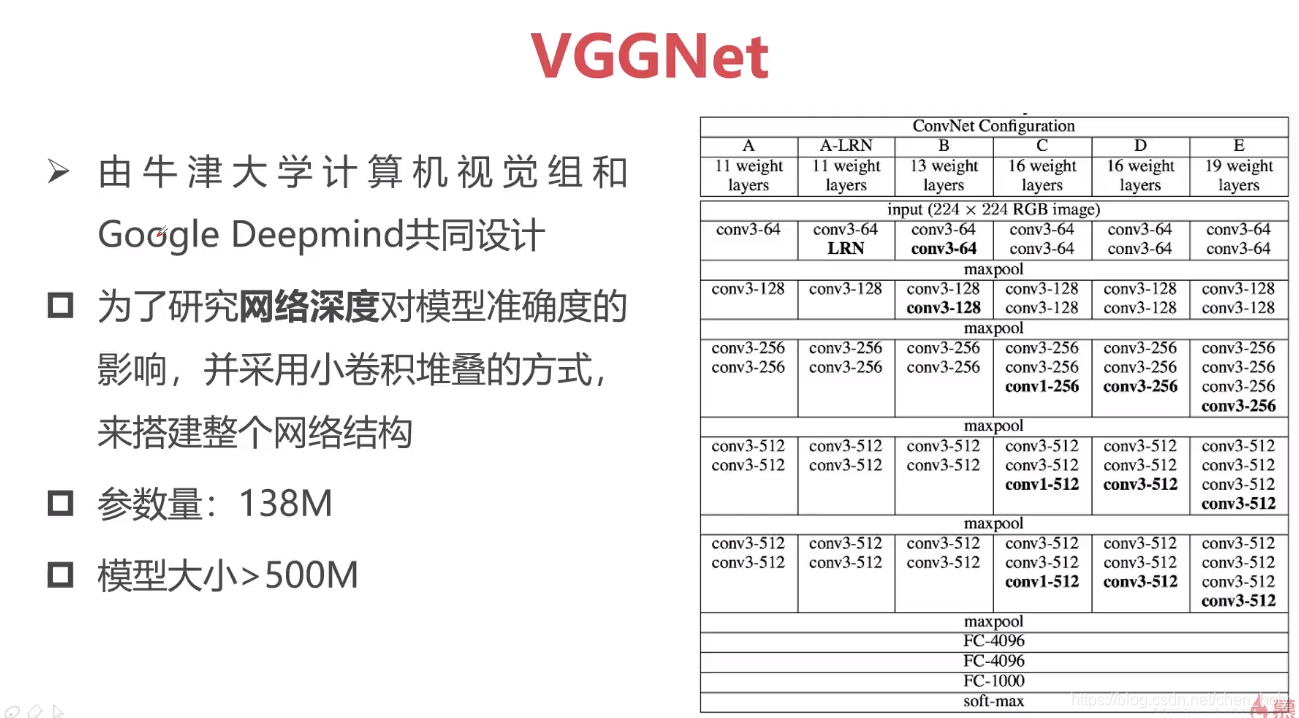

VGG

80%的参数量集中在FC层

网络设计更规范化

本文深入探讨卷积神经网络的设计,包括经典的LeNet、AlexNet、VGG、ResNet等,强调ReLU激活函数和dropout在防止过拟合中的作用。文章还讨论了轻量级网络如使用深度可分离卷积来减少参数和计算成本,并介绍了多分支卷积网络和度量学习中的注意力机制。最后,简述了模型压缩技术,如权重裁剪,以适应硬件限制。

本文深入探讨卷积神经网络的设计,包括经典的LeNet、AlexNet、VGG、ResNet等,强调ReLU激活函数和dropout在防止过拟合中的作用。文章还讨论了轻量级网络如使用深度可分离卷积来减少参数和计算成本,并介绍了多分支卷积网络和度量学习中的注意力机制。最后,简述了模型压缩技术,如权重裁剪,以适应硬件限制。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

663

663

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?