✅ 博主简介:擅长数据搜集与处理、建模仿真、程序设计、仿真代码、论文写作与指导,毕业论文、期刊论文经验交流。

✅ 具体问题可以私信或扫描文章底部二维码。

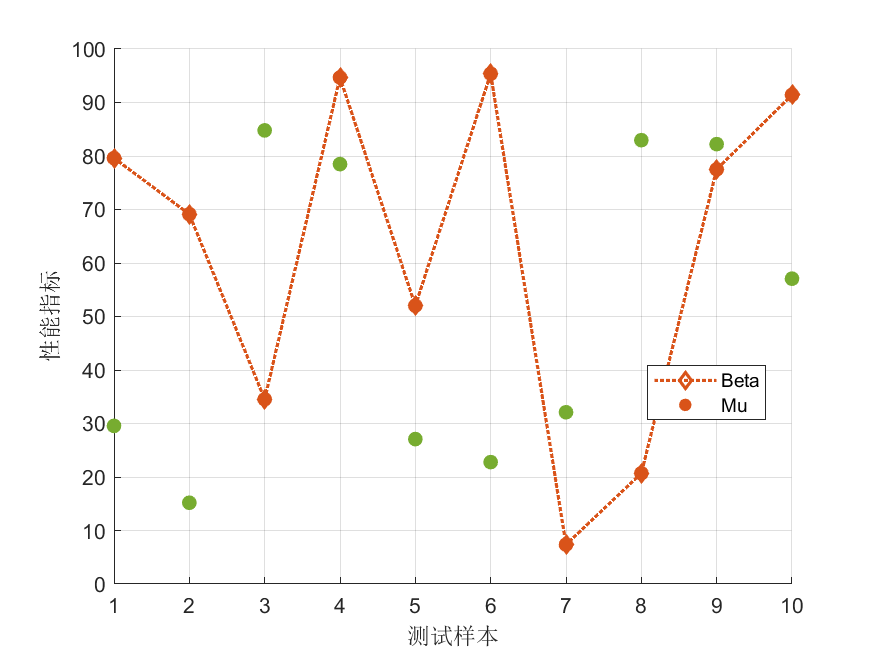

(1)为了克服基本鸽群优化算法(PIO)在复杂多峰函数寻优中存在的收敛速度慢和易陷入局部最优的缺陷,本研究首先引入了发现者策略,提出了一种基于发现者策略的改进鸽群优化算法。在生物学中,鸽群飞行时通常由少数经验丰富的个体(发现者)引领方向,而大多数个体(跟随者)则跟随飞行。本研究将这一机制引入算法,在地图指南针算子阶段,随机选取部分适应度较好的个体作为发现者,赋予其更大的搜索步长和独立的搜索方向,使其能够脱离当前的群体趋势去探索未知的解空间。这种策略有效地打破了算法初期盲目跟随导致的早熟收敛现象。通过对23个标准基准函数的测试,并与粒子群算法、差分进化算法等7种主流启发式算法进行对比,结果表明引入发现者策略后,算法在单峰和多峰函数上的寻优精度大幅提升,且收敛曲线下降更为迅速,证明了策略的有效性。

(2)针对电力系统经济调度这一具有非凸、非线性特征的复杂工程问题,本研究提出了一种基于混沌初始化和高斯变异的改进鸽群优化算法。电力系统经济调度需要考虑阀点效应产生的非平滑成本曲线。为此,首先利用立方混沌映射(Cubic Chaos Map)对鸽群进行初始化。混沌映射的遍历性保证了初始种群在解空间中的均匀分布,避免了随机初始化造成的分布死角。其次,在算法迭代过程中,对全局最优个体施加高斯变异。高斯变异能够在最优解附近产生小范围的随机扰动,当算法停滞在局部极值点时,这种扰动有助于算法跳出陷阱并继续向全局最优逼近。此外,引入递减因子动态调整速度权重,平衡算法的全局与局部搜索。实验结果显示,该算法在处理包含阀点效应的经济调度问题时,能够获得比传统算法更低的发电成本,证明了其在解决实际非线性约束优化问题上的潜力。

(3)为了进一步拓展鸽群优化算法的应用范围,并增强其后期开发的稳定性,本研究提出了一种基于灰狼捕食策略的鸽群优化算法,并将其应用于混合储能系统的容量优化配置中。在鸽群算法的地标算子阶段(即迭代后期),传统的做法是直接丢弃一半的劣势个体,这可能导致有效信息的丢失。本研究引入灰狼优化算法中的包围、狩猎和攻击机制,模拟灰狼群体的协作捕食行为。在算法后期,利用灰狼策略引导鸽群向着最优解(猎物)方向进行精细化搜索,增强了算法在小范围内的深度挖掘能力。将该改进算法应用于风光互补混合储能系统的容量配置问题,目标是在满足负荷缺电率和平抑波动指标的前提下,最小化系统的全寿命周期成本。实际案例分析表明,与其他5种群体智能算法相比,基于灰狼捕食策略的鸽群算法所得出的配置方案成本更低,系统可靠性更高,验证了该混合策略在能源系统规划领域的适用性。

import numpy as np

import math

import random

class ImprovedPIO:

def __init__(self, cost_func, bounds, pop_size=30, max_iter=100, R=0.2):

self.cost_func = cost_func

self.bounds = bounds

self.dim = len(bounds)

self.pop_size = pop_size

self.max_iter = max_iter

self.R = R # Map and Compass factor

self.pos = []

self.vel = []

self.fitness = []

self.gbest_pos = None

self.gbest_fit = float('inf')

def cubic_chaos_init(self):

self.pos = np.zeros((self.pop_size, self.dim))

self.vel = np.random.rand(self.pop_size, self.dim)

# Cubic map generation

y = np.random.rand(self.dim)

for i in range(self.pop_size):

for j in range(self.dim):

y[j] = 4 * y[j]**3 - 3 * y[j]

# Map to bounds

normalized = (y[j] + 1) / 2 # approx normalization

self.pos[i, j] = self.bounds[j][0] + normalized * (self.bounds[j][1] - self.bounds[j][0])

fit = self.cost_func(self.pos[i])

self.fitness.append(fit)

if fit < self.gbest_fit:

self.gbest_fit = fit

self.gbest_pos = self.pos[i].copy()

def gaussian_mutation(self, position):

mutation = position + np.random.normal(0, 1.0, self.dim) * 0.1

return np.clip(mutation, [b[0] for b in self.bounds], [b[1] for b in self.bounds])

def grey_wolf_hunting(self, current_pos, alpha, beta, delta):

# Simplified GWO update logic embedded in PIO

a = 2.0 # Linearly decreases

r1 = random.random()

r2 = random.random()

A1 = 2 * a * r1 - a

C1 = 2 * r2

D_alpha = abs(C1 * alpha - current_pos)

X1 = alpha - A1 * D_alpha

r1 = random.random(); r2 = random.random()

A2 = 2 * a * r1 - a; C2 = 2 * r2

D_beta = abs(C2 * beta - current_pos)

X2 = beta - A2 * D_beta

r1 = random.random(); r2 = random.random()

A3 = 2 * a * r1 - a; C3 = 2 * r2

D_delta = abs(C3 * delta - current_pos)

X3 = delta - A3 * D_delta

return (X1 + X2 + X3) / 3

def run(self):

self.cubic_chaos_init()

Nc1 = int(self.max_iter * 0.7) # Phase 1 duration

for t in range(self.max_iter):

if t < Nc1:

# Map and Compass Operator with Discoverer Strategy (Simplified)

for i in range(self.pop_size):

# Discoverer logic: random large jump for some

if random.random() < 0.1:

self.vel[i] = np.random.rand(self.dim) * 2 - 1

else:

self.vel[i] = self.vel[i] * math.exp(-self.R * t) + \

random.random() * (self.gbest_pos - self.pos[i])

self.pos[i] += self.vel[i]

self.pos[i] = np.clip(self.pos[i], [b[0] for b in self.bounds], [b[1] for b in self.bounds])

else:

# Landmark Operator -> Replaced/Augmented with GWO Strategy

# Identify Alpha, Beta, Delta

sorted_indices = np.argsort(self.fitness)

alpha = self.pos[sorted_indices[0]]

beta = self.pos[sorted_indices[1]]

delta = self.pos[sorted_indices[2]]

for i in range(self.pop_size):

self.pos[i] = self.grey_wolf_hunting(self.pos[i], alpha, beta, delta)

self.pos[i] = np.clip(self.pos[i], [b[0] for b in self.bounds], [b[1] for b in self.bounds])

# Evaluation

for i in range(self.pop_size):

fit = self.cost_func(self.pos[i])

self.fitness[i] = fit

if fit < self.gbest_fit:

self.gbest_fit = fit

self.gbest_pos = self.pos[i].copy()

# Mutation on best

mutated = self.gaussian_mutation(self.gbest_pos)

m_fit = self.cost_func(mutated)

if m_fit < self.gbest_fit:

self.gbest_fit = m_fit

self.gbest_pos = mutated

return self.gbest_pos, self.gbest_fit

如有问题,可以直接沟通

👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?