博主介绍: 大家好,我是想成为Super的Yuperman,互联网宇宙厂经验,17年医疗健康行业的码拉松奔跑者,曾担任技术专家、架构师、研发总监负责和主导多个应用架构。

近期专注: DeepSeek应用,RPA应用研究,主流厂商产品使用,开源RPA 应用等

技术范围: 长期专注java体系,软件架构,DDD,多年java、golang、.Net、redis、nginx、tomcat、mysql、oracle等经验

业务范围: 对传统业务应用技术转型,从数字医院到区域医疗,从院内业务系统到互联网医院及健康服务,从公立医院到私立医院都有一些经历及理解

*** 为大家分享一些思考与积累,欢迎持续关注公众号:【火星求索】 ***

如果说 AI 领域也有“拼多多”,那 DeepSeek 绝对是当之无愧的性价比之王!它让 AI 开发和训练变得像拼团一样简单,低成本、高效率。而 Ollama,作为一款轻量级的模型部署工具,更是让 DeepSeek 的部署变得像“点外卖”一样轻松。今天,我们就来手把手教你如何用 Ollama 部署 DeepSeek,让你也能轻松玩转 AI!

DeepSeek版本选择模型版本:

- 入门级:1.5B版本,适合初步测试。

- 中端:7B或8B版本,适合大多数消费级GPU。

- 高性能:14B、32B或70B版本,适合高端GPU。

本文机器环境:MacBook Pro M1

DeepSeek版本:deepseek-r1:1.5b

目录

-

Ollama 是什么?Ollama 的优势

-

Mac 笔记本安装 Ollama 及成功验证

-

使用 Ollama 部署 DeepSeek

-

DeepSeek 首次运行

-

总结及注意事项

1. Ollama 是什么?

Ollama 是一个快速、轻量且易于使用的开源 AI 代理框架,由 Facebook 开发,可以用来托管和运行各种语言模型(LLM),可以实现在您的硬件设备快速部署各种本地大模型,并且提供了一个简单命令行界面,方便用户快速部署。

-

轻量:Ollama 不占用大量资源,适合个人开发者和小团队使用。

-

快速:从模型上传到部署,只需几条命令,几分钟就能搞定。

-

易用:无需复杂的配置,小白也能轻松上手。

Ollama 支持多种操作系统包括:

- macOS:适用于所有现代版本的macOS。

- Windows:支持Windows 10及更高版本。

- Linux:支持多种Linux发行版,如Ubuntu、Fedora等。

- Docker:通过Docker容器,Ollama可以在几乎任何支持Docker的环境中运行。

2. Mac 安装 Ollama

在 Mac 上安装 Ollama 非常简单,只需几步:

步骤 1:安装 Ollama

官网地址下载: Ollama

网盘下载地址:https://download.youkuaiyun.com/download/charry0110/90340456

步骤 2:下载Ollama-darwin.zip解压安装

解压Ollama-darwin.zip直接双击安装即可

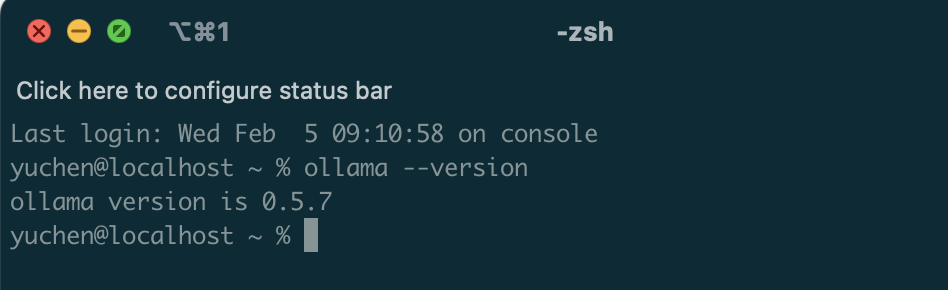

步骤 3:验证安装

ollama --version

如果显示版本号,恭喜你,Ollama 已经成功安装!

3. 使用 Ollama 部署 DeepSeek

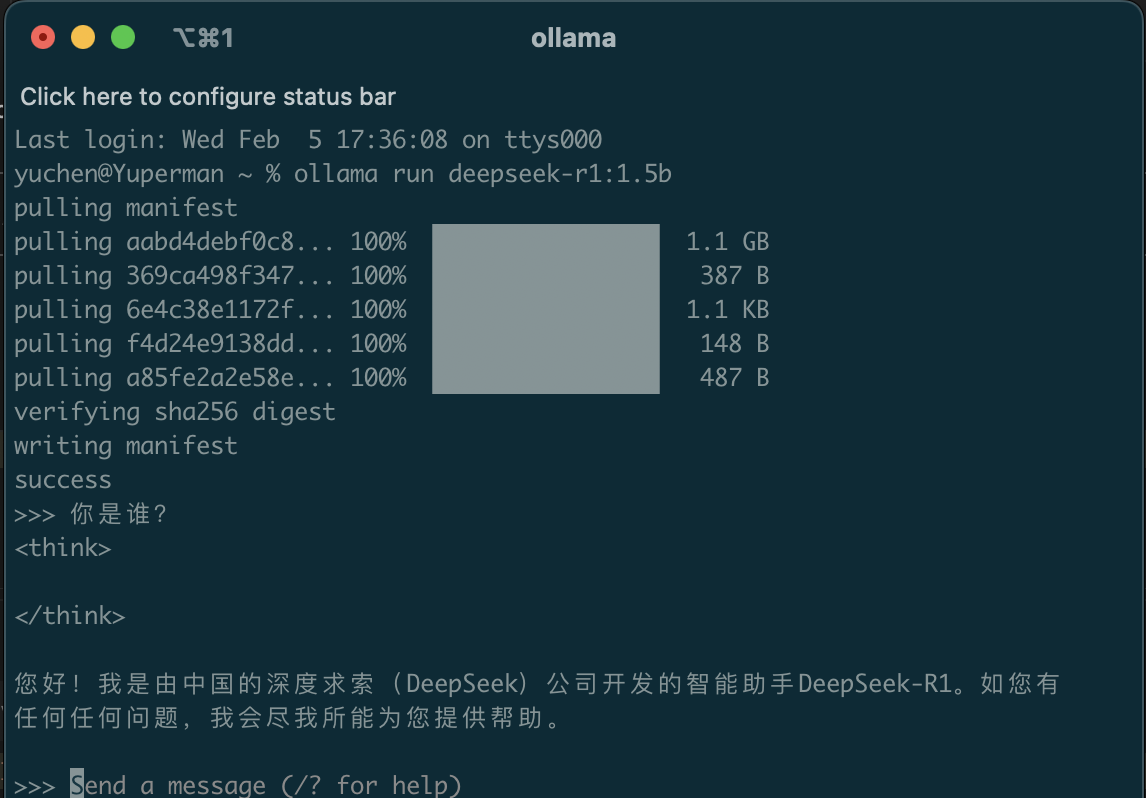

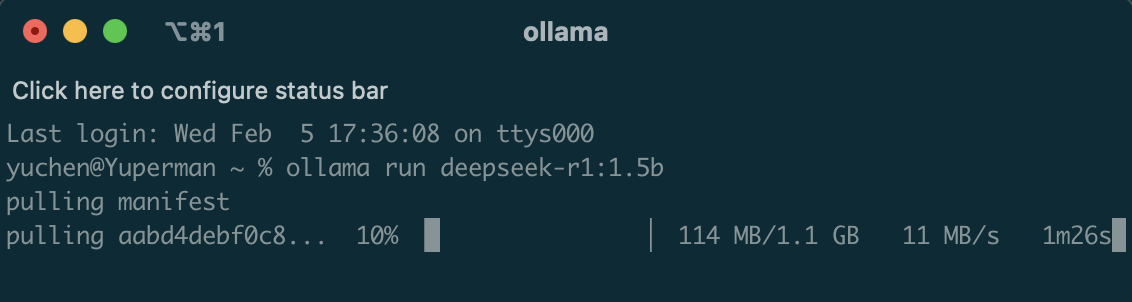

步骤 1:部署 DeepSeek 模型

第一次运行Ollama下载模型,deepseek-r1:1.5b大小1G

ollama run deepseek-r1:1.5bdeepseek-r1 部署其他命令参考

ollama run deepseek-r1:1.5b# 1.5B版本

ollama run deepseek-r1:7b # 7B版本

ollama run deepseek-r1:8b # 8B版本

ollama run deepseek-r1:14b # 14B版本

ollama run deepseek-r1:32b # 32B版本

步骤 2:验证 DeepSeek 服务

几分钟后,你的 DeepSeek 模型就会部署完成,可以直接运行对话

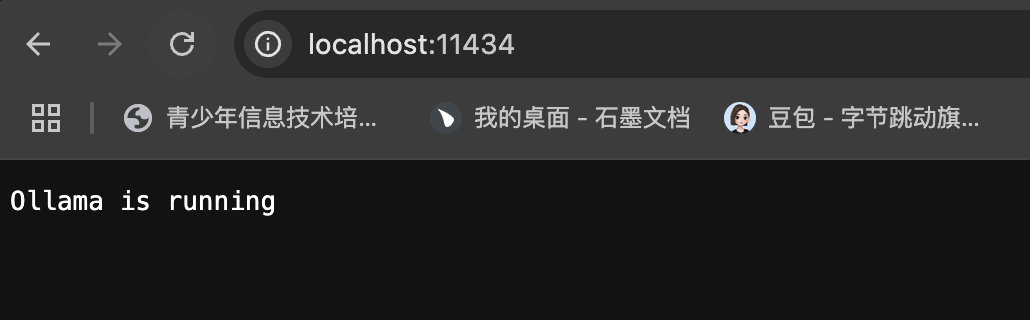

步骤 3:启动Ollama服务验证

通过访问 http://localhost:11434 来与模型进行交互。

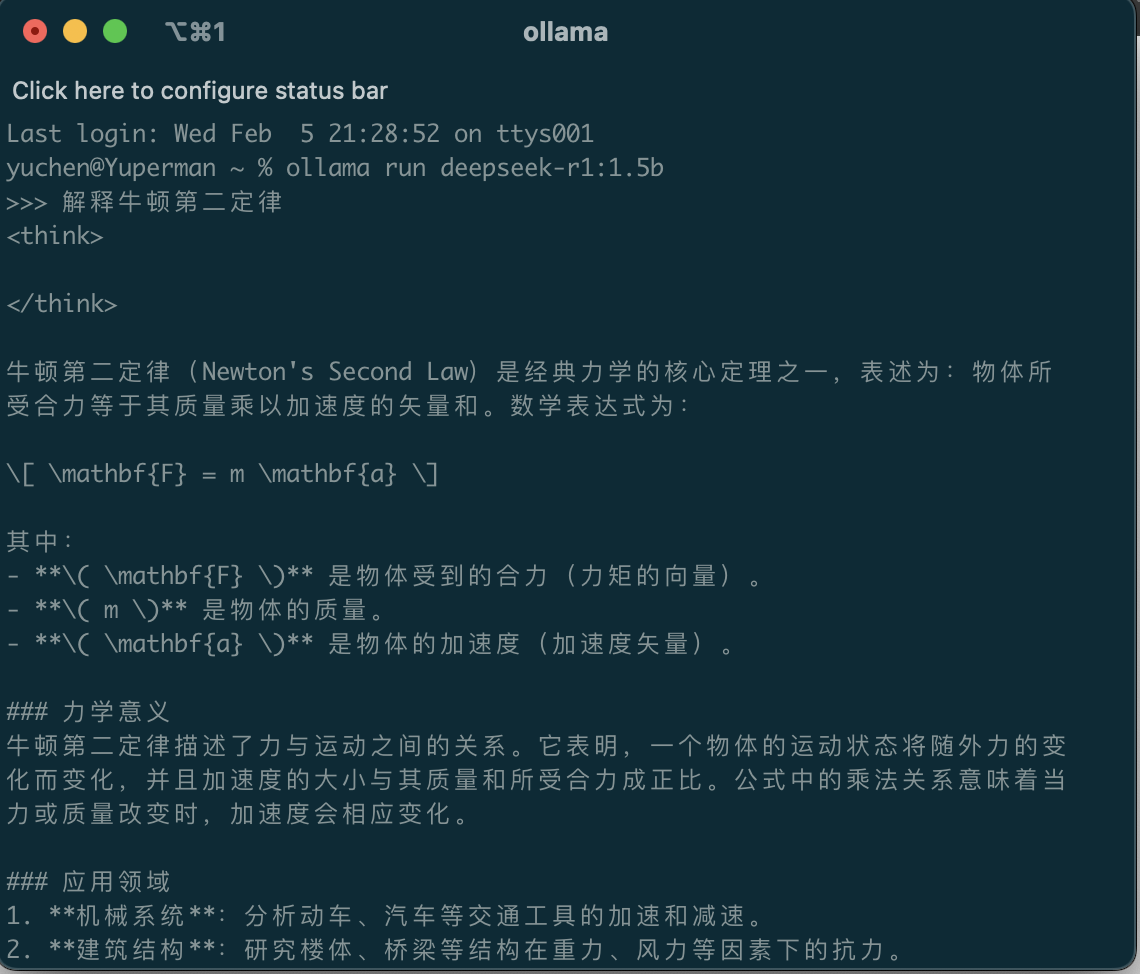

4. DeepSeek 首次运行

部署完成后,你可以通过以下命令测试模型:

ollama run deepseek-r1:1.5b如果模型返回了预期的结果,说明 DeepSeek 已经成功运行!

5. 总结及注意事项

虽然 Ollama 轻量,但 DeepSeek 运行时可能需要一定的计算资源,建议在性能较好的设备上运行。

默认 Ollama 会使用您的 CPU 来运行模型,而并非 GPU,对于那种比较小的模型用CPU+集成显卡也能较好的进行工作,如果您的计算机中有 AMD 或者 Nvidia 独立显卡,并且您想运行更大的模型或更快的响应速度,您需要安装CUDA Toolkit以更好地利用独立显卡。

DeepSeek R1 模型对应的硬件配置参考。

如果希望 Ollama 使用 GPU 加速,需要确保已正确安装 GPU 驱动和相关库,并在启动之前配置好环境变量。

最后

如果你觉得这篇文章对你有帮助,欢迎点赞、转发、评论!

公众号【火星求索】发送deepseek即可获取【清华大学DeepSeek 从入门到精通 系列】四连弹,以及可以获取收集整理的各种资料。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?