Deepseek本地部署及应用

ollama软件下载

下载ollama软件:ollama官网

安装好之后,打开电脑cmd输入ollama,得到以下界面表示安装成功:

模型下载

下载deekseekR1模型:下载地址,选择合适大小的模型进行下载:

电脑没有独立显卡:选择1.5b模型

有独显,显存4G或8G:选择7b或8b模型

更高的配置,可以自行尝试!

我选择了14B作为示例进行下载,复制下方代码,粘贴到cmd

等待下载完成

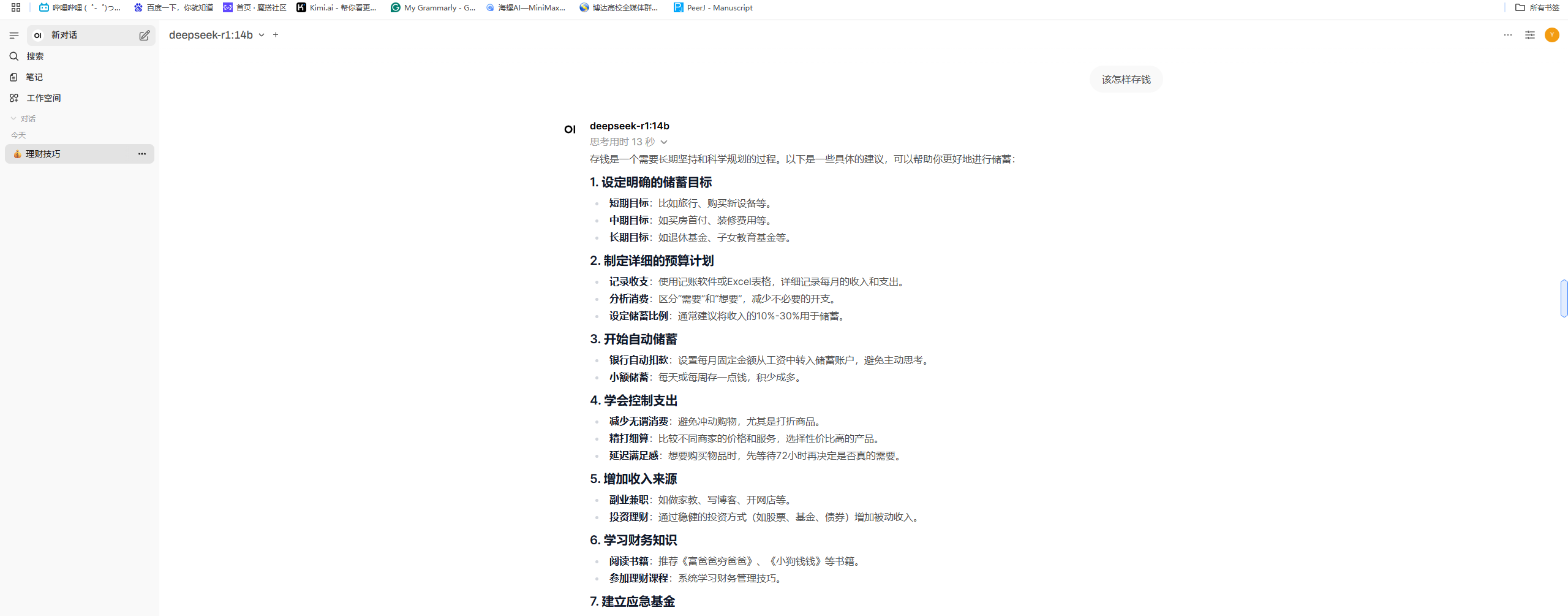

cherry studio终端使用

下载cherry studio:cherry studio官网

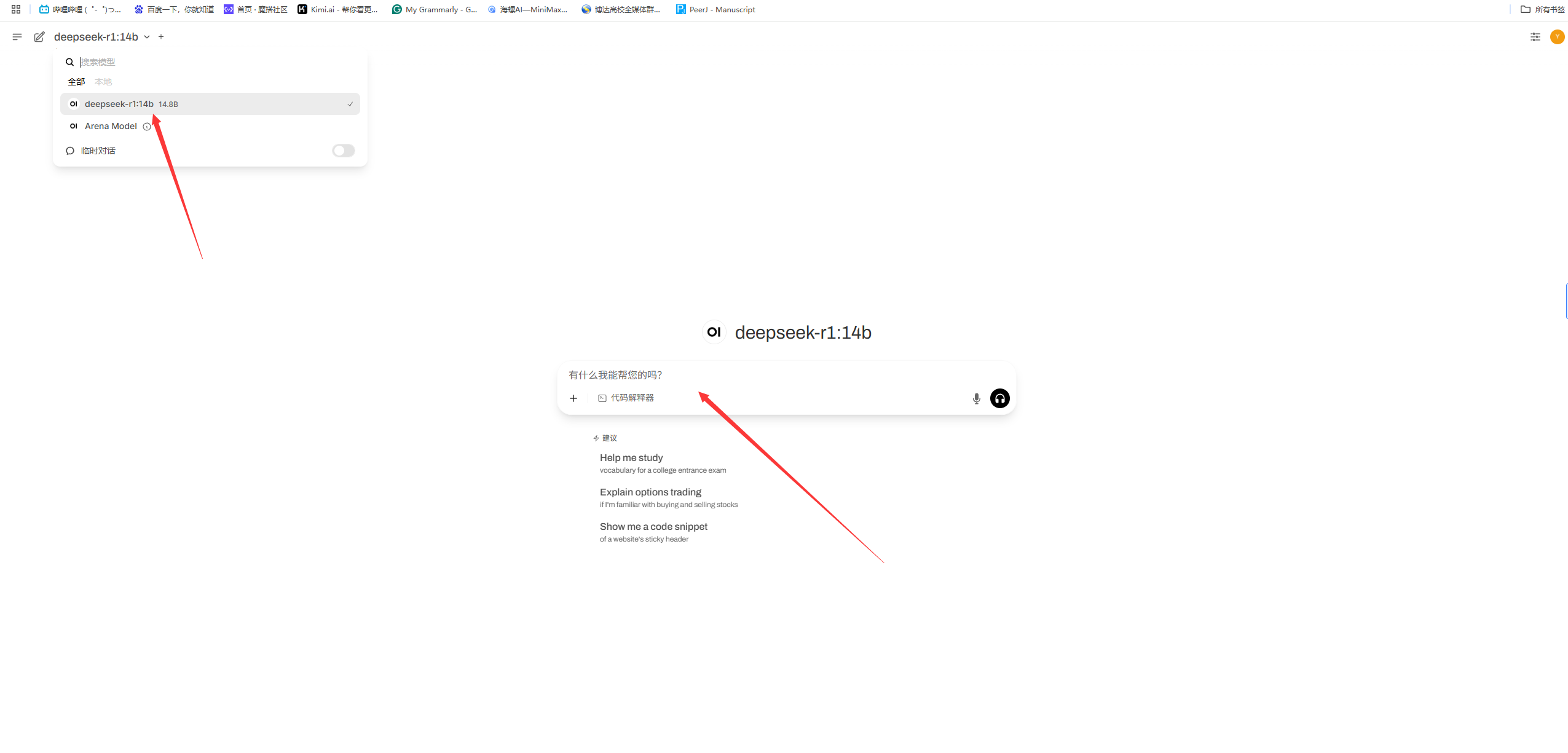

打开cherry studio设置,模型服务,找到Ollama,打开开关,点击管理

选择本地模型,回到首页即可进行对话。

OpenWebUI使用

- 新建虚拟环境

conda create -n python311 python==3.11

- 激活虚拟环境

conda activate python311

- 下载open-webui

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple

pip install open-webui

- 启动服务

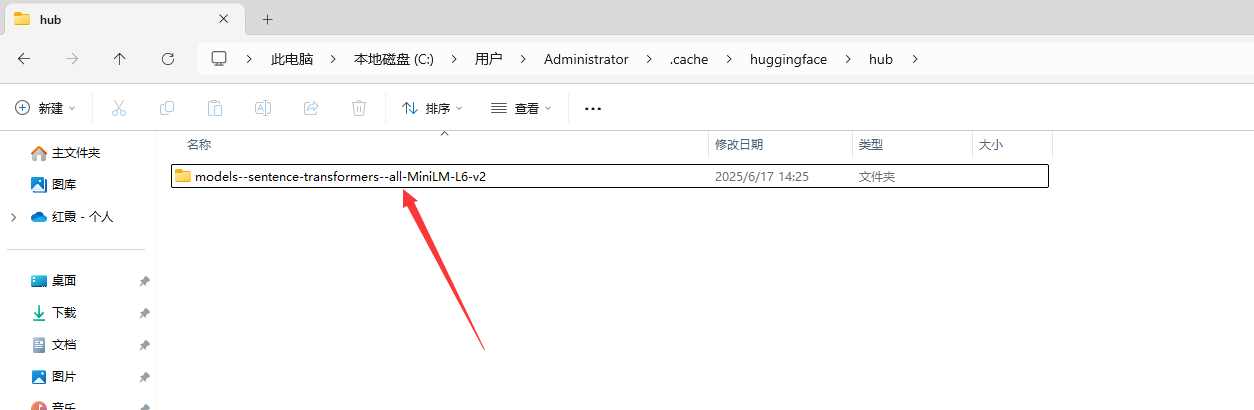

由于huggingface内网很难连接,所以将在C:\Users\XXX用户\.cache\huggingface\hub放入下解压模型

Open WebUI运行所需模型下载:https://wwye.lanzouj.com/i4ct72cgrp1e

开启服务(需要提前运行ollama 模型)

open-webui serve

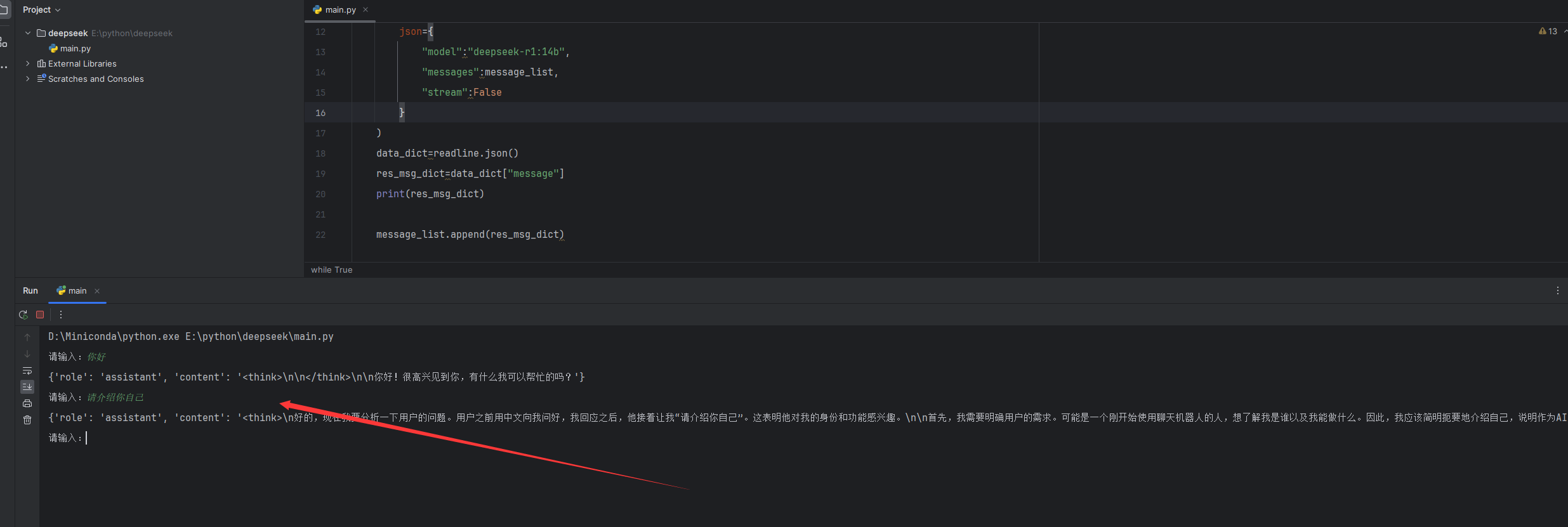

python调用

参考API

方便将本地大模型接入网站或者其他界面进行应用开发。

import requests

message_list=[]

while True:

text =input("请输入:")

user_dict={"role":"user","content":text} # 正确的字典定义

message_list.append(user_dict)

readline=requests.post(

url='http://localhost:11434/api/chat',

json={

"model":"deepseek-r1:14b",

"messages":message_list,

"stream":False

}

)

data_dict=readline.json()

res_msg_dict=data_dict["message"]

print(res_msg_dict)

message_list.append(res_msg_dict)

运行即可开始对话。

3882

3882

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?