文章目录

回顾

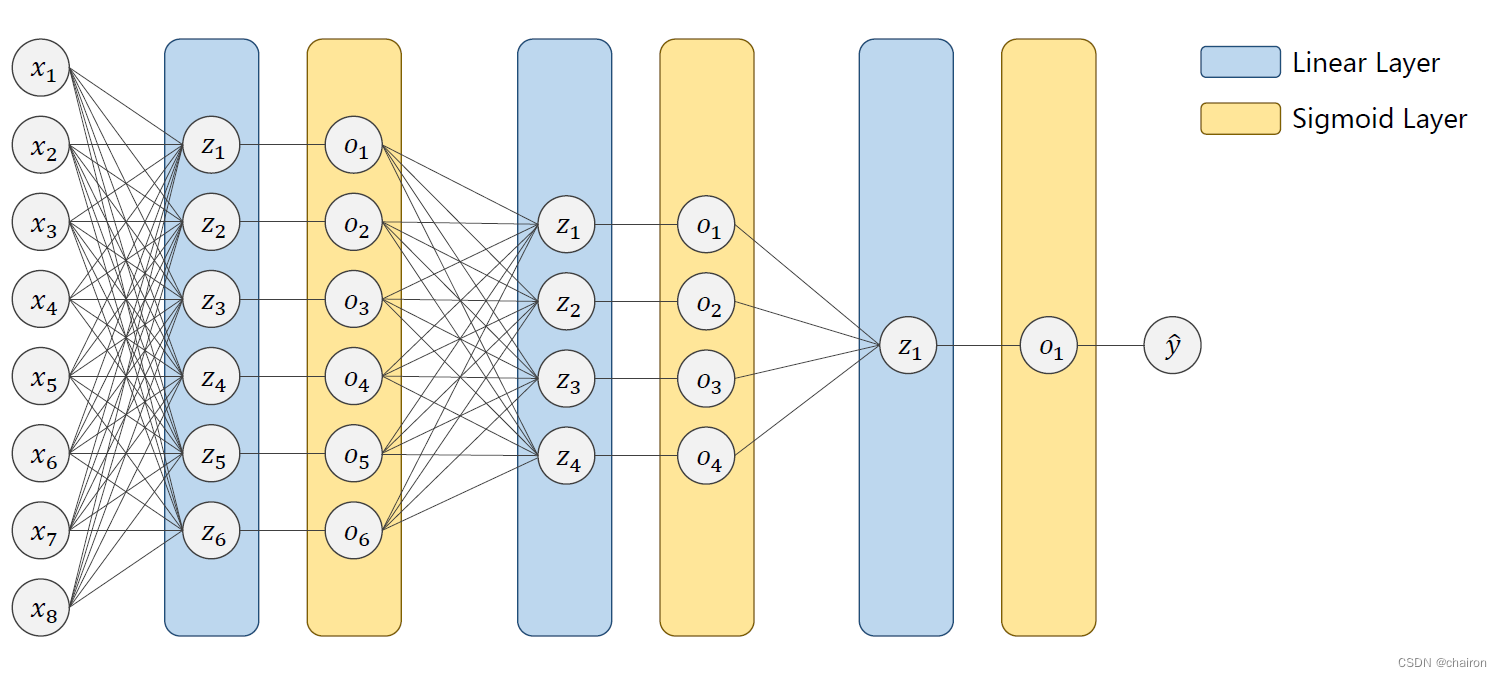

DNN(全连接):和CNN相比,拥有巨大的参数量,CNN权重共享因此参数量小很多。

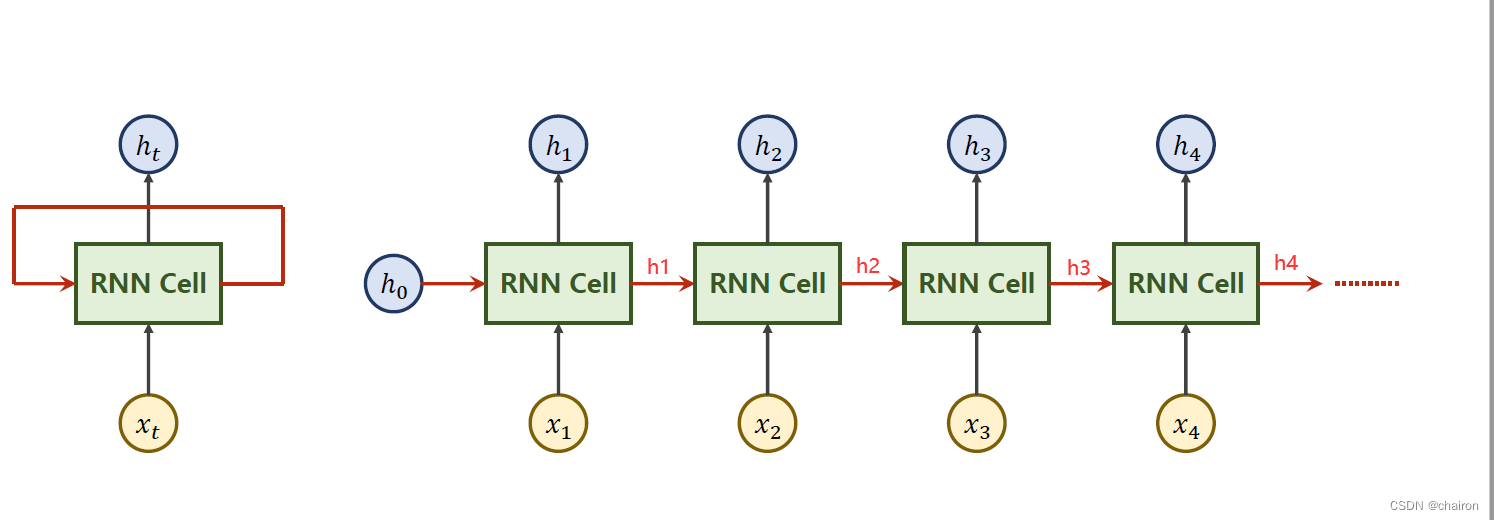

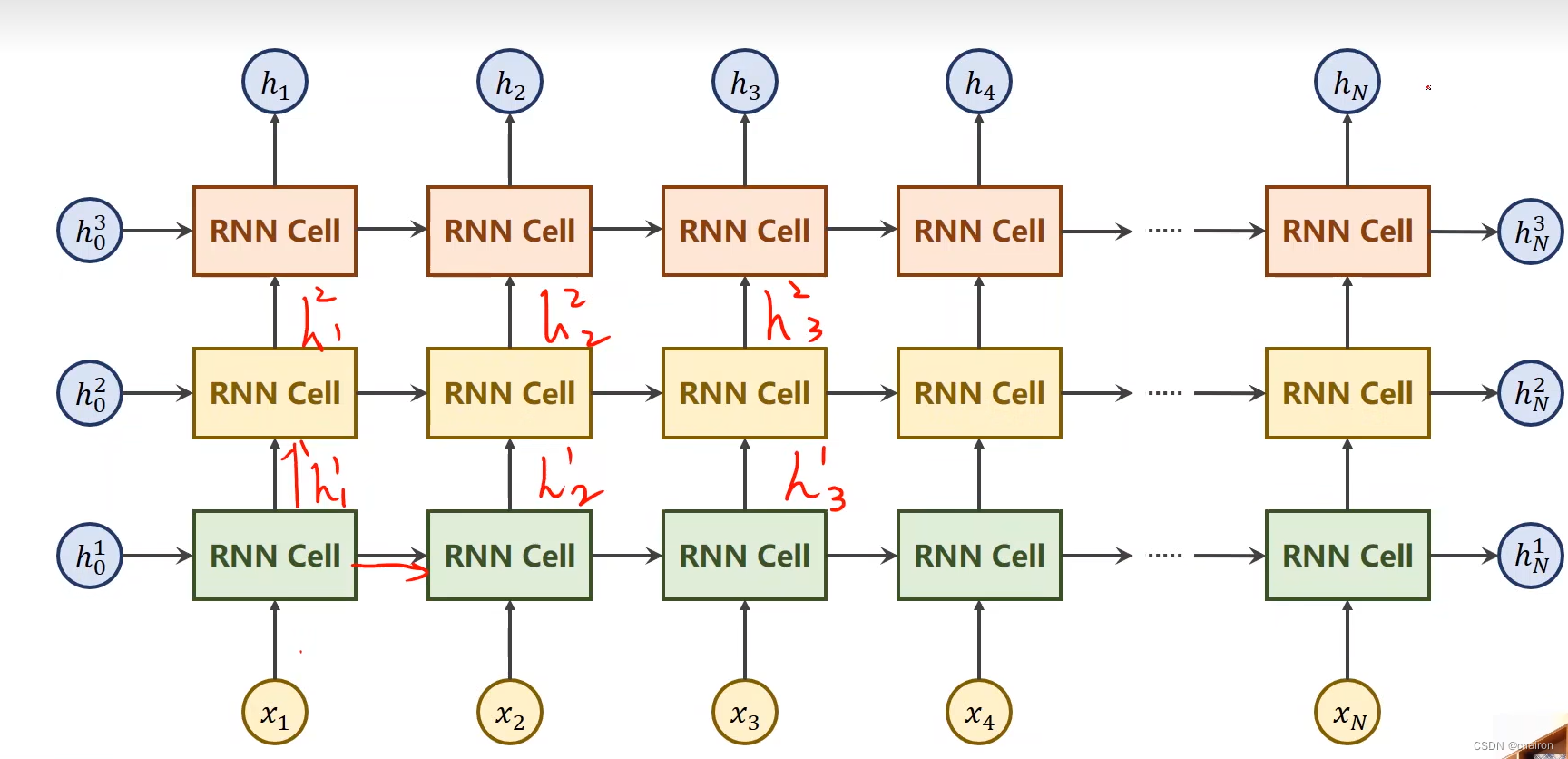

RNN

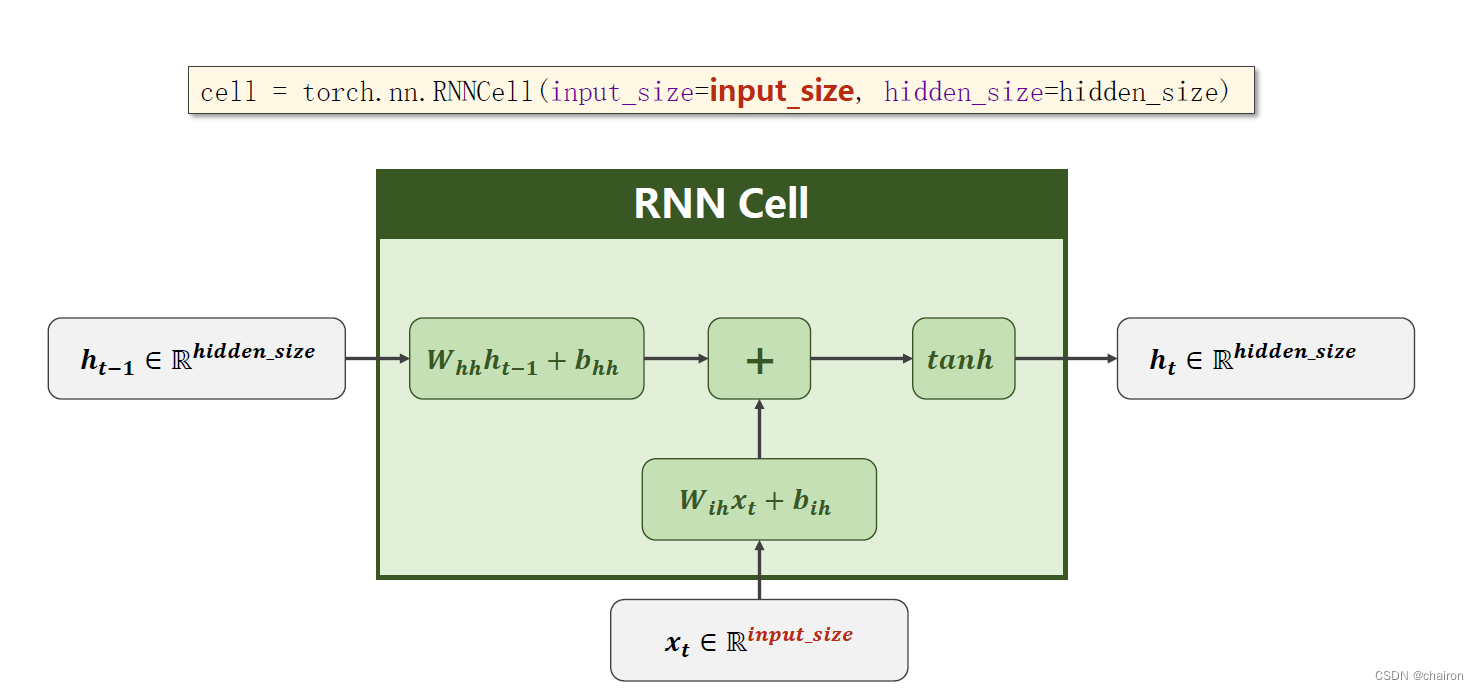

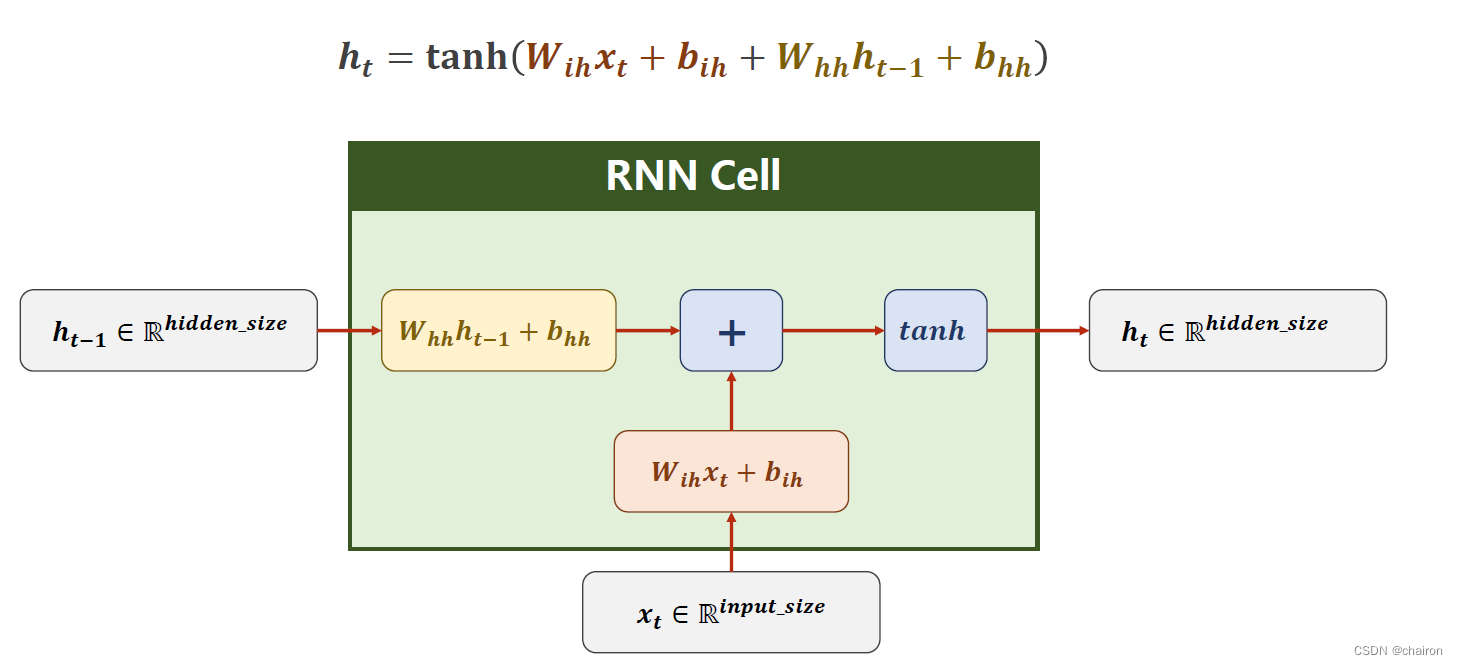

RNN Cell

RNN主要是处理带有时间序列特征的数据(前后文拥有逻辑关系)

- 自然语言:依赖于词的顺序

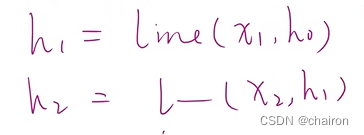

以上的RNN cell为同一个线形层(处理一个序列),其实以上是一个循环:

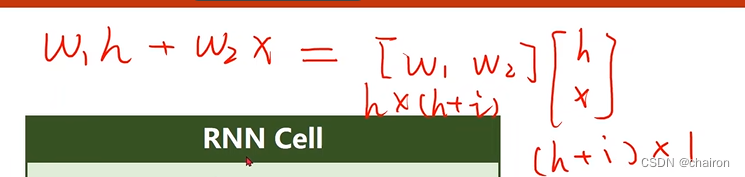

RNN Cell具体计算过程如下:

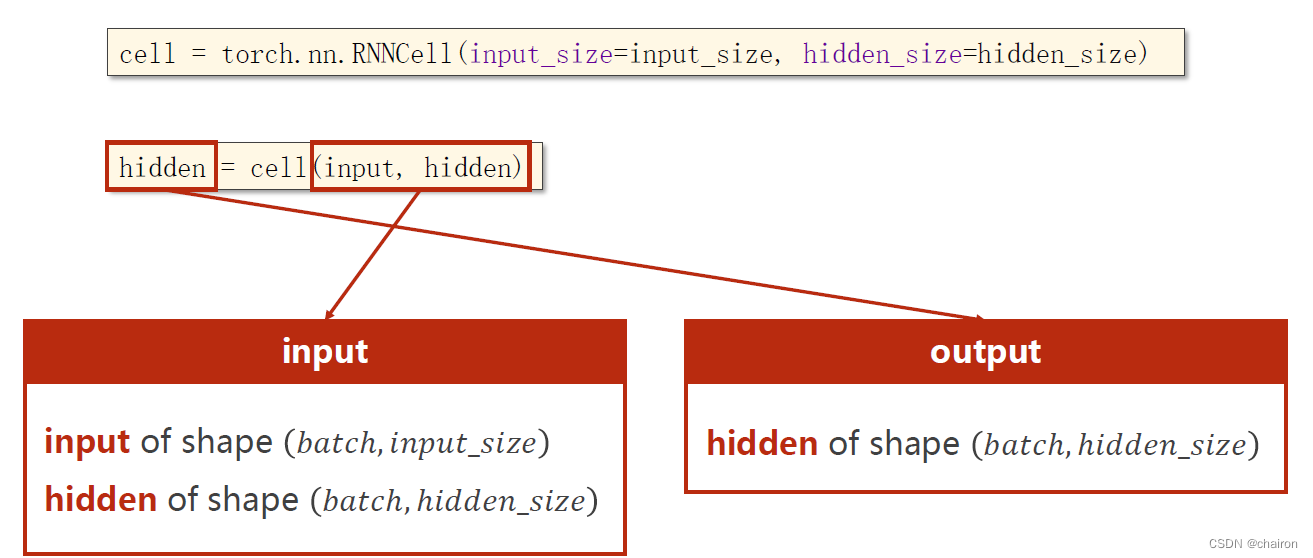

RNNCell的使用

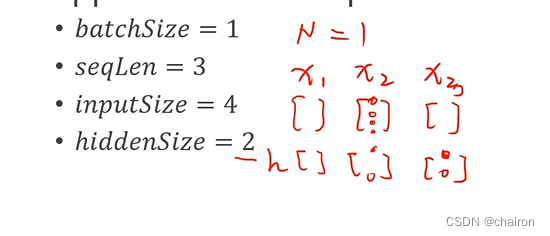

假设有以下这些条件:

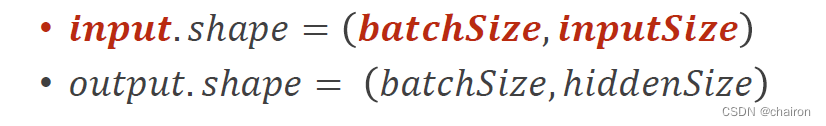

RNNCell的输入、输出的维度就应该是:

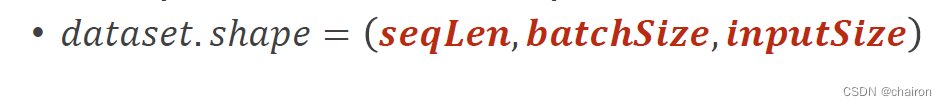

数据集的形状应该是:

seqLen应该放在最前面,方便循环。

#练习1

import torch

batch_size=1

seq_len=3

input_size=4

hidden_size=2

#构建RNNcell,RNNcell本质是一个Linear层

cell=torch.nn.RNNCell(input_size=input_size,hidden_size=hidden_size)

#(seq,batch,feartures)

#产生形状为(seq_len,batch_size,input_size)的序列

dataset= torch.randn(seq_len,batch_size,input_size)

#初始化hidden为0

hidden =torch.zeros(batch_size,hidden_size)

for idx, input in enumerate (dataset):#遍历datset中的序列

print('='*20,'='*20)

print('Input size:',input.shape)#[1, 4]

hidden=cell(input,hidden)#上一个的output作为下一个的hidden

print('output size:',hidden.shape) #[1, 2],output size=hidden size,上一个的output作为下一个的hidden

print(hidden)

结果:

==================== ====================

Input size: torch.Size([1, 4])

output size: torch.Size([1, 2])

tensor([[-0.4549, 0.6699]], grad_fn=<TanhBackward0>)

==================== ====================

Input size: torch.Size([1, 4])

output size: torch.Size([1, 2])

tensor([[-0.7693, 0.1919]], grad_fn=<TanhBackward0>)

==================== ====================

Input size: torch.Size([1, 4])

output size: torch.Size([1, 2])

tensor([[0.2945, 0.8171]], grad_fn=<TanhBackward0>)

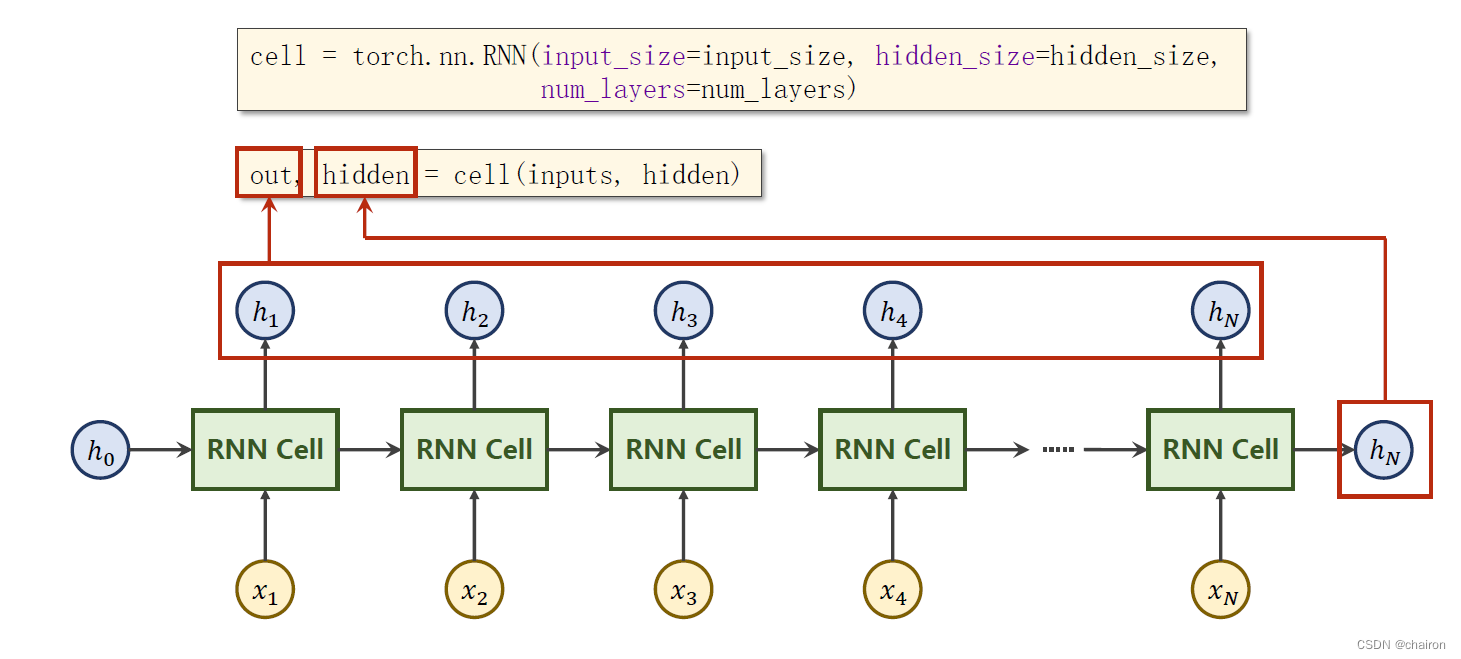

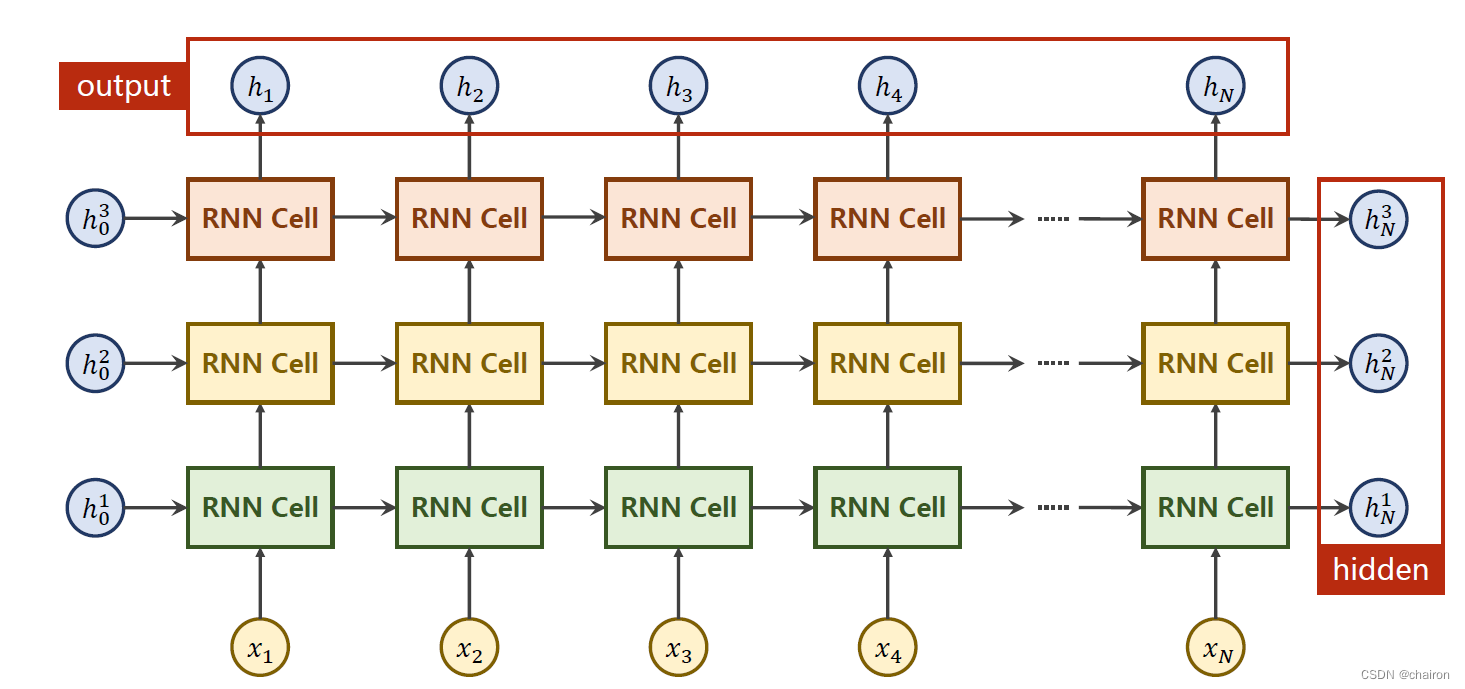

RNN的使用

inputs:全部的输入序列;shape=(𝑠𝑒𝑞𝑆𝑖𝑧𝑒,𝑏𝑎𝑡𝑐ℎ,𝑖𝑛𝑝𝑢𝑡_𝑠𝑖𝑧𝑒)

out:全部的隐层输出;shape=(𝑠𝑒𝑞𝐿𝑒𝑛,𝑏𝑎𝑡𝑐ℎ,ℎ𝑖𝑑𝑑𝑒𝑛_𝑠𝑖𝑧𝑒)

hidden:最后一层的隐层输出;shape=(𝑛𝑢𝑚𝐿𝑎𝑦𝑒𝑟𝑠,𝑏𝑎𝑡𝑐ℎ,ℎ𝑖𝑑𝑑𝑒𝑛_𝑠𝑖𝑧𝑒)

需要的参数:

• 𝑏𝑎𝑡𝑐ℎ𝑆𝑖𝑧𝑒

• 𝑠𝑒𝑞𝐿𝑒𝑛

• 𝑖𝑛𝑝𝑢𝑡𝑆𝑖𝑧𝑒,ℎ𝑖𝑑𝑑𝑒𝑛𝑆𝑖𝑧𝑒,

• 𝑛𝑢𝑚𝐿𝑎𝑦𝑒𝑟𝑠

同一层的RNN Cell是同一个,以上其实只有3层。

# 练习2

import torch

batch_size=1

seq_len=3

input_size=4

hidden_size=2

num_layers=1

#Construction of RNN

cell=torch.nn.RNN(input_size,hidden_size,num_layers)

cell1=torch.nn.RNN(input_size,hidden_size,num_layers,batch_first=True)

#(seq,batch,inputSize)

inputs= torch.randn(seq_len,batch_size,input_size)

inputs1=torch.randn(batch_size,seq_len,input_size)

#初始化hidden为0

hidden =torch.zeros(num_layers,batch_size,hidden_size)

out,hidden=cell(inputs,hidden)

# out,hidden=cell1(inputs1,hidden)</

博客回顾了DNN与CNN参数量差异,重点介绍RNN处理时间序列数据的原理、RNN Cell和RNN的使用及示例。还提及嵌入层Embedding解决独热向量缺点,介绍了LSTM和GRU,LSTM通过门控机制选择性保留信息,GRU解决RNN梯度消失问题。

博客回顾了DNN与CNN参数量差异,重点介绍RNN处理时间序列数据的原理、RNN Cell和RNN的使用及示例。还提及嵌入层Embedding解决独热向量缺点,介绍了LSTM和GRU,LSTM通过门控机制选择性保留信息,GRU解决RNN梯度消失问题。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

472

472

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?