1. epoch

| epoch | batchsize | Iteration |

|---|---|---|

| 所有训练样本的一次训练 | 一次训练中训练的样本数量 | 迭代:1个iteration等于使用batchsize个样本训练一次 |

举个例子,训练集有1000个样本,batchsize=10,那么:

训练完整个样本集需要:

100次iteration,1次epoch。

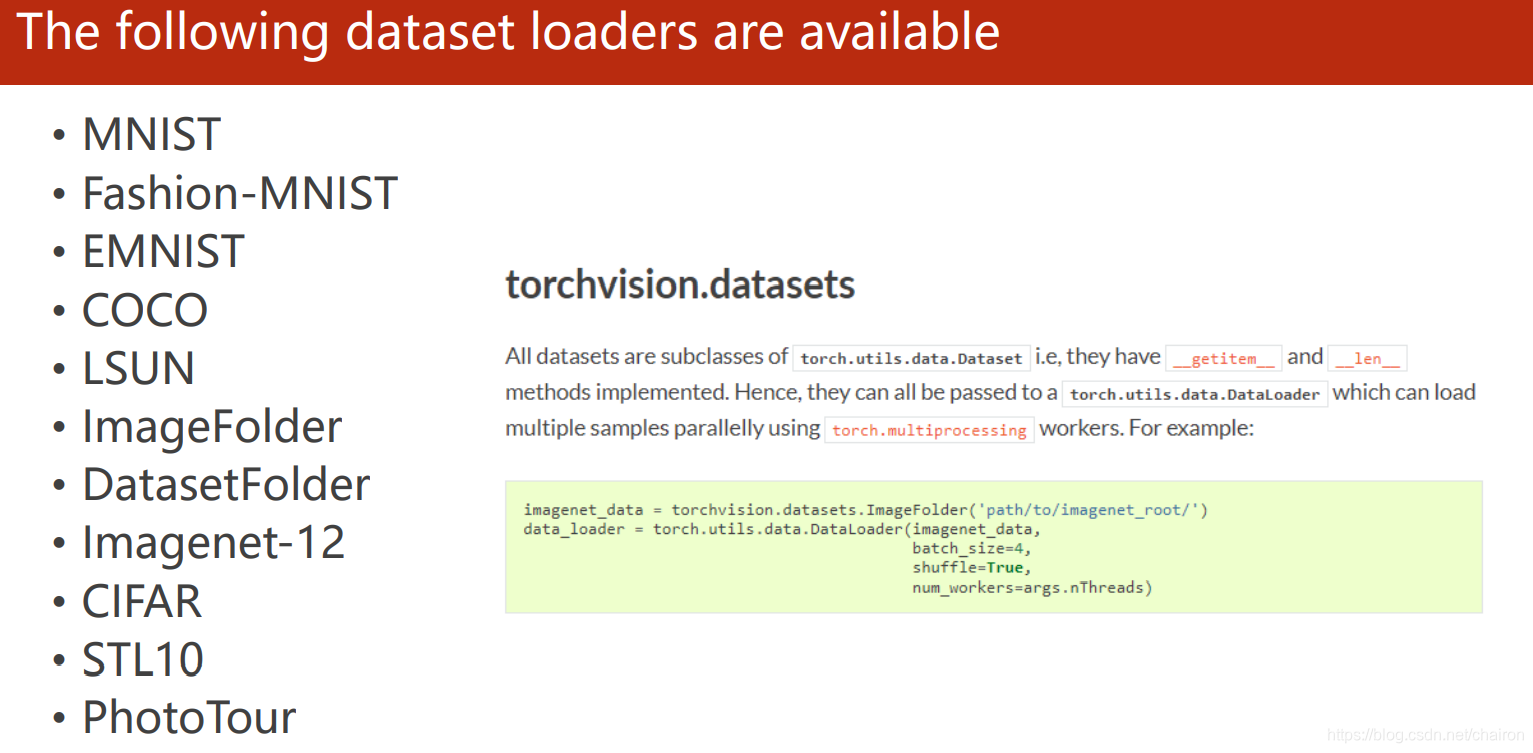

2.dataset

Dataset是一个包装类,用来将数据包装为Dataset类,然后传入DataLoader中,

我们再使用DataLoader这个类来更加快捷的对数据进行操作。

Dataset是一个抽象类,自定义的dataset必须继承。

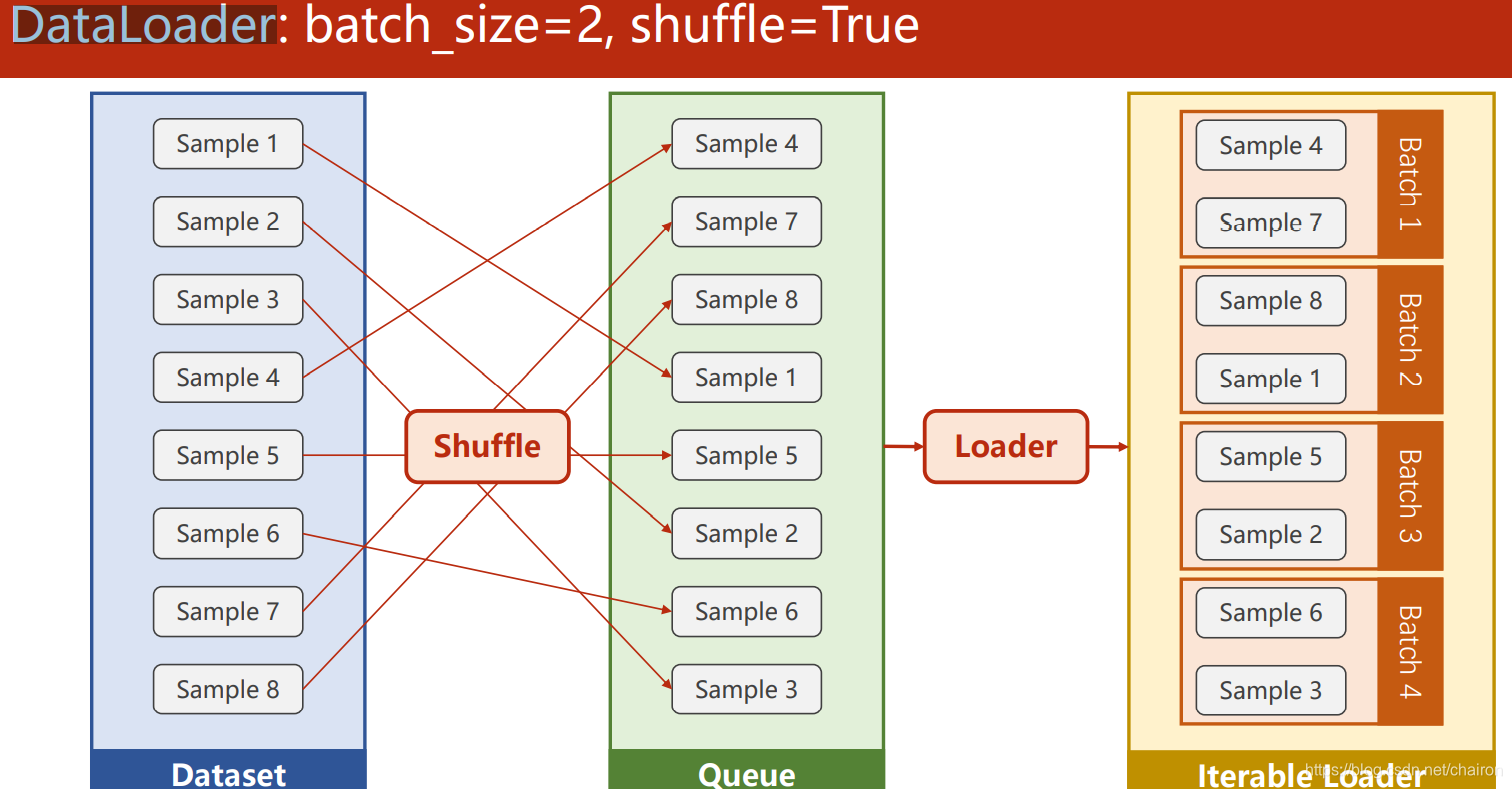

3. dataloader

1. 将自定义的Dataset根据batch size大小、是否shuffle等封装成一个Batch Size大小的Tensor,用于后面的训练。

2. DataLoader常用操作有:batch_size(每个batch的大小), shuffle(是否进行shuffle操作),

num_workers(加载数据的时候使用几个子进程)

import numpy as np

import torch

from torch.utils.data import Dataset, DataLoader

#Dataset is an abstract class. We can define our class inherited from

#DataLoader is a class to help us loading data in PyTorch this class.

#DiabetesDataset is inherited from abstract class Dataset.

class DiabetesDataset(Dataset):

def __init__(self,filepath):

datas=np.loadtxt(filepath,delimiter=',',dtype=np.float32)

self.len=datas.shape[0]

self.x_data=torch.from_numpy(datas[:,:-1])

self.y_data=torch.from_numpy(datas[:,[-1]])

def __getitem__(self,index):#dataset[index]

return self.x_data[index],self.y_data[index]

def __len__(self):#returns length of dataset.

return self.len

dataset=DiabetesDataset('diabetes.csv')# Construct DiabetesDataset object

train_loader=DataLoader(dataset=dataset,batch_size=32,shuffle=True,num_workers=2)

#Initialize loader with batch-size,shuffle, process number.

class Model(torch.nn.Module):

def __init__(self):

super(Model,self).__init__()

self.linear1=torch.nn.Linear(8,6)

self.linear2=torch.nn.Linear(6,4)

self.linear3=torch.nn.Linear(4,1)

self.sigmoid=torch.nn.Sigmoid()

def forward(self, x):

x=self.sigmoid(self.linear1(x))

x=self.sigmoid(self.linear2(x))

x=self.sigmoid(self.linear3(x))

return x

model=Model()

criterion=torch.nn.BCELoss(reduction='mean')

optimizer=torch.optim.SGD(model.parameters(),lr=0.01)

if __name__ == '__main__':

for epoch in range(100):

for i,data in enumerate(train_loader,0):

#1.Prepare data

inputs,labels=data

#2.Forward

y_predict=model(inputs)

loss=criterion(y_predict,labels)

print(epoch,loss.item())

#3.Backward

optimizer.zero_grad()

loss.backward()

#4.Update

optimizer.step()

本文详细介绍了PyTorch中的训练epoch、batch size、iteration的概念,并通过实例演示了如何使用DataLoader处理自定义Dataset。重点讲解了如何构建DataLoader,以及其在模型训练中的关键作用。

本文详细介绍了PyTorch中的训练epoch、batch size、iteration的概念,并通过实例演示了如何使用DataLoader处理自定义Dataset。重点讲解了如何构建DataLoader,以及其在模型训练中的关键作用。

466

466

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?